Zur Version ohne Bilder

freiesMagazin Januar 2012

(ISSN 1867-7991)

ReactOS

Das Ziel von ReactOS soll sein, dass Programme und Treiber, die für Windows NT und dessen Nachfolger entwickelt wurden, auch unter ReactOS verwendbar sind. Das freie Betriebssystem ist in großen Teilen unter der GNU GPL lizenziert. Einige Bestandteile stehen hingegen unter BSD- und LGPL-Lizenz. Das Projekt selbst betitelt ReactOS nicht als Windows-Nachbau, sondern als ein zu Windows binärkompatibles Betriebssystem. (weiterlesen)

Selbstgebacken: Kernel kompilieren nach Rezept

Moderne Linux-Distributionen bringen alles mit: Vom Systemkern über die Anwendungen bis hin zu den bunten Rüschen der graphischen Oberfläche. Für viele Nutzer gehört das Anpassen des Desktops zur Pflicht, das manuelle Installieren von Programmen – meist in einer aktuelleren Version – ist dann die Kür. Den Kernel jedoch lassen viele in Ruhe und vertrauen hier lieber auf die Aktualisierungen des Distributors. (weiterlesen)

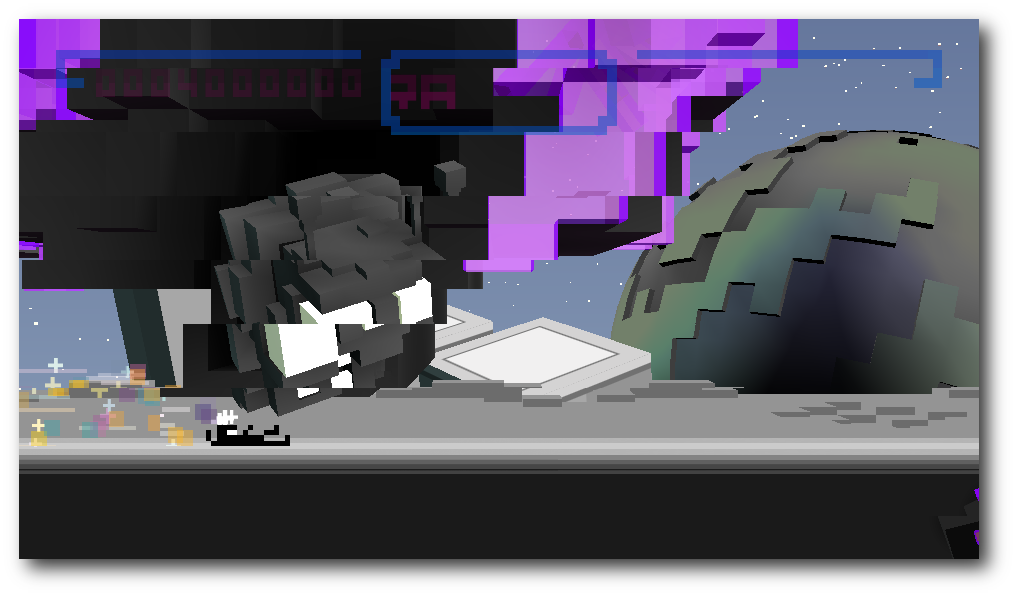

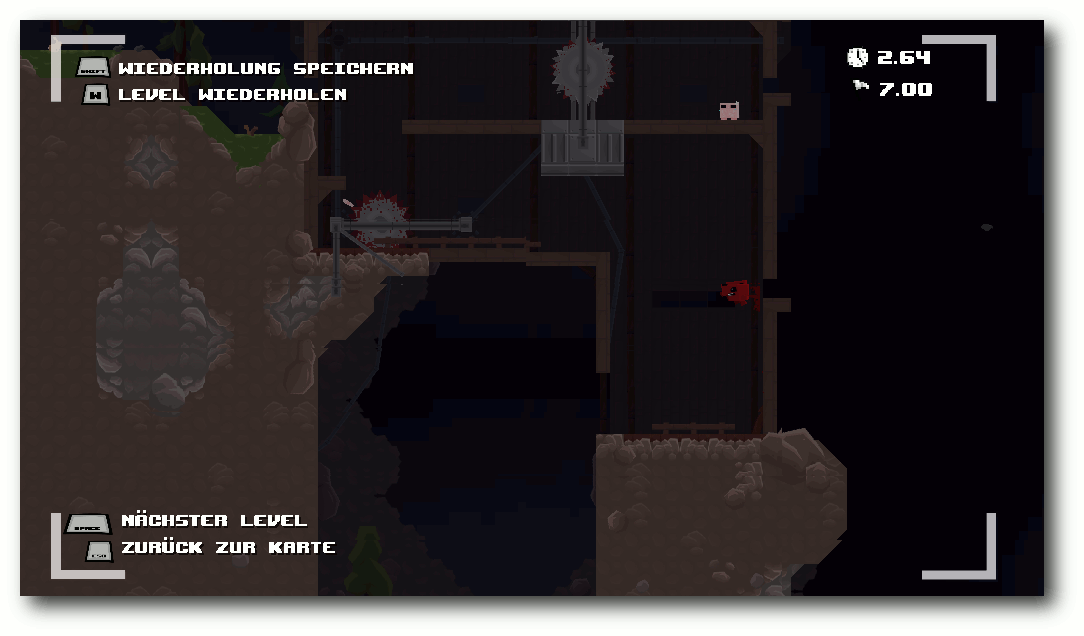

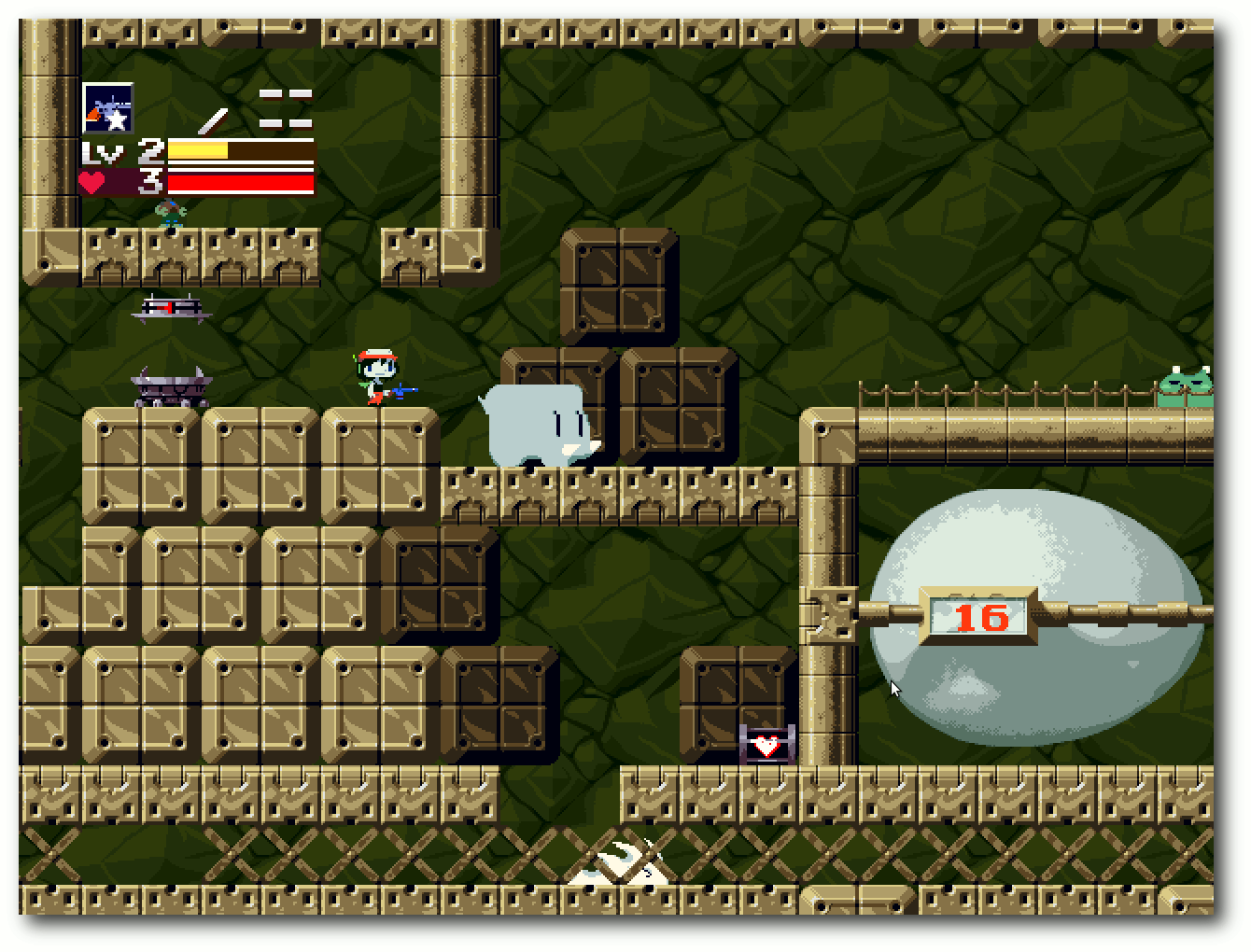

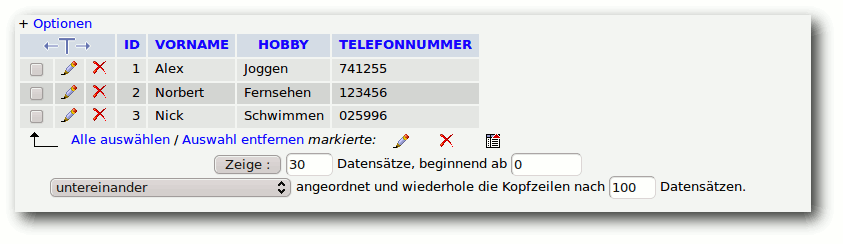

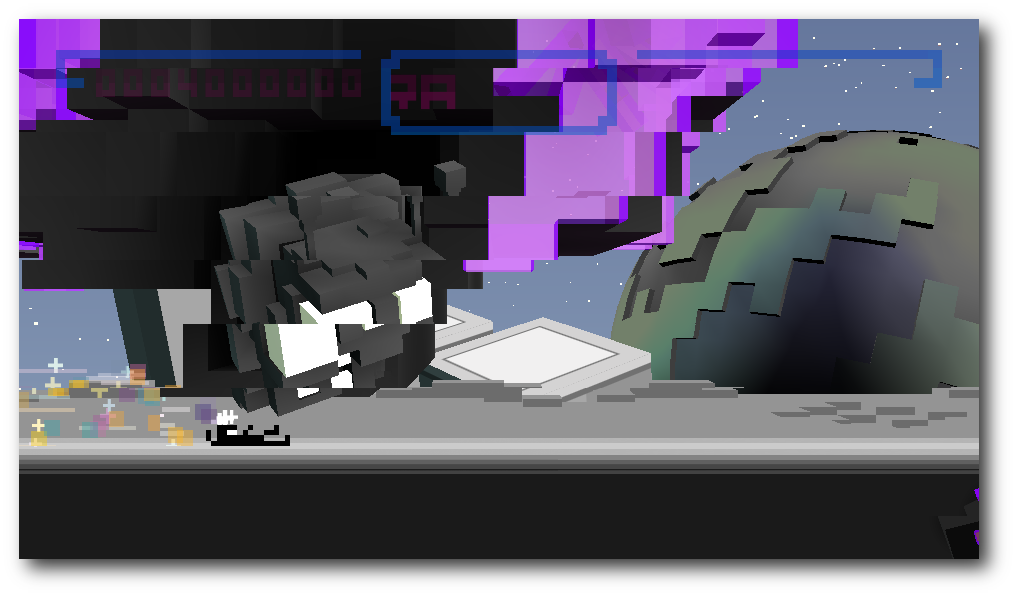

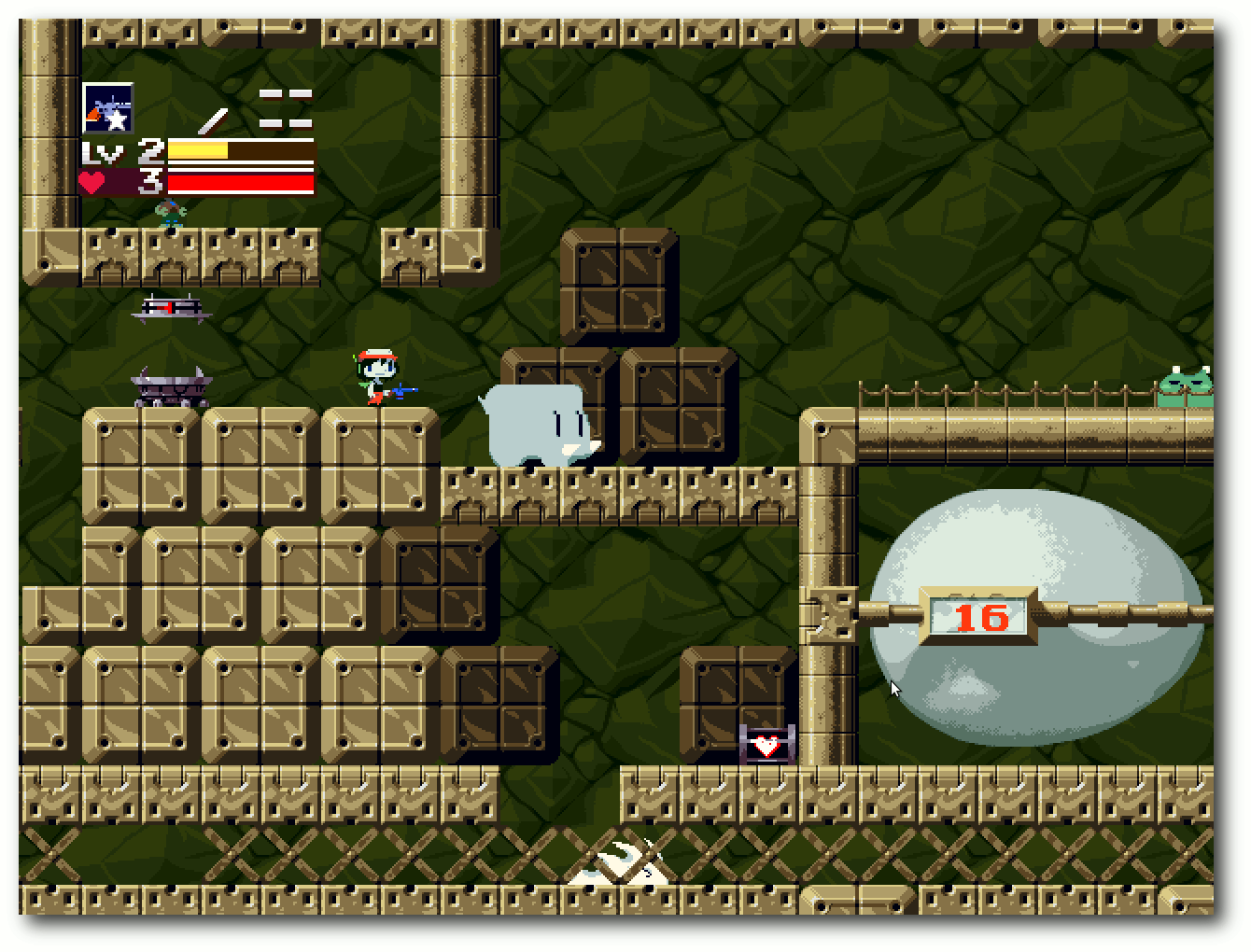

Kurzreview: Humble Indie Bundle 4

Das Humble Indie Bundle hat schon eine gewisse Tradition, so wurde die erste Version bereits im Mai 2010 veröffentlicht. Teil des Bundles sind Spiele, die von verschiedenen Independent-Studios entwickelt wurden und auf allen großen Plattformen Linux, Mac OS X und Windows laufen. Mitte Dezember 2011 wurde die vierte Version veröffentlicht, auf deren Inhalt in dem Artikel ein kleiner Blick geworfen werden soll. (weiterlesen)

Zum Index

Linux allgemein

ReactOS

Fedora 16

Anleitungen

Kernel kompilieren nach Rezept

OpenShift – Entwickeln in der Cloud

Perl-Tutorium – Teil 5: Subroutinen, Namensräume und Geltungsbereiche

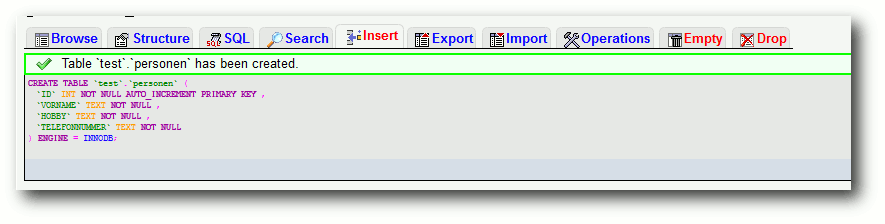

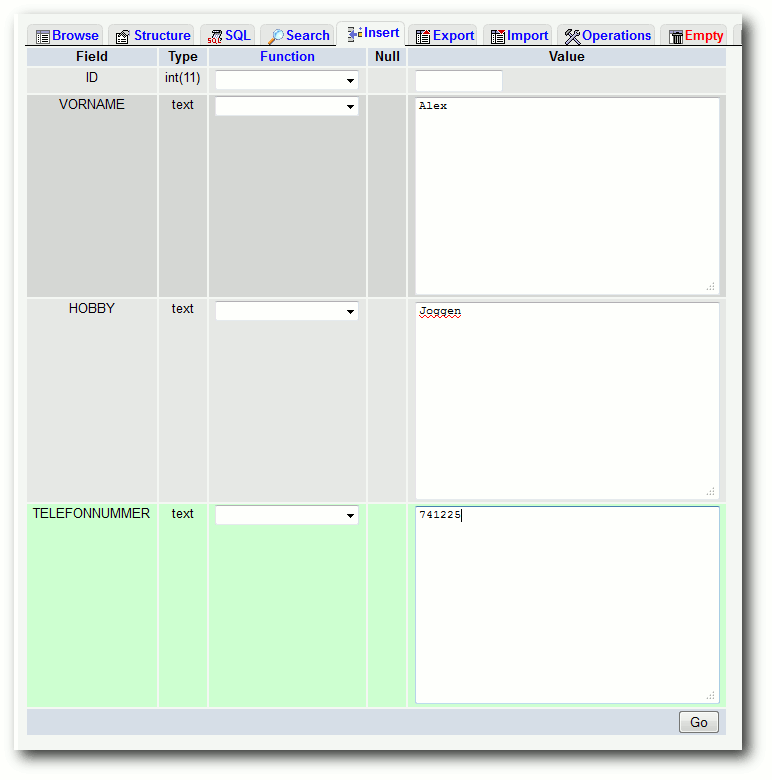

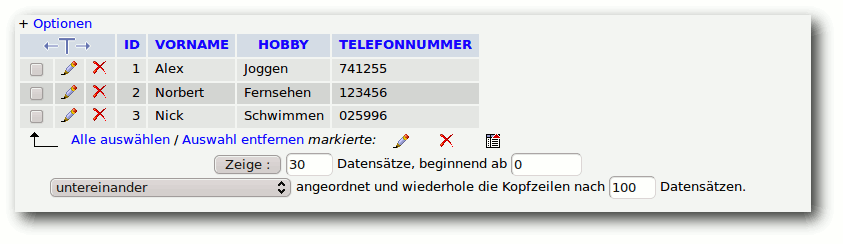

PHP-Programmierung – Teil 4: MySQL und PHP

Software

Kurzreview: Humble Indie Bundle 4

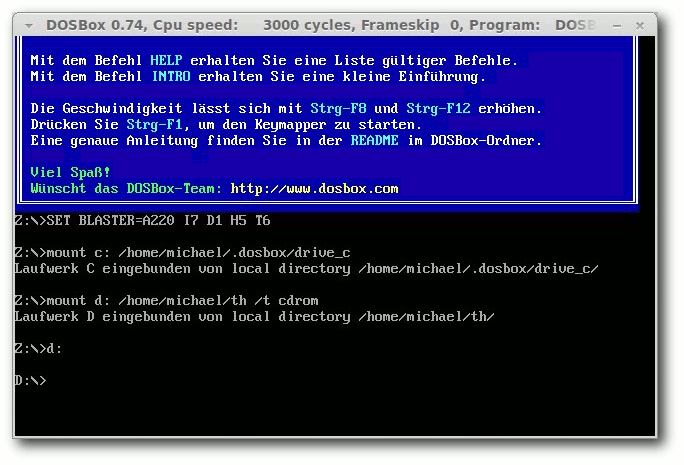

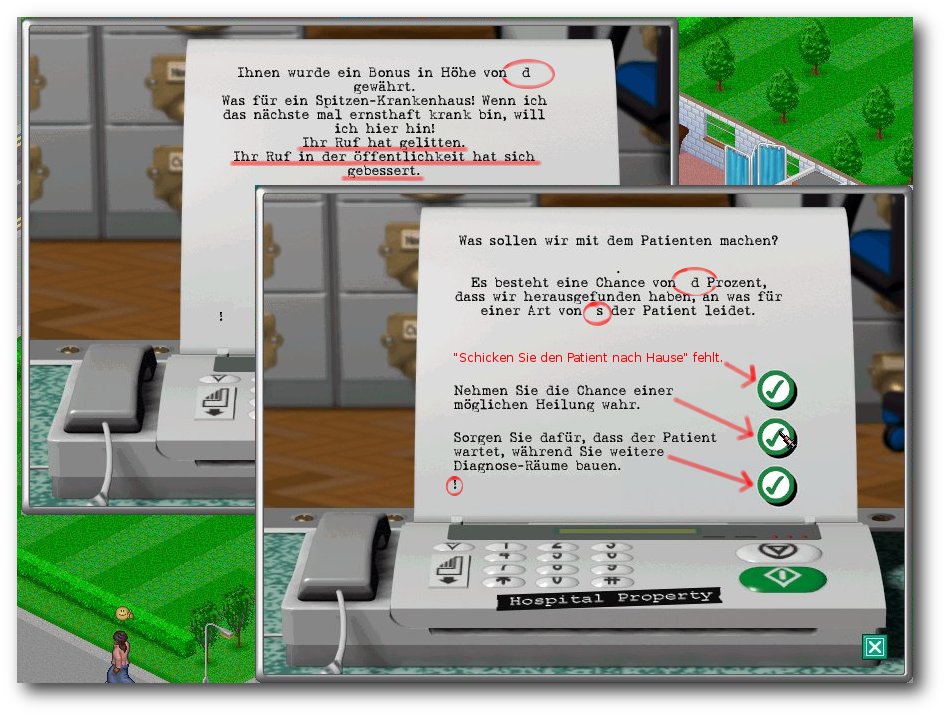

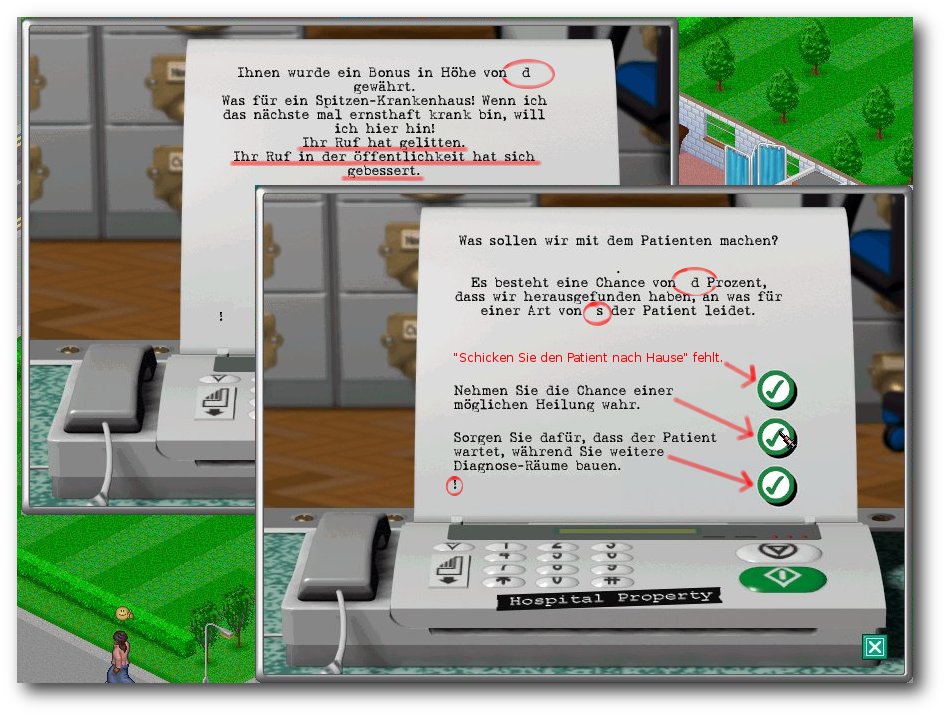

Theme Hospital & CorsixTH

Community

Rezension: JavaScript – Visual Quickstart Guide (8th Edition)

Rezension: X-Plane kompakt

Magazin

Editorial

Gewinner des vierten Programmierwettbewerbs

Leserbriefe

Veranstaltungen

Vorschau

Konventionen

Impressum

Zum Index

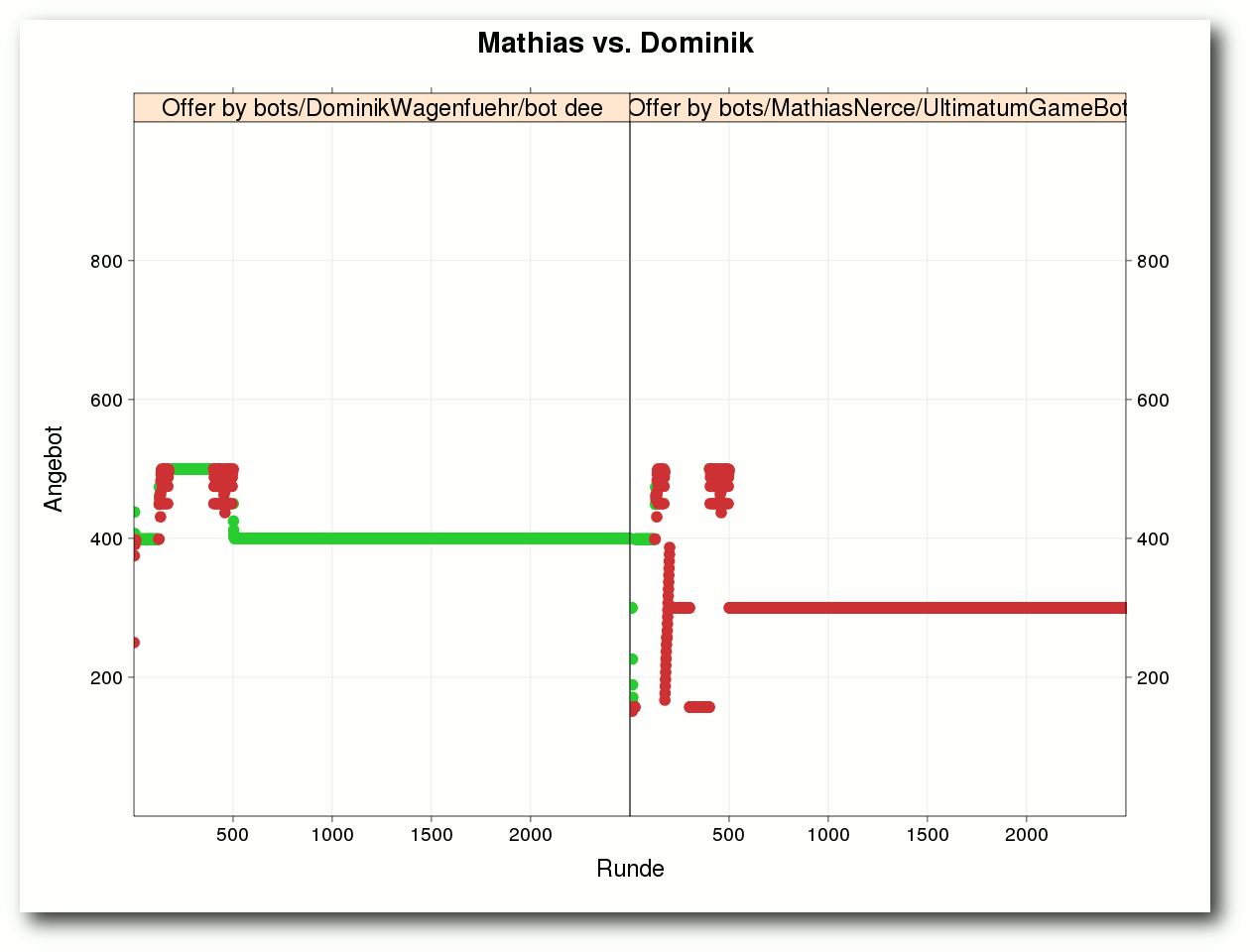

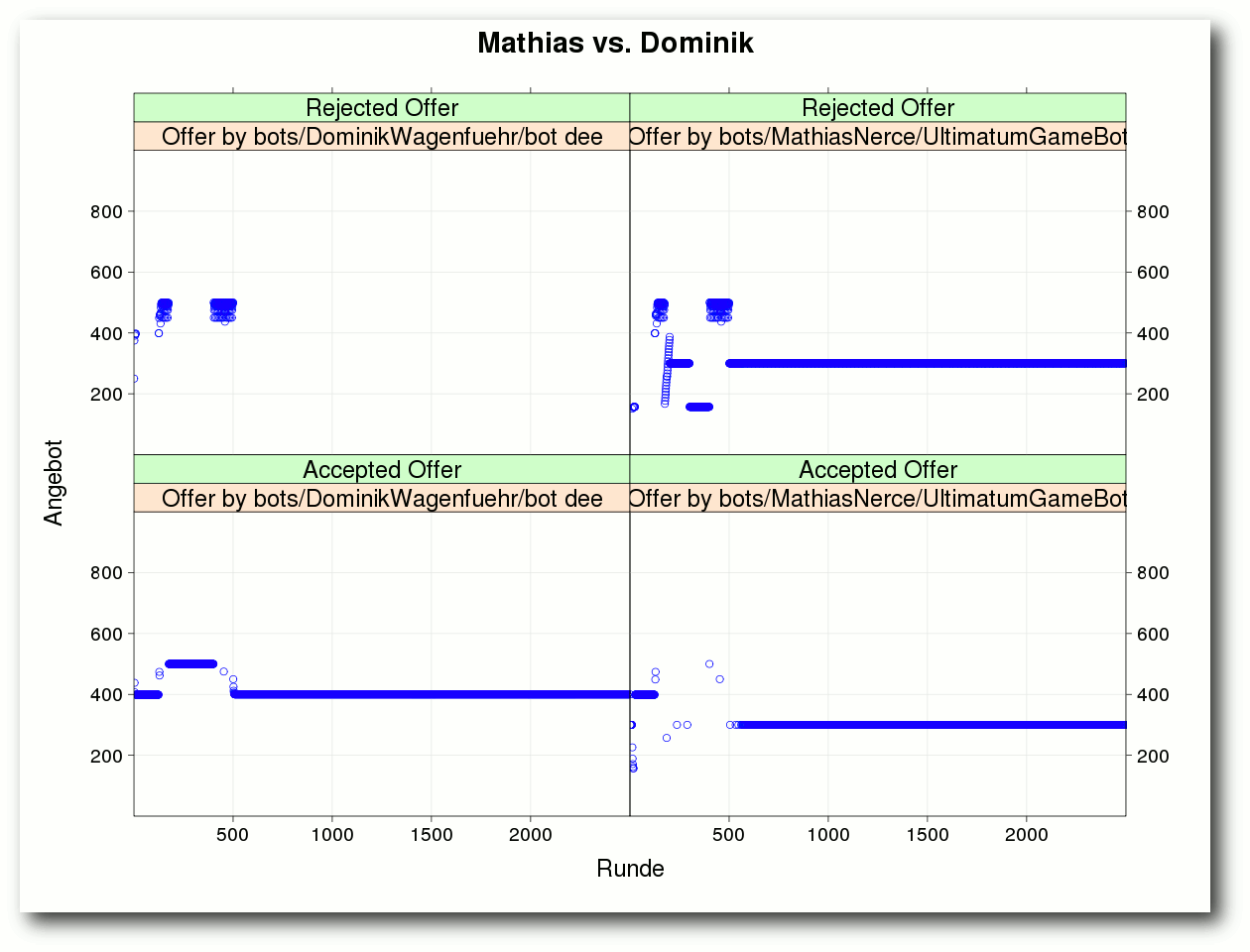

Vierter Programmierwettbewerb

Wie auf der freiesMagazin-Webseite bereits Mitte Dezember zu lesen war [1],

wurde der Wettbewerb erfolgreich beendet und 26 Teilnehmer kämpften

um die vorderen drei Ränge. Im Artikel „Gewinner des vierten Programmierwettbewerbs“ findet man eine ausführliche Vorstellung der

teilnehmenden Bots.

Wir möchten uns an dieser Stelle noch einmal bei allen Teilnehmern

bedanken und freuen uns bereits auf den nächsten Wettbewerb. Wenn

die Teilnahmequote immer so hoch liegt, sollte ein Programmierwettbewerb

auch in Zukunft kein Problem sein.

Logoänderungen

Eher subtil kommt eine Änderung am freiesMagazin-Logo daher. Arne Weinberg

hat uns einen neuen Entwurf zugesandt, den wir gerne angenommen haben.

So befindet sich der Schatten des Icons nun nicht mehr dahinter,

sondern als Verlauf im Icon selbst. Entsprechend wurden auch unsere

Logos und Icons auf der Extras-Seite [2]

aktualisiert.

Als zusätzliche Änderung stehen die neuen Logos nun wie der gesamte

Inhalt von freiesMagazin unter der Lizenz „Creative Commons

Namensnennung-Weitergabe unter gleichen Bedingungen 3.0 Unported“ [3]

und nicht mehr unter der GNU FDL, wie dies bisher der Fall war. Die

Vereinheitlichung macht die Benutzung und Weitergabe des Magazins

für Sie, aber auch für uns etwas einfacher.

Jahresrückblick

Einen kleinen Jahresrückblick soll es auch wieder geben.

Insgesamt wurden in

den zwölf Monaten 114 Artikel geschrieben, die sich auf 40 freiwillige

Autoren aufteilen. Im Schnitt gab es also 10 Artikel pro Ausgabe.

Seitentechnisch spiegelte sich das so wieder, dass eine freiesMagazin-Ausgabe

pro Schnitt 50 Seiten umfasst – und das Monat für Monat.

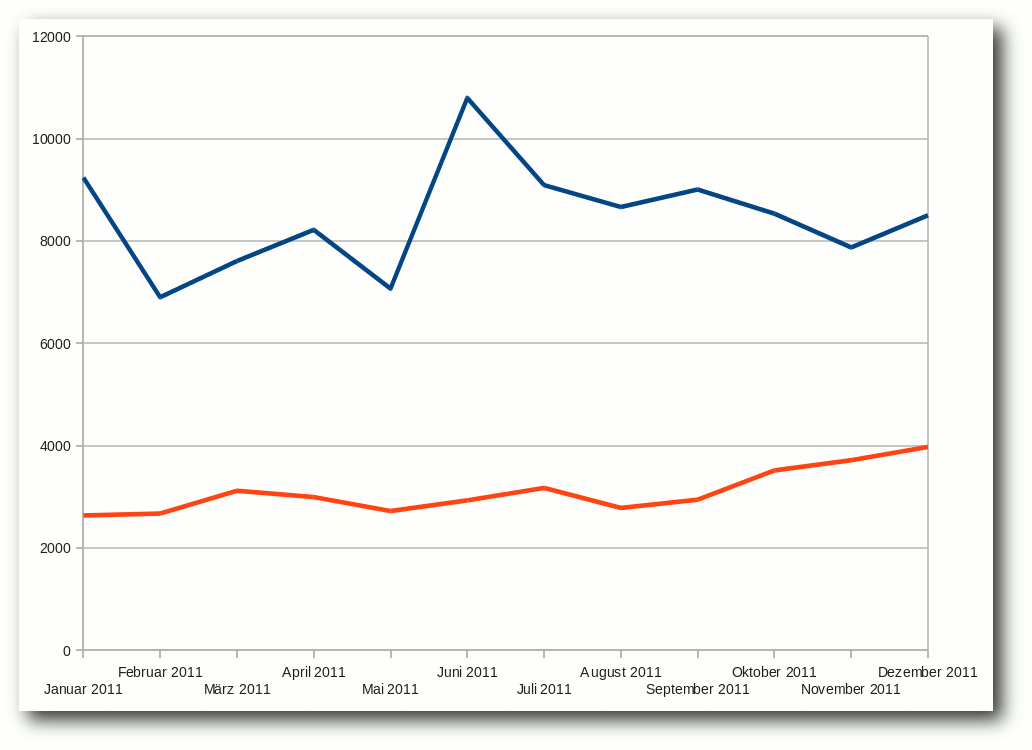

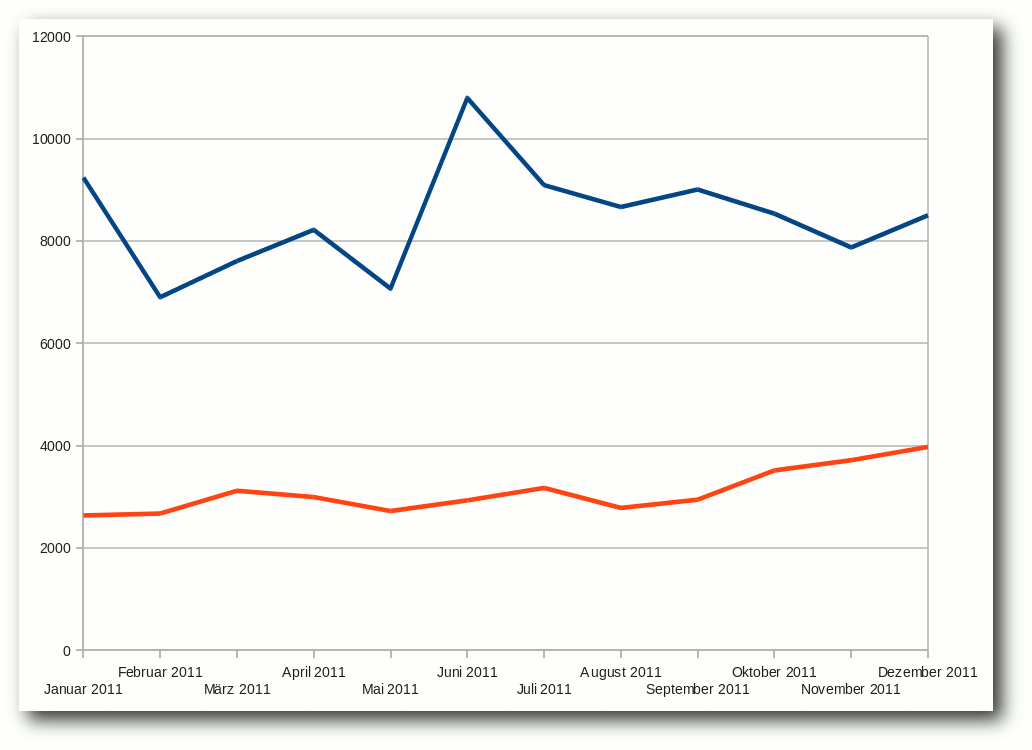

Die Downloadzahlen des Magazins in 2011 schwankten wie immer recht

stark. Für eine neue freiesMagazin-Ausgabe gab es durchschnittlich 8456

PDF-Downloads im Monat der Veröffentlichung. Der schlechteste Monat

war dabei der März 2011 mit nur 7067 PDF-Downloads, wohingegen der

Juni 2011 mit 10793 den Höchstwert des Jahres erzielte. Bei der

HTML-Version schwankten die Zahlen etwas weniger und lagen immer um die

3000 Klicks, wobei man zum Jahresende sogar eine kleine Steigerung

sehen konnte.

Es sei angemerkt, dass die Zahlen nicht exakt sein müssen und man

daraus auch nicht ableiten kann, wie viele Leser freiesMagazin wirklich hat,

denn die Weitergabe als PDF oder als Ausdruck ist ohne Probleme

möglich (und sogar gewollt).

Daneben wird die HTML-Version sicher auch von einer Person manchmal

mehrfach aufgerufen.

Downloads: PDF- (blau) und HTML-Version (orange).

Echte Mobilversion

Nachdem sehr oft der Wunsch nach einer echten Mobilversion von

freiesMagazin an uns herangetragen wurde, haben wir versucht, mit

Sigil [4] ein EPUB zu erstellen,

was nun fleißig getestet werden soll. Die Umfrage vor einem Jahr [5]

deutet

zwar nicht unbedingt darauf hin, dass ein EPUB notwendig ist,

aber im Laufe des Jahres 2011 sind Ebook-Reader und vor allem

Touchpads immer mehr in Mode gekommen, sodass wir uns

hier nicht

verschließen wollen.

Wir haben uns für eine Umsetzung mit Sigil entschieden, da die

Ergebnisse mit Calibre [6] im

direkten Vergleich ziemlich schlecht waren, was Schriftbild und

Seitengestaltung anging.

Da wir selbst aber kaum Testmöglichkeiten haben, sind nun Sie alle

aufgerufen, das EPUB auf Ihr mobiles Gerät zu transportieren und

zu testen. Bitte teilen Sie uns über den Kommentarlink am Ende des

Artikels oder direkt über  mit, welche Probleme Sie mit dem

EPUB haben. Gegebenfalls fehlen noch irgendwelche Meta-Angaben,

die Bilder wirken nicht gut oder Links fehlen.

Alles, was zur

Verbesserung beiträgt, hilft uns.

Schreiben Sie uns bitte auch, wenn mit dem EPUB alles in

Ordnung ist. Wir möchten natürlich wissen, ob die Arbeit, die wir in

das EPUB stecken, überhaupt angenommen wird. Falls sich niemand meldet,

gehen wir davon aus, dass niemand eine Mobilversion benötigt, und

wir sparen uns die Arbeit, die die Konvertierung mit sich bringt.

Da wir zwei Versionen zum Download anbieten, sind wir auch an Ihrer

Meinung zu den beiden Versionen interessiert. Benötigen Sie zwei

Versionen oder reicht Ihnen eine? Wenn ja, welche? Hierfür haben wir

auf unserer Webseite eine Umfrage eingerichtet, an der Sie

teilnehmen können [7].

Wir freuen uns über jede Stimme, denn nur mir Ihrer Hilfe kann das Magazin besser werden.

Und nun wünschen wir Ihnen viel Spaß mit der neuen Ausgabe.

Ihre freiesMagazin-Redaktion

Links

mit, welche Probleme Sie mit dem

EPUB haben. Gegebenfalls fehlen noch irgendwelche Meta-Angaben,

die Bilder wirken nicht gut oder Links fehlen.

Alles, was zur

Verbesserung beiträgt, hilft uns.

Schreiben Sie uns bitte auch, wenn mit dem EPUB alles in

Ordnung ist. Wir möchten natürlich wissen, ob die Arbeit, die wir in

das EPUB stecken, überhaupt angenommen wird. Falls sich niemand meldet,

gehen wir davon aus, dass niemand eine Mobilversion benötigt, und

wir sparen uns die Arbeit, die die Konvertierung mit sich bringt.

Da wir zwei Versionen zum Download anbieten, sind wir auch an Ihrer

Meinung zu den beiden Versionen interessiert. Benötigen Sie zwei

Versionen oder reicht Ihnen eine? Wenn ja, welche? Hierfür haben wir

auf unserer Webseite eine Umfrage eingerichtet, an der Sie

teilnehmen können [7].

Wir freuen uns über jede Stimme, denn nur mir Ihrer Hilfe kann das Magazin besser werden.

Und nun wünschen wir Ihnen viel Spaß mit der neuen Ausgabe.

Ihre freiesMagazin-Redaktion

Links

[1] http://www.freiesmagazin.de/20111211-gewinner-des-vierten-programmierwettbewerbs

[2] http://www.freiesmagazin.de/extras

[3] http://creativecommons.org/licenses/by-sa/3.0/deed.de

[4] https://code.google.com/p/sigil/

[5] http://calibre-ebook.com/

[6] http://www.freiesmagazin.de/20110110-umfrage-mobilversion-freiesmagazin

[7] http://www.freiesmagazin.de/20120108-welche-epub-version-bevorzugen-sie

Das Editorial kommentieren

Zum Index

von Sujeevan Vijayakumaran

Das Ziel von ReactOS [1] soll sein, dass

Programme und Treiber, die für Windows NT und dessen Nachfolger

entwickelt wurden, auch unter ReactOS verwendbar sind. Das freie

Betriebssystem ist in großen Teilen unter der GNU GPL lizenziert.

Einige Bestandteile stehen hingegen unter BSD- und LGPL-Lizenz. Das

Projekt selbst betitelt ReactOS nicht als Windows-Nachbau, sondern

als ein zu Windows binärkompatibles Betriebssystem.

Allgemeines

ReactOS [2] wird anhand von

öffentlichen Dokumentationen zu Windows geschrieben. Die Entwickler

versuchen durch diese Dokumentationen zu verstehen, wie Windows

funktioniert und arbeitet. Die gesamte Entwicklung geschieht durch

Reverse Engineering [3],

da die Systemfunktionen rekonstruiert werden. Problematisch für die

Entwicklung des Systems ist, dass viele Applikationen

Programmierschnittstellen aufrufen, die nicht öffentlich

dokumentiert sind. Es fließt kein originaler Windows-Code hinein,

sodass ReactOS völlig legal bleibt, da nur öffentliche Informationen

zur Entwicklung genutzt werden.

ReactOS basiert weder auf Unix noch auf Microsoft Windows. Die

Kernbestandteile des Systems wurden von Grund auf neu geschrieben,

da nichts von anderen Projekten wie Linux oder BSD übernommen werden

konnte. Es werden jedoch die unabhängigen Bibliotheken des

Wine-Projektes [4] verwendet, da diese ohne

größere Probleme genutzt werden können.

Geschichte

Die Geschichte von ReactOS beginnt im Jahr 1996. Damals wurde das

Projekt unter dem Namen „FreeWin95“ ins Leben gerufen. Zu

Projektbeginn wurde lange Zeit reichlich diskutiert, wie man das

Projekt gestalten soll, bis es nach und nach zum Erliegen kam ohne

etwas vorweisen zu können. Der Projektkoordinator Jason Filby rief

im Jahr 1998 in der Mailingliste das Projekt

erneut auf. Das

Projekt wurde fortan unter dem Namen „ReactOS“ weitergeführt, so wie

es heute noch heißt. Einige Jahre lang wurde der Kernel von einem

engen Entwicklerkreis geschrieben, sodass die Entwicklung nur

ziemlich langsam voran ging. Nachdem der Kernel

stabiler wurde und die ersten Treiber eingeflossen waren, konnten

dann mehr Personen in die Entwicklung einsteigen.

Über die Jahre entwickelte das Team von ReactOS das System weiter.

Die aktuelle Version ist eine Alpha-Version mit der

Versionsbezeichnung 0.3.13, die im März 2011 veröffentlicht wurde.

Download und Installation

Die Webseite von ReactOS bietet vier verschiedene Endbenutzer-Pakete

zum Herunterladen an [5].

Neben einer normalen Installations-CD gibt es noch eine Live-CD und

vorinstallierte virtuelle Maschinen für QEMU und VMWare. Die Größe

der Installations-CD beträgt knapp 63 MB und liegt als

32-Bit-Variante vor.

Die Installation von ReactOS ist sehr stark an den Installationsprozess

von Windows XP angelehnt. Beim Start der Installation ist es

zunächst möglich, die Sprache zu wählen, die das System verwenden

soll. Darunter ist auch die deutsche Sprache. Im nächsten

Schritt erscheinen einige Warnhinweise. Da ReactOS eine frühe

Alpha-Version ist, ist auch der Installationsprozess mit einigen

Einschränkungen verbunden.

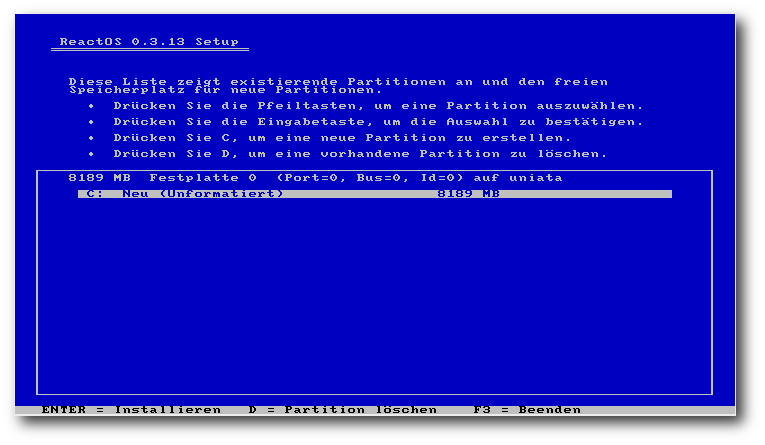

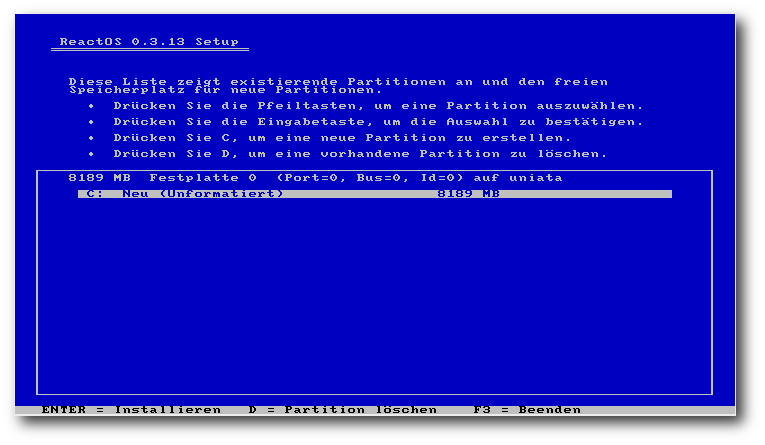

So kann das Setup nur eine primäre Partition auf der Festplatte

verwalten, und es ist nicht möglich, eine primäre Partition von der

Festplatte zu löschen. Ebenfalls kann das Setup die erste erweiterte

Partition nicht löschen, bis weitere erweiterte Partitionen auf der

Festplatte existieren. Weiterhin wird nur FAT als Dateisystem

unterstützt. In der nächsten Stufe sind nochmals die aktuellen

Geräteeinstellungen aufgelistet, darunter unter anderem die

Bildschirmauflösung und

das Tastaturlayout. In der darauf folgenden

Phase kann man die Festplatte partitionieren. Da für diesen

Artikel die Installation in einer VirtualBox-Instanz durchgeführt

wurde, wurde nur eine Partition mit der Größe von 8 GB verwendet,

welche mit dem FAT32-Dateisystem formatiert wird.

Partitionieren während der Installation.

Nach der Partitionierung muss man das Installationsverzeichnis für

ReactOS wählen. Als Vorschlag wird hier \ReactOS aufgeführt,

das in diesem Installationsprozess auch verwendet wird. Im

nächsten Schritt wird die Installation ausgeführt, welche recht

zügig vonstatten geht und innerhalb weniger Sekunden beendet ist.

Danach gibt es ein Auswahlmenü, um den Boot-Loader auf die

Festplatte oder auf eine Diskette zu installieren. Es ist auch

möglich, den Boot-Loader nicht zu installieren. Nach diesem Schritt

ist der Installationsprozess fertig und die Einrichtung des

Systems kann nach einem Neustart fortgeführt werden.

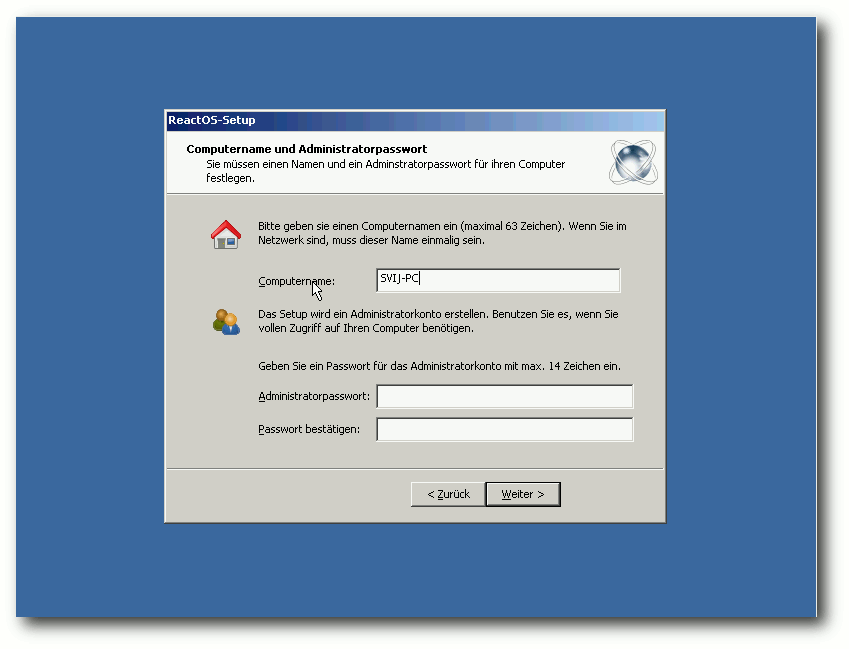

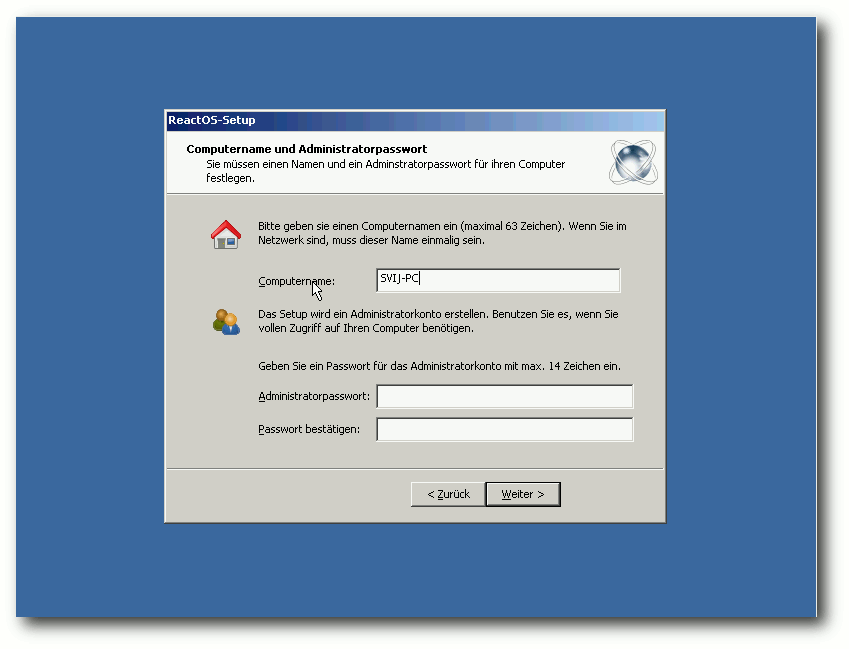

Nach dem Neustart läuft zuerst der Setup-Assistent von ReactOS. Ab

diesem Punkt ist eine graphische Oberfläche vorhanden. Zunächst

bedankt sich ReactOS bei vielen Open-Source-Projekten, von denen

teilweise Code verwendet wird. Darunter unter anderem Wine, FreeBSD

und X. Auch die weiteren Schritte sind an die

Windows-XP-Installation angelehnt. Nach der Angabe des eigenen

Namens geht es mit dem Setzen des Computernamens und eines

Administratorpassworts weiter. Im nächsten Abschnitt kann man

nochmals die regionalen Einstellungen ändern. Darunter fällt nicht

nur das Tastaturlayout, sondern auch die Darstellung von Zahlen,

Währungen und des Datums. Nach dem Setzen der aktuellen Uhrzeit und

des Datums wird die Installation fertig gestellt und

nach einem weiteren Neustart wird das System erstmals richtig gestartet.

Der Setup-Assistent.

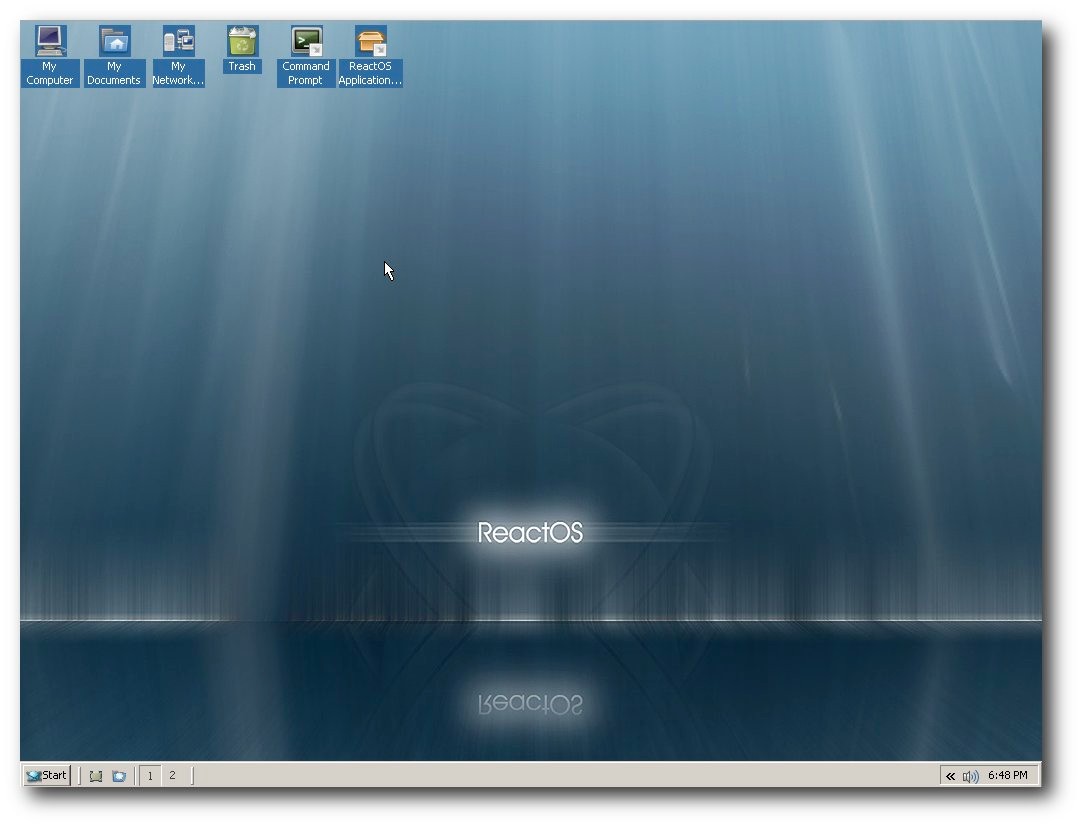

Der erste Start

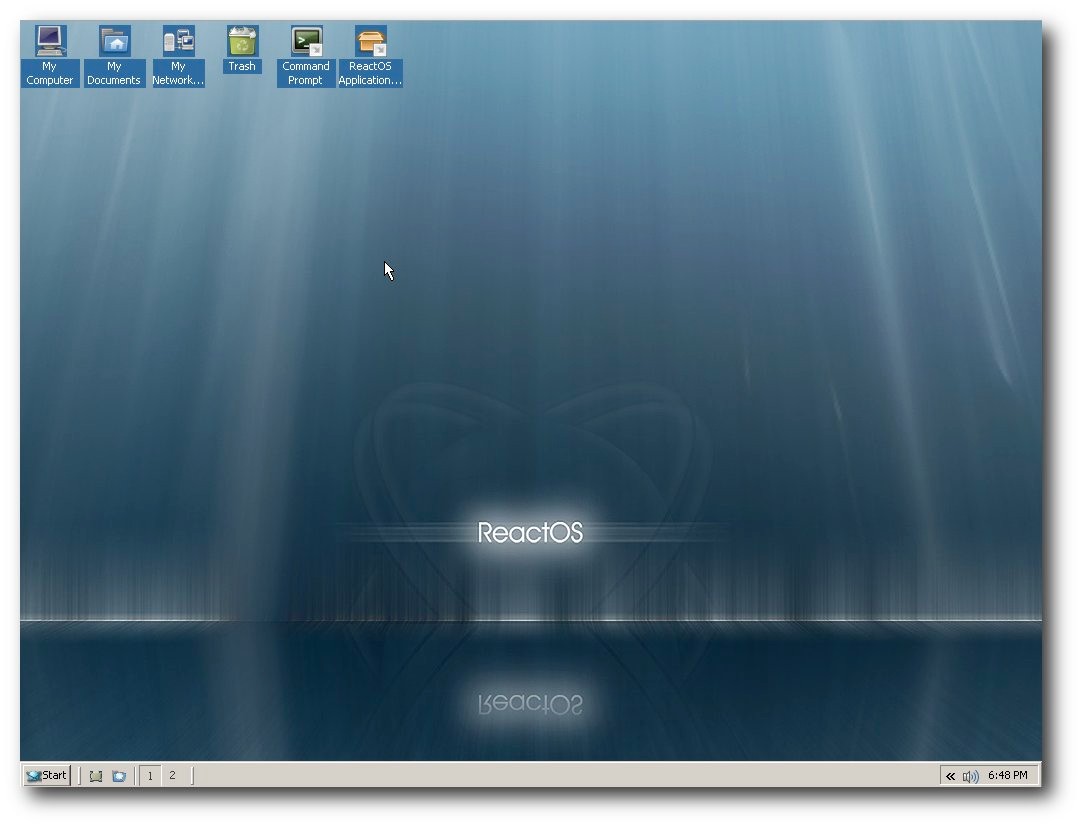

Beim ersten Start des Systems zeigt sich nun auch der Desktop.

Zunächst erscheint jedoch bei dieser Systeminstallation der Aufruf

zur Installation der Treiber für die Audiogeräte. Die Treiber können

wahlweise automatisch oder aus einem bestimmten Verzeichnis

installiert werden. Vor der Installation wird jedoch auch

ausdrücklich gewarnt, dass durch den Prozess der Rechner abstürzen

kann oder auch das Starten des Systems dann nicht mehr ordnungsgemäß

funktioniert. Die automatische Installation schlug im Test jedoch

sowohl für die Audio-Treiber als auch für „System-Device“ fehl.

Die Arbeitsoberfläche von ReactOS.

Während der Installationsprozess stark an Windows XP angelehnt ist,

sieht der Desktop wiederum nach Windows 2000 aus. Auf der

Arbeitsoberfläche liegen standardmäßig sechs Icons. Auf der

Schnellstartleiste liegen zwei Icons. Mit dem einen kann man alle

offenen Fenster

minimieren und den Desktop darstellen lassen. Mit

dem anderen kann der ReactOS-Explorer geöffnet werden. Daneben gibt

es Schaltflächen, um zwischen zwei Desktops zu wechseln, wie man

es unter Linux kennt.

Das Startmenü in ReactOS

Anwendungen

Die Anzahl der vorinstallierten Anwendungen ist sehr überschaubar.

Neben einem Editor und einem Taschenrechner sind zudem noch Nachbauten von

Paint und Wordpad installiert. Des Weiteren ist unter anderem ein

Multimedia-Player und ein Audio-Recorder mit dabei. Neben einigen

wenigen weiteren Programmen sind auch drei Spiele-Klone mit an

Bord, darunter die Windows-Spiele-Klassiker „Spider Solitaire“ und

„Minesweeper“ unter dem Namen „WineMine“.

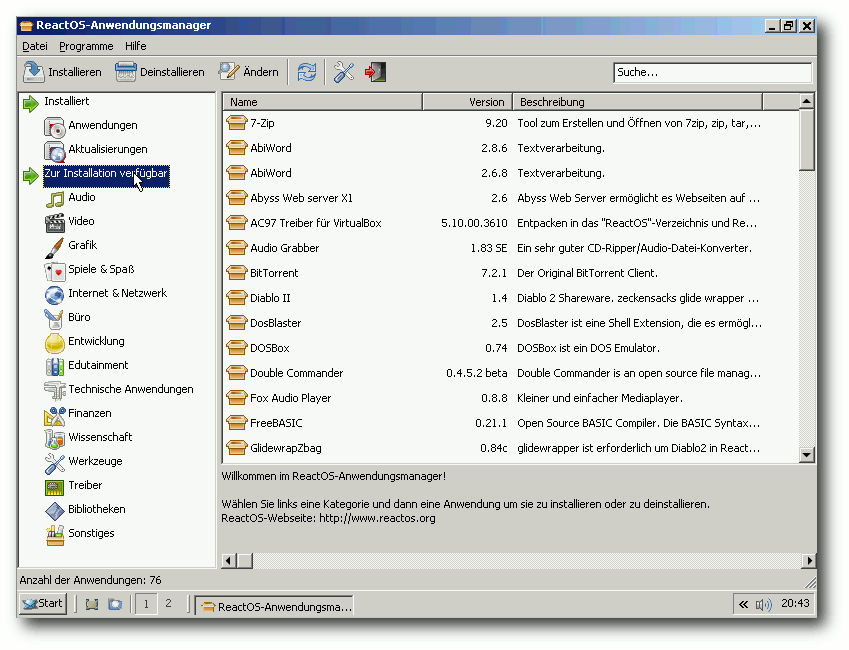

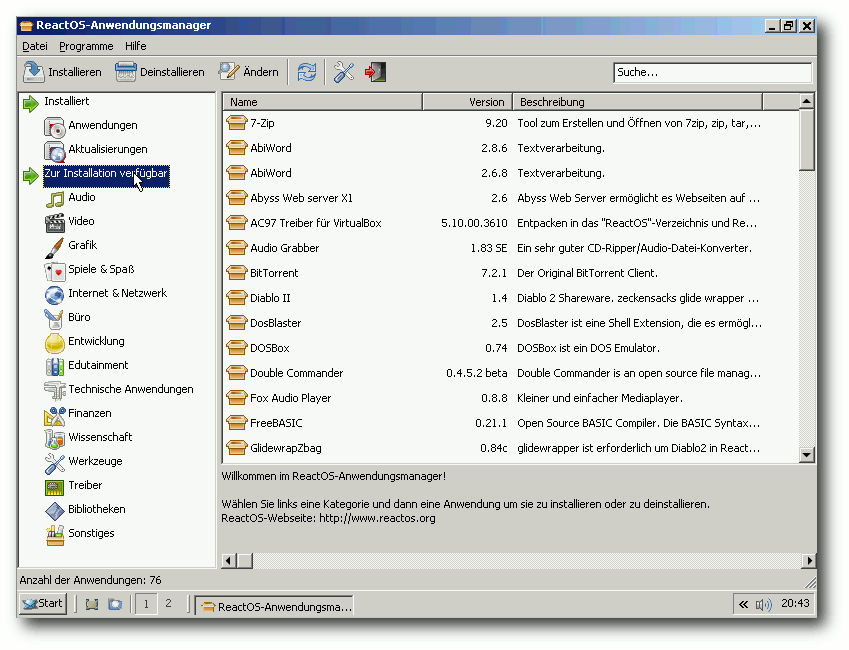

Das System wird standardmäßig mit einer Paketverwaltung mit dem Namen

„ReactOS-Anwendungsmanager“ ausgeliefert, womit man einige Programme

installieren kann. Die Anzahl der Programme ist jedoch sehr

übersichtlich und besteht derzeit aus 76 Anwendungen. Die Anwendungen

sind in verschiedene thematische Kategorien unterteilt. Viele

Kategorien wie Video, Edutainment, Technische Anwendungen, Finanzen

und Wissenschaft sind allerdings leer. Unter den Programmen finden sich

durchaus bekannte Anwendungen, wie beispielsweise VLC Media

Player, LibreOffice und Firefox. Jede dieser Anwendungen liegt in

einer aktuellen Version vor.

Der Versuch, LibreOffice zu installieren, schlug fehl. Es erschien

lediglich kurzzeitig ein Fenster, welches sehr schnell wieder

verschwand. OpenOffice.org in Version 3.3 ließ sich zwar problemlos

installieren, stürzte jedoch beim Start des Programms mit einer

Fehlermeldung ab. Die Installation und der Betrieb des Browsers

Firefox funktionierte hingegen problemlos. Im Anwendungsmanager gibt

es zwar eine Sektion, in dem die bereits installierten Anwendungen

aufgelistet werden, die probeweise installierten Programme Firefox

und OpenOffice.org wurden dort aber nicht aufgelistet.

In einem weiteren Test wurde ebenfalls über den

ReactOS-Anwendungsmanager versucht, 7-Zip zu installieren. Diese

Installation funktionierte und auch das Programm ließ sich normal

starten. Diesmal gab es sogar einen Eintrag von 7-Zip in der

entsprechenden Liste des Anwendungsmanagers. Danach wurde noch

versucht, GIMP und Pidgin zu installieren, wobei beide Programme

direkt von den Projekt-Webseiten heruntergeladen wurden. Auch hier

funktionierte die Installation, der Start scheiterte hingegen

erneut. Bei GIMP folgte eine Fehlermeldung, dass eine Bibliothek von

GIMP fehlt und eine Neuinstallation das Problem möglicherweise

beheben könnte. Die Meldung erschien dann noch weitere Male,

sodass nur ein Neustart half, die Meldungen zu beenden.

Die Deinstallation von Programmen läuft ebenfalls über den

Anwendungsmanager. Problematisch ist, dass dort nicht alle

installierten Programme aufgelistet werden. Ein Entfernen von GIMP

oder Pidgin war daher nicht möglich. Da nur 7-Zip unter den

getesteten Programmen enthalten war,

konnte auch nur dieses

deinstalliert werden. Beim Versuch es zu entfernen, startete ReactOS

plötzlich neu. Nach dem Start des Systems waren die Menüeinträge

von 7-Zip entfernt, der Eintrag im Anwendungsmanager war hingegen

noch vorhanden.

Der Anwendungsmanager

System

Das System ist momentan noch ziemlich schlicht gehalten, sowohl

optisch als auch vom Funktionsumfang. Es startet in einer

VirtualBox-Instanz innerhalb von wenigen Sekunden, was jedoch damit

zu erklären ist, dass es nicht eine annähernd große Funktionalität

mit sich bringt wie Windows oder eine aktuelle Linux-Distribution.

Die Geschwindigkeit des Systems lässt sich auch nur relativ

ausdrücken. Momentan funktioniert das meiste relativ flott, was – wie

beim Systemstart auch – mit der fehlenden Funktionalität

zusammenhängt, die bis zu einer möglichen finalen Version noch

hinzukommt. Die Auslastung des Arbeitsspeichers ist verhältnismäßig gering

und beträgt bei einem frisch installierten System knapp 60 MB. Es

steigert sich während der Benutzung jedoch recht schnell auf etwa

100 MB. Auf der Festplatte werden anfangs 558 MB belegt.

Wie bereits oben erwähnt, lässt sich ReactOS zur Zeit nur auf einer

FAT32-Partition installieren. Der größte Nachteil, der dadurch

entsteht ist, dass die Größe einer Datei 4 GB nicht überschreiten

kann. Auf der Seite über die meist gestellten Fragen [6]

nennt das Projekt die Gründe, warum noch kein NTFS als Dateisystem

unterstützt wird. Zum einen existieren zu NTFS keine Dokumentationen,

dadurch ist es für die Entwickler sehr schwierig, ein einwandfrei

funktionierendes Dateisystem zu programmieren. Zum anderen ist

NTFS ein sehr komplexes Dateisystem.

Bei diesem Punkt stellt sich daher auch die Frage, wie die

NTFS-Unterstützung unter Linux funktioniert. In dem Fall wird unter

Linux kein natives NTFS unterstützt, sondern es wird

NTFS-3G [7] verwendet, welches

nur als Treiber für NTFS-Dateisysteme fungiert. Es setzt hierbei auf

FUSE [8] auf.

FUSE ist ein Kernel-Modul, das es ermöglicht, das Einbinden von

Dateisystem-Treibern vom Kernel-Mode in den User-Mode zu

verlagern. ReactOS möchte im Gegensatz zu Linux oder anderen

Systemen eine native NTFS-Unterstützung haben. Zur Zeit ist die

Priorität für NTFS seitens der Entwickler eher gering, da andere

Teile von ReactOS aktuell wichtiger sind.

Beim Durchstöbern des Systems fällt schnell auf, dass einige

Programme vorhanden sind, für die unter Windows keine Menüpunkte

existieren. Dazu zählen zum Beispiel der Registry-Editor oder das

Tool msconfig, um unter anderem Autostart-Programme zu deaktivieren.

Weiterhin wird klar, dass Einiges zwar schon grafisch implementiert

wurde, die wirkliche Funktion dahinter aber noch fehlt. So stößt man

durchaus mal auf einen Button, der beim Klick nur ein Fenster

öffnet, in dem man informiert wird, dass die Funktion noch nicht

implementiert ist.

Mitmachen

Die Webseite von ReactOS bietet eine spezielle Seite für den

Einstieg in die Entwicklung von ReactOS [9].

Wie auch bei anderen Open-Source-Projekten ist das Mitmachen bei dem

Projekt wichtig, damit die Entwicklung stets voran geht. Es werden

neben Entwicklern auch Autoren für Dokumentationen und

Server-Administratoren für die Infrastruktur benötigt. Bei neuen

Entwicklern ist zu beachten, dass nur die Entwickler programmieren

dürfen, die keinen Kontakt zu originalem Microsoft-Code haben,

sofern es diesen Bereich betrifft, da hier eine Beeinflussung

vorhanden sein könnte. ReactOS möchte so sicherstellen, dass der

Quelltext des Projekts legal bleibt. Neben den bereits genannten

Einsatzgebieten werden ebenfalls noch weitere Helfer für das

Übersetzen und Designen von ReactOS benötigt. Spenden werden ebenfalls

entgegen genommen.

Blick in die Zukunft

Die Zukunft von ReactOS sieht langfristig den Ausbau der aktuellen

Alpha-Version in eine Beta-Version mit der Nummer 0.5 vor. Später

soll dann das erste stabile Release mit der Versionsnummer 1.0

folgen. Wie lange dies noch dauert, lässt sich nicht abschätzen, da

eine große Anzahl der Entwickler nicht kontinuierlich zum Projekt

beiträgt. Aus diesen Gründen sei es schwierig, einen Zeitplan zu

nennen, da dieser nicht einzuhalten wäre, so die Aussage des

ReactOS-Teams auf der Wikiseite der Roadmap [10].

Das Team versucht trotzdem, etwa jedes halbe Jahr eine weitere

Alphaversion zu veröffentlichen.

Der Entwicklungsplan von ReactOS ist momentan nur ziemlich spärlich

vorhanden. Für die nächste Version 0.4.0 sind ein Plug-and-play-Manager

und einige Netzwerk- und Serverapplikationen geplant, wie etwa ein

DHCP- und ein Telnet-Server.

Des Weiteren ist die volle Unterstützung von USB-Tastaturen und

-Mäusen, Audio-Treibern und Windows 7 geplant. Außerdem soll es dann

auch eine volle native Unterstützung des Dateisystems NTFS geben.

Weiterhin ist noch die Unterstützung von Mehrkernprozessoren

angedacht, da bisher lediglich ein Prozessorkern unterstützt

wird. Zudem ist zur Zeit nur eine 32-Bit-Version von ReactOS

verfügbar. Wann eine 64-Bit-Version erscheint, ist noch unklar.

Im September 2011 wurde das Projekt dem damaligen russischen

Präsidenten Dmitri Medwedew vorgestellt, als dieser eine Schule

besuchte [11].

Ein 17-jähriger Schüler erhielt dadurch die Möglichkeit, ReactOS dem

russischen Präsidenten zu zeigen. Laut den Informationen des

Schülers brauche das Projekt etwa eine Million Euro, um die

Entwicklung innerhalb eines Jahres abschließen zu können. Medwedew

fand das Projekt interessant, sagte jedoch nichts über eine

finanzielle Unterstützung. So wurde zumindest das Projekt der

Regierung eines Staates bekannt und machte deutlich, dass das Projekt

durch einen großen Geldbetrag sehr gut gefördert werden kann, damit

die Entwicklung zügig voran geht. Bis dahin kann die Entwicklung bis

zur ersten stabilen Version durchaus noch einige Jahre in Anspruch

nehmen.

Kritik

Es gibt einige Kritiker, die keinen Sinn in der Entwicklung von

ReactOS sehen. Als Grund wird häufig angeführt, dass man die

Entwicklungsarbeit lieber in andere Projekte, wie etwa Wine,

stecken sollte, statt in ein binärkompatibles Windows. Zudem ist

ReactOS mittlerweile ziemlich alt, da die Entwicklung schon vor

einigen Jahren begann. Windows selbst hat sich seit dieser Zeit

deutlich weiterentwickelt. Fakt ist, dass ReactOS kein Linux ist,

und mit Linux an sich nichts zu tun hat. Daher wird es normale

Linux-Nutzer auch kaum ansprechen. Der Vorteil, den ReactOS

gegenüber Wine unter Linux hat, ist, dass ein fertiges ReactOS

Windows-Treiber installieren kann. Das ist ein wichtiger Punkt,

besonders für sehr alte Hardware, für die es weder lauffähige Treiber

für aktuelle Windows-Versionen noch für Linux gibt. Für mich hat ReactOS

den Vorteil, dass es als Windows-Ersatz auf alten Rechnern dienen kann,

besonders für die Nutzer, die kein Linux verwenden möchten. Allerdings nur

unter der Voraussetzung, dass in naher Zukunft eine stabile Version erscheint.

Fazit

Zum aktuellen Entwicklungsstand kann man kaum ein richtiges

Fazit ziehen. Klar ist, dass es wirklich eine sehr frühe

Alpha-Version ist und viele Systemkomponenten noch nicht bzw.

nicht einwandfrei implementiert sind.

Die Installation des Systems war der Punkt, der bei den Tests

größtenteils problemlos funktionierte. Dies ist jedoch bislang

noch mit Einschränkungen verbunden, da u. a.

nur FAT32-Partitionen unterstützt werden. Besonders schlecht sieht

es im Moment im Bereich der Anwendungen aus. Gängige Programme

ließen sich zwar installieren, aber am Ende funktionierten

nur Firefox und 7-Zip.

Man darf gespannt sein, wie sich ReactOS weiter entwickeln wird. Bis

zu einer Beta-Version fehlt neben der Funktionalität auch die

Stabilität. Bis ReactOS ein fertiges und reifes

Betriebssystem ist, kann durchaus noch viel Zeit vergehen,

da bis zum jetzigen Zeitpunkt die Entwicklung

eher mäßig voran geht. Beschleunigt werden kann dies möglicherweise

nur durch größere Spenden.

Links

[1] http://www.reactos.org/de/

[2] http://de.wikipedia.org/wiki/Reactos

[3] http://de.wikipedia.org/wiki/Reverse_Engineering

[4] http://www.winehq.org/

[5] http://www.reactos.org/de/download.html

[6] http://www.reactos.org/de/about_userfaq.html

[7] http://de.wikipedia.org/wiki/NTFS-3G

[8] http://de.wikipedia.org/wiki/Filesystem_in_Userspace

[9] http://www.reactos.org/de/dev.html

[10] http://www.reactos.org/wiki/Roadmap

[11] http://www.pro-linux.de/news/1/17502/russland-koennte-fertigstellung-von-reactos-finanzieren.html

| Autoreninformation |

| Sujeevan Vijayakumaran (Webseite)

interessiert sich für ein freies, zu Windows binärkompatibles

Betriebssystem und beobachtet daher die Entwicklung von ReactOS.

|

Diesen Artikel kommentieren

Zum Index

von Hans-Joachim Baader

Das neu erschienene Fedora 16 will den Benutzern wie jedes halbe

Jahr die neueste Freie Software und neueste Technologien bringen.

Redaktioneller Hinweis: Der Artikel „Fedora 16“ erschien erstmals bei

Pro-Linux [1].

Vorwort

Etwas später als ursprünglich

geplant, erschien Fedora 16

als Nachfolger des ein halbes Jahr alten Fedora 15 (siehe freiesMagazin

07/2011 [2]). Der

Schwerpunkt dieser Version ist offenbar die Cloud. Ansonsten enthält

die Distribution zwar viele Updates, aber keine tiefgreifenden

Änderungen. Diese Aussage gilt auch für die beiden populärsten

Desktopumgebungen, GNOME und KDE. Auf Systemebene kam es zur

Einführung des Bootloaders GRUB 2 und der Entfernung von HAL. Beides

dürfte den meisten Benutzern kaum auffallen. Fedora 16 wurde dem

kürzlich verstorbenen Unix-Pionier Dennis Ritchie

gewidmet [3].

Weitere Neuerungen gab es unter anderem bei der Virtualisierung. So

wird USB 2.0 in Gastsystemen unterstützt, Gastinspektion ist

möglich, ein virtueller Lock-Manager und ein auf pvops beruhender

Kernel für Xen wurden hinzugefügt.

Zu beachten ist auch, dass sich bei den numerischen Benutzer- und

Gruppen-IDs etwas geändert hat. Die IDs für normale Benutzer

beginnen jetzt wie bei anderen Distributionen bei 1000, nicht mehr

bei 500.

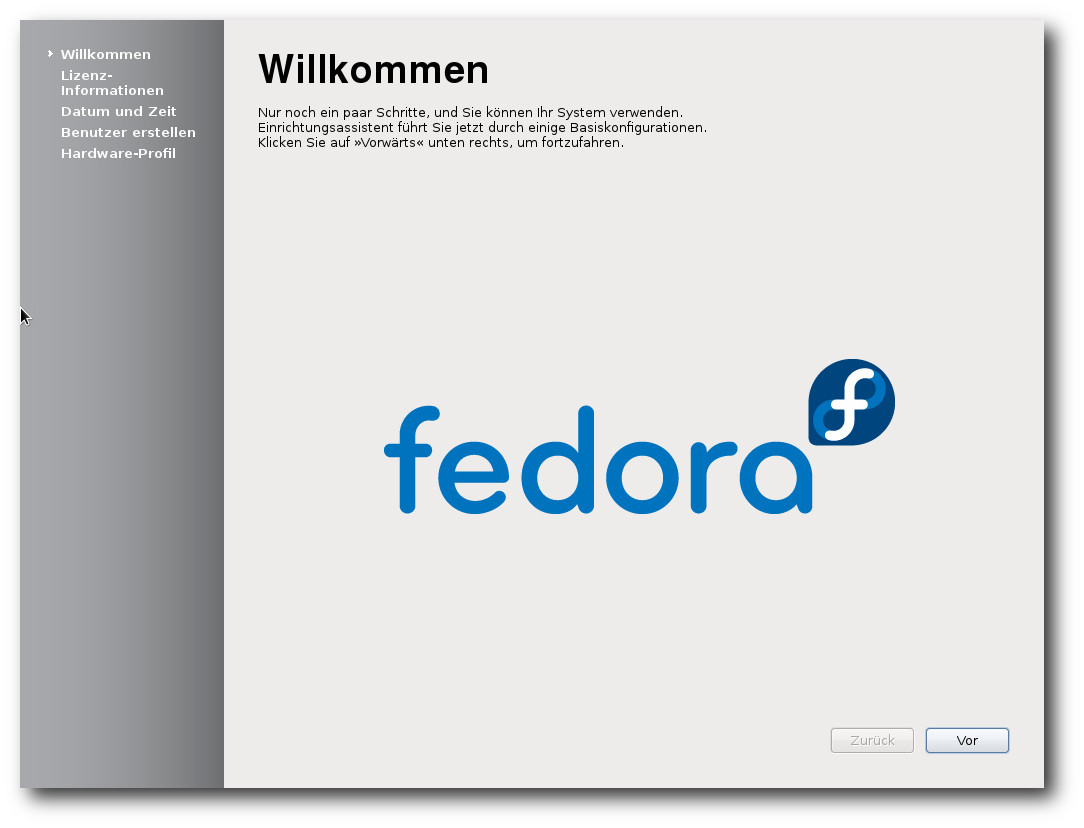

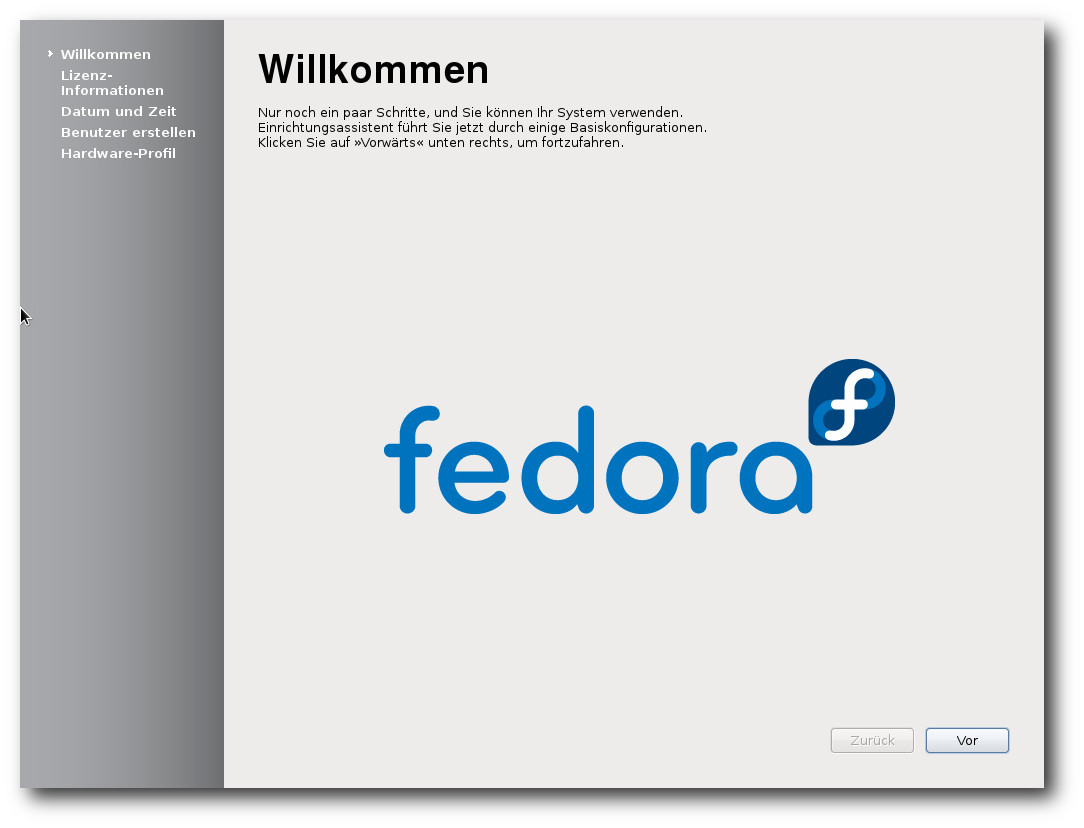

Fedoras Einrichtungsassistent.

Für Entwickler bietet Fedora 16 unter anderem vollständige

Entwicklungsumgebungen für Ada, D und Haskell und das verteilte

Bugtracking-System Be.

Im Umfeld kam Ask Fedora [4]

hinzu, eine Wissensplattform, auf der Anwender Fragen und Vorschläge

einreichen können. Die Plattform soll besonders einfach zugänglich

sein, da kein Log-in benötigt wird.

Dieser Artikel wird sich auf die Desktopumgebungen GNOME und KDE

beschränken. Aus

praktischen Gründen sind auch andere

Einschränkungen nötig. So wurden natürlich zahlreiche zur

Distribution gehörende Softwarepakete geändert oder ersetzt. Mit

wenigen Ausnahmen kann auf diese Änderungen nicht eingegangen

werden; man darf annehmen, dass die meisten Pakete unter allen

aktuellen Distributionen nahezu gleich sind und überall gleich gut

funktionieren.

Wie immer sei angemerkt, dass es sich hier nicht um einen Test der

Hardwarekompatibilität handelt. Es ist bekannt, dass Linux mehr

Hardware unterstützt als jedes andere Betriebssystem, und das

überwiegend bereits im Standard-Lieferumfang. Ein Test spezifischer

Hardware wäre zu viel Aufwand für wenig Nutzen. Falls man auf

Probleme mit der Hardware stößt, stehen die Webseiten von Fedora zur

Lösung bereit.

Da eine Erprobung auf realer Hardware nicht das Ziel des Artikels

ist, werden für den Artikel zwei identische virtuelle Maschinen,

64 Bit, unter KVM mit jeweils 768 MB RAM verwendet. Außerdem

wurde ein Netbook mit 32-Bit-CPU, aber funktionierender Grafikbeschleunigung,

von Fedora 15 auf 16 aktualisiert.

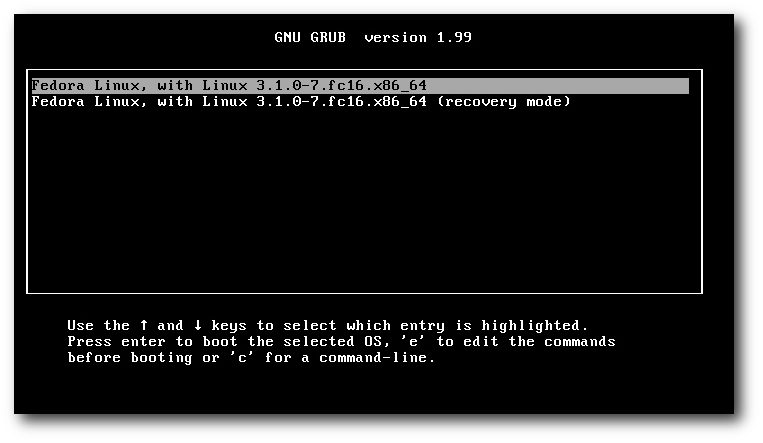

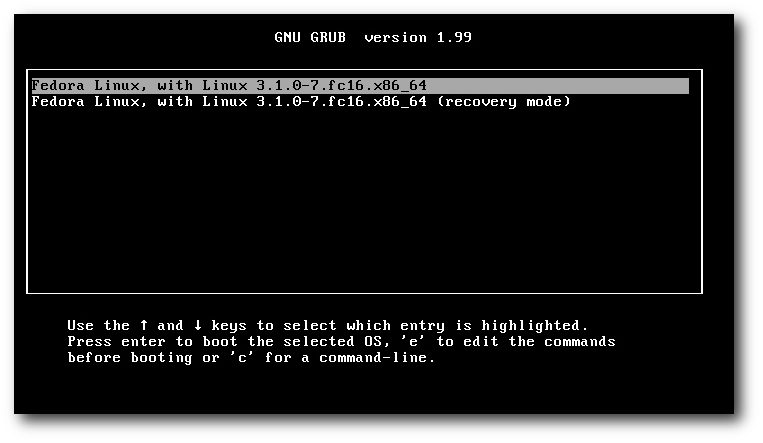

Bootprompt von GRUB 2.

Installation

Fedora kann von DVD, einem Satz von CDs, Live-CDs oder minimalen

Bootmedien installiert werden. Natürlich kann man aus einem

ISO-Image auch ein USB-Medium für die Installation erstellen. Die

Live-CDs, in den Varianten GNOME und KDE, sind aufgrund ihres

geringen Umfangs eher eine Notlösung für die Installation, denn es

fehlen dann unter anderem LibreOffice und Übersetzungen. Zwar

erfolgt die Installation binnen Minuten, da hierbei offenbar mehr

oder weniger nur ein Abbild der CD auf die Platte geschrieben wird,

aber für normale, vollständige Installationen sind die DVD oder das

minimale Image vorzuziehen, bei dem die eigentliche Distribution

über das Netz installiert wird.

Die Installation von Fedora erfordert mindestens 640 MB RAM. Damit

wurde die verhältnismäßig hohe Anforderung von 768 MB in Version 15

leicht reduziert, das Ziel von 512 MB aber verfehlt. Für den Betrieb

werden mehr als 1 GB empfohlen, was aber allenfalls für ziemlich

alte Rechner zu einem Problem wird.

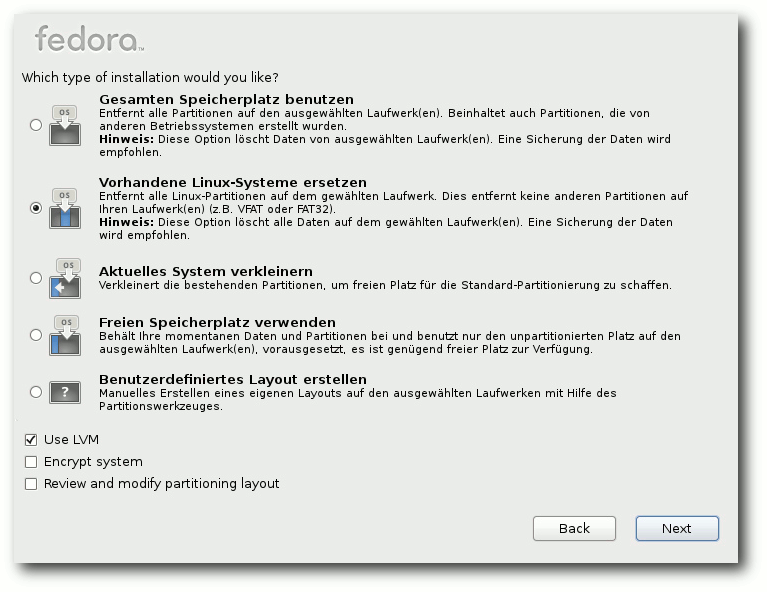

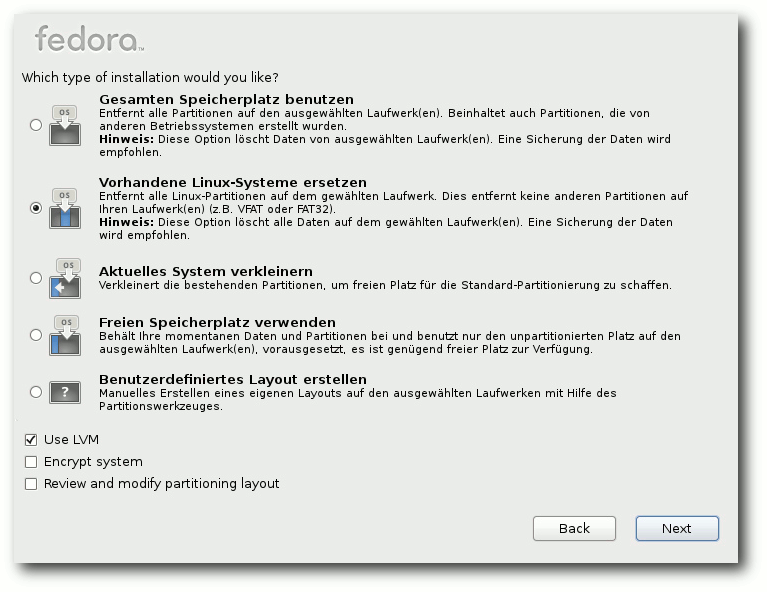

Die grafische Installation ist gegenüber Fedora 15 nahezu

unverändert. Bei der Partitionierung, die wie immer zahlreiche

Optionen bietet, gab es aber eine wichtige Änderung. Statt

MSDOS-Partitionstabellen wird nun GPT verwendet. Damit man davon

auch booten kann, muss man in vielen (allerdings nicht allen) Fällen

eine etwa 1 MB große BIOS-Boot-Partition anlegen. Bei der manuellen

Partitionierung geht das ganz einfach, indem man eine neue Partition

anlegt und als Typ „BIOS Boot“ auswählt. Vergisst man

das, erhält man eine Fehlermeldung „Sie haben kein Zielgerät für

Bootloader Stage 1 eingerichtet“ und muss diesen Schritt nachholen.

Auswahl der Partitionierungsmethode.

Bei der automatischen Partitionierung wird die BIOS-Boot-Partition

natürlich selbständig angelegt. Allerdings macht die Installation

die /boot-Partition 500 MB groß. Ich habe noch nie mehr als 200 MB

auch nur annähernd benötigt und halte die 500 MB daher für zu groß,

besonders bei kleineren Festplatten (man denke an SSDs). Als

zusätzliche Neuerung kann man nun wählen, ob man LVM verwenden will

oder nicht. Die Benutzung von GPT ermöglicht bis zu 128 Partitionen,

somit haben einige Anwender nun keinen Anlass mehr, LVM einzusetzen.

Dennoch ist LVM wesentlich flexibler als die anderen Optionen.

Verschlüsselung und RAID sind weiterhin verfügbar. Auch das

Dateisystem Btrfs steht als Option bei der Installation zur

Verfügung, aber das Standard-Dateisystem ist weiterhin ext4. Ein

Nachteil von Btrfs ist nach wie vor das Fehlen des Werkzeugs btrfsck

für Dateisystemreparaturen, ein zweiter die Tatsache, dass das

Dateisystem noch nicht so erprobt ist. Vielleicht wird die geplante

Erhebung von Btrfs zum Standard-Dateisystem in Fedora 17 kommen.

Somit kann man sagen, dass bezüglich der Partitionierung auch

weiterhin niemand Fedora etwas vormachen kann. Im eigens

bereitgestellten Installationshandbuch [5]

werden alle verfügbaren Optionen erörtert und Tipps gegeben. Dort

wird auch eine separate Home-Partition empfohlen, wenn möglich

verschlüsselt. Wählt man allerdings die Standard-Partitionierung bei

der Installation, wird keine Home-Partition angelegt.

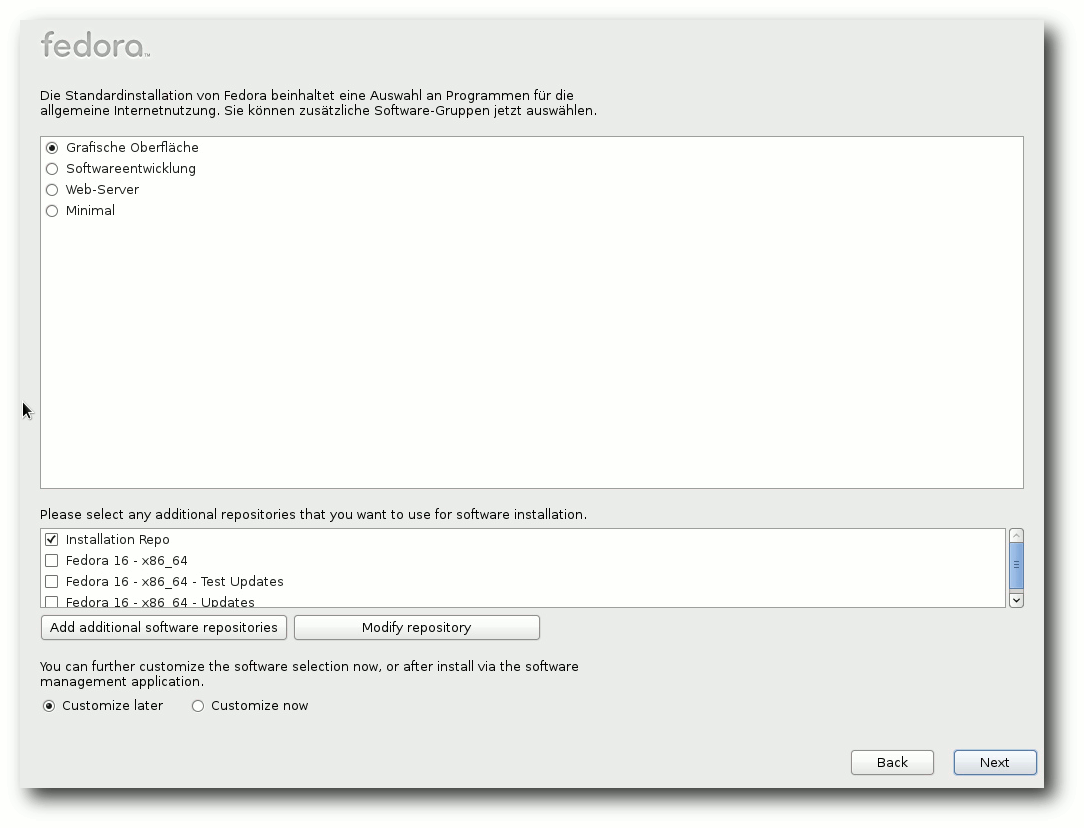

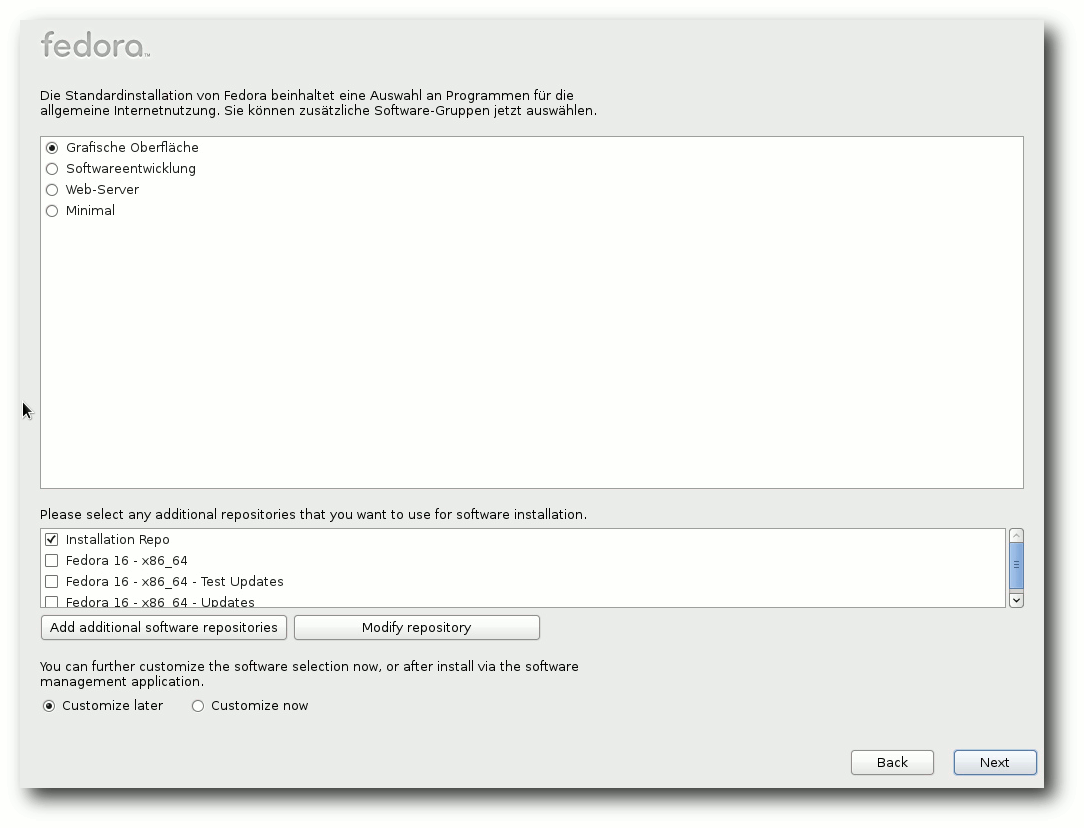

Ausstattung

Dass nahezu alle Softwarepakete, bei denen das möglich war,

aktualisiert wurden, versteht sich von selbst. Als Kernel kommt nun

eine erweiterte Version 3.1 zum Einsatz. Als Desktop-Systeme stehen

unter anderem KDE SC 4.7.2 und GNOME 3.2.1, teils mit Updates, zur

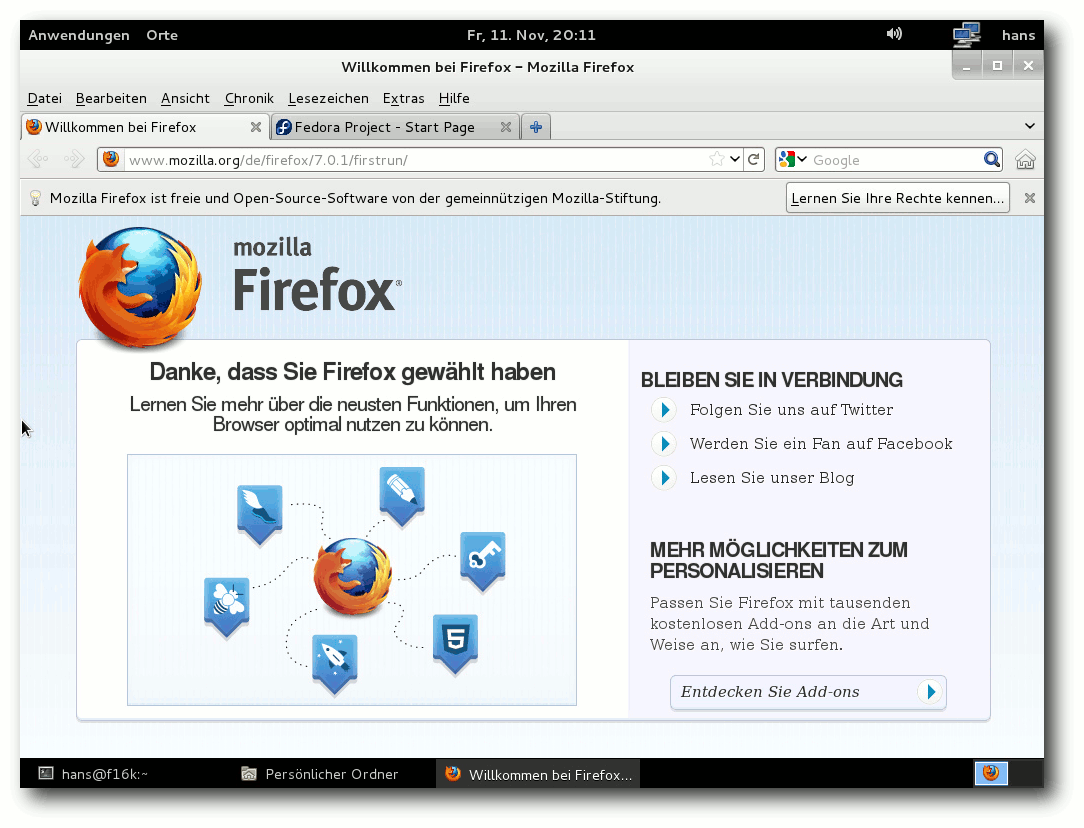

Verfügung. Der Standard-Browser unter GNOME ist Firefox 7.0.1. Unter

KDE steht neben dem etatmäßigen Konqueror ebenfalls Firefox zur

Verfügung. Auf 64-Bit-Systemen liegt Firefox als 64-Bit-Version vor.

Die Standard-Office-Suite auf beiden Desktops ist LibreOffice 3.4.3.

Vorausgewählte Software.

Fedora 16 startet etwa genauso schnell wie sein Vorgänger. Wie immer

ist SELinux eingebunden und aktiviert. Als normaler Benutzer merkt

man überhaupt nichts davon, solange die Konfiguration korrekt ist.

In Fedora 16 trat kein sichtbares Problem im Zusammenhang mit

SELinux auf. Für den Fall, dass ein Problem auftritt, sei es nach

der Installation von zusätzlicher Software oder anderen Änderungen,

steht ein Diagnosewerkzeug zur Verfügung.

GNOME 3 benötigt in Fedora 16 direkt nach dem Start mit einem

geöffneten Terminal-Fenster etwa 260 MB RAM, KDE etwa 420 MB. Bei

der Geschwindigkeit lässt sich kein nennenswerter Unterschied

zwischen den Desktops feststellen, sofern genug RAM vorhanden ist.

Für KDE

bedeutet das, dass man mindestens 768 MB RAM haben sollte

(was weniger als die offizielle Empfehlung von Fedora ist). Die

Angaben zum Speicherverbrauch sind nur als Anhaltswerte zu sehen,

die sich je nach Hardware und Messzeitpunkt erheblich unterscheiden

können.

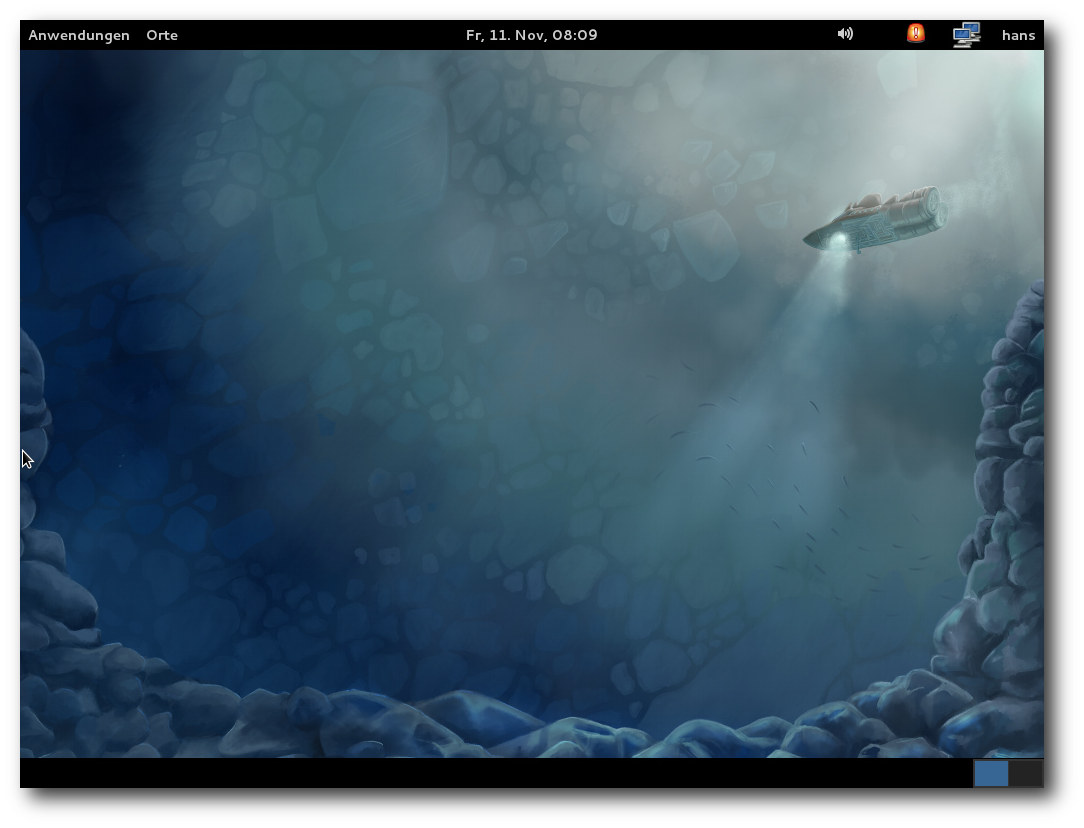

GNOME

GNOME 3.2 ist der Standard-Desktop von Fedora 16, wenn man nicht

ausdrücklich KDE, Xfce, LXDE oder anderes auswählt. Gegenüber

GNOME 3.0, das die erste Version einer ganz neuen Generation von

GNOME darstellte,

wurden zahlreiche allgemeine Verbesserungen

integriert. Auch in dieser Version benötigt die GNOME-Shell eine

3-D-Beschleunigung; ohne dieselbe gibt es nur den Fallback-Modus

oder, wie Fedora es nennt, den Ausweichmodus. Dieser ähnelt noch GNOME 2, hat aber im Grunde nicht mehr viel damit zu

tun. In der nächsten Version von GNOME und damit auch Fedora soll er

ganz verschwinden, da die GNOME-Shell dann auch auf unbeschleunigter

Grafik laufen soll.

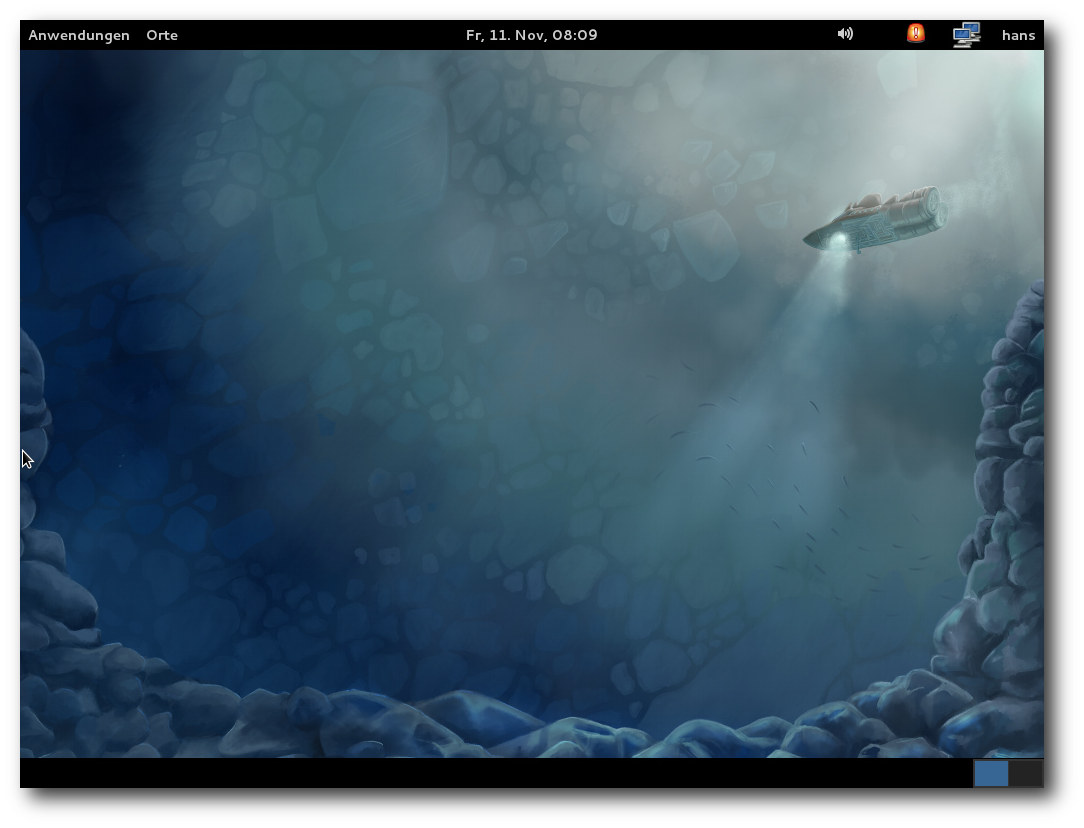

Desktop im Ausweichmodus.

In der GNOME-Shell wurden keine bedeutenden Änderungen vorgenommen,

lediglich kleinere Verbesserungen. Offenbar sind die Entwickler und

Benutzer der GNOME-Shell mit der grundsätzlichen Implementierung so

zufrieden, dass sie keine Notwendigkeit für größere Änderungen sahen.

Wegen der Ähnlichkeit mit der Version 3.0 ist es an dieser Stelle

nicht nötig, nochmals auf die GNOME-Shell einzugehen.

Selbstverständlich erfordert sie etwas Gewöhnung; sie ist aber ziemlich

intuitiv und auch in der Praxis effizient nutzbar, wenn man die eher

umständlichen Maus-Aktionen durch Tastenkürzel ergänzt. Oberflächlich

ähnelt die GNOME-Shell Unity von Ubuntu. Unter der Haube ist jedoch

alles anders. Die GNOME-Shell ist stabil, äußerst durchdacht und

weist keines der Probleme auf, die Unity in Ubuntu 11.10 mit sich

bringt. Das Konzept der „Linsen“ von Unity ist allerdings besser und

flexibler als die Suchfunktion der GNOME-Shell. In diesem Bereich

könnte die Shell spürbar verbessert werden.

Desktop im 3-D-Modus.

Noch immer lässt sich GNOME 3 nicht perfekt an eigene Vorstellungen

anpassen, aber immerhin kommt es nahe heran. Man kann dconf-editor

installieren, um direkten Zugriff auf alle GNOME-Einstellungen zu

erhalten, aber bei solchen Dingen sollte man wissen, was man tut.

Zudem besitzen die GNOME-Shell und Mutter auch da nur sehr wenige

Einstellungen.

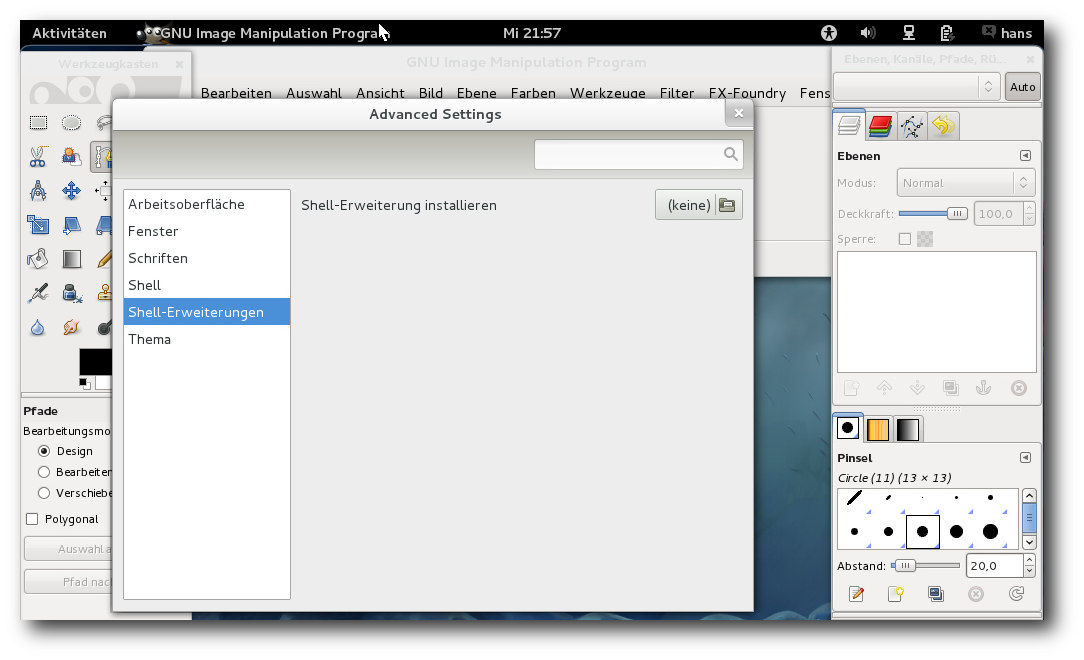

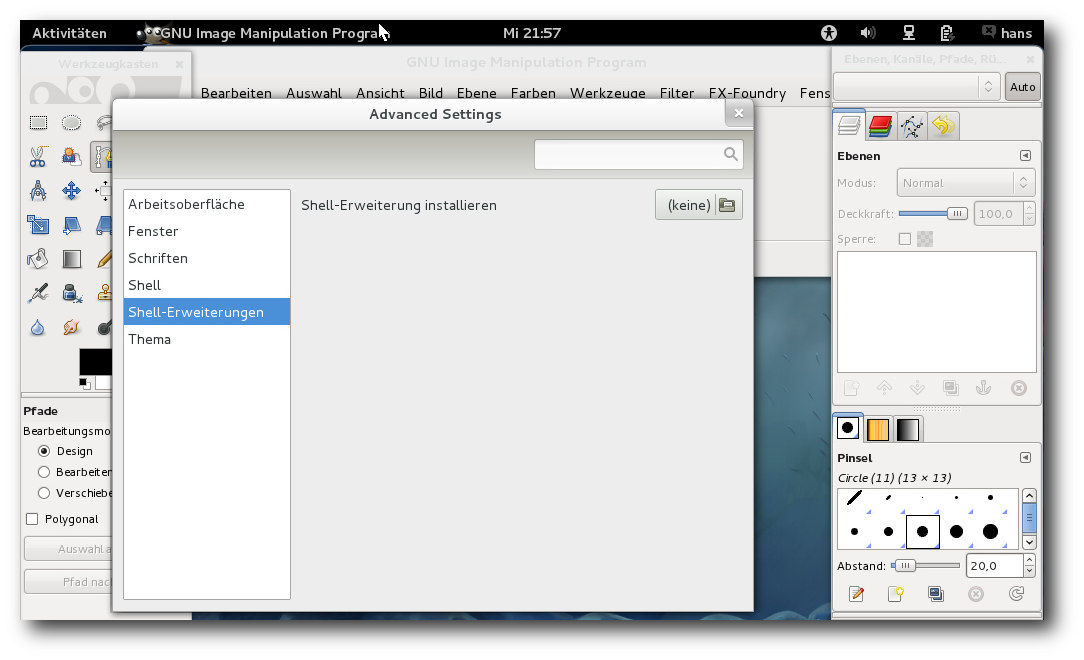

Einige weitere Einstellungen werden mit dem gnome-tweak-tool

zugänglich gemacht. Mittlerweile hilft sich die Gemeinschaft mit

Plug-ins für die GNOME-Shell [6]

selbst. Die Zahl der Shell-Erweiterungen dürfte schnell

wachsen, da der Fantasie hierbei keine Grenzen gesetzt sind.

Sie lassen sich über das gnome-tweak-tool installieren, aber noch

einfacher geht es bei den etwa zwei Dutzend Paketen, die bereits in

den Fedora-Repositorien liegen, da sie einfach über die

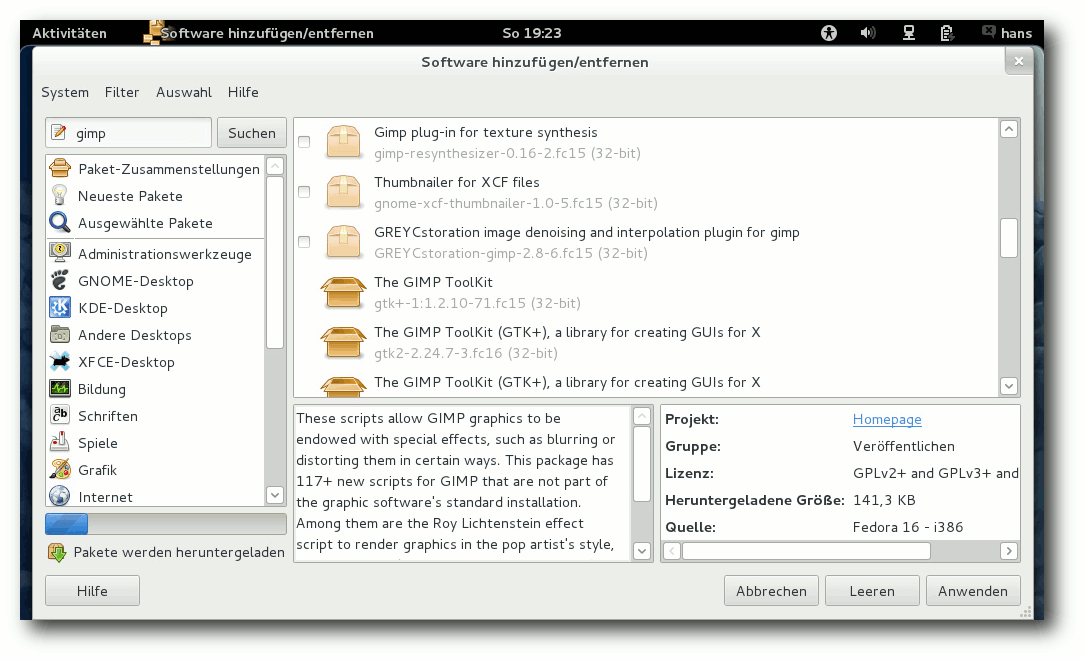

Paketverwaltung installierbar sind.

Installation von Shell-Erweiterungen.

KDE

KDE liegt nun in Version 4.7.2 mit KDE-PIM 4.7.2 vor (inzwischen

aktualisiert auf 4.7.3), deren wohl größte Neuerung die

Überarbeitung der Aktivitäten ist. Nach wie vor dürfte es Benutzern

schwerfallen, den Sinn von Aktivitäten zu sehen, da Arbeitsflächen

auf den ersten Blick das gleiche leisten. Und da Dokumentation zu

den Aktivitäten weitgehend fehlt, erschließt sich der Vorteil

einfach nicht.

Diverse KDE-Anwendungen wurden in der neuen Version natürlich auch

stark verbessert, aber grundlegende Änderungen blieben aus. Über den

normalen Umfang von KDE SC hinaus sind noch die Projektverwaltung

Planner installiert (die sich allerdings sofort aufhängte), das

Layoutprogramm Scribus, der Photo Layouts Editor und, aus

unerfindlichem Grund, eine Reihe von GNOME-Programmen, von

Evolution über Brasero bis Empathy. Das führt dazu, dass für

eine Reihe von Aufgaben mindestens zwei Programme im Startmenü

auftauchen, eines von GNOME und eines von KDE.

Der leere KDE-Desktop.

Multimedia

Wegen der Softwarepatente in den USA kann Fedora, ebenso wie die

meisten anderen Distributionen, nur wenige Medienformate abspielen,

da es viele benötigte Codecs nicht mitliefern kann. Wenn man

versucht, eine MP3- oder Videodatei abzuspielen, dann bieten die

gängigen Player aber die Option an, über die Paketverwaltung nach

passenden Plug-ins zu suchen. Leider fällt Rhythmbox nicht unter

diese Kategorie. Das Programm schafft es nicht einmal, eine

brauchbare Fehlermeldung zu produzieren, sondern meldet nur „Die

Wiedergabe konnte nicht gestartet werden“.

Damit die Suche in der Paketverwaltung Aussicht auf Erfolg hat, muss

man vorher die zusätzlichen Repositorys von RPM Fusion eintragen.

Wenn man weiß, wie es geht, ist es im Prinzip ganz einfach. Über die

Webseite von RPM Fusion [7] kann man Pakete

installieren, die die Repositorys hinzufügen. Dies gilt für GNOME

wie für KDE.

Nach dieser Vorbereitung sollten die Player unter GNOME und KDE in

der Lage sein, die benötigten Plug-ins selbsttätig zu installieren.

Merkwürdigerweise hat Totem aber ein Problem, wenn man ausgerechnet

mit der Suche nach einem MP3-Plug-in anfängt und noch keine Codecs

installiert sind – diese Suche schlägt fehl. Bei Videoformaten

funktioniert es aber. Am schnellsten und einfachsten ist allerdings

eine manuelle Installation der GStreamer-Plug-ins, insbesondere das Paket

gstreamer-ffmpeg.

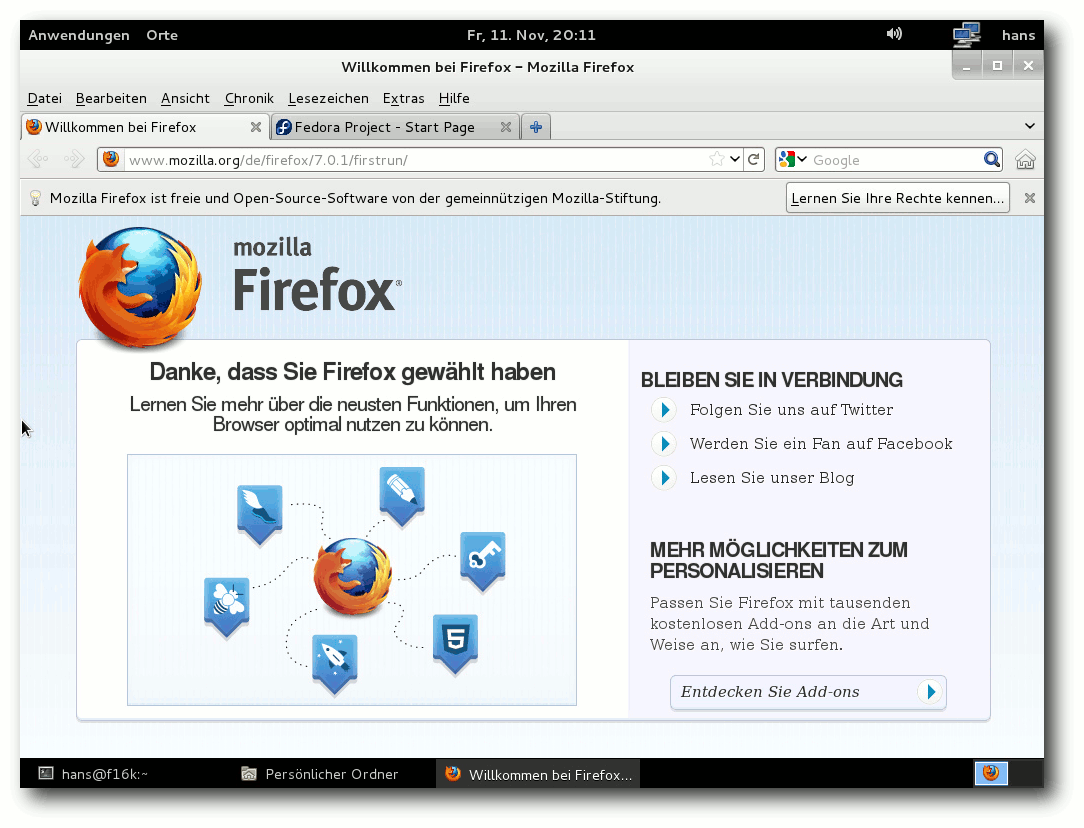

Startfenster von Firefox 7.0.1.

Totem erscheint bei Installation von DVD auch unter KDE als

Standard-Medienplayer, auch für MP3-Dateien. Kaffeine und

Dragonplayer sind als Alternativen installiert.

Beim Ausprobieren der Multimedia-Funktionen fiel auf, dass alle

Anwendungen hängen können, wenn sie eine Sound-Ausgabe machen und

diese blockiert wird. Das ist keine Kleinigkeit, denn mitunter

können Dialogboxen fehlen, ohne deren Beendigung das Programm nicht

fortgesetzt werden kann. Das Problem, das natürlich im Normalfall

nicht auftritt, ist vielleicht PulseAudio anzulasten, aber eindeutig

ließ sich das nicht klären.

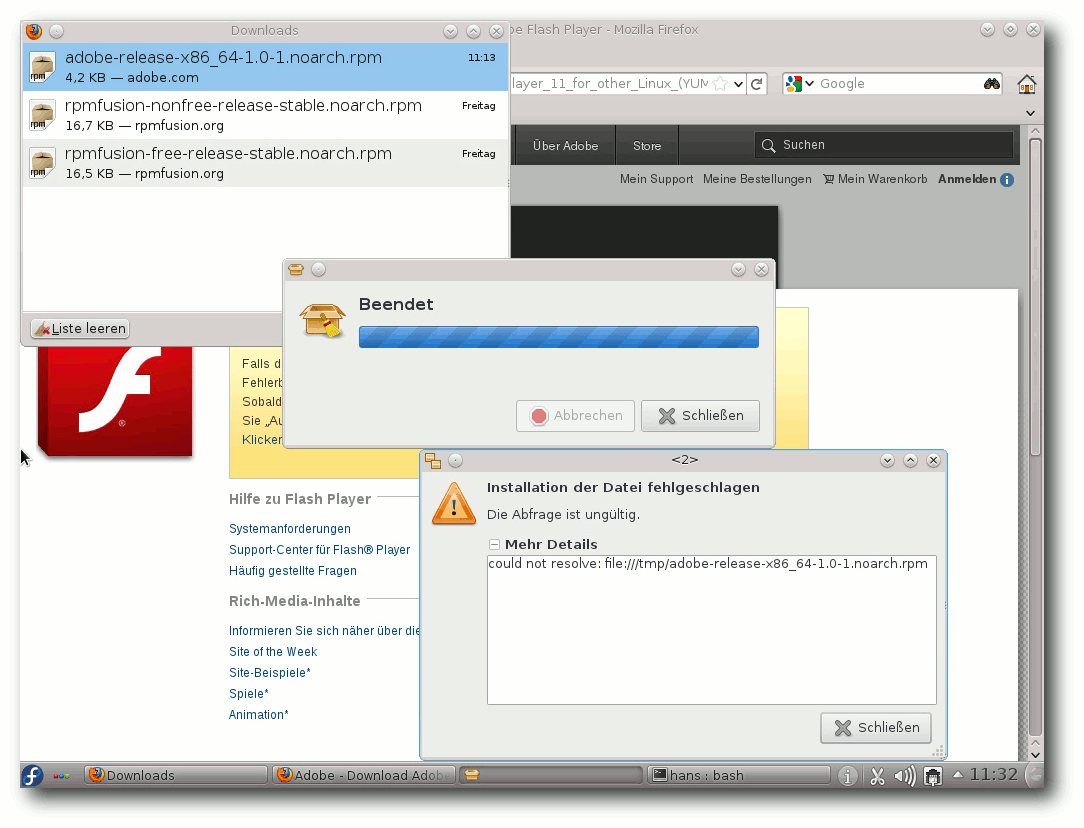

Die Flash-Situation in den Browsern bleibt mittelmäßig. Ohne den

Adobe Flash Player geht nicht allzu viel. Gnash erfuhr in den letzten

sechs Monaten kaum eine Weiterentwicklung und kann nur eine

begrenzte Zahl von Flash-Videos im Web abspielen. Die freie

Alternative Lightspark ist nun gar nicht mehr in den Repositorys

enthalten.

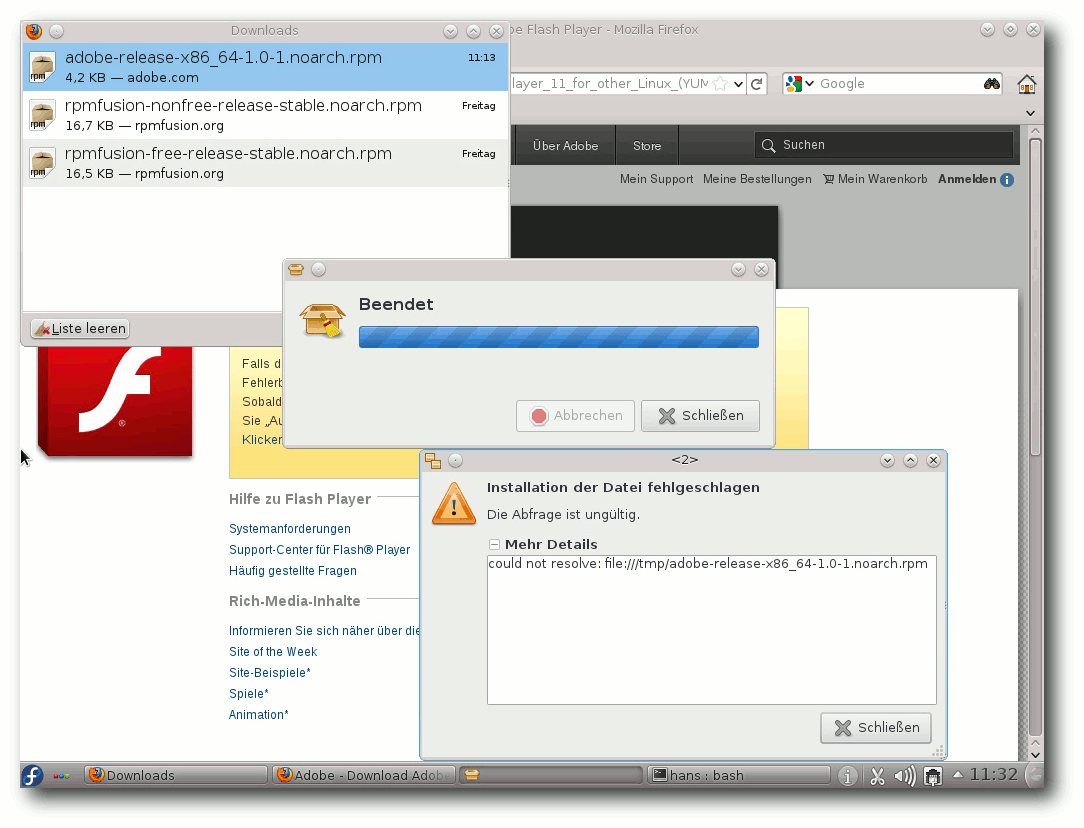

Die Installation des Adobe Flash Players ist ein zweistufiger

Prozess, wenn man das Yum-Repo einbindet. Zunächst lädt man von

Adobe eine RPM-Datei herunter, die das Repository anlegt. Dann

kann man über die Paketverwaltung das eigentliche Plug-in

installieren. Das Anlegen des Repositorys benötigt die Eingabe des

Root-Passworts. Macht man hierbei einen Fehler, kann man sich in

allerlei Schwierigkeiten bringen, da es keine Wiederholung der

Eingabe gibt. Stattdessen verheddert sich das Programm, besonders

wenn man es noch ein zweites Mal versucht, und man kann schließlich

gezwungen sein, Fenster, die sich nicht mehr schließen lassen,

manuell zu killen.

Hat man dagegen das Passwort korrekt eingegeben, kann man

anschließend das Flash-Plug-in über die Paketverwaltung installieren.

Dies gilt jedenfalls für GNOME. Unter KDE dagegen stellte

sich Apper

als unfähig heraus, die RPM-Datei zu verarbeiten.

Die Alternative zu Flash, das WebM-Format, sollte in Firefox seit

Version 4 kaum Probleme bereiten, und im Großen und Ganzen scheint

es zu funktionieren. In Konqueror allerdings funktionierten die

meisten Videos überhaupt nicht, da das Plug-in regelmäßig abstürzte.

Zum Testen von WebM kam es erst gar nicht.

Die Installation eines RPMs direkt aus dem Browser scheitert.

Paketverwaltung und Updates

Wenig hat sich bei der Paketverwaltung getan, insbesondere unter

GNOME. Sie funktioniert normalerweise reibungslos und die Updates,

wenn sie auch zahlreich sind, sind dank Delta-RPMs oft erstaunlich

klein und schnell installiert.

In Fedora 16 wurde die seit einiger Zeit gute Erfahrung durch

mehrere unerwartete Probleme getrübt. Nach einer Woche Betrieb kam

es bei Operationen der Paketverwaltung, insbesondere beim Suchen

nach Updates, zu einem Fehler, der erst durch die Ausführung von yum

update klarer erkenntlich war:

# yum update

database disk image is malformed

Der Fehler ist im Web nicht ganz unbekannt, scheint aber selten

aufzutreten. In diesem Fall half ein yum clean all.

Erstmals seit langer Zeit kam es zu einem weiteren Fehler in der

Paketverwaltung, der es unmöglich machte, bestimmte Updates zu

installieren.

Downloading Packages:

Running Transaction Check

ERROR with transaction check vs depsolve:

perl = 4:5.12.4-162.fc15 is needed by (installed) perl-Module-CoreList-0:2.50-162.fc15.noarch

Please report this error in http://yum.baseurl.org/report

** Found 1 pre-existing rpmdb problem(s), 'yum check' output follows:

perl-Module-CoreList-2.50-162.fc15.noarch has missing requires of perl = ('4', '5.12.4', '162.fc15')

In diesem Fall ist eine fehlerhafte Paketabhängigkeit zu vermuten.

Das Paket perl-Module-CoreList hätte wohl für Fedora 16 neu

generiert werden müssen, um von Perl 5.14 statt 5.12 abzuhängen.

Solche Fehler können in der Entwicklungsversion von Distributionen

auftreten; für freigegebene Versionen sind sie aber

nicht

akzeptabel. Eine Lösung des Problems steht noch aus.

KPackageKit unter KDE, das in der letzten Version endlich gut

funktionierte, wurde durch ein Programm namens Apper ersetzt. Nach

dem ersten Schreck stellt man aber fest, dass Apper KPackageKit

verdächtig ähnlich sieht, und in der Tat handelt es sich um

KPackageKit, das Programm wurde lediglich in Apper

umbenannt [8].

Auch weiterhin hat die Paketverwaltung ein Problem mit dem Verhalten

von Dialogboxen unter

KDE. Das Problem ist aber vielleicht eher KDE

selbst anzulasten. Möglicherweise aufgrund der Tatsache, dass

mehrere verschiedene Prozesse an der Paketverwaltung beteiligt sind,

kann es vorkommen, dass die Dialogbox, die zur Bestätigung die

Eingabe des Root-Passworts verlangt, hinter anderen Fenstern zu

liegen kommt, und wenn man nicht auf die Taskleiste achtet, kann man

sich darüber wundern, dass die Paketverwaltung keinerlei Fortschritt

mehr macht.

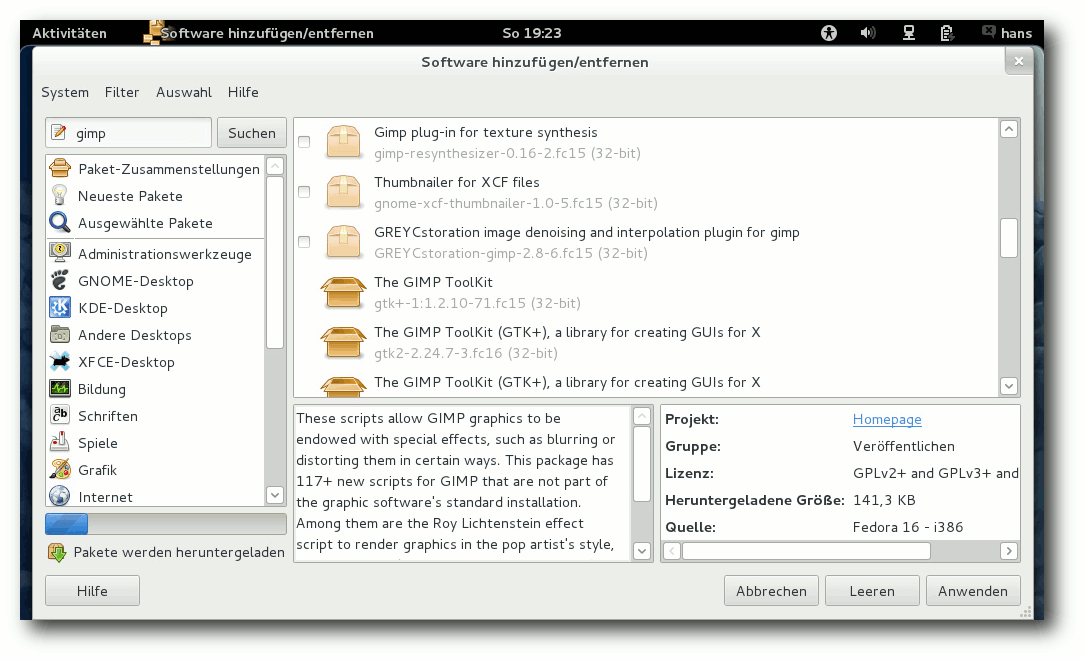

Softwareverwaltung unter GNOME 3.2.

Fazit

Fedora 16 ist eine solide Distribution mit zahlreichen Features und

stetigen Neuerungen. Es ist also eigentlich wie immer, mit nur

wenigen Ausnahmen. Zu bemängeln ist dieses Mal unbedingt der Patzer

in der Paketverwaltung, der Aktualisierungen verhindert und einfach

nicht vorkommen

darf, zumal Paketabhängigkeiten von geeigneten

Testprogrammen geprüft werden können. Generell könnten die

grafischen Werkzeuge zur Paketverwaltung mehr Robustheit vertragen.

Dieser Fehler reiht sich in die Probleme ein, die Fedora in der

ersten Zeit nach der Veröffentlichung immer mit sich bringt. Wer

sich nicht mit der Lösung dieser Probleme aufhalten kann, sollte mit

dem Update auf Fedora 16 einige Zeit warten.

Viele Benutzer schätzen Fedora trotzdem als Distribution, die

Neuerungen schnellstmöglich zu den Anwendern bringt, und nehmen die

häufigen Updates in Kauf, die dank Delta-RPMs ohnehin meist sehr

schnell gehen. Aber die große Zahl von Updates – für eine typische

Installation von Fedora 16 dürften es schon jetzt mehr als 200 sein

– gehört bei Fedora prinzipiell zum Konzept. Und in der Tat wird

Fedora durch die reichlichen Fehlerkorrekturen in der zweiten Hälfte

seines Support-Zeitraums zu einer sehr stabilen Distribution.

Die vielen fortgeschrittenen Funktionen, beispielsweise bei der

Virtualisierung, machen Fedora für fortgeschrittene Anwender

interessant, auch hier wieder besonders für diejenigen, die auf die

aktuellsten Versionen großen Wert legen. Auch Entwickler werden

Fedora durch die verschiedenen neuen oder aktualisierten

Entwicklungsumgebungen sehr attraktiv finden.

Links

[1] http://www.pro-linux.de/artikel/2/1538/11fedora-16.html

[2] http://www.freiesmagazin.de/freiesMagazin-2011-07

[3] http://www.pro-linux.de/news/1/17603/dennis-ritchie-verstorben.html

[4] http://ask.fedoraproject.org/questions/

[5] http://docs.fedoraproject.org/en-US/Fedora/16/html/Installation_Guide/

[6] https://live.gnome.org/GnomeShell/Extensions

[7] http://rpmfusion.org/

[8] http://dantti.wordpress.com/2011/08/01/apper-kpackagekit-reworked-part-i/

| Autoreninformation |

| Hans-Joachim Baader (Webseite)

befasst sich seit 1993 mit Linux. 1994 schloss er sein

Informatikstudium erfolgreich ab, machte die Softwareentwicklung

zum Beruf und ist einer der Betreiber von Pro-Linux.de.

|

Diesen Artikel kommentieren

Zum Index

von Mathias Menzer

Moderne Linux-Distributionen bringen alles mit: Vom Systemkern über

die Anwendungen bis hin zu den bunten Rüschen der graphischen

Oberfläche. Für viele Nutzer gehört das Anpassen des Desktops zur

Pflicht, das manuelle Installieren von Programmen – meist in einer

aktuelleren Version – ist dann die Kür. Den Kernel jedoch lassen viele

in Ruhe und vertrauen hier lieber auf die Aktualisierungen des

Distributors.

Dabei ist das Erstellen eines Kernels kein großes

Voodoo. In den Grundzügen läuft es wie bei allen anderen Anwendungen

auch in drei Schritten:

- Konfigurieren

- Kompilieren

- Installieren

Ein paar Dinge vorweg

An dieser Stelle ist bei Texten zur Kernel-Kompilierung meist ein

Warnhinweis zu finden, der allzu Mutige vor dem Nachmachen warnt. Doch

dieser Beitrag richtet sich explizit an jene Anwender, die bislang

keine Berührung mit gcc und make hatten. Linux-Nutzer, die gerne den

Weg in die tieferen Ebenen ihres Systems finden möchten, sollen hier

zum Ausprobieren ermutigt werden. In der Regel richten auch vermurkste

Kernel-Eigenkompilate keine dauerhaften Schäden an, sodass ein

Neustart mit einer anderen, funktionierenden Version einen zum

laufenden System zurückführt.

Dem mündigen Leser seien jedoch drei Hinweise mitgeben:

- Kernel-Versionen, die ein „-rc“ in der Versionsbezeichnung tragen,

sind Entwickler-Kernel und ausschließlich zum Testen und Fehlersuchen

gedacht.

- Ein Eigenkompilat muss nicht immer besser laufen als der Kernel

von der Stange, die Distributoren wissen in der Regel, was sie tun!

- Bei der ganzen Kompiliererei werden externe Treiber nicht

berücksichtigt. Das betrifft proprietäre Treiber wie z. B. für

VirtualBox, fglrx (AMD/ATI-Grafik) oder nvidia (Nvidia-Grafik).

Diese müssen nach dem Kernel-Bau ggf. nach den jeweiligen Vorgaben

neu erstellt und konfiguriert werden.

Als Beispiel findet die zur Fertigstellung des Beitrags aktuelle

Kernel-Version 3.1.5 Verwendung, bei anderen Kernel-Versionen ändern

sich dann Bezeichnungen, URLs und Befehle eben entsprechend der

jeweiligen Versionsnummer. Um mit dieser Anleitung den Einstieg in die

Kernel-Kompilierung zu finden, wird erst einmal eine virtuelle Umgebung

empfohlen; Ubuntu in einer VirtualBox käme dem in diesem Artikel

verwendeten Aufbau am nächsten. Des Weiteren wird hier ausschließlich

auf der Text-Konsole gearbeitet, was allerdings eher darauf

zurückzuführen ist, dass sich Konsolenbefehle leichter zu Papier

bringen lassen als Mausklicks in grafischen Programmen.

Beim Bau eines Kernels sollte darauf geachtet werden, dass genug Platz

auf dem Datenträger vorhanden ist. Das Kompilieren bläst das genutzte

Verzeichnis gerne mal von einem ursprünglich 60 MB großen Archiv über

450 MB für das entpackte Archiv bis auf mehrere Gigabyte nach dem

ganzen Vorgang auf. Dazu muss noch der Platz gerechnet werden, den der

später installierte Kernel (ca. 120 MB) und die fertigen Module (ca. 2

GB in der Standardkonfiguration von Linux 3.1) belegen. Eine Kontrolle

im Vorfeld, zum Beispiel mittels df -h, wie viel Platz auf /boot

(mindestens 120 MB), /lib (mindestens 2 GB) und /home (mindestens 8 GB) frei sind, ist

im Zweifel also angeraten.

Vorbereiten

Zuerst müssen natürlich einige Vorbereitungen getroffen werden. Es wird ein

Verzeichnis zum Arbeiten benötigt und natürlich der Quellcode des

Kernels. In diesem Beispiel wird ein Verzeichnis direkt im Home-Verzeichnis des

Anwenders verwendet:

$ cd ~

$ mkdir Kernel

$ cd Kernel

Die Kernel-Quellen können bequem als vollständiges Archiv von

kernel.org [1] geladen werden. Am kleinsten sind die

mit xz [2] komprimierten Dateien, sie

erfordern jedoch die XZ-Utils, die eventuell nachinstalliert werden

müssen.

$ wget http://www.kernel.org/pub/linux/kernel/v3.x/linux-3.1.5.tar.xz

$ tar xf linux-3.1.5.tar.xz

tar entpackt das Archiv in das Unterverzeichnis linux-3.1.5, in dem

die weitere Arbeit erfolgen wird.

Konfigurieren

Die Quellen liegen nun vor, also kann die Konfiguration des Kernels

erfolgen. Am einfachsten ist es, die bereits für den aktuell laufenden

Kernel vorhandene Konfiguration als Ausgangspunkt zu nutzen. Diese

befindet sich im Verzeichnis /boot und wird zu den Kernelquellen

kopiert. Das Kompilierwerkzeug make erwartet die Konfiguration in der

Datei .config.

$ cd linux-3.1.5

$ cp /boot/config-`uname -r` .config

Meist stammt diese Konfiguration von einem älteren Kernel als dem, den

zu bauen man im Begriff ist. In diesem Fall fehlen der Konfiguration

eventuell Optionen zu neueren Funktionen. Um dies zu vermeiden,

erstellt man eine vollständige Konfigurationsdatei. Der folgende

Befehl liest die vorhandenen Einstellungen und fragt die Optionen für

neue, nicht definierte Funktionen ab. Ist man sich unsicher, was man

auswählen sollte, kann man auf die Vorgaben vertrauen. Diese sind

immer die Standard-Option und können per „Enter“ ausgewählt werden.

$ make oldconfig

Ist man des minutenlangen Betätigens der „Enter“-Taste überdrüssig, so

kann man auch den Befehl

yes [3] zu Hilfe nehmen. Dieser

simuliert das Drücken der „Enter“-Taste, bis make oldconfig durch alle

Optionen gelaufen ist:

$ yes "" | make oldconfig

In diesem Fall möchte man die Konfiguration vielleicht anschließend

kontrollieren und gegebenenfalls anpassen. Zumindest ist es

interessant, mal einen Blick auf die verschiedenen Optionen und

Funktionen zu werfen:

$ make menuconfig

Für die Darstellung des Menüs wird die Bibliothek ncurses-devel

benötigt.

Nun ist die Konfiguration vollständig und der eigentliche Kernelbau

kann beginnen.

Kompilieren

Das Kompilieren läuft im Grunde automatisch ab. make übernimmt den

Löwenanteil der Arbeit, indem es aus der oben erstellten Konfiguration

und über Makefiles, die jede Komponente des Kernels mitbringt, die zu

bauenden Teile des Kernels bestimmt und Abhängigkeiten auflöst.

Prinzipiell kann man sich make als Küchenmaschine vorstellen, in die

man den kompletten Vorratsraum hineinkippt und die dann aufgrund

eines dazugeworfenen Rezepts nicht benötigte

Zutaten aussortiert, den

Rest entsprechend in der richtigen Reihenfolge verarbeitet und zum

Schluss den Kuchen backt. Ganz perfekt ist die Analogie jedoch nicht,

solange Hühner ihren Eiern kein Makefile beilegen.

Voraussetzung ist natürlich, dass die für das Bauen des Kernels

notwendigen Programme vorhanden sind, also

Linker [4],

Compiler [5] usw. In der GNU

Compiler

Collection [6] (gcc)

ist alles dabei.

Der folgende Befehl baut den oben konfigurierten Kernel und die

zugehörigen Module zusammen:

$ make -j8 bzImage modules

Mit make kann man seinem System richtig

einheizen – im wahrsten Sinne. Die Option -j gibt an, wie viele Jobs

gleichzeitig laufen sollen, denn make ist ein unbarmherziger

Antreiber. Ohne Widerrede schickt es auf Anforderung 64 Compiler- und

Linker-Prozesse oder noch mehr gleichzeitig an den Start, was jedoch

nur bei entsprechend gut dimensionierten Mehrprozessor-Systemen

wirklich sinnvoll ist. Ein durchschnittliches Zwei-Prozessor-System ist

mit vier bis acht Jobs gut bedient. Die Faustregel lautet hier

generell, dass doppelt so viele Jobs antreten sollen, wie Prozessoren

oder Kerne im System vorhanden sind, so z. B. acht Jobs für vier Kerne.

In keinem Fall sollte -j ohne darauf folgende Zahl auftreten; make

versteht dies als Anweisung, keine Grenzen für die Zahl möglicher

Prozesse zu setzen und startet für jedes Unterverzeichnis im

Kernel-Baum nun einen eigenen Job. Dies führt fast immer zu einer

vollständigen Auslastung des Systems, das dann auch nicht mehr auf

Benutzereingaben reagiert.

Der Gang zur Kaffeemaschine ist als nächstes eine gute Wahl. Ein Build-Vorgang kann gerne mal

eine gute Stunde (oder auch zwei) in Anspruch nehmen, je nach

Leistungsfähigkeit der Hardware. Da das Bauen des Kernels auch eine

sehr aufwendige Angelegenheit ist, sollte man vom Abspielen von

HD-Videos auf dem gleichen System absehen, selbst wenn es seit Linux

2.6.38 dank der dort eingeführten Prozess-Gruppen (siehe „der November

im Kernelrückblick“, freiesMagazin

12/2010 [7])

prinzipiell möglich, wenn auch nicht schön ist.

Installieren

Das Installieren des Kernels und der Module muss als Superuser (ggfs.

mittels sudo) erfolgen. Hierbei werden das Kernel-Abbild

(vmlinuz), eine Sicherung der verwendeten Konfiguration (config),

eine Datei mit Debug-Informationen (System.map) und das Startabbild

(initrd.img), das den Kernel und ein kleines Dateisystem für den

Start des Systems beinhaltet, in das Verzeichnis /boot kopiert und

im Bootloader registriert. Die Module wandern in dem Fall nach

/lib/modules/3.1.5; bei anderen Kernel-Versionen eben in ein

entsprechend benanntes Verzeichnis.

# make modules_install install

Damit wäre der eigene Kernel gebaut und installiert und

wartet nur noch auf einen Test.

Kurzer Einwurf

Der Bootloader Grub2 blendet je nach Konfiguration das Bootmenu beim

Start aus, was die Auswahl eines alternativen Kernels erheblich

erschweren kann. Um dem vorzubeugen, sollte man in der Datei

/etc/default/grub kontrollieren, ob die Option GRUB_HIDDEN_TIMEOUT

gesetzt ist und sie gegebenenfalls auskommentieren. Musste die Datei

bearbeitet werden, ist es notwendig, dass Grub seine Konfiguration neu

schreibt, erst dann sollte ein Neustart mit dem neuen Kernel erfolgen.

# update-grub

Feuerprobe

Ob alles gut gegangen ist, wird nach einem Neustart mit dem eigenen

Kernel offensichtlich. Im besten Fall bootet das System – das kann beim

ersten Mal etwas länger dauern als gewohnt – und präsentiert einem die

Anmeldemaske. Nach der Anmeldung kann man erst einmal prüfen, ob der

neue Kernel auch tatsächlich geladen wurde:

$ uname -a

Es sollte nun eine Ausgabe erfolgen, die irgendwo die

Versionsnummer 3.1.5 aufführt. Erscheint wider Erwarten die alte

Version, so wurde der neue Kernel nicht in Grub registriert;

update-grub, schafft hier Abhilfe.

Probleme können auftreten, wenn Kernel-Module zum Einsatz kommen, die

nicht aus den Kernel-Quellen stammen – ein Beispiel ist

hier VirtualBox, es kann aber auch proprietäre Grafiktreiber

betreffen. Diese externen Module werden natürlich nicht mitkompiliert,

selbst wenn sie aus der Paketverwaltung des Linux-Systems stammen. Im

Falle von VirtualBox muss hier gegebenenfalls unter dem neuen Kernel

das zugehörige Modul erneut gebaut werden:

# /etc/init.d/vboxdrv setup

Dieses Problem ist nicht neu, deshalb bieten aktuelle Distributionen

bereits Abhilfe: DKMS (Dynamic Kernel Module

Support [8])

ist in der Lage, ihm bekannte Module neu zu kompilieren, sobald ein

neuer Kernel installiert wird. VirtualBox nutzt dies bereits seit

längerem, weshalb die Installation von dkms zu empfehlen ist.

Wie werde ich ihn wieder los?

Nicht immer ist alles Gold was glänzt, und nicht alles, was bootet, taugt

auch für den täglichen Gebrauch. Treten Probleme auf, ist es

vielleicht notwendig, den Kernel wieder loszuwerden. Auch das ist vom

Prinzip her einfach; man löscht die erzeugten Kernel-Dateien und wirft

den entsprechenden Eintrag aus dem Bootloader. Dazu startet man am

besten mit einem anderen Kernel, indem man diesen beim Systemstart im

Menü des Bootloaders auswählt. Ist das System gestartet, kontrolliert man mit uname, ob man auch den richtigen

Kernel geladen hat.

Zu Löschen sind im Verzeichnis /boot alle Dateien mit der

entsprechenden Versionsnummer, zum Beispiel:

- config-3.1.5

- initrd.img-3.1.5

- System.map-3.1.5

- vmlinuz-3.1.5

Außerdem sollte das Verzeichnis mit den Modulen entfernt werden

(hier wieder /lib/modules/3.1.5):

# rm /boot/*-3.1.5

# rm -rf /lib/modules/3.1.5/

Einige Distributionen, darunter SUSE, fügen der Versionsnummer auch

beim Selbstkompilieren noch ein Anhängsel an, entsprechend müssen die

beiden rm-Befehle korrigiert werden.

Grub muss auch diesmal wieder seine Konfiguration aktualisieren:

# update-grub

Damit ist man den selbstgebackenen Kernel wieder los, sowohl im

Bootloader als auch auf der Festplatte.

Die Kernel-Quellen braucht man im Übrigen nicht unbedingt aufzuräumen,

solange man genug Platz auf der Festplatte hat.

Fazit

Einen Kernel selbst zu erstellen ist grundsätzlich kein Hexenwerk. Hat

man noch keine Erfahrung damit gemacht, so kann man die ersten

Versuche an einem Zweit-Gerät oder dem gerade ausgemusterten PC

durchführen, im schlimmsten Falle greift man auf eine virtuelle

Maschine zurück. Auf diesem Weg kann ohne Gefahr für Leib und Daten

nach Belieben herumprobiert und getestet werden und damit ist auch für

bislang eher zurückhaltende Linux-Nutzer der eigene Heimwerker-Kernel

machbar.

| Paketübersicht nach Distributionen |

| Debian/Ubuntu | SuSE | Fedora |

| wget (Standardinstallation) | wget (Standardinstallation) | wget |

| make | make | make |

| g++ | gcc | gcc |

| libncurses5-dev | ncurses-devel | ncurses-devel |

| dkms (Standardinstallation) | / | dkms |

Links

[1] https://kernel.org/

[2] http://de.wikipedia.org/wiki/Xz

[3] http://linux.die.net/man/1/yes

[4] http://de.wikipedia.org/wiki/Linker_%28Computerprogramm%29

[5] http://de.wikipedia.org/wiki/Compiler

[6] http://de.wikipedia.org/wiki/GNU_Compiler_Collection

[7] http://www.freiesmagazin.de/freiesMagazin-2010-12

[8] http://de.wikipedia.org/wiki/Dynamic_Kernel_Module_Support

| Autoreninformation |

| Mathias Menzer (Webseite)

malträtiert sein Notebook gerne mit dem aktuellsten

Linux-Kernel. Dieser findet seinen Weg in der Regel als Eigenkompilat

nach obigem Rezept in das System.

|

Diesen Artikel kommentieren

Zum Index

von Patrick Meyhöfer

Egal, ob im Open-Source-Umfeld oder im Business-Bereich: Überall dominiert in

irgendeiner Form das Thema „Cloud Computing“ die Medien. Deren unschätzbare

Vorteile, durch geschickte Marketingaktivitäten oft besonders hervorgehoben,

sollte man natürlich auch einer kritischen Analyse für den jeweiligen

Einsatzzweck unterziehen.

Im privaten Umfeld nutzt sicher der eine oder andere diverse Cloud-Lösungen,

die direkt an den einfachen Privatanwender gerichtet sind. Man denke an Google

Mail, Dropbox, Evernote usw. Diese Lösungen fasst man alle unter der Rubrik

Software-as-a-Service (kurz: SaaS [1])

zusammen.

Dieser Beitrag richtet sich jedoch an eine eher technisch orientierte

Sichtweise des Cloud-Computing, nämlich der so genannten

Platform-as-a-Service (PaaS), mit der der normale Anwender

eher selten in Berührung kommt, die aber für Entwickler durchaus von

Interesse sein kann.

Ein interessantes Angebot liefert hierfür der Softwarehersteller Red Hat mit

seinem Angebot OpenShift [2].

Kurzer Exkurs: PaaS

Um den Nutzen von OpenShift im Folgenden besser nachvollziehen zu können,

folgt hier ein kurzer Exkurs, was unter PaaS [3]

zu verstehen ist und wie

man dessen Vorteile für seine eigenen Softwareprojekte nutzen kann.

Bereits jetzt sind fast alle wesentlichen Komponenten von Open-Source-Technologien als Fundament der Cloud-Technologien zu sehen. Sie beruhen auf dem

Linux-Kernel, Virtualisierungstechnologien wie Xen oder KVM und Datenbanklösungen

wie PostgreSQL oder MySQL (siehe hierzu OpenStack [4]).

Wollte man bisher auf herkömmliche Weise, z. B. eine Webanwendung,

bereitstellen, musste man sich i. d. R. im Vorfeld bereits gründlich Gedanken

machen, auf welcher Basis man diese Software entwickeln und anschließend zur

Verfügung stellen wollte. Es war also notwendig, bereits vor dem Bereitstellen

seiner Webanwendung eine eigene Plattform einzurichten, über die man diese den

Benutzern zugänglich machen kann. Das heißt, es wurden meist Webserver

benötigt, Programmierumgebungen wie PHP, JEE u. v. m. mussten installiert und

konfiguriert werden und wenn eine Anwendung sehr schnell populär wurde,

reichten die Ressourcen nicht aus, wodurch wieder Anpassungen in der

Skalierung/Optimierung etc. notwendig waren.

Mit der Idee von PaaS soll diese Arbeit nun durch die Cloud wahrgenommen werden.

Der Entwickler soll sich einzig um das Entwickeln seiner Anwendung kümmern,

der gesamte Administrationsaufwand, die Arbeiten vorab zur Installation,

Wartung sowie Backuparbeiten werden durch den Anbieter übernommen, wodurch

mehr Zeit für die eigentliche Entwicklung der Software bleibt.

PaaS am Beispiel von OpenShift

Die Vorteile des Konzepts sollen im Folgenden am Beispiel von OpenShift

vorgestellt werden. Der Grund ist, dass Red Hat für kleine

Entwicklungsprojekte eine Variante mit dem Namen

„OpenShift Express“ [5] komplett kostenlos anbietet.

In der Praxis reserviert hier Red Hat bei Amazon Web Services EC2 eine

Instanz, auf der dann die Anwendung später läuft.

Hat man im weiteren Verlauf zusätzliche Wünsche, kann man auch auf ein

kostenpflichtiges Modul namens „Flex“ upgraden. Dies bietet u. a. Clustererstellung,

Benutzeroberfläche statt Kommandozeile und vieles mehr. Näheres hierzu findet man im „OpenShift UserGuide“ [6].

Für den Anfang reicht aber die kostenlose Lösung zum Einstieg in das Thema

vollkommen aus.

Zur Programmierung stehen folgende Sprachen zur Verfügung:

- Java 6 EE

- PHP

- Perl

- Python

- Ruby

Verfügbare Datenbanken im Backendbereich sind entweder MySQL oder SQLite. Mit

500 MB Festplattenkapazität und 300 MB RAM sollten für kleine Applikationen

zunächst genug Ressourcen zur Verfügung stehen [7].

Installation der Client-Tools

Um mit der Entwicklung zu beginnen, ist es vorab notwendig, die Client-Tools

(diese werden aktiv auf github gehostet [8])

zu installieren, wie in der

Dokumentation nach der Registrierung beschrieben.

Für die Installation (die unter den gängigen Linux-Distributionen, Mac OS X,

und Windows mit Cygwin möglich ist) werden die Pakete ruby in Version 1.8,

rubygems- und ruby-dev-Pakete benötigt, die unter Ubuntu 11.10 alle unter

diesem Namen problemlos über den Paketmanager installiert werden können.

Eine detaillierte Installationsanleitung für die einzelnen Systeme liefert die

Webseite von OpenShift [9].

Die Client-Tools belaufen sich beim Download auf maximal 2 MB und basieren

vollständig auf Ruby [10]. Die Entwicklung

erfolgt aktiv auf Github [11] unter

einer Red-Hat-Lizenz [12].

Von nun an sind alle folgenden Befehle nur möglich, wenn die Client-Tools im

vorigen Schritt erfolgreich installiert worden sind. Anschließend muss man

sich überlegen, welchen Namen die Anwendung bekommen soll und mit welcher

Programmiersprache man sie umsetzen möchte. Hierfür legt man sich zunächst

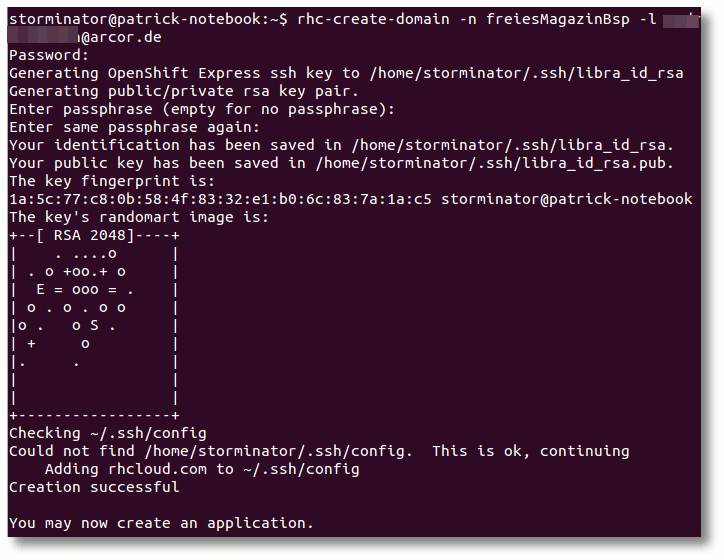

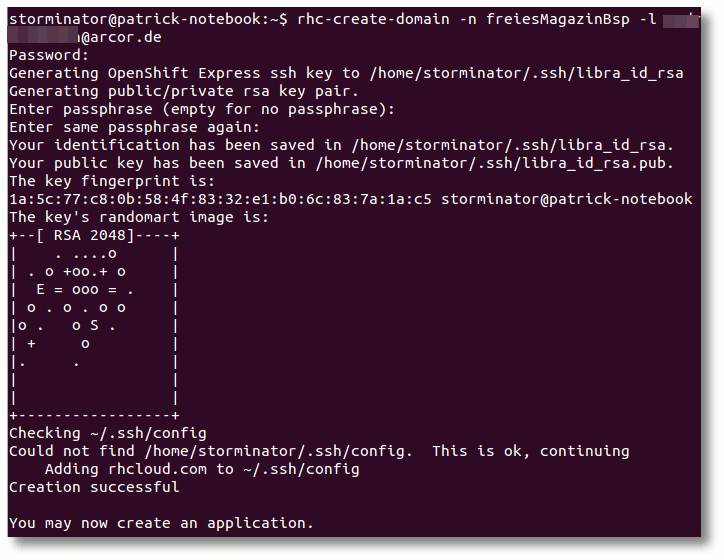

eine Domain an, welches man mit folgendem Befehl in der Konsole erreicht:

$ rhc-create-domain -n Domänenname -l Loginname

Reservierung einer eigenen Domain für die Anwendung.

Nun kann man endlich seine erste eigene Anwendung erstellen, wobei man

angeben muss in welcher Programmiersprache und in welcher Version derselben

man seine Anwendung entwickelt, da man natürlich nicht

möchte, dass man seine Anwendung für PHP 5.3 entwickelt, der Server aber nur

PHP 5.2 als Laufzeitumgebung bietet.

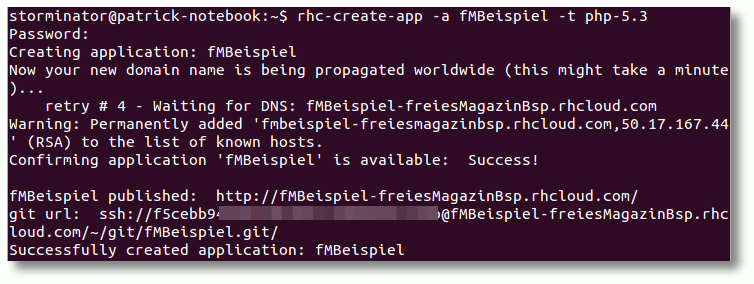

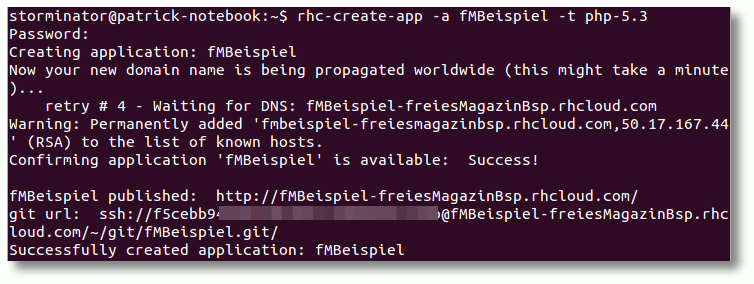

Folgender Konsolenbefehl ist nötig:

$ rhc-create-app -a fMBeispiel -t php-5.3

Anwendung erstellen, Programmiersprache definieren.

Nach Eingabe des vorab festgelegten Passwortes wird nun im Hintergrund ein

Git-Repository, also eine verteilte Versionsverwaltung [13]

eingerichtet, welche eine vorgegebene

Ordnerstruktur besitzt.

Es kann unter Umständen ein paar Minuten dauern, bis alles im Hintergrund

eingerichtet wurde, zum Abschluss erhält man im Erfolgsfall jedoch die

Meldung, dass die Anwendung erfolgreich erstellt wurde und man bekommt eine

Git-URL zu seinem weltweit erreichbaren Repository.

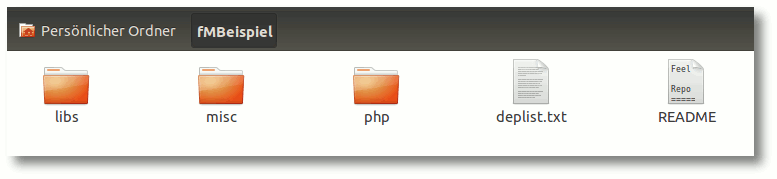

Im aktuellen Verzeichnis, in dem man den Befehl ausgeführt hat, findet man nun

auch seine Anwendung wieder.

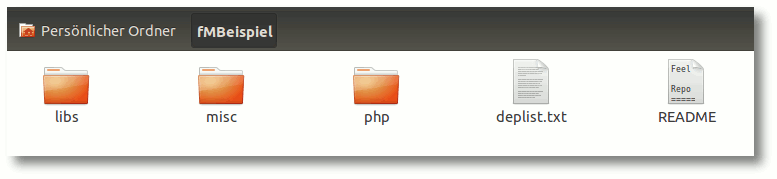

Projektordner.

Im Ordner php (je nach Programmiersprache auch ein anderer Ordner, z. B. python

etc.), werden die eigentlichen Quelldateien angelegt, im Ordner libs

zusätzliche Bibliotheken, die man verwenden möchte.

Was in einzelne Ordner

gehört und welche zusätzlichen Verzeichnisse z. B. für persistente Daten

(Umgebungsvariablen u. ä.) angelegt werden können, listet die beiliegende

README-Datei sehr übersichtlich auf.

Anwendung per Git hochladen

Nachdem man seine Quellcodes erstellt hat, ist man nun in der Lage, die Anwendung

über Git in das Git-Repository zu heben.

Dazu wechselt man zunächst in den Ordner der Anwendung:

$ cd Anwendungsname

Über den Befehl

$ git commit -a -m "Meine erste Aenderung"

landen die Dateien im lokalen Git-Repository und mittels

$ git push

werden die Dateien auf das entfernte Repository in der Cloud übertragen.

Von jetzt an ist jeder in der Lage, die Anwendung von überall aufrufen zu

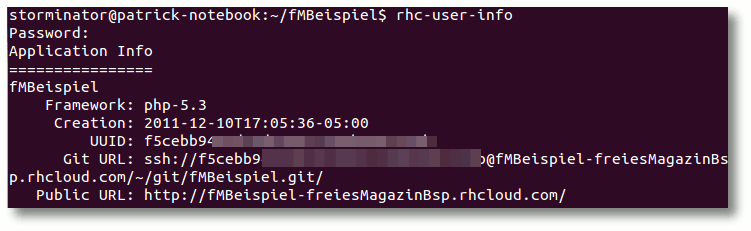

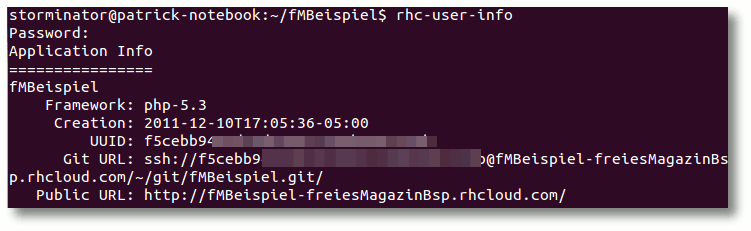

können. Wenn man die URL zur Anwendung oder zu Git nicht mehr weiß, hilft der

Befehl

$ rhc-user-info

Informationen zur Anwendung.

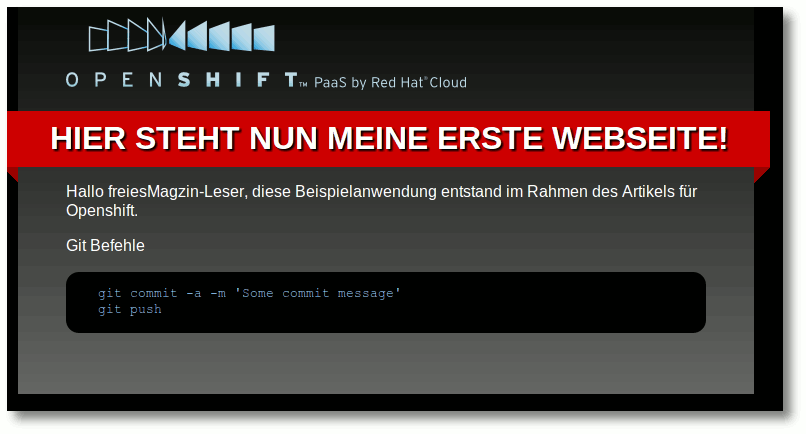

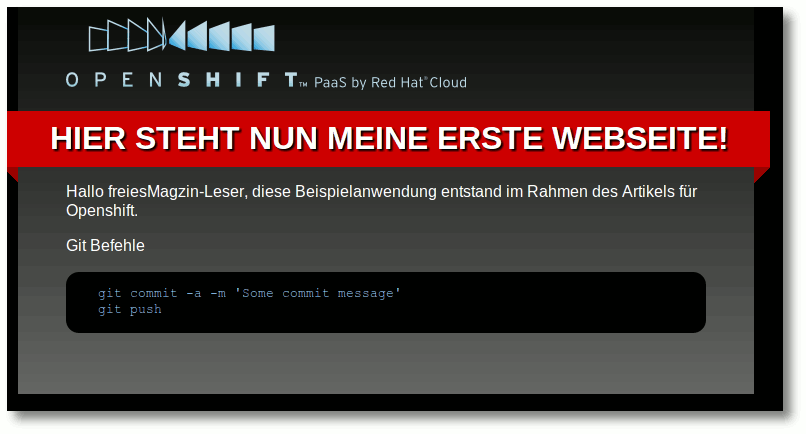

Ruft man nun die URL im Browser auf, bekommt man seine Webseite mit den

durchgeführten Änderungen zu sehen (Beispiel für diesen Artikel [14]).

Erstellte Webseite in der Cloud-Beispiel.

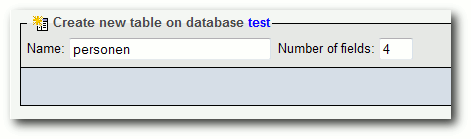

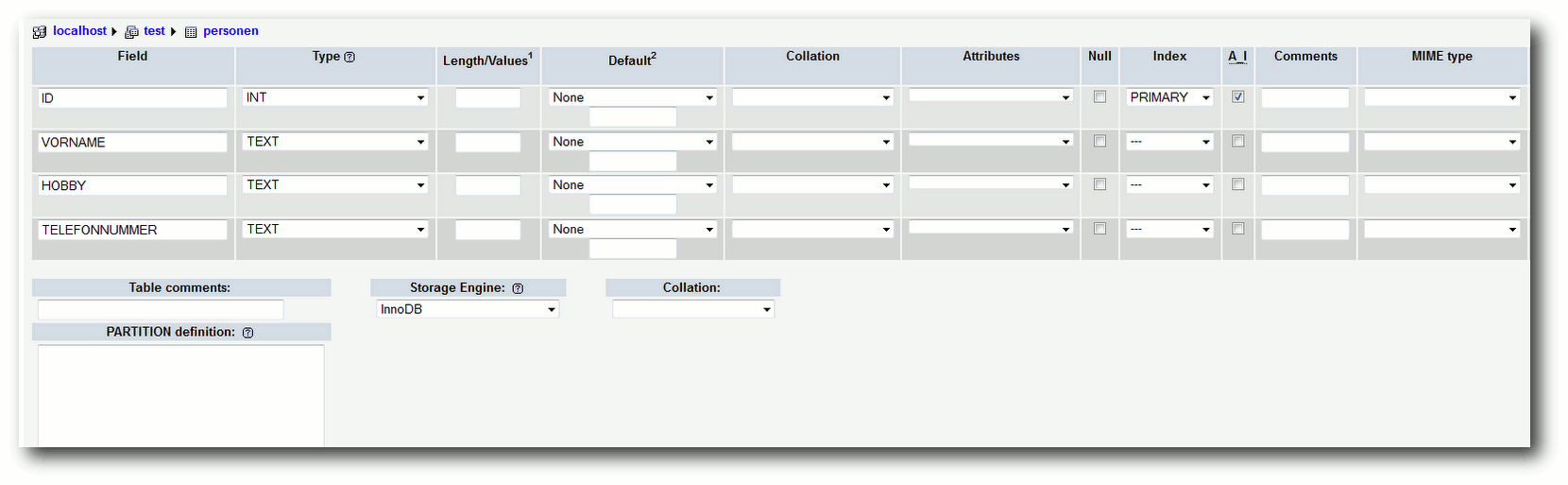

Erstellung einer zugehörigen Datenbank

Für fast jede größere Applikation, die man entwickelt oder die man einfach in

der Cloud laufen lassen möchte, wird früher oder später eine Datenbank

benötigt. So verlangen beliebte Open-Source-Projekte, wie Joomla,

Wordpress, Drupal u. v. m., in der Regel eine MySQL-Datenbank, die

performante Speicher- und Lesezugriffe erlaubt.

In einer frühen Version von OpenShift war es lediglich möglich, eine

SQLite-Datenbank der Anwendung hinzuzufügen, was aber außer für Beispiele wie

Mediawiki zu wenig praktikabel in der Anwendung war, weshalb Red Hat hier

schnell eingelenkt hat und auch MySQL in die kostenlose Lösung der

Express-Version integriert hat.

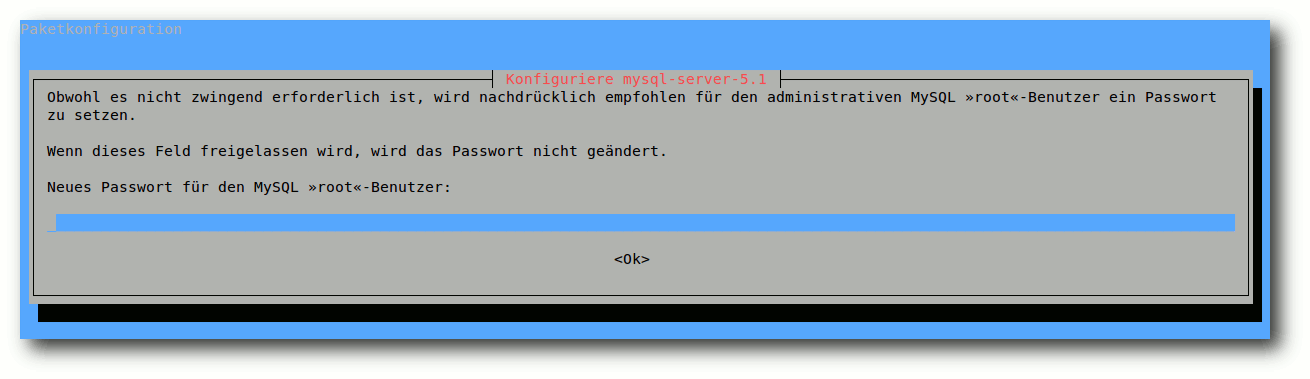

Mittels des Befehls

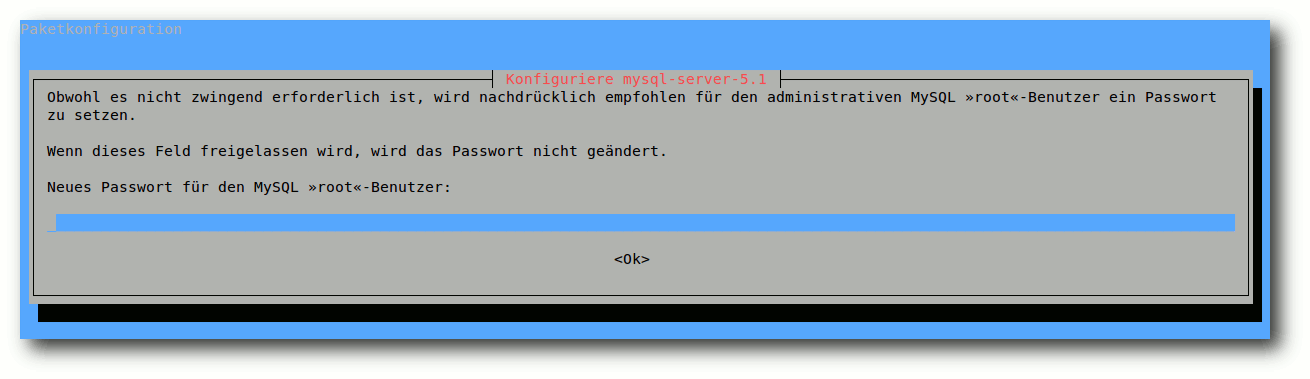

$ rhc-ctl-app -a "fMBeispiel" -e add-mysql-5.1

wird hier eine MySQL-Datenbank in der Version 5.1 installiert und nach kurzer

Wartezeit erhält man die Bestätigung, dass die Datenbank erfolgreich erstellt

werden konnte. Zusätzlich erhält man die benötigten Login-Daten für den

Administrator der Datenbank.

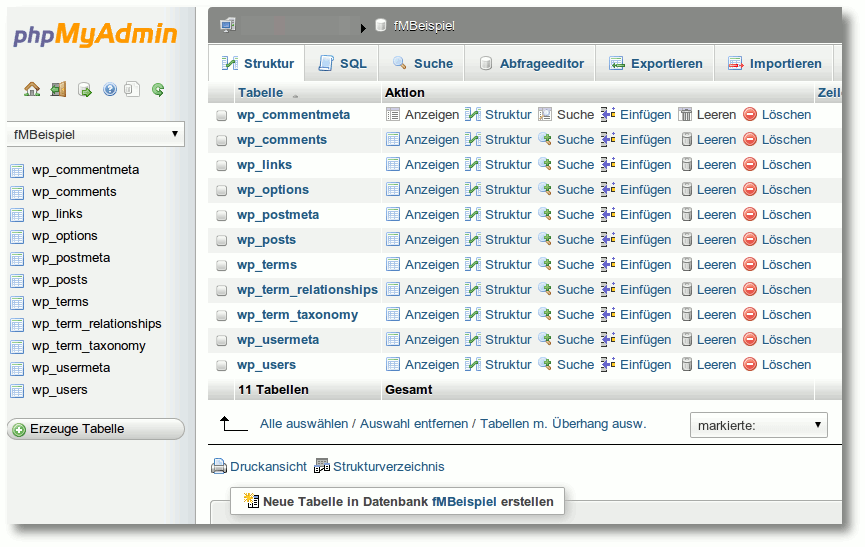

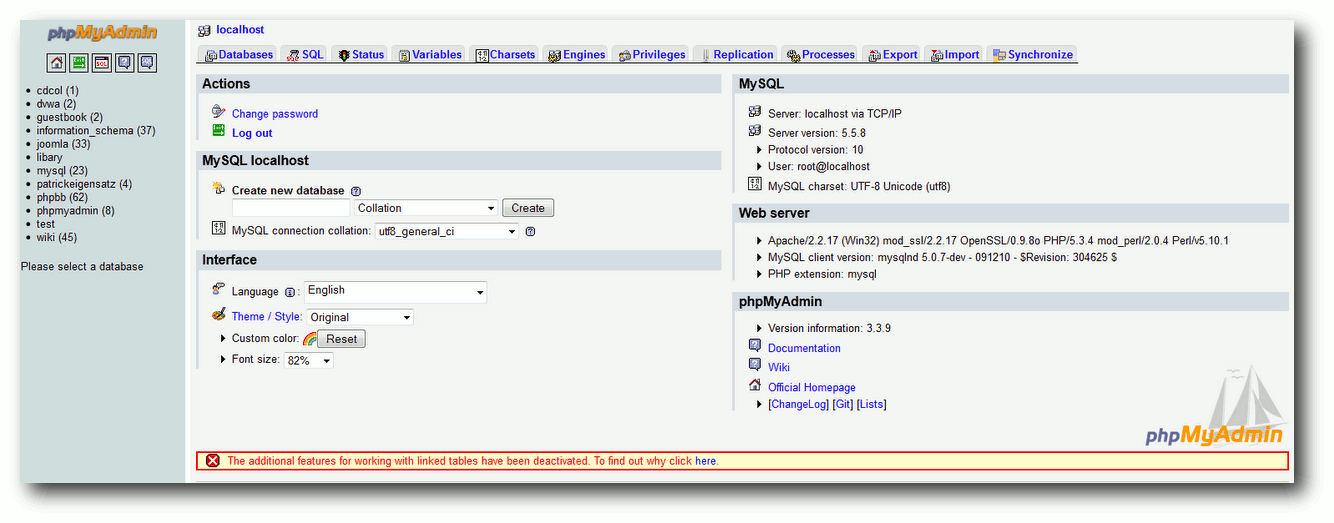

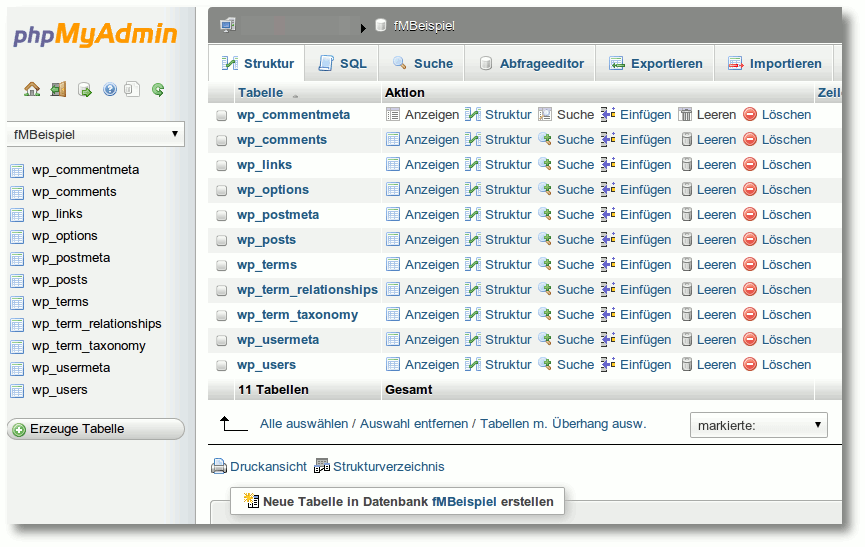

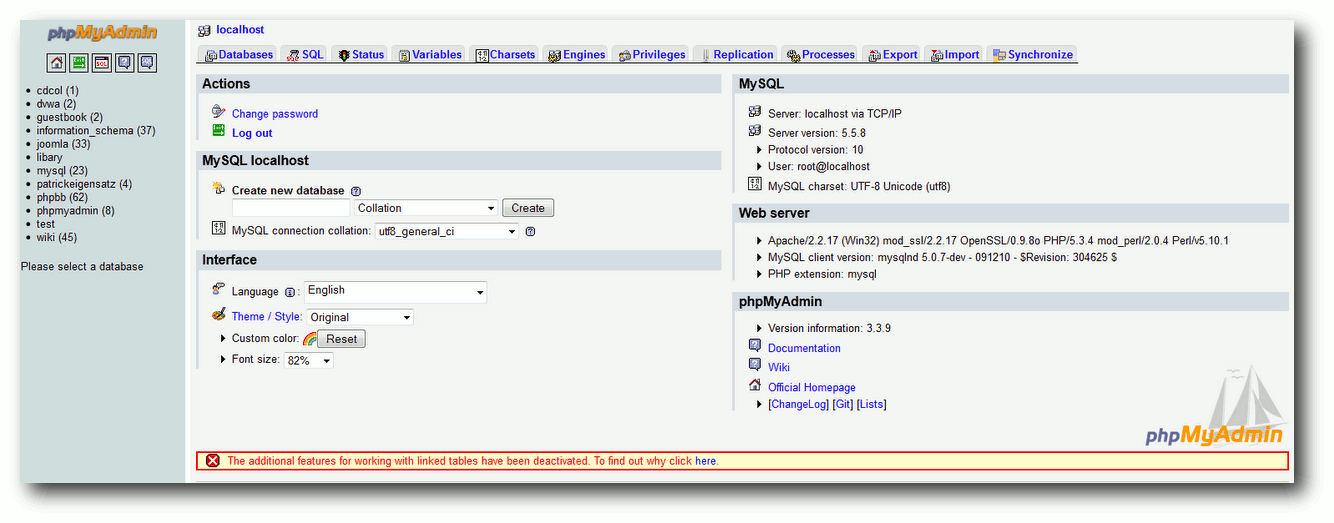

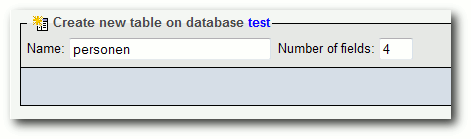

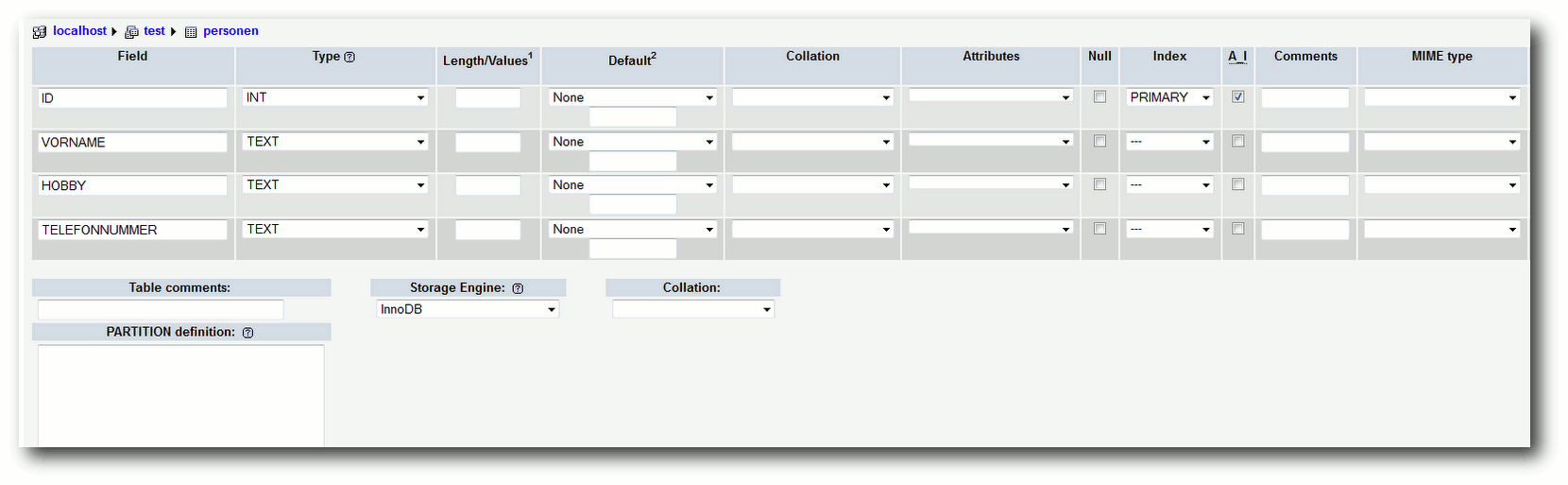

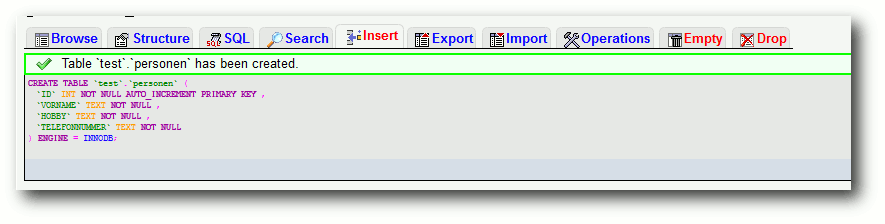

Viele bevorzugen zum Verwalten ihrer Datenbank, d. h. zum Anlegen von Tabellen,

Spaltendefinitionen u. v. m., eine grafische Benutzeroberfläche, damit nicht

alles über die Standard-Konsolenbefehle von MySQL durchgeführt werden muss.

Auch hierfür gibt es wiederum einen kurzen Befehl, der phpMyAdmin innerhalb

von OpenShift installiert.

$ rhc-ctl-app -a "fMBeispiel" -e add-phpmyadmin-3.4

Danach steht unter der Adresse http://URLdesProjektes/phpmyadmin die

Loginseite zur Verfügung, unter der man sich mit dem MySQL-Administrator

anmelden kann.

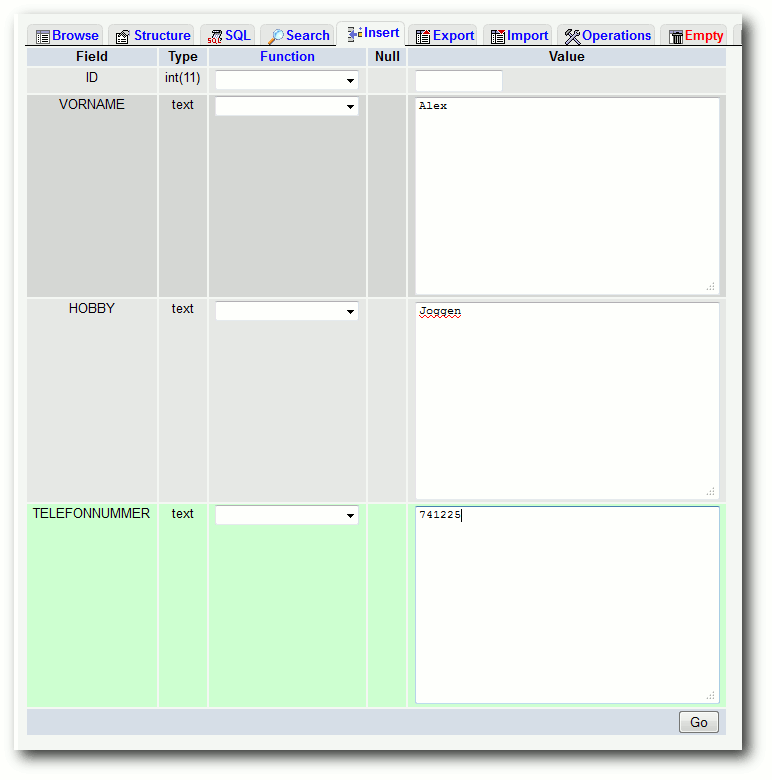

Schnell installiert: phpMyAdmin.

Somit ist es nun möglich, z. B. ein Wordpress-Blog wie auf einem

gewöhnlichen Webspace zu installieren, indem man einfach die

Installationsdateien von Wordpress in das Anwendungsverzeichnis legt und

mittels der oben erwähnten Git-Befehle in die Cloud lädt.

Alternativen

Wenn man bei seiner Anwendung an die Grenzen der kostenlosen Lösung von

OpenShift Express kommt, ist man nicht zwangsläufig an Red Hat

gebunden, sondern kann sich mittlerweile zwischen mehreren Anbietern

entscheiden.

Weit verbreitete andere Lösungen haben auch bekannten Firmen mit

Angeboten wie:

- Google App Engine

- Windows Azure

- Morph Application Platform

- Amazon Elastic Beanstalk

Dies sind nur einige der inzwischen zahlreichen Vertreter, bei denen man im

Einzelnen die Angebote für seine spezifischen Vorgaben vergleichen sollte.

Fazit

PaaS kann eine große Hilfe für diejenigen Entwickler sein, die schnell eine

funktionierende Plattform mit allen notwendigen Tools und Programmierumgebungen

benötigen und sich nicht leisten können, selber die komplette Installation und

Wartung von Hand vorzunehmen.

Mit OpenShift ist ein kostenloser Einstieg in diese Form des Cloud-Computing

sehr leicht möglich, man sollte aber beachten, dass man je nach Größe des

Projektes schnell mit den Restriktionen der Ressourcen an Grenzen stoßen kann.

Zudem begibt man sich wie bei allen Cloud-Formen in die Abhängigkeit

vom Anbieter, dass dieser die bereitgestellte Plattform auch korrekt verwaltet

und diese tatsächlich so performant und sicher zur Verfügung steht, wie

versprochen.

Man sollte daher stets abwägen, ob man die Risiken des Fremdhostings auf sich

nehmen will. Entschließt man sich für einen PaaS-Anbieter, stehen einem

durchaus neue Wege der Softwareentwicklung zur Verfügung.

Links

[1] http://de.wikipedia.org/wiki/Software_as_a_Service

[2] https://openshift.redhat.com/app/

[3] http://de.wikipedia.org/wiki/Platform_as_a_Service

[4] http://openstack.org/

[5] https://openshift.redhat.com/app/express

[6] http://docs.redhat.com/docs/en-US/OpenShift_Flex/1.0/html/User_Guide/chap-OpenShift_Overview.html

[7] https://docs.redhat.com/docs/en-US/OpenShift_Express/1.0/html/User_Guide/chap-User_Guide-Application_Development.html#sect-User_Guide-Application_Development-Overview

[8] https://github.com/openshift/os-client-tools

[9] https://openshift.redhat.com/app/express#quickstart

[10] https://rubygems.org/gems/rhc

[11] https://github.com/openshift/os-client-tools

[12] https://github.com/openshift/os-client-tools/blob/master/express/LICENSE

[13] http://de.wikipedia.org/wiki/Git

[14] http://fmbeispiel-freiesmagazinbsp.rhcloud.com/

| Autoreninformation |

| Patrick Meyhöfer (Webseite)

beschäftigt sich seit längerem mit Cloud-Lösungen.

Zunächst als Anwender von SaaS-Lösungen. Da diese Form bereits viele

Vorteile beinhaltete, testete er verschiedene PaaS-Lösungen für seine

Anwendungen aus und konnte mit OpenShift erste Erfahrungen sammeln.

|

Diesen Artikel kommentieren

Zum Index

von Herbert Breunung

Nach der Einführung in Referenzen und zusammengesetzte

Datenstrukturen in Teil 4 (siehe freiesMagazin 12/2011 [1])

folgt in diesem Teil die Anwendung des Gelernten. Das Notizprogramm

soll vielseitiger werden. Dabei werden erstmalig Funktionen wie

read_file erstellt. Wie in der Praxis werden sie in einem

eigenen Modul verstaut und von dort exportiert. Dann wird auch

endlich klar, was das :: in File::Slurp eigentlich bedeutet. Das

wird ab jetzt nicht mehr verwendet, sondern – wie angekündigt –

YAML, da die Datenstrukturen komplexer werden.

Vorbetrachtungen zur Datenstruktur

Die beliebtesten Fallen, in denen sich selbst erfahrene Entwickler

wiederfinden, sind die selbstgebauten. Denn so wichtig die Phantasie

vor allem in der Planungsphase ist, so wichtig ist es ebenfalls,

nicht zu vergessen, dass niemand genau voraussehen kann, was der

Benutzer möchte oder wie er das Programm letztlich nutzt. Deshalb

ist es sehr wichtig, die Grundstruktur einfach und flexibel zu

halten. Jede Notiz sollte deshalb nur ein Hash sein. Unter

aussagekräftigen Schlüsseln liegt dann der Inhalt, das Datum der

letzten Änderung und so weiter. Manche Angaben, wie etwa Referenzen

zu den Aufgaben, die zuerst getan werden müssen, bevor man dieser

Notiz Beachtung schenken sollte, benötigen ein Array. Dieses lässt

sich auch unter einem Schlüssel speichern. Aber komplizierter

soll es nicht werden. Die Notizen selber werden nicht gruppiert oder

verschachtelt, sondern weiterhin schön in ein Array gepackt.

Müssen die Notizen in einer komplizierteren Ansicht dargestellt

werden, so wird das woanders sortiert und gestapelt und von dort auf

die Notizhashs im Hauptarray gezeigt.