Zur Version ohne Bilder

freiesMagazin Juni 2011 (ISSN 1867-7991)

Topthemen dieser Ausgabe

Ubuntu 11.04 – Vorstellung des Natty Narwhal

Am 28. April 2011 wurde Ubuntu 11.04 freigegeben. Der Artikel gibt einen Überblick über die Neuerungen der Distribution mit besonderem Augenmerk auf das neue Desktop-System „Unity“, welches im Vorfeld bereits für viel Furore sorgte. (weiterlesen)

GNOME 3.0: Bruch mit Paradigmen

Mit der Freigabe von GNOME 3 bricht der Entwicklerkreis rund um die Desktopumgebung mit vielen gängigen Paradigmen der Benutzerführung und präsentiert ein weitgehend überarbeitetes Produkt, das zahlreiche Neuerungen mit sich bringt. Drei wesentliche Punkte sind in die neue Generation der Umgebung eingegangen: eine Erneuerung der Oberfläche, Entfernung von unnötigen Komponenten und eine bessere Außendarstellung. (weiterlesen)

UnrealIRC – gestern „Flurfunk“, heute „Chat“

Ungern brüllt man Anweisungen von Büro zu Büro. Damit Angestellte miteinander kommunizieren können, wird vielerorts zum Telefon gegriffen. Wird bereits telefoniert, muss die dienstliche E-Mail herhalten, um Kommunikationsbedürfnisse zu befriedigen. Was aber, wenn die Leitung belegt und das Senden einer E-Mail derzeit nicht möglich ist? Ein Chat ist die Lösung für das Problem. (weiterlesen)

Zum Index

Linux allgemein

Ubuntu 11.04 – Vorstellung von Natty

GNOME 3.0: Bruch mit Paradigmen

Der Mai im Kernelrückblick

Anleitungen

UnrealIRC – gestern „Flurfunk“, heute „Chat“

Software

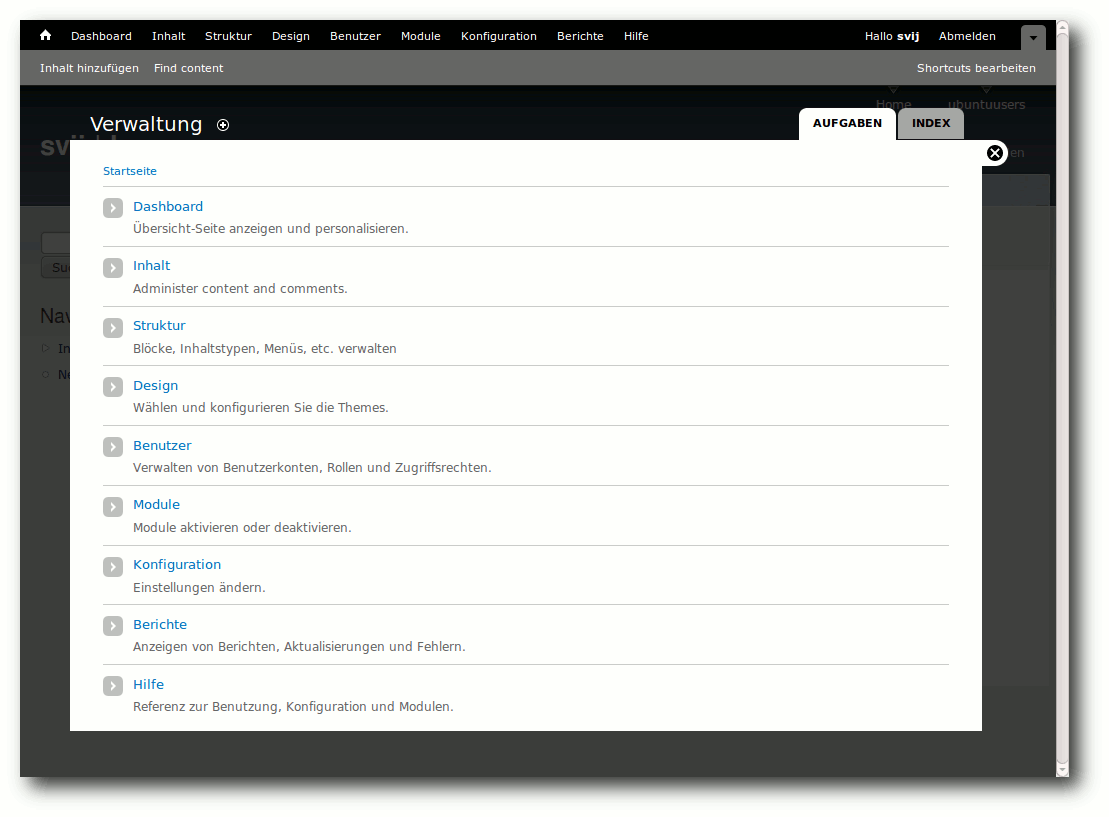

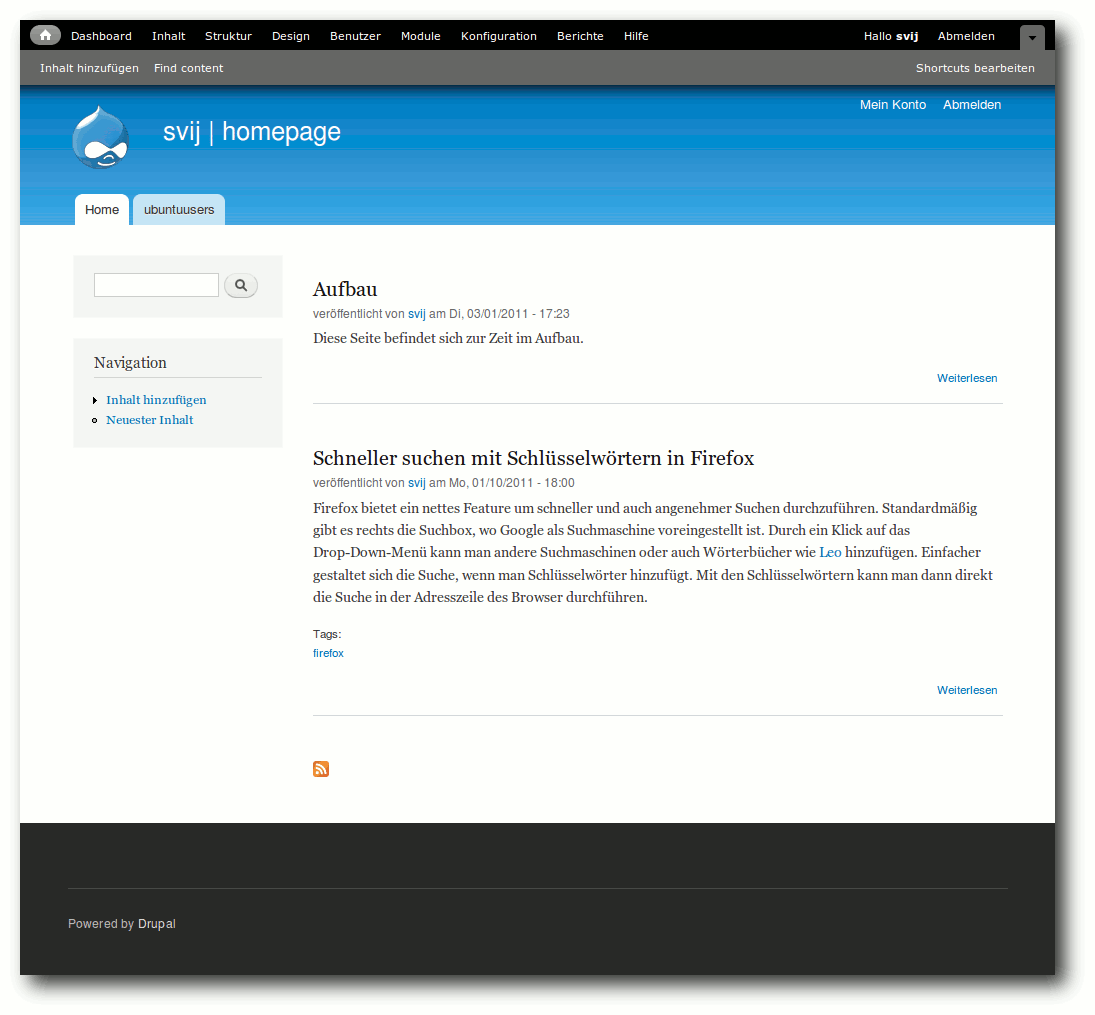

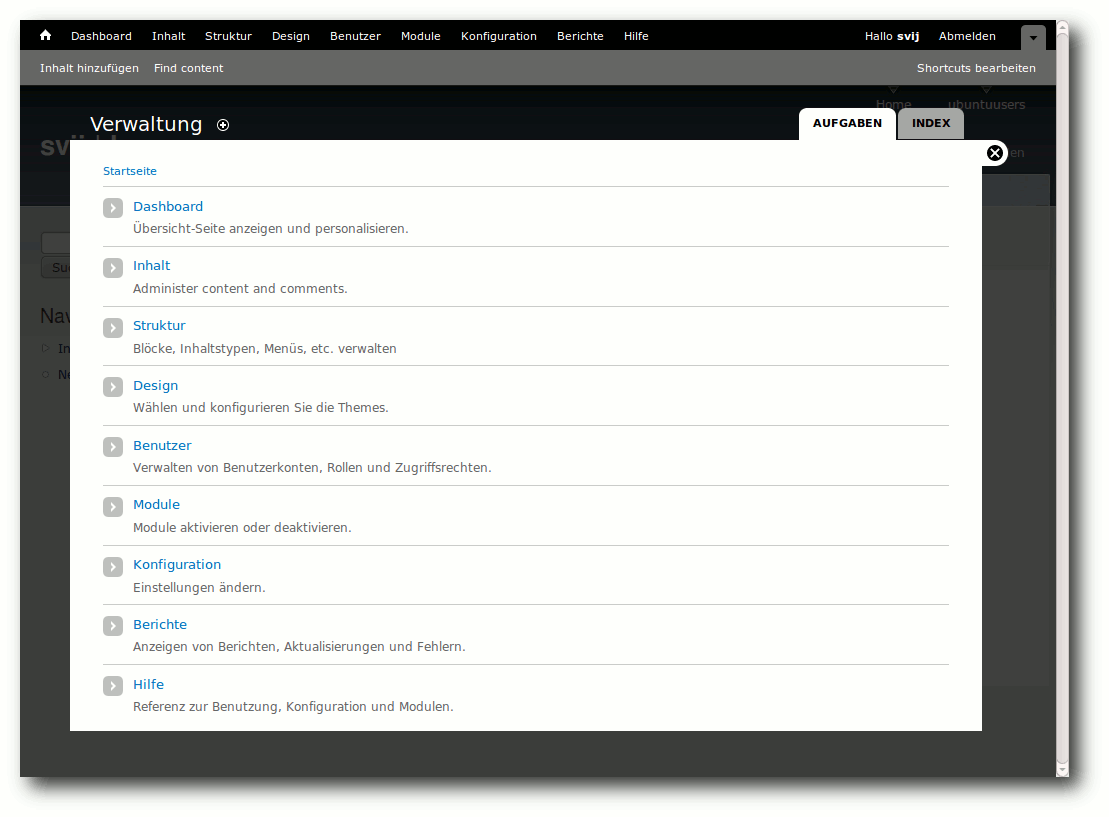

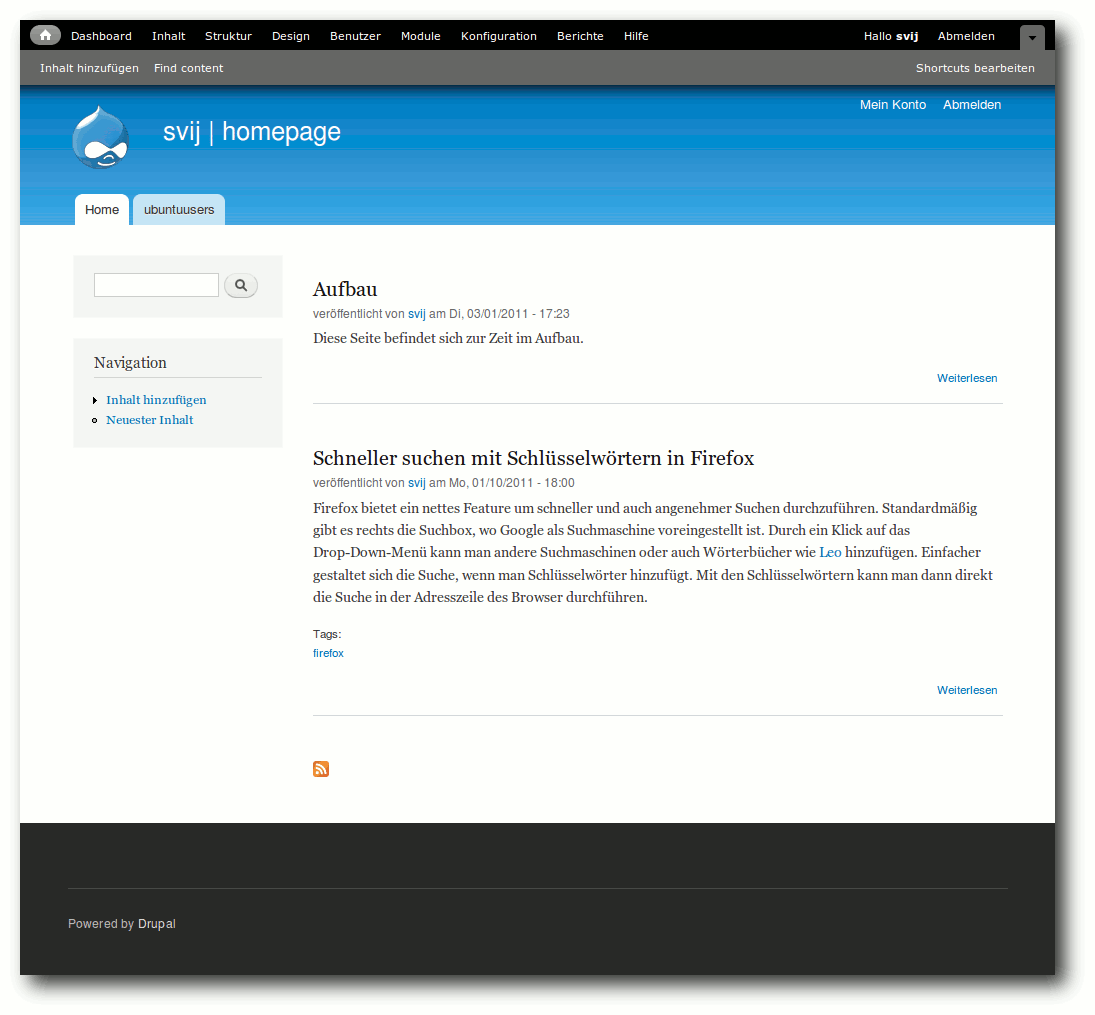

Einblicke in Drupal

Hardware

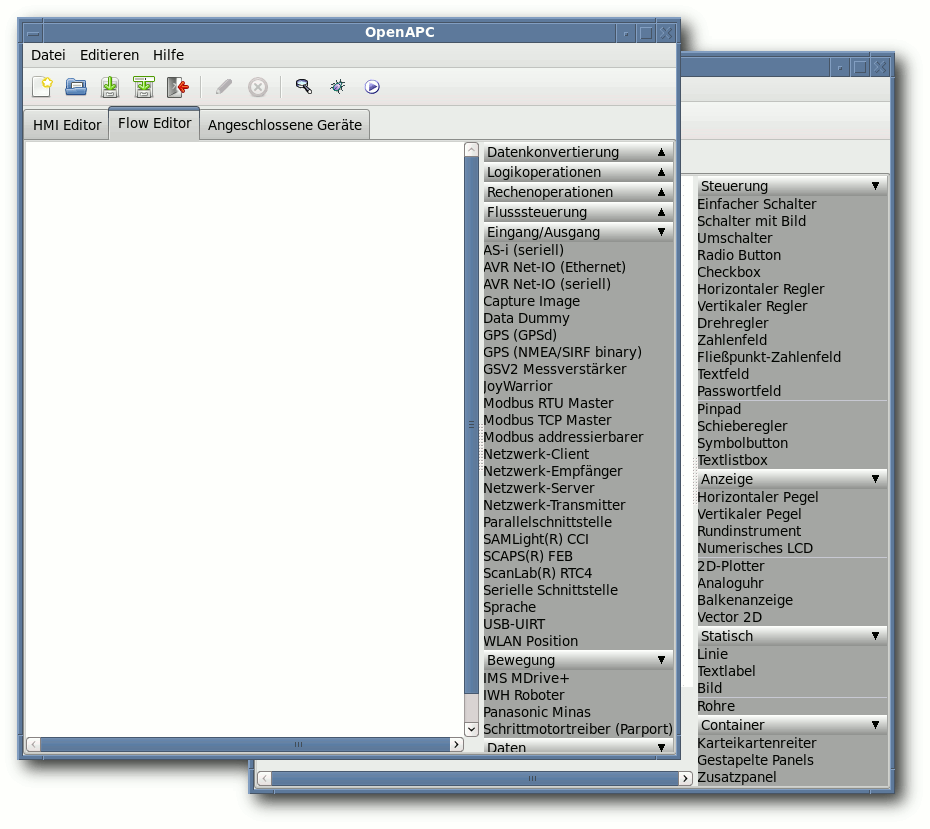

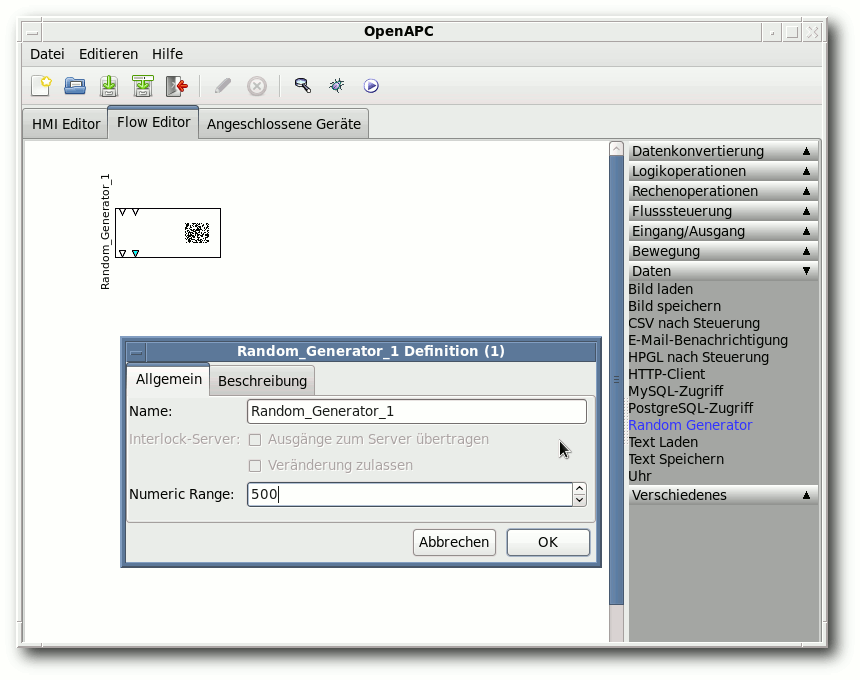

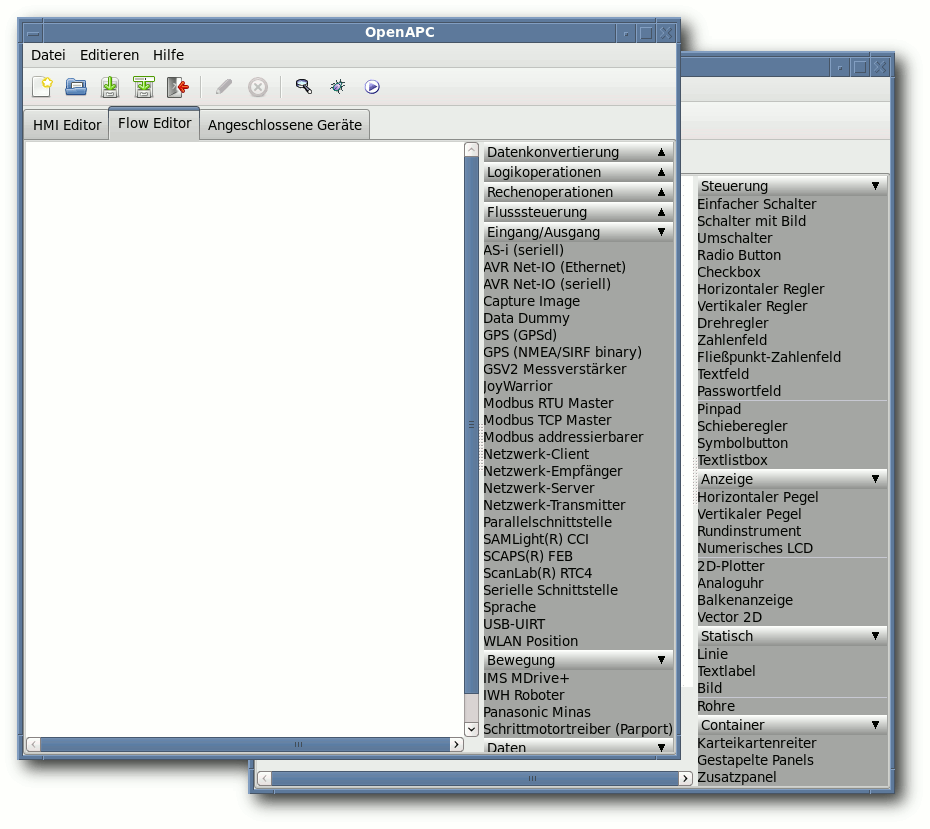

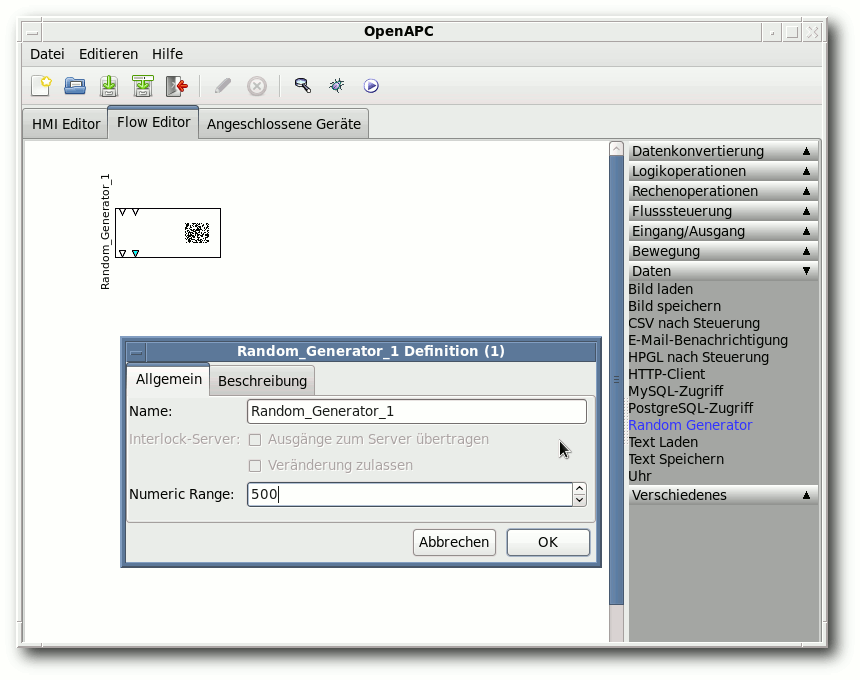

Heimautomatisierung für Hardwarebastler (Teil 3)

Community

Rezension: Praxiskurs Unix-Shell

Rezension: Computergeschichte(n) – nicht nur für Geeks

Magazin

Editorial

Leserbriefe

Veranstaltungen

Vorschau

Konventionen

Impressum

Zum Index

Traut Euch und macht mit

Wer nicht wagt, der nicht gewinnt

Die Reaktionen auf unsere These im Editorial des letzten Monats [1] waren recht gut.

Zur Erinnerung: Wir fragten, ob – nach der bescheidenen Teilnehmerzahl

am Grafikwettbewerb [2] –

auch die Linux-Community zu einer reinen Konsumgesellschaft verkommt.

Wie in den Leserbriefen nachzulesen ist,

gab es einige Zustimmungen, aber auch kritische Gegenstimmen.

Was uns aber sehr gewundert hat, waren sehr häufige Bemerkungen der

Art „Ich habe mir eh keine Chancen ausgerechnet bei der Masse an

professionellen Einsendungen“. Wie jetzt jeder weiß, haben wohl sehr

viele Leser so gedacht, was die geringe Teilnahme am Wettbewerb

erklären könnte.

Achtung, jetzt wird es politisch: Das obige Beispiel zeigt sehr schön,

wieso man wählen sollte. Wenn jeder potenzielle Wähler einer „normalen“

Partei (was auch immer das ist) sich denkt, dass die Wahl eh nichts

bringt und andere schon wählen gehen werden, kann es am Ende passieren,

dass irgendeine extreme Partei mit ganz wenig Stimmen die Wahl gewinnt.

Als alternatives Beispiel: Wer bei einem Wettbewerb erst gar nicht

teilnimmt, hat automatisch verloren. Erst durch die Teilnahme gibt

es überhaupt eine Chance, etwas zu gewinnen – auch wenn diese Chance

vielleicht verschwindend gering ist.

Dies gilt im Übrigen für fast alles im Leben: sei es die Frage nach

einer Gehaltserhöhung, das erste zögerliche Gespräch mit seinem

Schwarm oder der Umzug ins Ausland, um eines neues Leben zu beginnen.

Wer diese Schritte nicht wagt, wird auf alle Fälle nicht enttäuscht,

das stimmt. Aber er wird auch nie die positiven Konsequenzen seines

Handelns spüren, wenn er es nicht zumindest versucht. (Es erfolgt hier

explizit der Hinweis, dass das nicht für alles gilt. Der Sprung aus

einem Fenster im zehnten Stock eines Hochhauses, nur um zu wissen,

wie sich das anfühlt, ist eine blöde Idee.)

Call for Papers zur Ubucon 2011

Einige Leser werden es vielleicht schon gesehen haben: Vom 14. bis

16. Oktober 2011 soll in Leipzig die fünfte Ubucon stattfinden [3].

Wieso erwähnen wir das hier explizit und verlinken es nicht nur im

Veranstaltungskalender wie

gewohnt? Zum einen, weil wir die Wurzeln von freiesMagazin nicht vergessen

haben, die ganz klar bei Ubuntu und beim Portal

ubuntuusers.de [4] liegen. Die Ubucon wird zu einem großen

Teil genau von den Leuten hinter diesem Portal getragen. Zum

anderen aber auch, weil die Veranstaltung die letzten Jahre einen

sehr guten Anlaufpunkt für alle Neueinsteiger und Anfänger gebildet

hat. Die Vorträge beschäftigten sich nur selten mit extrem

speziellen

Problemen, sondern zeigten das, was den Normalanwender

auch interessiert.

Sollte also ein freiesMagazin-Leser bzw. -Autor Lust haben, Leipzig im Oktober

einen Besuch abzustatten, kann er auf der Ubucon vorbei schauen und

dabei auch gleich einen Vortrag halten. Wer meint, dass sich das nicht lohnt, weil ganz viele andere,

viel bessere Vorschläge bei der Ubucon-Organsation eingehen und der

eigene Vortrag dagegen „schlecht“ aussieht, sollte sich noch einmal

die ersten Absätze dieses Editorials durchlesen.

Serverumzug

Wie sicherlich einige unserer Webseiten-Besucher wissen, wird der

Server, auf denen die freiesMagazin-Dienste wie Webseite, FTP,

Versionsverwaltung, Wiki etc. laufen, von der Firma

x|encon [5] gesponsort. Da der

bisherige Server eine für die Zukunft ungenügende

Hardwareausstattung hat, haben wir (ohne unser Zutun) einen neuen

Server gestellt bekommen:

| Hardwarevergleich |

| Hardware | Alter Server | Neuer Server |

| RAM | 256MB | 1024MB |

| HDD | 20GB (nach Upgrade!) | 40GB |

| CPU | 1x | 2x |

| HVM | Nein | Ja |

| VNC | Nein | Ja |

| |

Da wir auf einen neuen Server migrierten, implementierten wir

natürlich auch IPv6, welches x|encon mittlerweile auch für (fast)

alle Produkte anbietet. Bei dieser Gelegenheit schwenkten wir auch

gleich von Ubuntu 6.06 „Dapper Drake“, dessen Support im Juni dieses

Jahres auch für die Serverversion ausläuft auf Debian 6.0 „Squeeze“.

Gleichzeitig konnten wir so alles, was bisher bereits läuft,

endlich einmal dokumentieren und bekommen eine einmalige Gelegenheit

klar Schiff zu machen, sodass wirklich nur noch das läuft, was

gebraucht wird. Die vorherigen Administratoren hatten hier

aber schon viel Vorarbeit geleistet und alle Dienste sinnvoll

konfiguriert.

Bei der Neuinstallation haben wir auch einige andere Sachen

mitbehoben, welche in der Vergangenheit negativ aufgefallen sind.

So haben wir auf dem neuen Server jetzt ein LVM [6], welches es

ermöglicht, Snapshots vom System anzulegen oder die Volumes in der

Größe zu verändern. Zusätzlich bekommt jeder wichtige Dienst für

seine Daten ein eigenes Volume und kann so nicht das Root-Dateisystem

vollschreiben.

Die Migration der Daten startete am Freitag 27.05.2011 um 20:00

Uhr [7];

vorab hatten wir die Daten aber zu Testzwecken schon einmal

herüberkopiert. Durch rsync hatte dieser Teil nur circa

20 Minuten gedauert. Die komplette Migration dauerte in etwa zwei Stunden, da natürlich wie bei jeder großen Umstellung noch ein, zwei

Sachen im Vorfeld nicht ganz bekannt waren.

Nachdem alle Dienste auf dem neuen Server migriert waren, wurden

auch die DNS-Einträge geändert und IPv6 „scharfgeschaltet“.

Die Migration hat sich für uns gelohnt, da wir zum einen ein performanteres

System erhalten haben, aber auch das leidige Thema der Dokumentation

erschlagen konnten. In Zukunft wird es bestimmt noch die eine oder

andere Neuerung geben, die sich unter Umständen auch (positiv) auf

die Leser auswirkt.

Redaktioneller Hinweis: Obiger Abschnitt zur Serverumstellung stammt von unserem

Server-Administrator Stefan Betz.

Und nun wünschen wir Ihnen viel Spaß mit der neuen Ausgabe.

Ihre freiesMagazin-Redaktion

Links

[1] http://www.freiesmagazin.de/freiesMagazin-2011-05

[2] http://www.freiesmagazin.de/20110430-gewinner-des-grafikwettbewerbs

[3] http://ikhaya.ubuntuusers.de/2011/05/12/ubucon-2011-call-for-papers-gestartet/

[4] http://ubuntuusers.de/

[5] http://www.xencon.net/

[6] https://secure.wikimedia.org/wikipedia/de/wiki/Logical_Volume_Manager

[7] http://www.freiesmagazin.de/20110527-serverumzug

Das Editorial kommentieren

Zum Index

von Hans-Joachim Baader

Am 28. April 2011 wurde Ubuntu 11.04 freigegeben. Dieser Artikel

gibt einen Überblick über die Neuerungen mit besonderem Augenmerk

auf das neue Desktop-System „Unity“.

Redaktioneller Hinweis: Der Artikel „Ubuntu 11.04“ erschien erstmals bei

Pro-Linux [1].

Vorwort

Planmäßig wie jedes halbe Jahr erschien die neue Version 11.04

„Natty Narwhal“ der Linux-Distribution Ubuntu. Unter den vielen

Neuerungen ragt wohl eine besonders heraus: der neue Desktop

„Unity“, der zuvor schon als Desktop für Netbook-Systeme im Einsatz

war und jetzt der Standard-Desktop auf allen Rechnern ist, die die

Hardware-Anforderungen erfüllen. Schon im Vorfeld wurde viel über

das Für und Wider von Unity diskutiert.

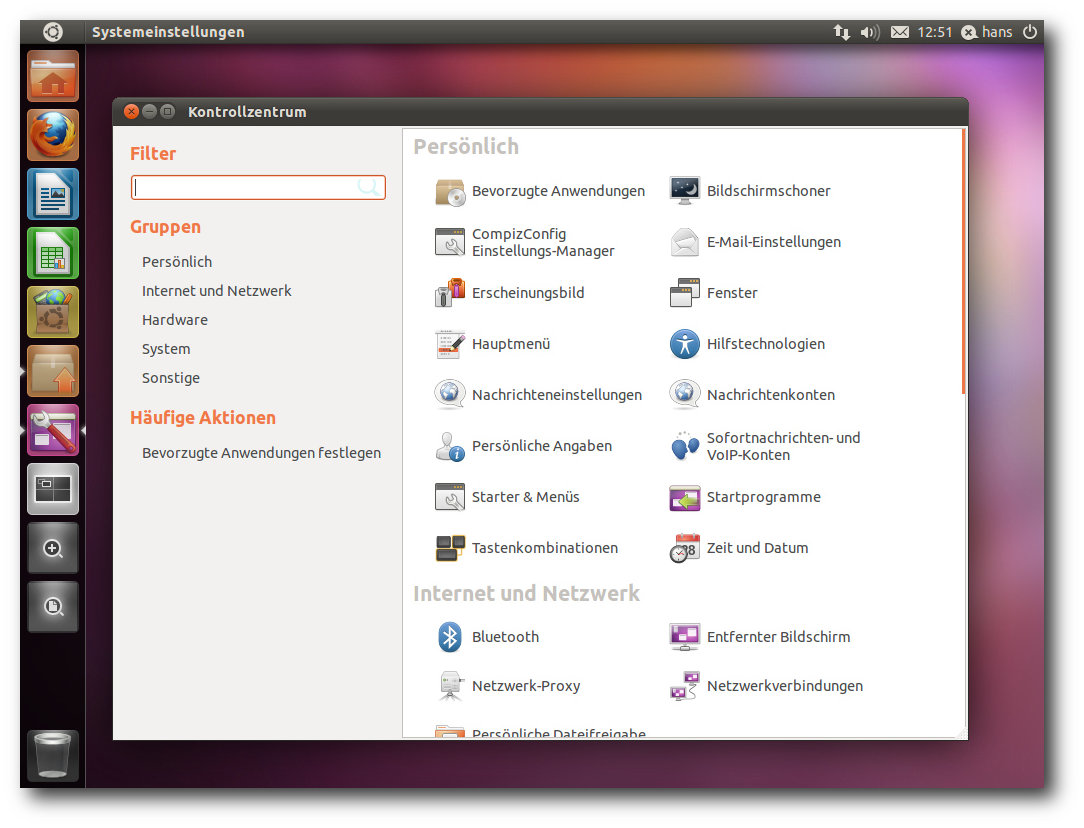

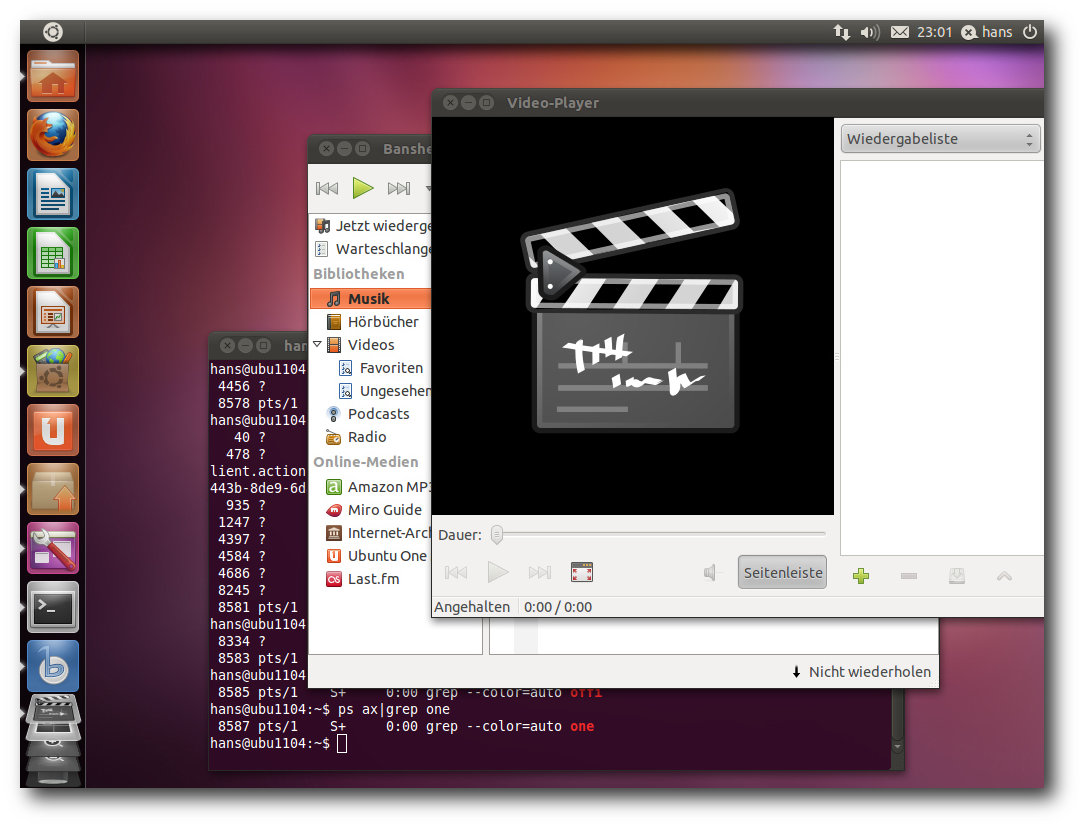

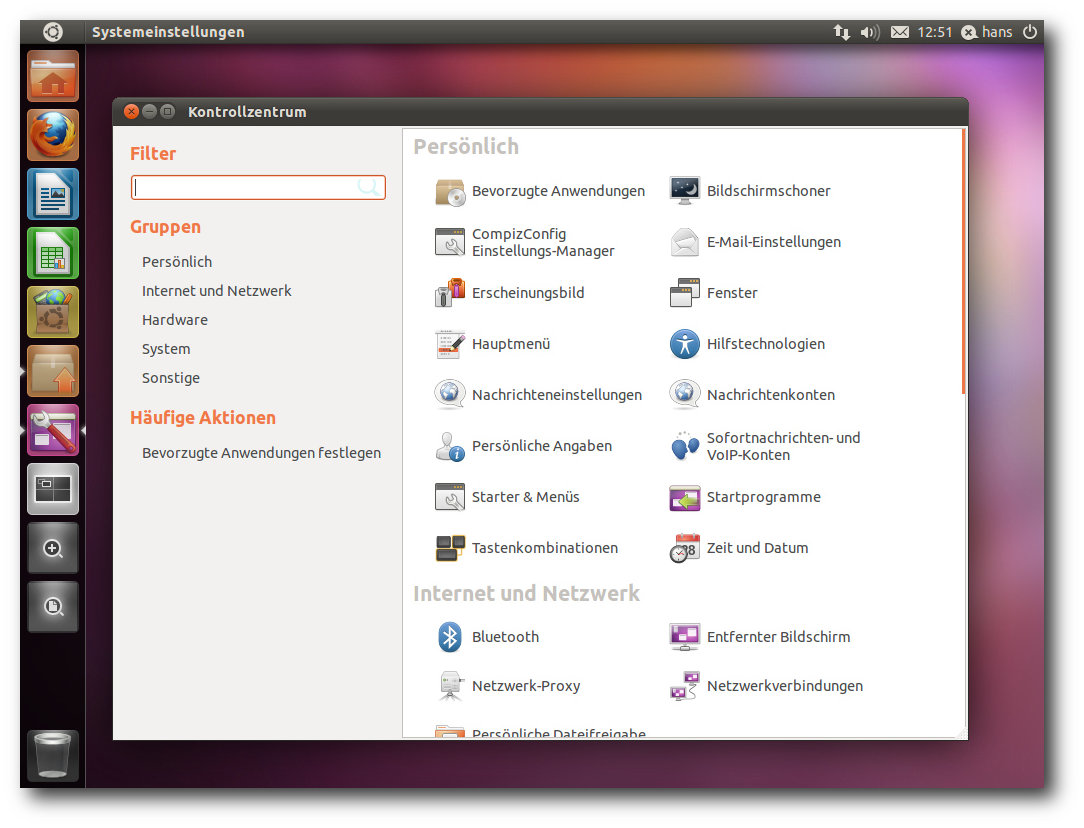

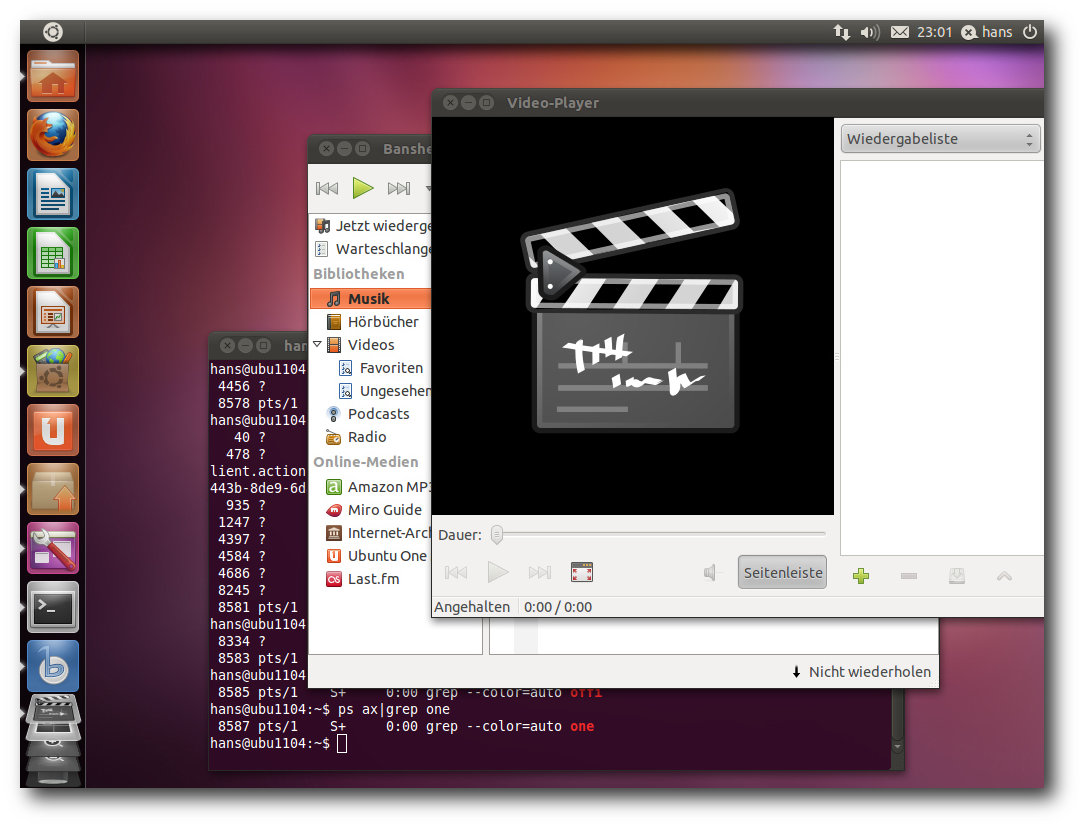

Unity mit Starter, Kontrollzentrum und schmalen Scrollbalken.

Wie ihr Vorgänger Ubuntu 10.10 (siehe „Ubuntu 10.10“, freiesMagazin

11/2010 [2]) ist

die neue Version keine Version mit längerfristigem Support. Sie

wird in allen Varianten 18 Monate mit Sicherheits- und anderen

wichtigen Updates versorgt. Ein Update ohne Neuinstallation von der

Version 10.10 wird offiziell unterstützt.

Ubuntu erscheint in mehreren Varianten, deren Hauptunterschied in

den Installationsmedien und dem Umfang der vorinstallierten Software

liegt. Die von Canonical hervorgehobenen Varianten sind jedoch die

Desktop-Edition mit Unity als

Oberfläche und die Server-Edition.

Die weiteren offiziell unterstützten Varianten sind Kubuntu,

Xubuntu, Edubuntu, Ubuntu Studio und Mythbuntu. Dieser Artikel wird

sich auf Ubuntu und Kubuntu beschränken. Aus praktischen Gründen

sind auch andere Einschränkungen nötig. So wurden natürlich

zahlreiche zur Distribution gehörende Softwarepakete geändert,

manche auch ersetzt. Mit wenigen Ausnahmen kann auf diese

Änderungen nicht eingegangen werden; man darf annehmen, dass die

meisten Pakete unter allen

aktuellen Distributionen nahezu gleich

sind und überall gleich gut funktionieren.

Es sei noch angemerkt, dass es sich bei diesem Artikel nicht um

einen Test der Hardwarekompatibilität handelt. Es ist bekannt, dass

Linux mehr Hardware unterstützt als jedes andere Betriebssystem

und das überwiegend bereits im Standard-Lieferumfang. Ein Test

spezifischer Hardware wäre zu viel Aufwand für wenig Nutzen. Dies

sei denen überlassen, die es für nötig halten. Die bekannten

Probleme von Ubuntu 11.04 mit Hardware sind in den Anmerkungen zur

Veröffentlichung [3]

aufgeführt.

Da eine Erprobung auf realer Hardware nicht das Ziel ist, werden

für den Artikel zwei identische virtuelle Maschinen, 64 Bit, unter

KVM mit jeweils 768 MB RAM verwendet. Weil KVM nicht die nötigen

Voraussetzungen für Unity bietet, wird eine weitere 64-Bit-VM unter

Virtualbox hinzugezogen.

Installation

Ubuntu wird meist von einem Live-System aus, das als CD und

umfangreichere DVD verfügbar ist, installiert. Ferner ist eine

Installation von der „Alternate-CD“ möglich, die im Textmodus

läuft, aber wesentlich mehr Flexibilität als die grafische

Installation besitzt.

Für Ubuntu 11.04 werden 384 MB RAM für den Unity-Desktop als

Mindestanforderung angegeben. Mit 512 MB und mehr läuft das System

allerdings wesentlich besser. Kubuntu ist aufgrund des größeren

Speicherbedarfs von KDE unter 512 MB RAM fast nicht zu benutzen –

aber wer den Rechner intensiv nutzt, sollte bei den heutigen

Speicherpreisen lieber gleich in 4 bis 8 GB RAM und ein

64-Bit-System investieren, so dass reichlich Platz für die

Anwendungen ist. Xubuntu und die Server-Edition sollten weiterhin

mit 128 MB auskommen.

Startbildschirm der Desktop-DVD.

Im Folgenden soll nur die Installation von der Desktop-DVD kurz

vorgestellt werden. Wer den Logical Volume Manager (LVM) verwenden

will, muss zur textbasierten Installation von der DVD oder der

Alternate-CD wechseln, da diese Möglichkeit im grafischen Installer

nach wie vor fehlt. Die Alternate-Installation läuft ansonsten fast

genauso ab wie die grafische Installation. Durch Boot-Optionen

steht aber eine erweiterte Installation zur Verfügung, mit der man

weitgehende Kontrolle über den ganzen Vorgang hat.

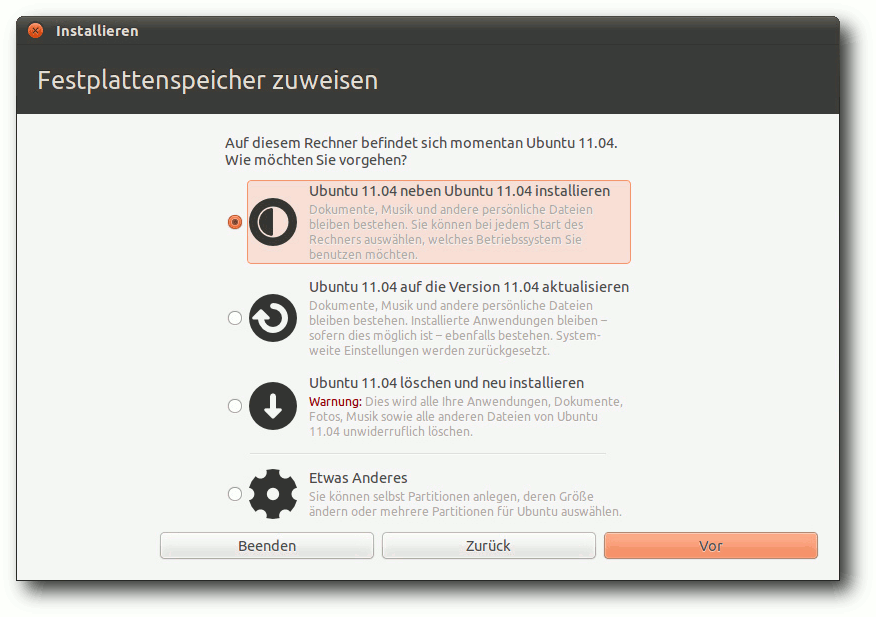

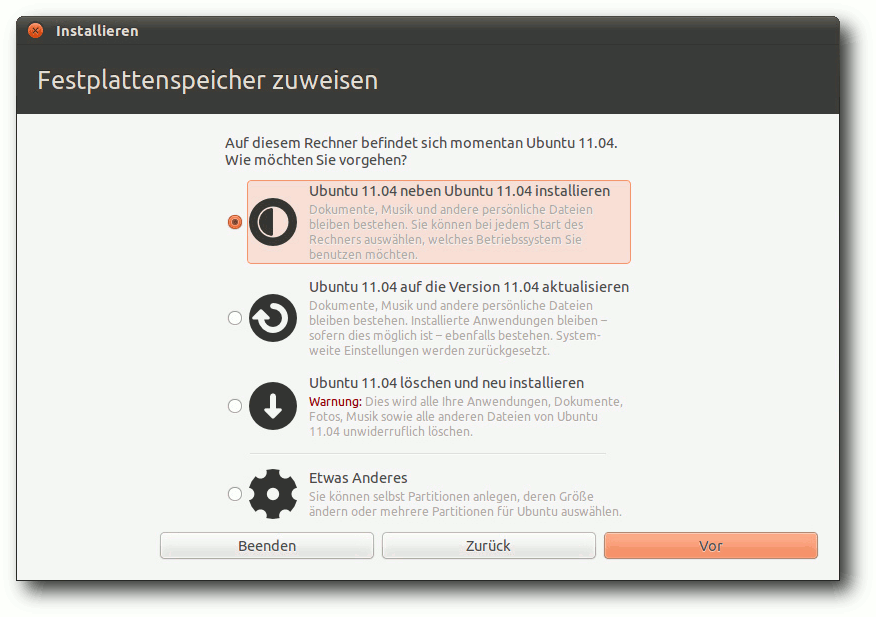

Die Installation unterlag nur wenigen Änderungen gegenüber der

letzten Version, die ja etwas umgestellt und verbessert wurde. Das

Einrichten der Festplatte ist nun noch einfacher und bietet einige

weitere Optionen. So kann ein bereits installiertes Ubuntu-System

vom Desktop-Installer aus aktualisiert oder neu installiert werden,

wenn eine Internet-Verbindung vorhanden ist. Ist die vorherige

Installation bereits Ubuntu 11.04, kann das allerdings zu kuriosen

Vorschlägen wie „Ubuntu 11.04 auf Ubuntu 11.04 aktualisieren“ führen.

Merkwürdige Formatierungsoptionen.

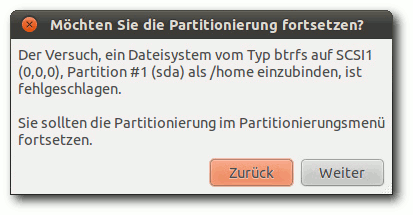

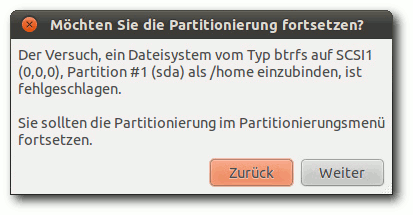

Das Dateisystem Btrfs kann nun ausgewählt werden und das System

sollte dank eines GRUB-Moduls auch mit diesem booten können. Btrfs wird

in den Anmerkungen zur Veröffentlichung ausdrücklich noch als

experimentell gekennzeichnet, aber mit einigen kleinen

Einschränkungen sollte es nutzbar sein. Im Test kam es während der

Formatierung zu einem nicht in den Anmerkungen genannten Fehler,

sodass ext4 als Dateisystem gewählt werden musste. Auch bei einer

weiteren Testinstallation trat dieser Fehler auf.

Fehler beim Anlegen von Btrfs.

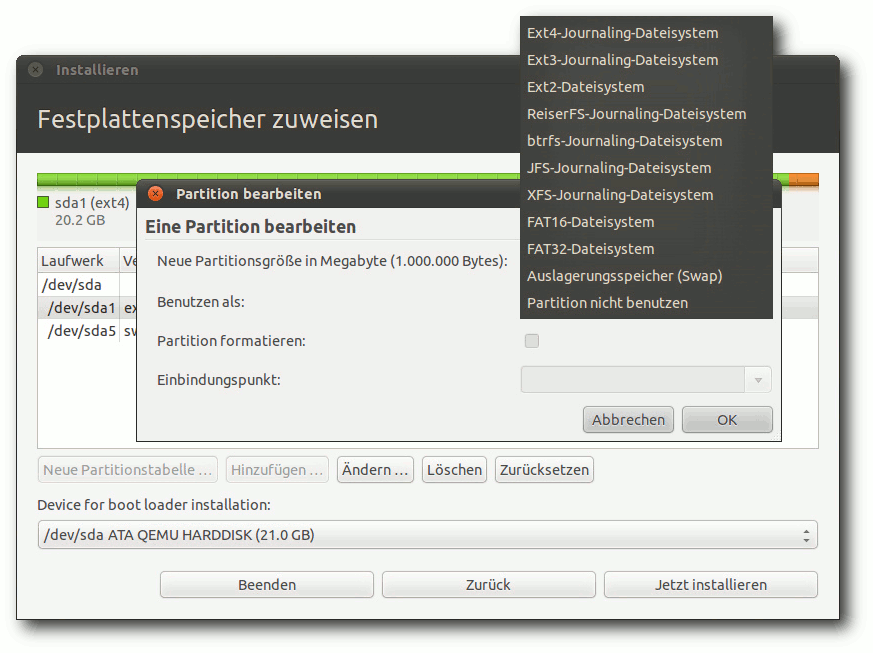

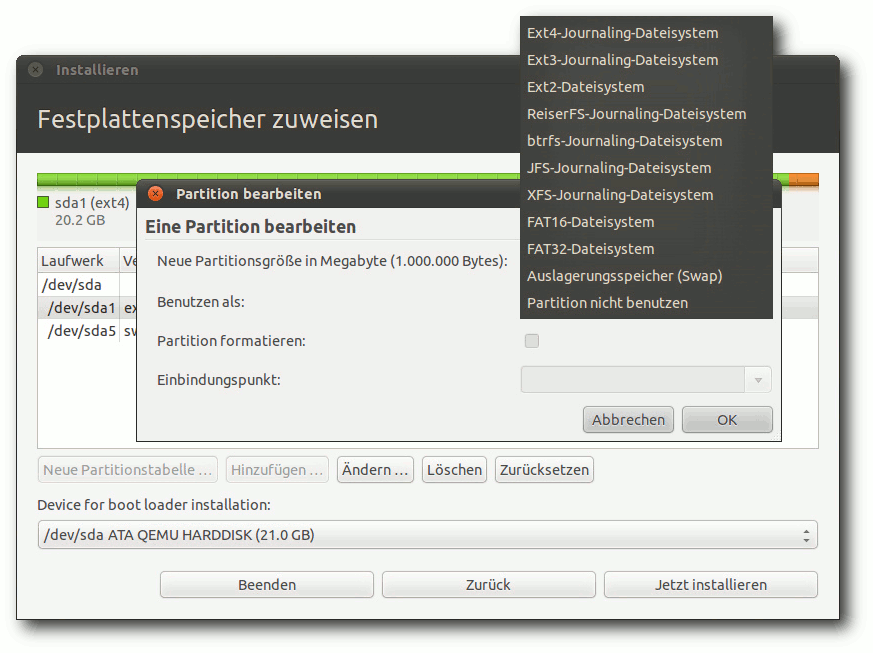

Von diesen Makeln abgesehen funktioniert die Partitionierung

korrekt. An das Einrichten mindestens einer Swap-Partition wird man

gegebenenfalls erinnert und es wird gewarnt, wenn die

Root-Partition zu klein für die Installation ist. Hier hat das

Programm gegenüber der letzten Version hinzugelernt, denn es warnt

nun nicht mehr,

wenn man die Root-Partition klein macht und eine

separate, ausreichend große Partition für /usr anlegt. Der

Einbindungspunkt kann nun nicht mehr frei eingegeben werden,

sondern man ist auf die Auswahl beschränkt, die Ubuntu vorgibt.

Dateisystemauswahl bei der Partitionierung.

Direkt nach der Definition der Partitionen beginnt der Installer mit

der Partitionierung und der Installation der Pakete im Hintergrund.

Ein Fortschrittsbalken zeigt von hier ab den Stand der Installation

an. Parallel dazu kann man die Zeitzone auswählen und danach das

gewünschte Tastatur-Layout einstellen.

Im letzten Schritt gibt man seinen Namen, Anmeldenamen, Passwort und

den Computernamen ein. Wenn zuvor bereits per DHCP ein Name

ermittelt werden konnte, wird dieser als Vorgabe angezeigt. Wenn

erkannt wird, dass die

Installation in einer virtuellen Maschine

läuft, wird

dagegen der Name benutzer-virtual-machine vorgegeben.

Optional können Daten im Home-Verzeichnis verschlüsselt werden.

Während man das Ende der Installation abwartet, kann man nun noch

einige Tipps zu Ubuntu ansehen.

Laufender Betrieb

Das System startet, gleichgültig ob Ubuntu oder Kubuntu, schnell.

Sofern kein automatisches Login konfiguriert wurde, muss man sich

anmelden, was unter Ubuntu mit gdm, unter Kubuntu mit kdm

geschieht. Danach wird der vollständige Desktop zügig aufgebaut.

Der Kernel wurde auf Linux 2.6.38.2 aktualisiert (siehe „Was Natty

antreibt: Ein Blick auf den Kernel von Ubuntu 11.04“, freiesMagazin

05/2011 [4]). Da

sich die folgenden Ausführungen ausschließlich auf den Desktop

beziehen, ist dies nur ein kleines Detail am Rande. Wie gewohnt hat

Root keinen direkten Zugang zum System. Zugang zum Root-Account ist

aber über das Kommando sudo vorhanden. Damit kann man jeden

beliebigen Befehl ausführen, nachdem man sein eigenes Passwort

eingegeben hat. Wenn man, nachdem man als Root eingeloggt ist, ein

Passwort vergibt, ist auch das direkte Einloggen als Root möglich.

Der GNOME-Desktop benötigt mit einem Terminalfenster ohne weitere

offene Programme etwa 350 MB, nachdem in der Vorversion noch 220 MB

gemessen wurden. Der Grund für diese Zunahme ist zum einen der

Daemon ubuntuone-syncd, der im Testsystem mehr Speicher frisst als

X11. Zum anderen ist auch

der zeitgeist-daemon hinzugekommen, der auf diesem System 21 MB

resident belegt. „Erschreckend“ ist, wie wenig dynamische

Bibliotheken dabei gemeinsam benutzt werden. So belegt

ubuntuone-syncd 45 MB resident, davon sind nur 11 MB dynamischen

Bibliotheken zuzuordnen. Hier wäre einmal ein Aufräumen überfällig.

Allerdings ist das Problem, von ubuntuone-syncd abgesehen, nicht

Ubuntu-spezifisch.

KDE benötigt etwa 430 MB, die Zunahme im Vergleich zum letzten Test

scheint aber auf Änderungen an der virtuellen Maschine zu beruhen,

wodurch X11 mehr Speicher belegt. Das zeigt wieder einmal, dass die

Angaben zum Speicherverbrauch nur Anhaltswerte darstellen, die sich

je nach Hardware erheblich unterscheiden können.

Unity

Die größte Neuerung im Desktop-Bereich ist zweifellos Unity, das

allerdings nicht als eigene Desktopumgebung gelten kann, sondern

lediglich als alternative Oberfläche für GNOME. Unity entstand als

Netbook-Oberfläche und feierte in der Netbook-Edition von Ubuntu

10.10 sein Debüt. Nach Differenzen zwischen Ubuntu und GNOME (GNOME 3

kam nach Ansicht von Ubuntu zu früh) wurde das Ziel ausgegeben,

Unity zur Standard-Oberfläche zu machen, und nach

zwischenzeitlichen Zweifeln [5]

auch erreicht. Aufgrund der Kontroversen, in die sich auch der

bekannte Buchautor Michael Kofler mit einer kritischen

Beurteilung einschaltete [6],

durfte man sehr gespannt sein, wie sich Unity mittlerweile anfühlt.

Unity beruht noch ganz auf GNOME 2 (2.32.1) und Compiz, aber ein

paar Komponenten von GNOME 3 sind enthalten: Die

Barrierefreiheitstechnologie gnome-orca, der Client für soziale

Netze Gwibber, das Online-Hilfeprogramm Yelp und interessanterweise

auch der Aktivitätsaufzeichnungsdienst Zeitgeist 0.7.1. Mit

Zeitgeist wird eine semantische Suche möglich; wo sie nutzbar ist,

bleibt aber unklar – in die normalen GNOME-Komponenten kann sie

noch nicht integriert sein.

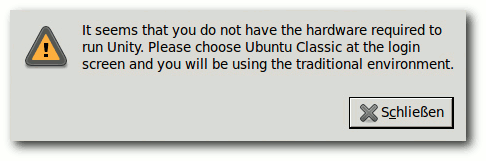

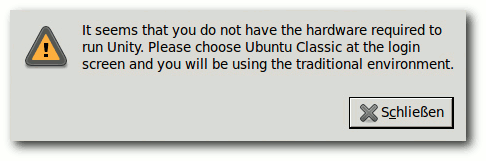

Fehlende Hardware-Voraussetzungen für Unity.

Unity benötigt derzeit 3-D-Beschleunigung in der Hardware, wohl weil

es als Compiz-Plug-in realisiert ist. Wo 3-D nicht verfügbar ist,

wird auf den klassischen GNOME-Desktop umgeschaltet. Dies kann man

auch von Hand einstellen, wenn man Unity nicht verwenden will.

Geplant ist aber, dass Unity künftig auch ohne 3-D auskommen soll.

Dieses „Unity 2-D“ ist jetzt schon auf der ARM-Netbook-Edition von

Ubuntu zu finden und wird wohl in Ubuntu 11.10 Standard. Das

klassische GNOME wird damit entfallen – eine logische Entscheidung,

da GNOME 2.x dann schon alt ist und nicht mehr gewartet wird. Die

Weiterentwicklung von Unity wird also auf GNOME 3 aufsetzen (müssen).

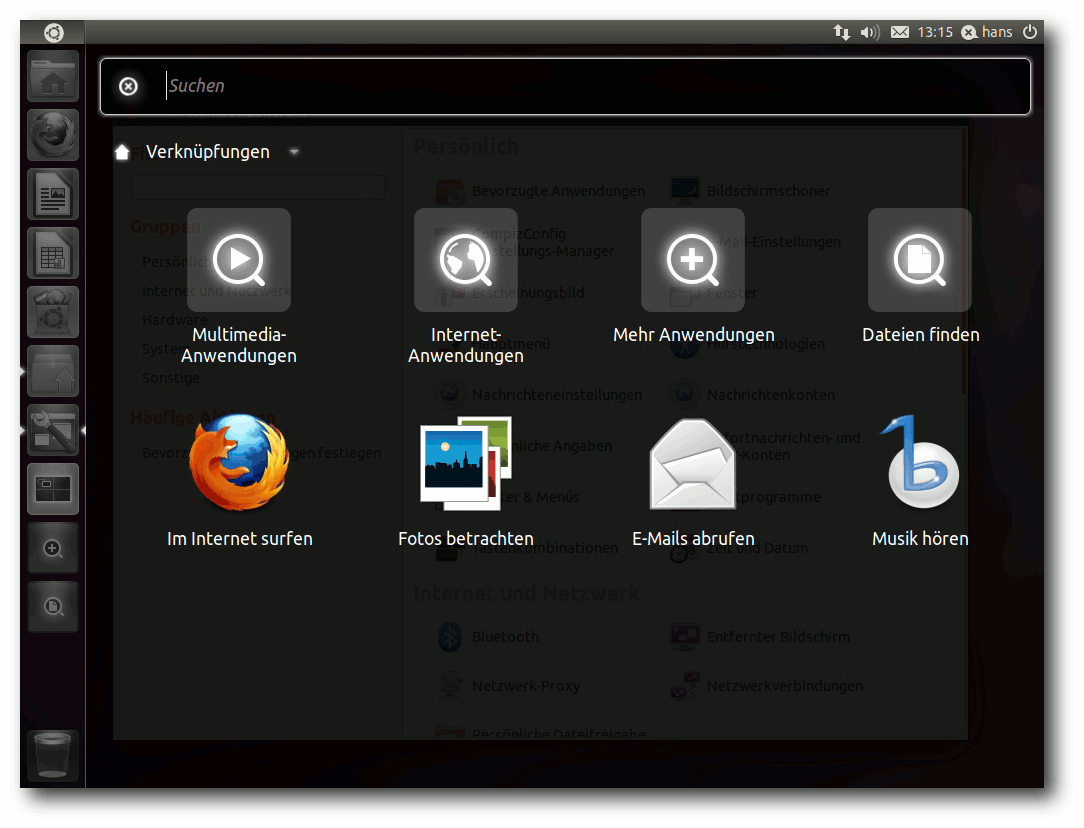

Vorweg sollen zwei wesentliche Komponenten, der Starter und die

Schnellauswahl, erwähnt werden, damit die nachfolgenden

Ausführungen klarer werden. Der markante Starter, der am linken

Bildschirmrand eingeblendet wird, dient hauptsächlich zum schnellen

Starten von Programmen. Durch Klick auf das Ubuntu-Symbol oben wird

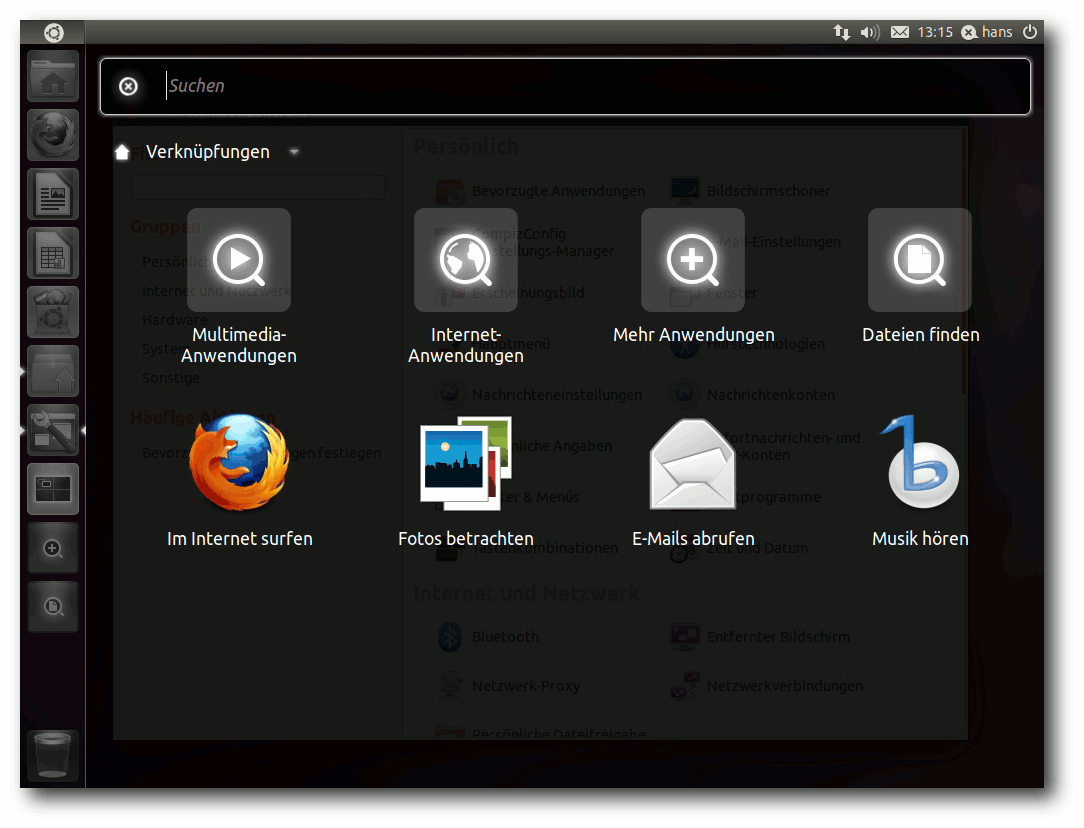

die Schnellauswahl (Dash) gestartet, mit der man nach Anwendungen

suchen oder sich durch Kategorien klicken kann. Bei der Dash

handelt es sich im Prinzip um einen Browser, doch leider kann sie

nicht als solcher bedient werden. So fehlt eine einfache

Möglichkeit, eine Ebene zurück zu gehen und beim Überfahren eines Icons mit dem Mauszeiger wäre es

sinnvoll, Informationen dazu anzuzeigen, so wie es Dateimanager

üblicherweise schon machen. Aber vielleicht kommt das alles noch.

Die Schnellauswahl (Dash).

Um herauszufinden, wie sich Unity anfühlt und warum es kritisiert

wurde, wurde überlegt, welche Aktionen man üblicherweise auf dem

Desktop ausführt, um Anwendungen zu starten oder zu organisieren.

Normalerweise setze ich KDE4 ein und arbeite hauptsächlich in

mehreren Firefox-Fenstern mit einer größeren Anzahl von Tabs, einer

Menge von Konsolen-Fenstern, ebenfalls mit zahlreichen Tabs, und

Editoren. Die meisten Aufgaben sind auf der Kommandozeile weit

schneller als durch Herumklicken auf einer wie auch immer gearteten

Oberfläche zu erledigen, wenn man nur einigermaßen mit den

Kommandos und der Shell vertraut ist. Sicher hat diese Arbeitsweise

dabei aber keine Allgemeingültigkeit.

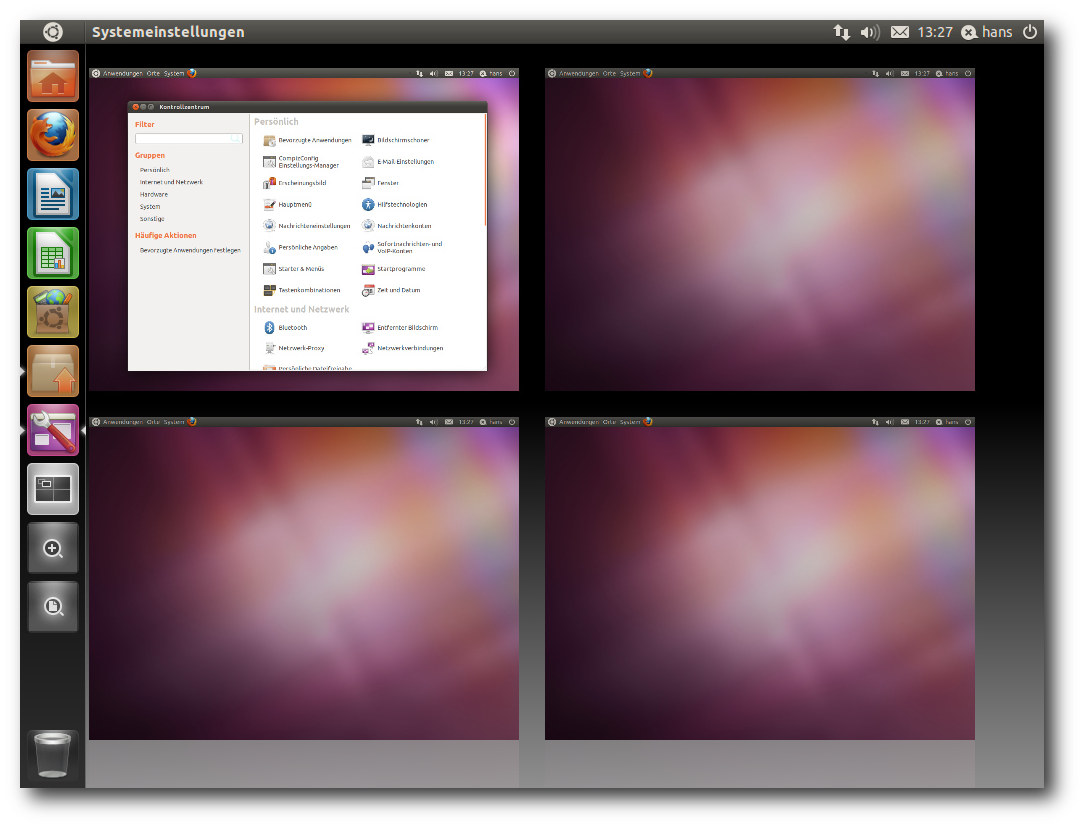

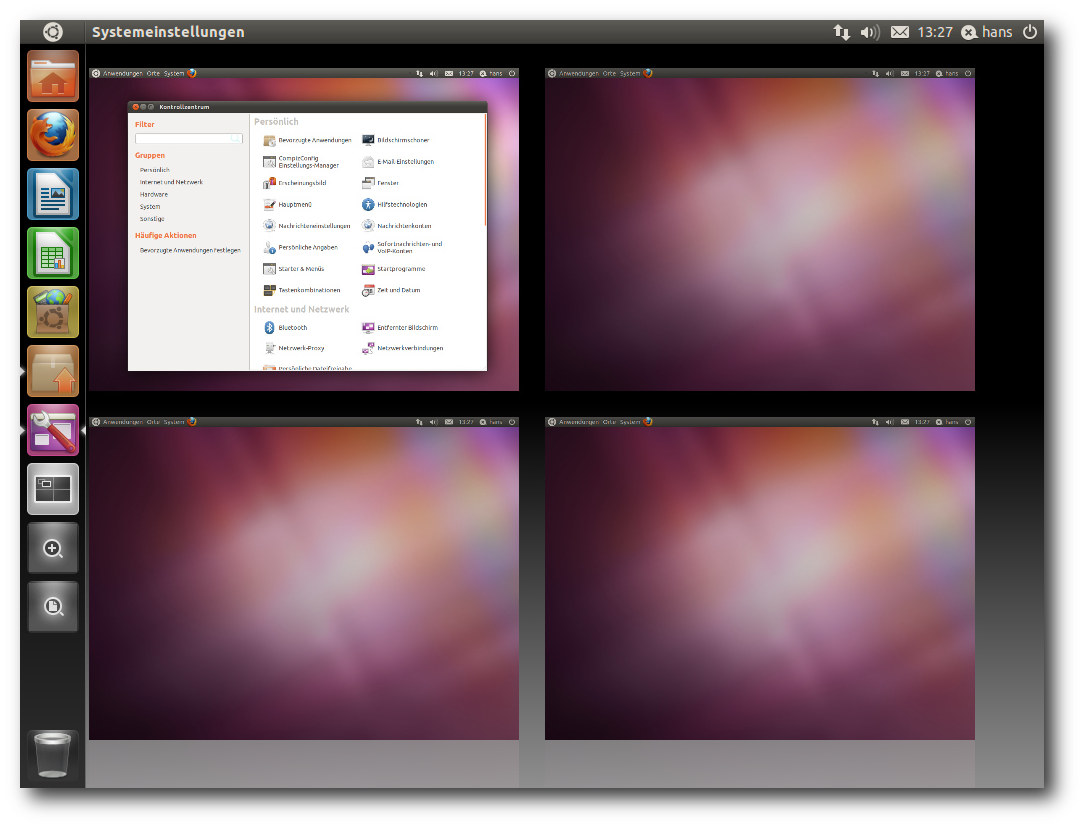

Der Arbeitsflächenumschalter.

Die Fenster werden bei mir in vier virtuellen Desktops organisiert,

sodass das Umschalten zwischen den Arbeitsflächen zu den

häufigsten Tätigkeiten gehört. Zufällig enthält Unity standardmäßig

ebenfalls vier Arbeitsflächen, die allerdings im Quadrat angeordnet

sind. Das

Wechseln zwischen diesen ist über den im Starter

vorhandenen Pager möglich. Klickt man diesen, sieht man die

Arbeitsflächen in einer Übersicht und kann durch Doppelklick zu

einer davon wechseln. Es ist klar, dass das zu umständlich ist.

Glücklicherweise kann man Kurztasten definieren, mit denen man

direkt zu einem der Arbeitsflächen gelangt. Diese wurden auf

auf „Strg“ + „F1“ bis „Strg“ + „F4“ gelegt wie bei KDE. Das Umschalten

mittels dieser Tasten ist dann mit einer kurzen Animation

verbunden. Es wäre sinnvoll, wenn diese Tasten standardmäßig

definiert wären; es gibt zwar zahlreiche vordefinierte Tasten, doch

genau diese fehlten.

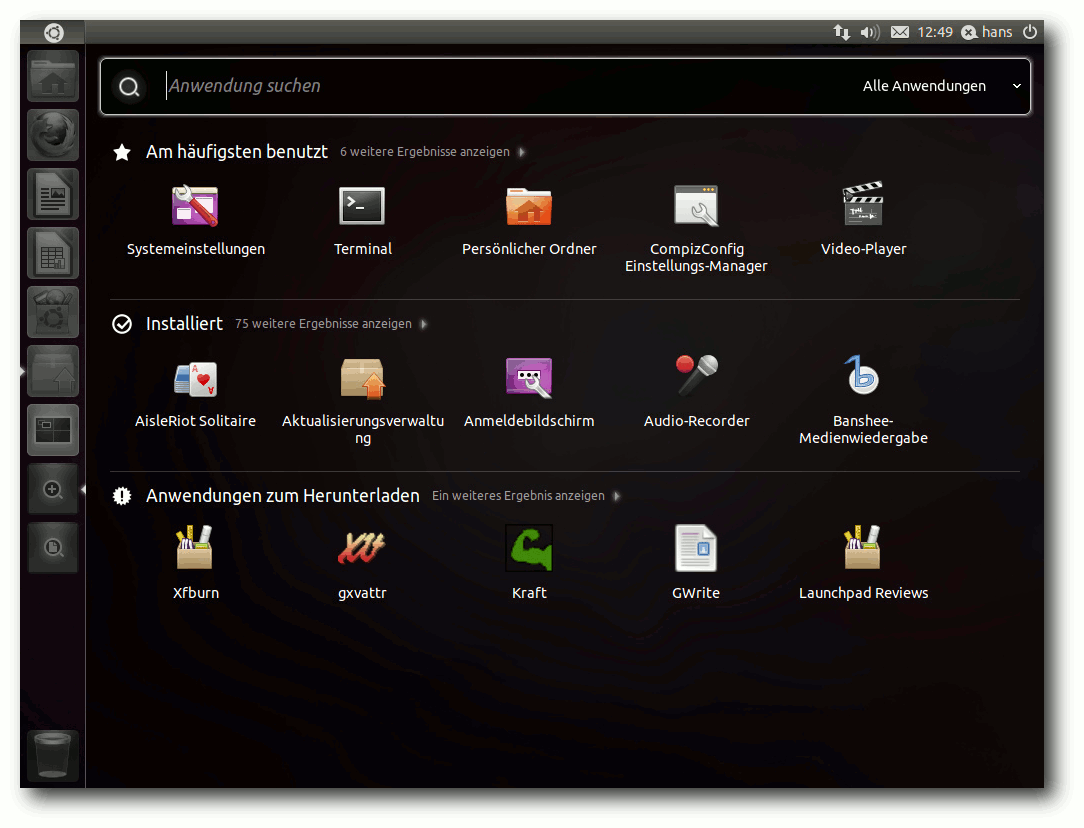

Das Starten von Programmen per Tastatur ist mit „Alt“ + „F2“ möglich. Das

ist die schnellste und oft bevorzugte Methode auch unter KDE.

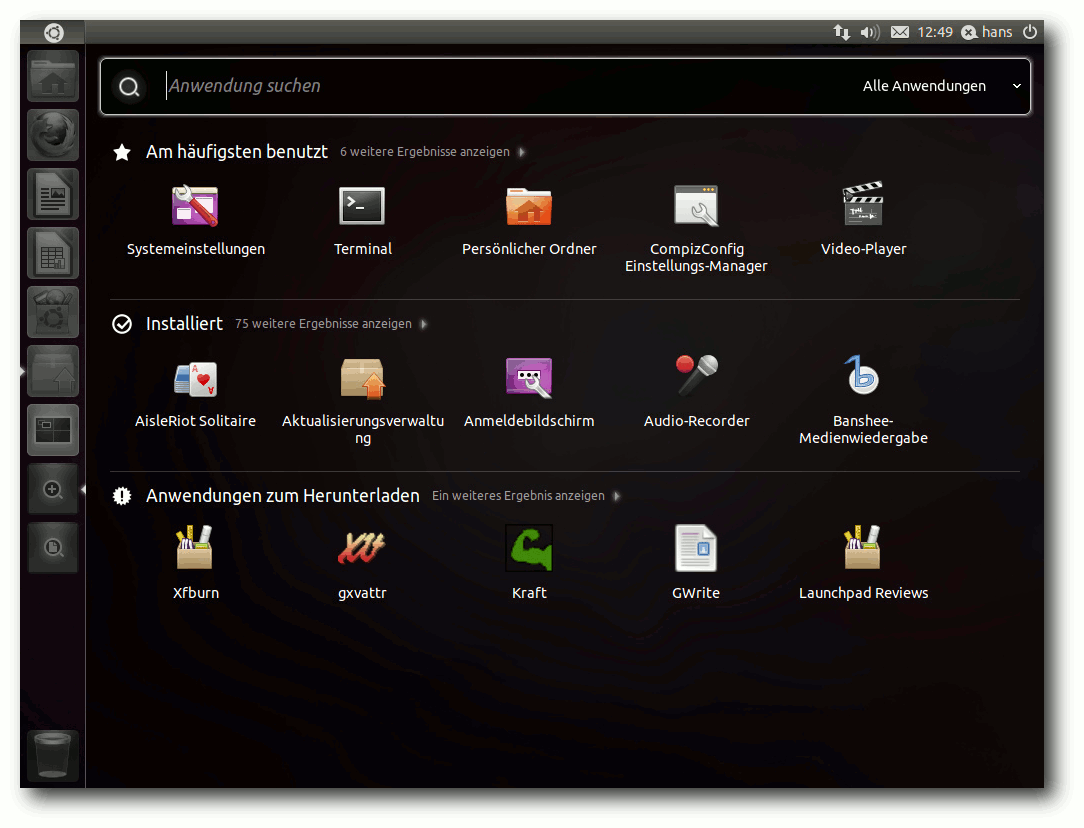

Kennt man den Namen des Programms nicht genau, kann man die

Programmauswahl öffnen, welche installierte Programme anzeigt. Über

das Suchfeld findet man schnell das Gewünschte. Gestartet wird das

Programm dann mit einem Einzelklick. Leider ist das inkonsistent,

da die meisten Aktionen ansonsten einen Doppelklick erfordern, so

wie es üblicherweise in GNOME Classic eingestellt ist.

Nicht nur Programme, sondern auch Ordner, die man dann in Nautilus

öffnet, kann man auf diese Weise suchen. Generell scheint

Unity stark auf das Suchen und weniger auf das Durchstöbern von

Verzeichnishierarchien ausgerichtet zu sein. Dies ist eine durchaus

praktische Neuerung, die wohl durch das Webbrowsen inspiriert wurde

(die meisten Webseiten erreicht man, indem man danach sucht).

Anwendungen lassen sich natürlich auch mit dem Starter starten; sie

lassen sich ebenso aus dem Starter entfernen (durch Rechtsklick aus dem

Kontextmenü oder durch Ziehen auf den Mülleimer), außer dem

Arbeitsflächenumschalter und dem Mülleimer. Das Hinzufügen funktioniert durch

das Ziehen aus dem Dashboard oder indem man eine bereits gestartete

Anwendung, deren Icon im Starter erscheint, per Kontextmenü dort

fixiert.

Die Programmauswahl.

Unity enthält auch Vertrautes: Ein Klick in ein Fenster bringt es in

den Vordergrund; „Alt“ + „Tab“ erlaubt Wechsel zwischen Fenstern,

allerdings zeigt es nicht den Namen der Anwendung an, was das

Finden der richtigen Anwendung schwierig machen kann. Auch

Copy & Paste funktionieren wie erwartet.

Eine weitere, ziemlich kontroverse Neuerung von Unity ist, dass die

Menüleiste von Anwendungen grundsätzlich im Panel am oberen

Bildschirmrand erscheint. Das heißt, immer das Menü der gerade

aktiven Anwendung erscheint dort, die anderen sind nicht sichtbar

und belegen damit keinen Platz. Der Vorteil der Platzersparnis ist

offensichtlich, die große Entfernung zwischen Anwendungsfenster und

Menü, die sich auf großen Bildschirmen ergeben kann, ist allerdings

sicher ein Nachteil. Ändern kann man es leider momentan nicht. Eine

kleine Änderung könnte hier schon einen guten Kompromiss ergeben:

Nur bei maximierten Anwendungen sollte die Menüleiste im Panel

erscheinen. Noch besser wäre es allerdings, dies konfigurierbar zu

machen, wobei eine globale Einstellung noch einmal fensterspezifisch

änderbar sein sollte.

In Kombination mit dem Starter ergibt die Anordnung der

Fensterknöpfe links, die zu den strittigsten Neuerungen in Ubuntu

10.04 LTS gehörte, mehr Sinn, da damit der Weg des Mauszeigers vom

und zum Starter kürzer ist. Ob man sich daran gewöhnen kann oder

will, ist eine andere Frage. Wer es nicht will, kann immer noch ein

anderes Theme auswählen, das die Buttons rechts belässt.

Nicht Unity-spezifisch ist eine weitere Neuerung in Ubuntu 11.04:

GNOME-Programme verwenden nun einen Scrollbalken, der weniger

Platz [7]

benötigt. Effektiv ist der Scrollbalken nur noch durch

eine schmale Linie angedeutet und erst wenn man den Mauszeiger in

dessen Nähe bewegt, wird der eigentliche Scrollbalken eingeblendet,

je nach Platz innerhalb oder außerhalb des Fensters. Das spart

Platz und funktioniert gut. Aber auch das wird nicht jedermanns

Geschmack sein und ist auf großen Bildschirmen eher unnötig. Es

sollte daher eine Option geben, die alten Scrollbalken wieder

herzustellen.

Das wäre schon im Rahmen der Barrierefreiheit

notwendig. Es ist geradezu grotesk, dass man sich auf der einen

Seite der Barrierefreiheit annimmt und dann gleichzeitig ein neues,

für manche Benutzer schwer bedienbares Element einführt, das sich

nicht einmal abschalten lässt. Der neue Scrollbalken ist übrigens

auf reine GTK+-Programme beschränkt und einige Programme, die nicht

in diese Kategorie fallen, z. B. Firefox und Programme, die mit

wxWidgets geschrieben sind, zeigen weiterhin den alten

Scrollbalken. Zudem wurden einige Anwendungen per Schwarzer

Liste [8] von

dem neuen Design ausgeschlossen.

Wenn man eine Anwendung maximiert, blendet sich der Starter aus.

Durch Anfahren des linken Bildschirmrandes wird er wieder

eingeblendet. Das Verschieben von Fenstern auf eine

andere

Arbeitsfläche funktioniert, wie bei KDE, über das Fenstermenü. Die Option

„Fenster aktivieren, wenn sich die Maus darüber befindet“, die es

im GNOME-Kontrollzentrum gibt, sollte man ausgeschaltet lassen, da

sie nicht korrekt mit Unity zusammenarbeitet. So wird, wenn eine

Anwendung maximiert ist, immer deren Menü angezeigt, selbst wenn

eine andere, nicht maximierte Anwendung aktiv ist. Denn die

maximierte Anwendung wird ja aktiv, wenn man mit dem Mauszeiger zur

Menüleiste fährt. Das wäre ein weiteres Argument für den obigen

Vorschlag, das Anwendungsmenü nur bei maximierten Anwendungen im

Panel anzuzeigen.

Hat man viele Anwendungen in den Starter eingetragen oder gestartet,

werden die Icons schräg gestellt (Ziehharmonika-Effekt). Das ist

ein pfiffiger Effekt, aber das Scrollen, das teilweise langsam ist,

wird damit nicht ganz vermieden. Alternativen wären kleinere Icons

oder die Darstellung in zwei oder mehr Spalten. Kleinere Icons

lassen sich über CompizConfig einstellen.

Ein Starter mit vielen Icons.

Damit nun (endlich) zum Thema Konfiguration. Standardmäßig

mitgeliefert wird das GNOME-Kontrollzentrum, dessen Punkte unter

GNOME Classic auch im Menü „System“ zu finden sind. Viele Aspekte,

auch von Unity, sind über CompizConfig änderbar. Ärgerlicherweise

ist dieses Programm aber nicht vorinstalliert. Man sollte es daher

gleich installieren; es verbirgt sich im Software-Center hinter

„Einstellungen für erweiterte Arbeitsoberflächeneffekte (ccsm)“.

Damit lassen sich einige, aber noch nicht alle Aspekte von Unity

anpassen. Beispielsweise muss man den Starter auf der linken

Bildschirmseite belassen.

Kritik von Michael Kofler

Im Artikel von Michael Kofler [6]

wurden eine Reihe von Dingen an Unity kritisiert. Die genannte

„übertriebene Platzoptimierung“ kann man durchaus nachvollziehen,

wenn man z. B. das Erscheinen des Menüs von Anwendungen im globalen

Panel betrachtet. Wie schon geschrieben, wäre es optimal, wenn das

Menü nur bei den maximierten Anwendungen ins Panel gesetzt werden

würde. Das genaue Verhalten sollte über Optionen fein

einstellbar sein.

Das „Zielgruppenproblem“ sehe ich weniger. Ubuntu richtet sich, auch

nach den jüngsten Äußerungen von Marketing Manager Gerry

Carr [9],

immer noch überwiegend an Umsteigewillige aus dem Windows-Lager.

Damit ist die Aussage von Herrn Kofler entkräftet. Natürlich nutzen

auch viele andere Anwender Ubuntu, wie Herr Kofler bestätigt; das

eine schließt das andere nicht aus, zumal es für die meisten

Benutzer keinen Grund gibt, von Ubuntu weg zu wechseln.

Es folgt ein Blick auf die konkret aufgeführten Kritikpunkte von

Michael Kofler:

- „Das Unity-Dock befindet sich am linken Bildschirmrand. Wer das

Dock lieber rechts, unten oder oben hätte – Pech gehabt.“

Korrekt, aber zumindest ist derzeit eine Konfigurationsmöglichkeit

vorgesehen, nur funktioniert sie nicht.

- „Die Größe der Icons ist fix vorgegeben (kann mit CCSM verändert

werden).“

Da sie geändert werden kann, existiert das Problem gar nicht.

- „Fenster sind von Schatten umgeben. Das sieht gut aus – es sei

denn, man will Screenshots erstellen. Früher ließ sich der Schatten

mit dem CCSM einstellen – jetzt nicht mehr (siehe Launchpad).

(Abhilfe: Erstellen Sie Ihre Screenshots mit Shutter!)“

Der Schatten lässt sich sehr wohl einstellen. Leider fehlt ein

einfacher Ein-/Aus-Schalter. Mit den vorhandenen Einstellungen kann

man aber den Schatten unsichtbar machen.

- „Im Launcher (also im Startmenü) befinden sich außer dem Suchmenü

gerade einmal acht Icons (auch wenn der Bildschirm 1920×1600 Pixel

groß ist). Die Icons sind fix vorkonfiguriert. Die Folge: Ich

arbeite mittlerweile vollkommen ohne Startmenü. Häufig benötigte

Programme sind im Dock, den Rest starte ich mit „Alt“ + „F2“.“

Bis auf die Anwendungs- und Ordnerauswahl und den Mülleimer lassen

sich alle Icons austauschen.

- „Unter Unity gibt es ein Zentralmenü im Panel (nicht mehr in der

Leiste des jeweiligen Fensters). Auf kleinen Bildschirmen spart das

Platz, auf großen Bildschirmen macht es die Bedienung des Menüs

aber extrem umständlich. Auch hier keine Wahlmöglichkeit.“

Sehe ich genauso, wie oben schon erläutert.

- „Der Arbeitsflächenumschalter ist fixer Bestandteil des Docks – ganz

egal, ob man Arbeitsflächen verwenden möchten oder nicht. (Und

gerade Einsteiger, für die Unity ja anscheinend konzipiert wurde,

werden Arbeitsflächen anfänglich wohl eher nicht brauchen.)“

Das ist zum einen Ansichtssache; Ubuntu ist der Ansicht, dass seine

Zielgruppe – die Windows-Umsteiger – mehrere Arbeitsflächen

verwenden möchten. Außerdem verschwindet der

Arbeitsflächen-Umschalter nach einem Neustart, wenn man über die

Compiz-Einstellungen die virtuelle Größe des Desktops auf 1x1

gesetzt hat.

Den Kritikpunkten von Herrn Kofler kann ich mich insgesamt

anschließen. Allerdings hat er eine Betaversion getestet. In

der offiziellen Version wurden offensichtlich eine Menge Probleme

behoben, so dass aus obiger Liste nicht mehr viel übrig bleibt.

Als vorläufiges Fazit kann man festhalten: Unity enthält gute Ideen

und ist keinesfalls unbenutzbar – auch auf großen Bildschirmen

nicht. Mit mehr Optionen wäre es aber wesentlich besser. Die

Schlussfolgerung ist für mich aber eine andere als für Herrn

Kofler. Wer Verbesserungen in Unity sehen will, sollte darauf

drängen, dass sie auch passieren, selbst Patches schreiben oder das

Projekt forken. Fürs Erste kann man, wenn man von Unity genervt

ist, auf GNOME Classic umschalten. In der nächsten Ubuntu-Version

sollte man Unity aber auf jeden Fall eine erneute Chance geben.

GNOME-Desktop

Wenn man Unity und die Scrollbalken ausnimmt, bringt erstmals seit

Bestehen von Ubuntu eine neue Version keine wesentlichen Änderungen

im GNOME-Desktop, denn die GNOME-Version blieb 2.32 (genaugenommen

2.32.1). Im Umfeld gab es dennoch, wie nach den turbulenten

Entwicklungen der letzten sechs Monate zu erwarten war, zahlreiche

Änderungen.

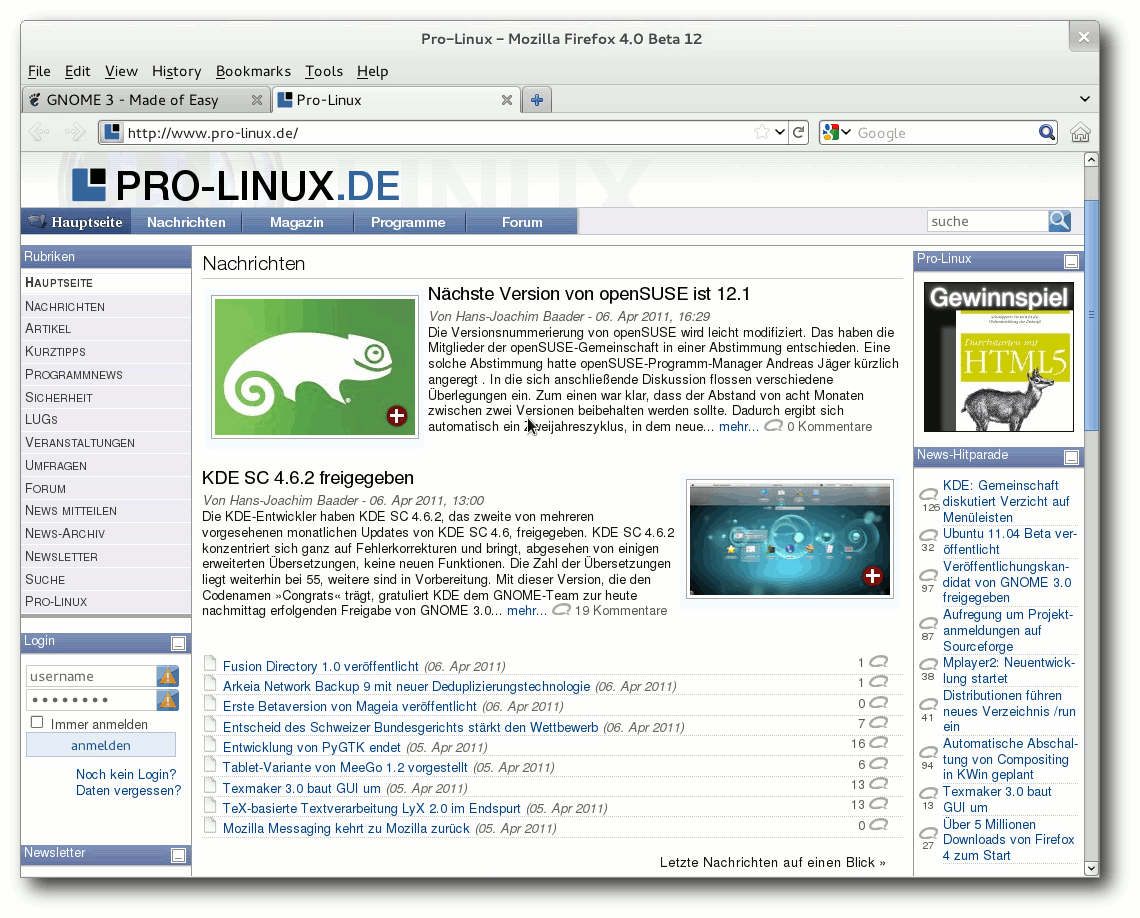

Als Webbrowser wird jetzt Firefox 4 eingesetzt. Das

Standard-Office-Paket änderte sich zu LibreOffice 3.3.2.

Banshee 2.0.0 wurde der Standard-Musik-Player anstelle von

Rhythmbox. Der X-Server 1.10.1 und Mesa 7.10.2 bilden die Basis für

die grafische Oberfläche einschließlich der 3-D-Beschleunigung.

Der Online-Dienst Ubuntu One ermöglicht über sein Steuerfeld jetzt

das selektive Synchronisieren und die Synchronisation von Dateien

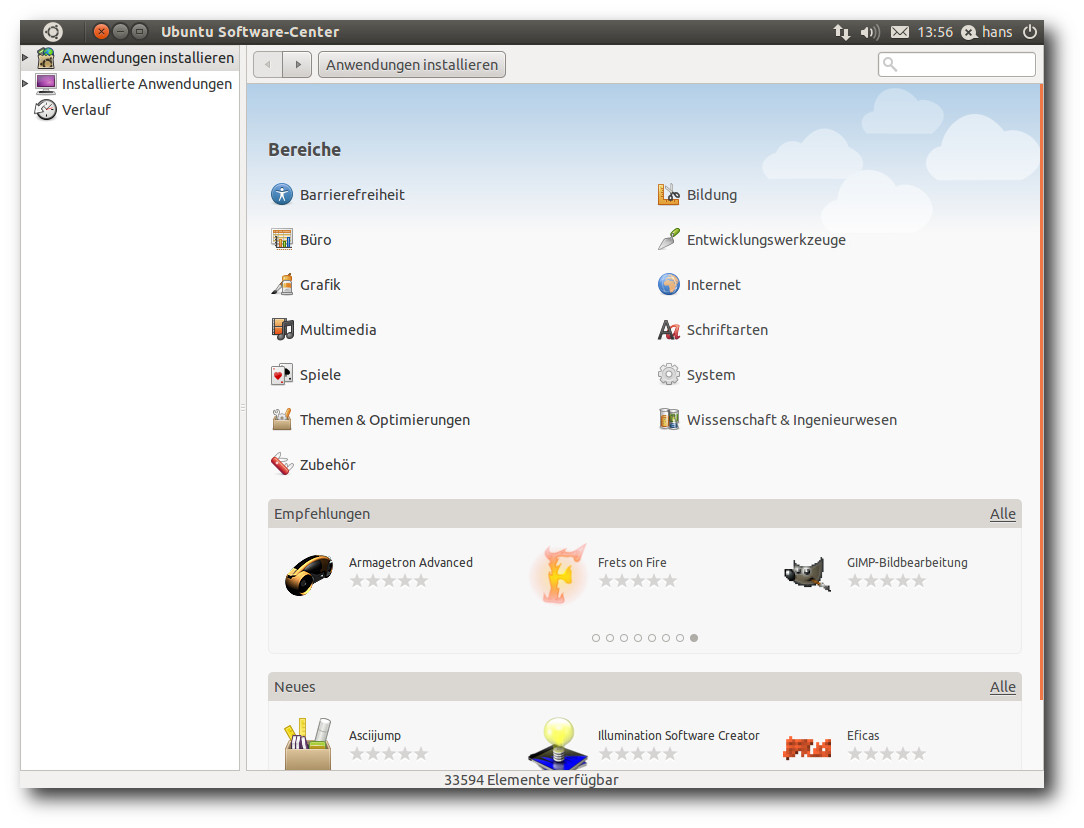

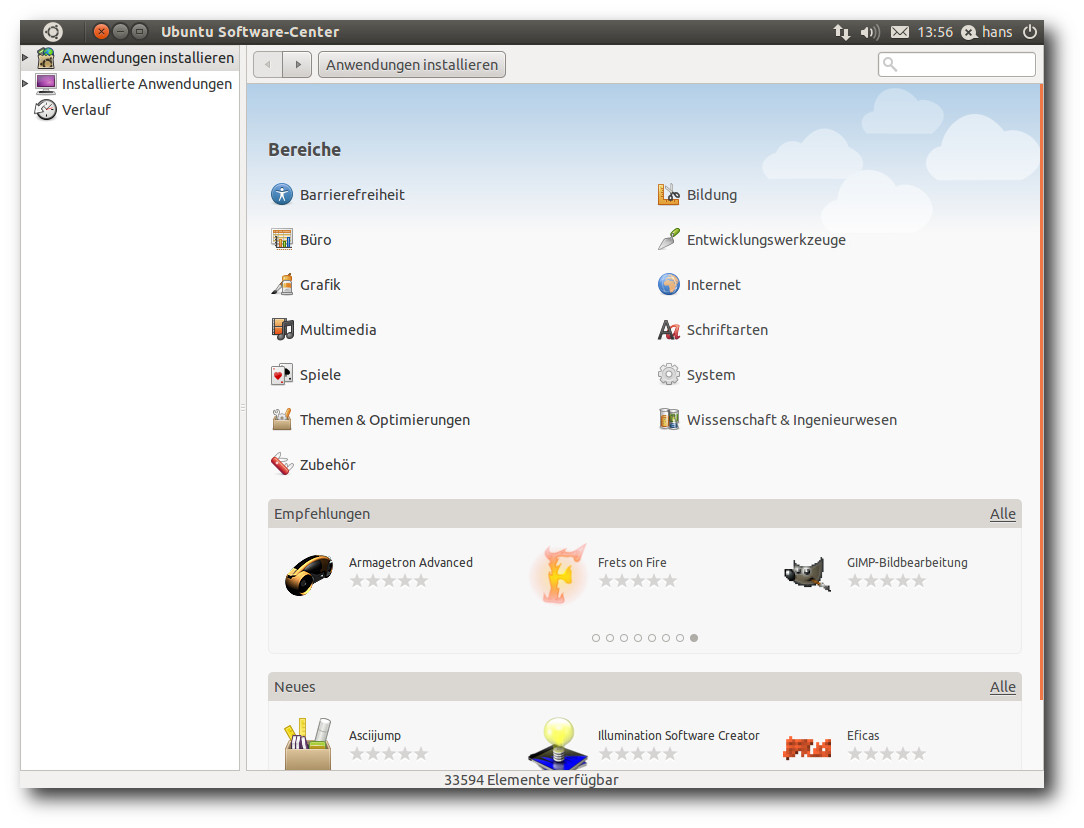

soll schneller vonstatten gehen. Das Software Center ermöglicht es

nun, installierte Anwendungen zu bewerten, auch in Form von

Anmerkungen, und hat weitere Verbesserungen in der Benutzbarkeit

erhalten. Bewertungen zu einem Paket kann man nur abgeben, wenn man

es installiert hat.

Ubuntu Software Center mit Bewertungen, Empfehlungen und Neuheiten.

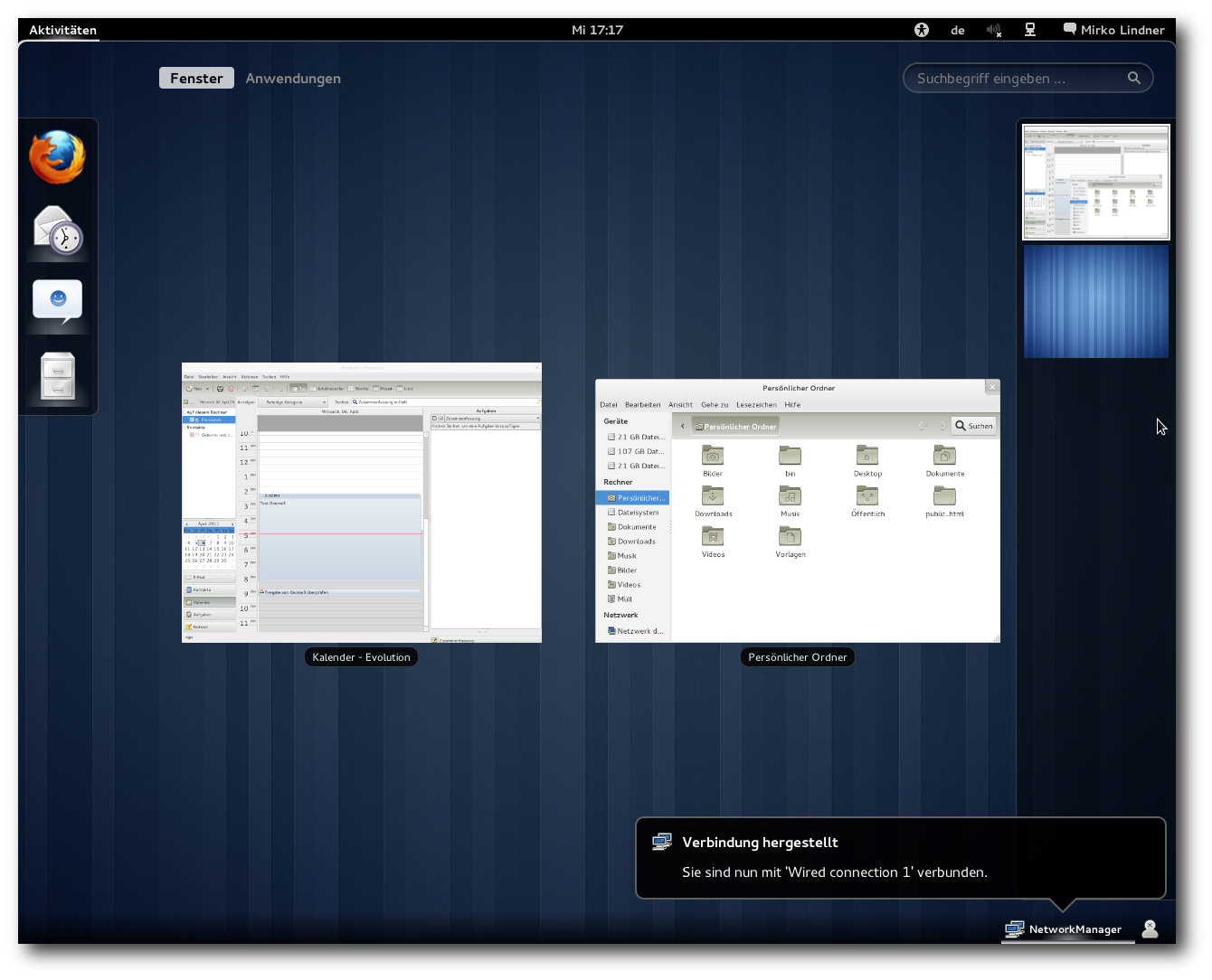

KDE-Desktop

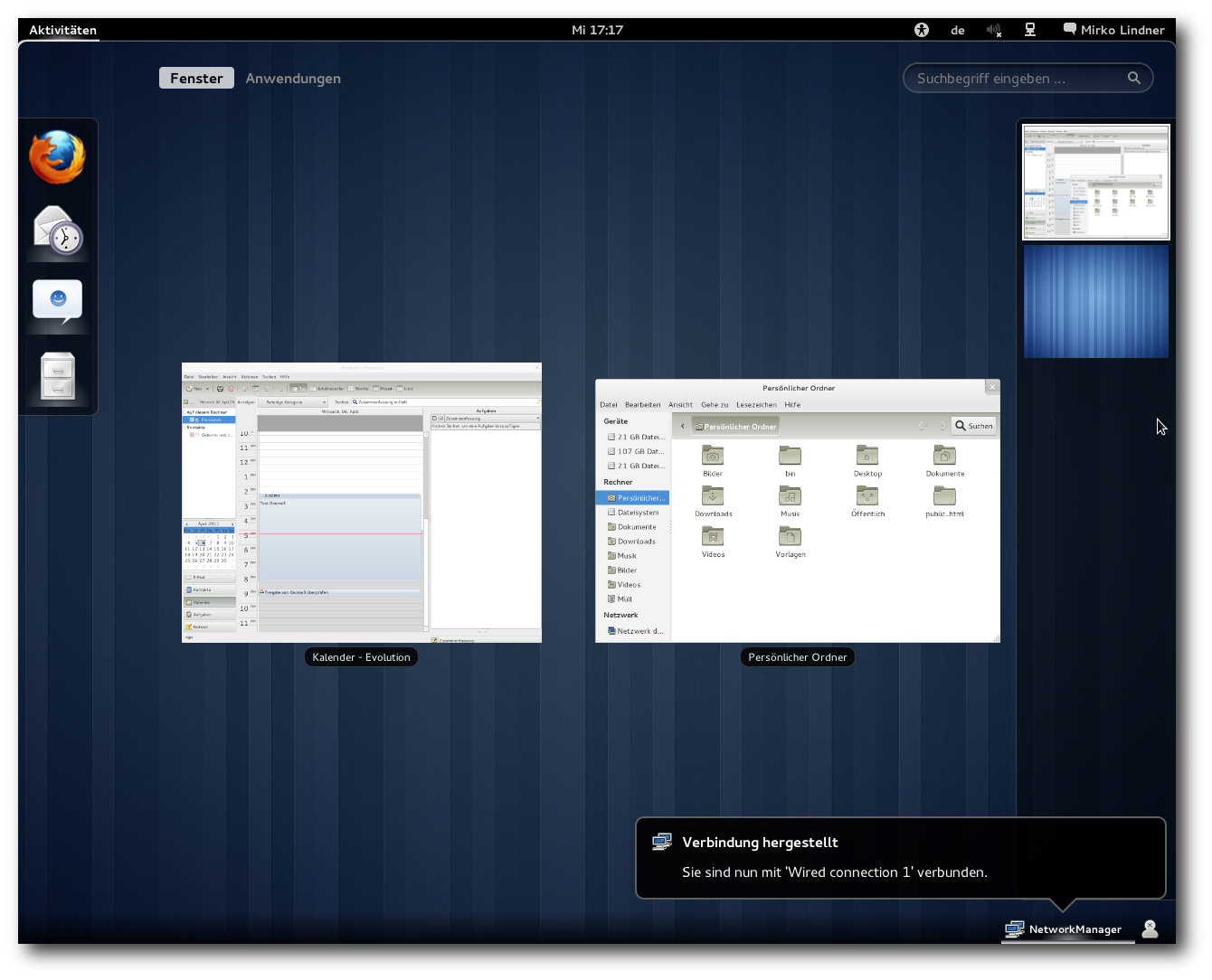

Kubuntu [10] nutzt KDE SC

4.6.2, das unter anderem ein Neudesign der Aktivitäten bringt.

Man kann nun Anwendungen und Dateien einer Aktivität zuordnen.

Wechselt man zu einer bestimmten Aktivität, sieht man nur noch

deren zugehörige Anwendungen. Das Konfigurieren von Aktivitäten

verursacht zunächst etwas Rätselraten, bis man darauf kommt, dass

bestimmte Stellen des Symbols anklickbar sind. Das könnte ein

Hinweis sein, dass das Ganze intuitiver zu bedienen ist, als man im

ersten Moment denkt.

Die Energieverwaltung wurde neu geschrieben und kann nun mit Plug-ins

erweitert werden. Mit dem neuen Richtlinien-Agenten kann man

Energieprofile definieren, die festlegen, wann Energiesparfeatures

aktiv sein sollen und wann nicht.

Der Window- und Compositing-Manager KWin wurde optimiert und kann

jetzt mehr Funktionalität der Grafiktreiber nutzen.

Benachrichtigungen von Programmen, die bisher bei der Taskleiste

eingeblendet wurden, können an eine beliebige Stelle verschoben

werden. GTK-Anwendungen passen sich optisch dank eines neu geschriebenen

Oxygen-GTK-Themes noch besser in die KDE-Umgebung ein.

Kubuntu bringt neu ein Modul zur Verwaltung von Samba-Shares

direkt aus dem Eigenschaftenmenü von Dolphin

und ein neues Sprachauswahl-Modul mit.

Die Druckerverwaltung wurde ebenfalls verbessert.

Definition von Aktivitäten in KDE.

Als Webbrowser kommt weiterhin rekonq zum Einsatz, jetzt in Version

0.7.0. Das Programm erinnert mit seinem auf einen einzelnen Button

reduzierten Menü entschieden an Chrome.

Mein „Lieblings“-Themenblock, um darauf einzuhacken, war in den letzten

Versionen stets KPackageKit. Das ist nun vorbei. In der neuesten

Version wurde eine Repository-Verwaltung hinzugefügt, sodass nun

alles, was man für die Paketverwaltung und Updates benötigt,

vorhanden ist. Zwar hätte man die Oberfläche, wie schon mehrfach

angemerkt, platzsparender gestalten können und möglicherweise ist

die Suchfunktion noch nicht ganz intuitiv, aber das Programm

versieht seinen Dienst einwandfrei.

Ansonsten bringt KDE ein neues Standard-Hintergrundbild mit. Die

Icons aus der letzten Version wurden beibehalten, was

Geschmackssache ist. Viele KDE-Anwendungen wurden natürlich auch

stark verbessert. Insgesamt hinterlässt KDE einen exzellenten

Eindruck.

Multimedia im Browser und auf dem Desktop

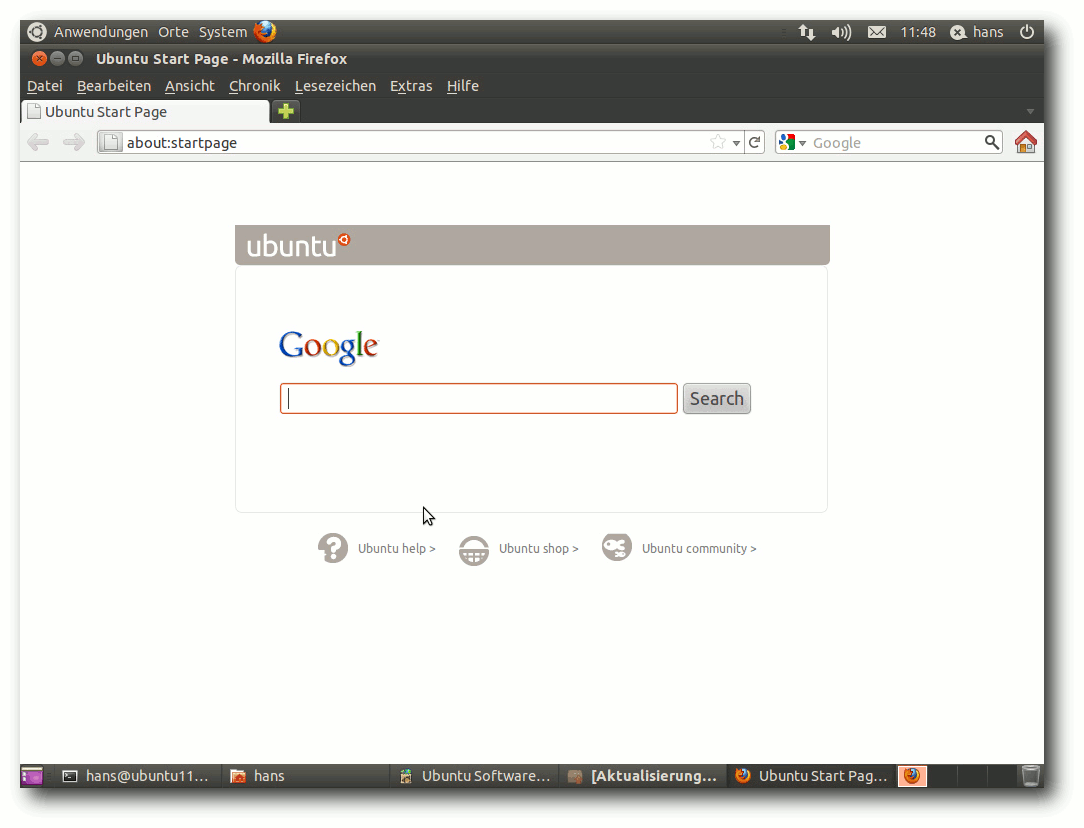

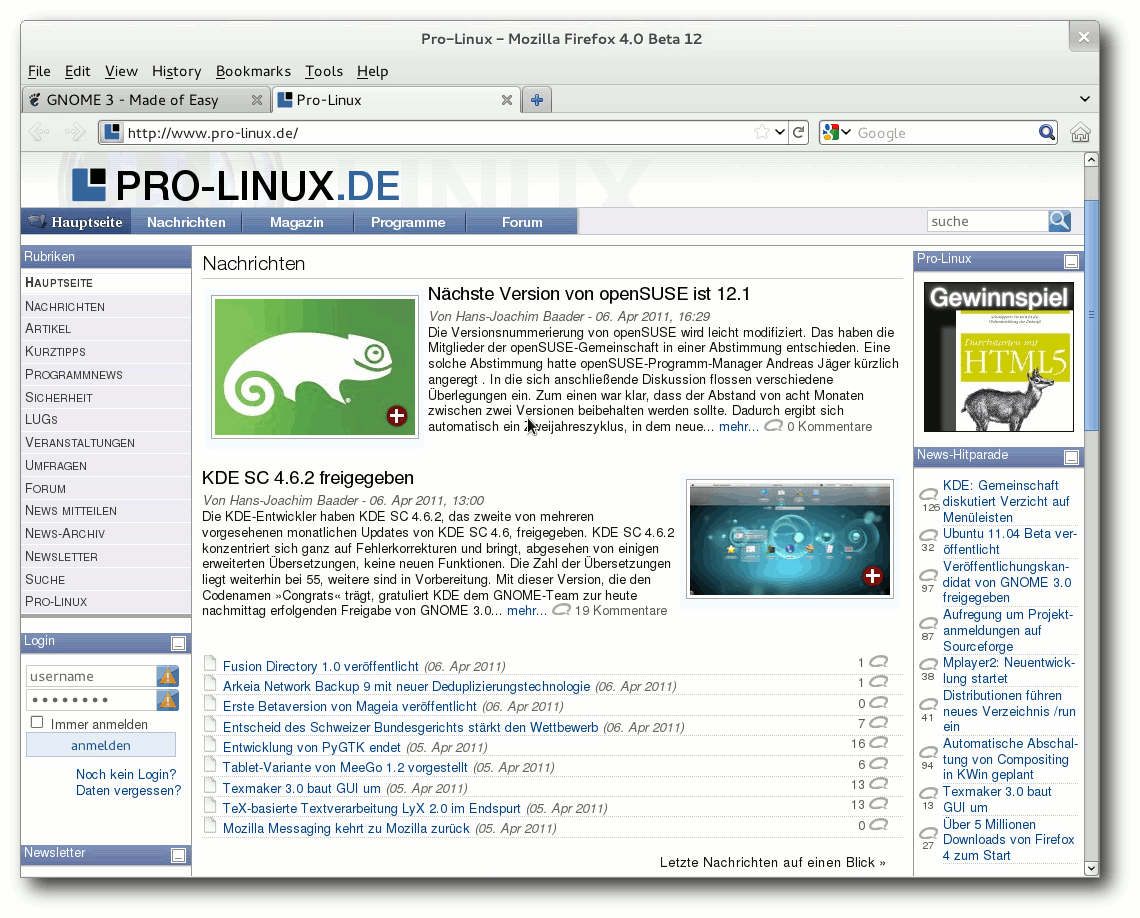

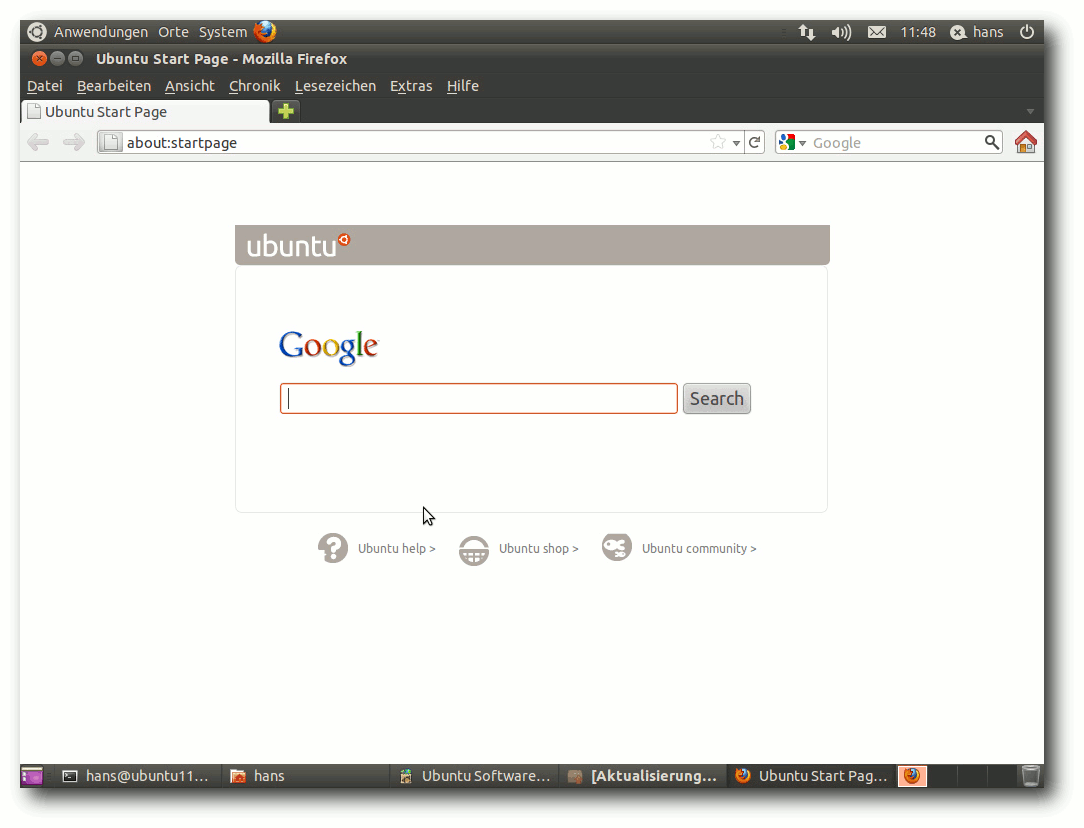

Firefox, jetzt in Version 4, bringt als eine große Neuerung

Unterstützung für WebM mit. Zahlreiche weitere Plug-ins zum

Abspielen von Videos in freien Formaten sind vorinstalliert.

Die vorinstallierte Erweiterung Ubuntu Firefox Modifications hat

Version 0.9 erreicht. Darin ist der bereits bekannte

Plug-in-Finder-Service enthalten. Will man beispielsweise ein Video

in einer Webseite abspielen, lassen sich komfortabel passende

Plug-ins finden und installieren. Das funktionierte im Test nicht

immer; wenn der Bildschirm schwarz blieb, konnte man aber die

Option „Im Video-Abspieler öffnen“ wählen. Dieser meldete dann, dass

ein Plug-in fehlte und bot eine Suche danach an. Ein passendes

Plug-in konnte dennoch nicht gefunden werden.

Startseite von Firefox.

Flash ist wiederum ein anderes Thema. In der 64-Bit-Version ist

klar, dass das Adobe-Flash-Plug-in nicht zur Verfügung steht. Warum

Ubuntu hier aber nicht das Gnash-Plug-in anbietet oder

vorinstalliert, ist rätselhaft, denn es funktioniert mit den

meisten Flash-Videos gut. So muss man es manuell aus dem Paket

browser-plugin-gnash installieren.

In den bekannten Anwendungen Banshee und Totem ließen sich

GStreamer-Plug-ins, die die standardmäßig nicht unterstützbaren

Formate kennen, wie gewohnt problemlos installieren. Fast jedes

Audio- und Video-Format ließ sich damit abspielen.

Unter KDE ist Amarok, jetzt in Version 2.4.0, der

Standard-Audioplayer. Anders als in der letzten Version lassen sich

MP3-Dateien nicht ohne Weiteres abspielen. Der Grund dafür ist der

Wechsel des KDE-Multimedia-Systems zu GStreamer als Phonon-Backend.

Amarok erkennt aber, dass ein Plug-in fehlt, startet die

Paketverwaltung, um danach zu suchen, und kann die benötigten

Module erfolgreich installieren.

Der Standard-Videoplayer ist Dragonplayer. Nachdem die

GStreamer-Module bereits durch Amarok installiert wurden, ließ sich

in dem Player alles abspielen, bis auf Flash-Videos. Die Ursache

konnte bisher nicht ermittelt werden, Gnash war jedenfalls

installiert. Im Dateimanager Dolphin fehlt weiterhin eine

Dateizuordnung von Dateien mit dem Suffix .flv. Insgesamt ist die

Multimedia-Integration sowohl in GNOME/Unity als auch in KDE recht

problemlos, aber Verbesserungen wären immer noch möglich.

Fazit

Ubuntu ist, wie es ist. Es besitzt Stärken und Schwächen, daran wird

sich auch nichts ändern. Auch Ubuntu 11.04 ist wieder eine sehr

solide Distribution. Lediglich ein größeres Problem ließ sich

finden, die Partitionierung als Btrfs-Partition. Für alle anderen

Dinge, die einen stören könnten, gibt es entweder Workarounds oder

es sind Kinderkrankheiten, die in den nächsten Wochen durch Updates

beseitigt werden. Wer sicher gehen will, sollte mit der

Installation einfach noch einige Wochen warten.

Unity wird ein ganz großer Wurf – wenn es einmal fertig ist. Das ist

in der aktuellen Version klar nicht der Fall. Unity in Ubuntu 11.04

ist ein Experiment, aber ein durchaus gelungenes, wenn man von

fehlenden Konfigurationsmöglichkeiten absieht. In der kommenden

Version könnte das ganz anders aussehen, denn dann wird Unity GNOME

2 als Basis verlassen und auf GNOME 3 portiert. Damit wird wohl

auch Compiz entfallen, außerdem wird Unity auch ohne

3-D-Beschleunigung funktionieren. Und wer weiß, vielleicht wird es

bereits eine erste Version von Wayland als Ersatz für X11 geben.

Einen Vergleich zu GNOME 3 kann noch nicht gezogen werden,

hierzu muss man erst das Ergebnis von Fedora 15 abwarten.

KDE galt lange als ziemlich vernachlässigt und Kubuntu nicht gerade

als erste Wahl für KDE-Anwender. Mittlerweile hat sich das

gewandelt. Natürlich wurde das Software Center nicht für KDE

entwickelt, aber wer möchte, kann es dennoch nutzen. Ob und wie

sich Ubuntu One unter KDE nutzen lässt, ist nicht bekannt.

Ubuntu will bekanntlich in erster Linie umstiegswillige

Windows-Anwender ansprechen. Das wird immer noch gerne mit

unerfahrenen Anwendern gleichgesetzt, doch davon kann keine Rede

sein. Ubuntu kann genauso auch von erfahrenen Linux-Anwendern

genutzt werden. Sowohl Ubuntu als auch Kubuntu sind in dieser

Version besonders gelungen und lassen für die Zukunft noch viel

Gutes erwarten.

Links

[1] http://www.pro-linux.de/artikel/2/1506/ubuntu-1104.html

[2] http://www.freiesmagazin.de/freiesMagazin-2010-11

[3] https://wiki.ubuntu.com/NattyNarwhal/ReleaseNotes

[4] http://www.freiesmagazin.de/freiesMagazin-2011-05

[5] http://www.pro-linux.de/news/1/16923/unity-in-ubuntu-stabilisiert-sich.html

[6] http://www.pro-linux.de/artikel/2/1504/unity-der-anfang-vom-ende-fuer-ubuntu.html

[7] http://www.pro-linux.de/news/1/16790/neues-scrollbar-design-fuer-ubuntu.html

[8] https://wiki.ubuntu.com/Ayatana/ScrollBars#Blacklist

[9] http://www.netzwelt.de/news/86520-gerry-carr-ubuntu-interview-konnten-gnome-3-warten.html

[10] http://kubuntu.org/news/11.04-release

| Autoreninformation |

| Hans-Joachim Baader (Webseite)

befasst sich seit 1993 mit Linux. 1994 schloss

er sein Informatikstudium erfolgreich ab, machte die

Softwareentwicklung zum Beruf und ist einer der Betreiber

von Pro-Linux.de.

|

| |

Diesen Artikel kommentieren

Zum Index

von Mirko Lindner

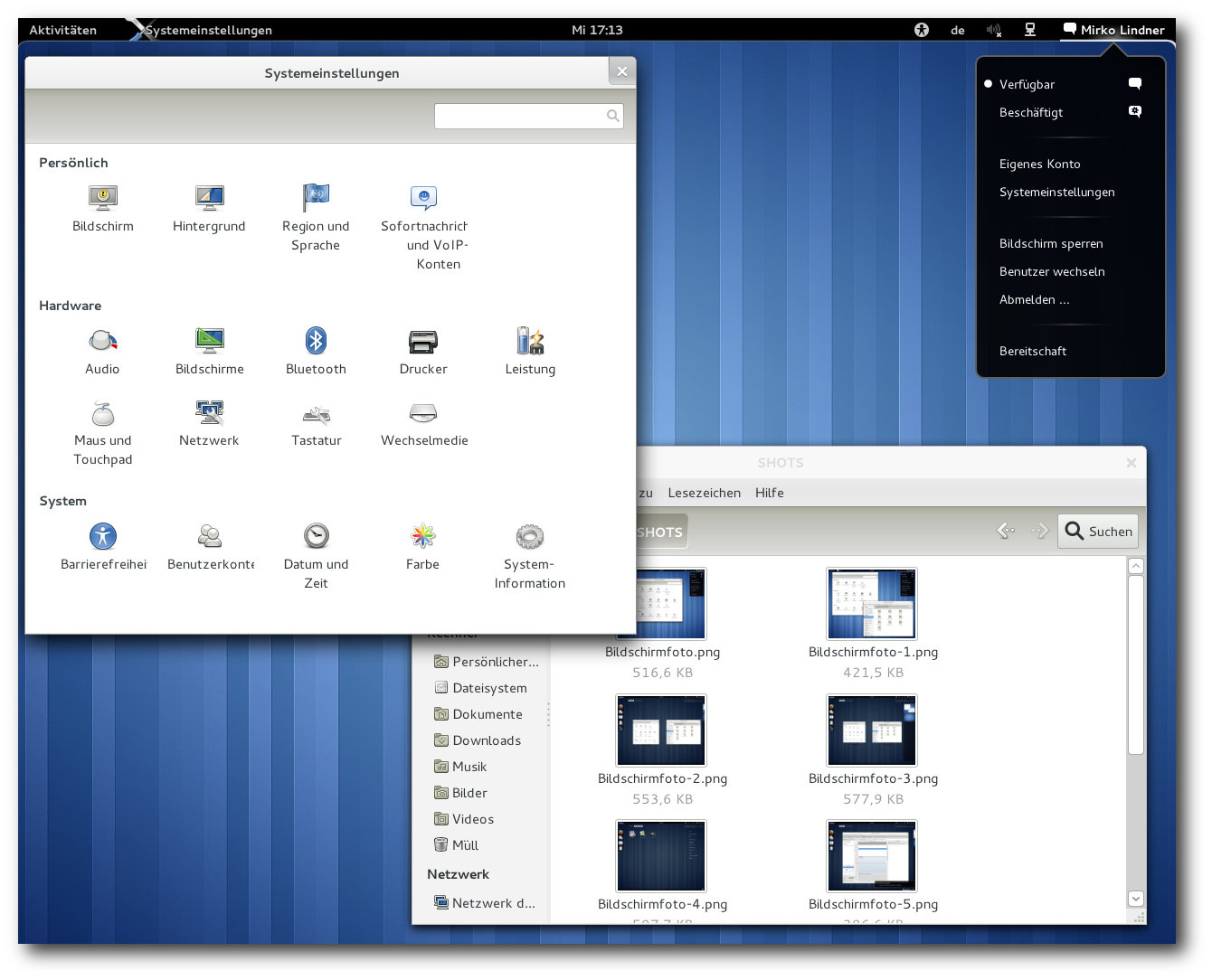

Mit der Freigabe von GNOME 3 bricht der Entwicklerkreis rund um die

Desktopumgebung mit vielen gängigen Paradigmen der Benutzerführung

und präsentiert ein weitgehend überarbeitetes Produkt, das

zahlreiche Neuerungen mit sich bringt. Drei wesentliche Punkte sind in

die neue Generation der Umgebung eingegangen: eine Erneuerung der

Oberfläche, Entfernung von unnötigen Komponenten und eine bessere

Außendarstellung.

Redaktioneller Hinweis: Der Artikel „GNOME 3.0: Bruch mit Paradigmen“ erschien

erstmals bei Pro-Linux [1].

Die Vergangenheit …

Die Desktopumgebung GNOME [2] glänzte in den

letzten Jahren nicht unbedingt durch radikale Änderungen und

Konzepte, die sich jenseits vom Altbewährten bewegten. Die

Oberfläche von GNOME wurde zwar sukzessive poliert und durch neue

Funktionen erweitert, einen Bruch mit Altbewährtem schaffte sie

trotzdem nicht. Die zentralen Komponenten der Umgebung datieren auf

den Anfang des Jahrhunderts, als mit GNOME 2 Schluss mit den

bestehenden Strukturen war.

Einen der Gründe für die Beständigkeit stellte GTK+ dar. Das Toolkit

bildet die Basis der grafischen Oberflächen von GNOME und vielen

weiteren Programmen. Trotz

einiger recht einschneidender Änderungen

wurde die Programmierschnittstelle seit der Version 2.0 kompatibel

gehalten, so dass ältere Programme quellcode- oder gar

binärkompatibel bleiben. Es erklangen allerdings zunehmend

Stimmen [3],

wonach die

Funktionalität von GTK+ nicht mehr für künftige

Entwicklungen ausreiche und das Team sich einer neuen Generation des

Toolkits widmen solle. Mit der Entscheidung, GTK+ radikal zu

erneuern,

wurde auch der Weg zu GNOME 3 geebnet. Herausgekommen ist

dabei eine Umgebung, die viele bekannte Strukturen begräbt und die

Anwender durch neue Konzepte zu überzeugen versucht.

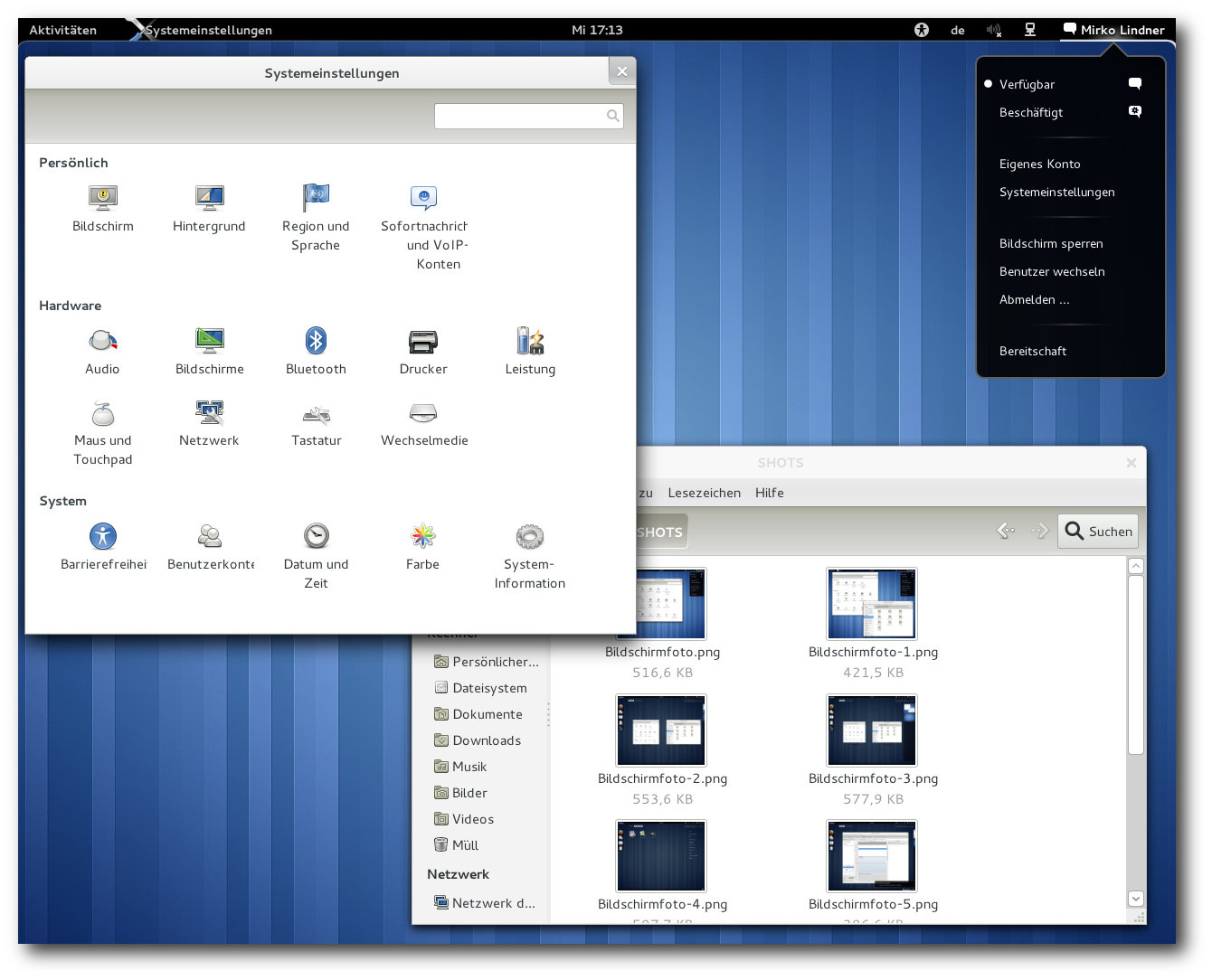

Der Standarddesktop von GNOME 3.0 mit eingeblendeten Optionen für Barrierefreiheit.

… und die Zukunft

Mit der Freigabe von GNOME 3 verabschiedet sich die Umgebung von

vielen bekannten

Einrichtungen und präsentiert ein weitgehend neues

Arbeitsgefühl. Die Hauptkomponente der aktuellen Generation der

Umgebung stellt dabei die GNOME Shell [4]

dar. Diese fungiert als zentrale Stelle und ersetzt nicht nur das

bisherige Panel, sondern auch zahlreiche weitere Einrichtungen. Der

ganz in Schwarz gehaltene Bereich der GNOME Shell gliedert sich

dabei in drei verschiedene Bereiche.

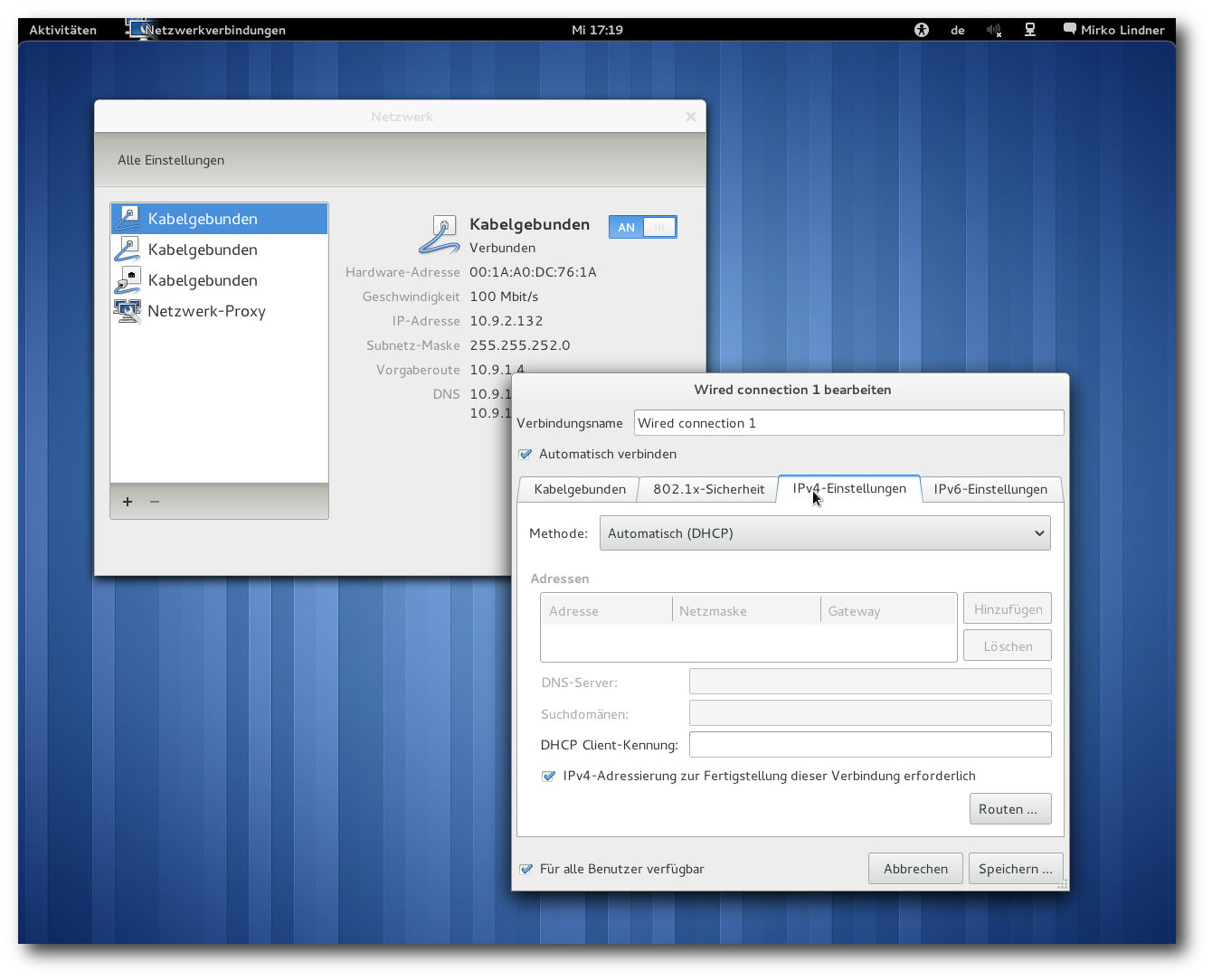

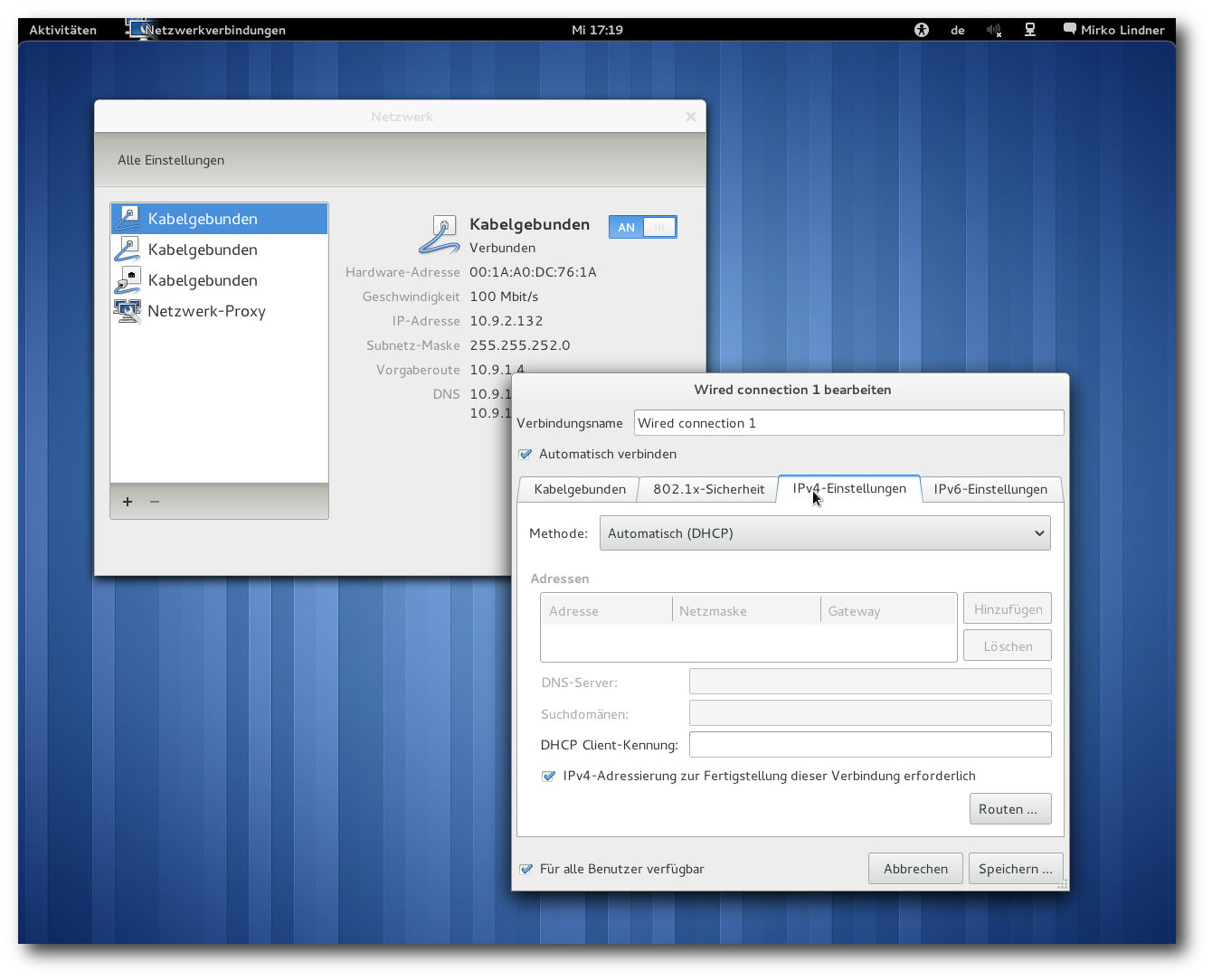

Ganz rechts ist der Systembereich zu finden, unter dem die

Standardkomponenten zur Steuerung der Lautstärke, des Netzwerks

und der Barrierefreiheit sowie der Strom- und

Batteriestatus eingegliedert

wurden. Zudem beinhaltet der Bereich das Benutzermenü, das einen

Zugriff auf das Kontrollzentrum, die Konteneinstellungen oder die

Benutzersteuerung ermöglicht. Zudem kann hier der Anwender seinen

Status setzen und sich vom System abmelden.

Hier ist auch der erste Bruch zu sehen, denn standardmäßig

verzichtet GNOME der Einfachheit wegen auf eine Funktion zum

Herunterfahren und bietet nur den Punkt „Suspend“ zur Auswahl an.

Will der Anwender des System herunterfahren (Shutdown), muss er die

„Alt“-Taste drücken.

Ferner verzichtet GNOME 3.0 in diesem Bereich auch auf ein

dynamisches Panel, wie er noch in der alten Version Usus war. So

lassen sich hier weder Benachrichtigungen noch weitere Applets

einbinden. Eine spätere Integration ist auch nicht geplant.

Aktivitäten

Der zweite Bruch mit den herrschenden Gepflogenheiten findet sich

auf der linken Seite der GNOME-Shell-Leiste in Form eines

Aktivitäteneintrags. Ein Klick auf den Button, der Druck der

„Windows“-Taste, das Kommando „Alt“ + „F1“ oder das Bewegen der Maus in

die linke obere Ecke blenden einen Überblickmodus ein, der einen der

zentralen Bereiche der Umgebung ausmacht. In einer Exposé-ähnlichen

Ansicht finden die Anwender alle Informationen über laufende

Anwendungen. Auf der linken Seite des Bildschirms ist dabei der so

genannte „Dash“ – ein Bereich, der in einer Icon-Ansicht die

favorisierten und gerade ausgeführten Anwendungen auflistet. Bewegt

der Anwender die Maus über ein Icon, blendet die Shell weitere

Informationen ein. Ein Klick auf ein Icon bringt weitere Funktionen

zum Vorschein.

Die neue Übersicht blendet ausgeführte Applikationen ein.

Den Hauptbereich der Ansicht bildet die Übersicht über die laufenden

Anwendungen, wohingegen auf der rechten die momentanen Workspaces

angedeutet sind. So können Anwendungen zwischen verschiedenen

Workspaces verschoben werden, wobei GNOME 3 nicht mehr wirklich

zwischen Workspaces trennt und die Anzahl der Workspaces bei Bedarf

erweitert. Schiebt ein Anwender beispielsweise eine Applikation auf

ein leeres Workspace, wird ein neues leeres Workspace erstellt.

Schließt er

dagegen das letzte Fenster eines Workspaces, wird auch

der Bereich geschlossen. Ein Klick auf ein Workspace wechselt zu

diesem.

Eine Neuerung gegenüber GNOME 2 ist hier, dass die Anordnung der

Workspaces nicht mehr horizontal, sondern vertikal erfolgt. Das

Starten von neuen Anwendungen erfolgt wahlweise entweder durch eine

direkte Eingabe, durch einen Klick auf ein Applikationsicon oder

durch das „Verschieben“ eines Applikationsicons auf ein Workspace.

Die zwei letzten Möglichkeiten können wahlweise auf einer

Favoritenleiste oder auf einer Übersichtsseite erfolgen. Die

Applikationen werden dabei auch hier als Icons gelistet. Je mehr

Anwendungen installiert sind, desto kleiner werden die Icons der

Übersichtsseite. Hier kann der Anwender auch eine Sortierung nach

Kategorien durchführen.

Benachrichtigungen

Einen integralen Bestandteil von GNOME 3 stellt das

Benachrichtigungssystem dar, das nun im unteren Bereich des

Bildschirms angeordnet wurde. Das System unterscheidet zwischen

wichtigen und weniger wichtigen Mitteilungen und blendet sie je nach

Stufe unterschiedlich lange ein. Mehrere Meldungen einer Applikation

werden zu einem Eintrag zusammengefasst und in Form eines Icons

dargestellt. Dabei beschränkt sich das System auf die Ansicht der

wichtigsten Informationen. Erst wenn der Anwender mit der Maus über

einer Nachricht stehenbleibt, blendet die GNOME Shell weitere

Informationen ein. Ein Klick auf die Nachricht startet, sofern

vorhanden, die entsprechende Applikation.

Verpasst ein Anwender eine Nachricht, so reicht es, mit der Maus in

die untere rechte Ecke zu navigieren. Sofort blendet die Shell alle

Nachrichten, die das System erhalten hat, ein. Auch hier werden die

Ausgaben gruppiert dargestellt und können mittels eines Klicks

erweitert werden.

Fenstermanagement und das Aussehen

Für viel Wirbel sorgte im Vorfeld der Freigabe die Handhabung von

Fenstern. So verzichtet GNOME 3.0 auf die Maximieren- und

Minimieren-Buttons in der Leiste und stellt standardmäßig nur einen

Button zum Schließen des Fensters zur Verfügung. Das Maximieren

erfolgt entweder durch einen Doppelklick auf die Fensterleiste oder

durch das Ziehen des Fensters in den oberen Bereich des Bildschirms.

Wird ein Fenster dagegen an den linken oder rechten Bildschirmrand

gezogen, wird es ähnlich Windows, oder neuerdings auch KDE, auf die

Hälfte des Bildschirms angepasst. So lassen sich bequem

beispielsweise zwei Dokumente oder Bilder nebeneinander einblenden,

ohne dass eine manuelles Zentrieren notwendig wäre.

Fensterleisten in GNOME 3.0 beinhalten nur noch den Schließen-Knopf.

Das weitere zentrale Merkmal von GNOME 3.0 stellt das Umschalten von

Fenstern dar. Das System agiert in der neuen Version nicht mehr auf

Fenster-, sondern auf Applikationsebene. Konkret heißt das, dass

beim Betätigen der Tasten „Alt“ + „Tab“ mehrere geöffnete Fenster

derselben Anwendung gruppiert dargestellt werden. Erst die Auswahl

mittels der Maus oder Tastatur klappt ein Untermenü aus, aus dem ein

spezielles Fenster herausgepickt werden kann. In der täglichen

Arbeit erweist sich die Steuerung

allerdings als wenig glücklich.

Vor allem für Anwender, die viele Terminal-Fenster offen haben,

werden eine Weile brauchen, bis das passende ausgesucht wurde.

Einen besonderen Wert bei der Erstellung von GNOME 3 legten die

Programmierer auf das Aussehen der Umgebung. Das neue Desktop-Theme

kann vollständig über eine CSS-Syntax konfiguriert und an die

eigenen Wünsche angepasst werden. Als Teil der Philosophie der

Vereinfachung wurde auch die Darstellung von Icons auf dem Desktop

entfernt. Laut Aussage der Entwickler lassen sich Daten sowieso

schneller mittels der neuen Funktionen finden. Wer der Funktion

nachtrauert, kann sie aber wieder einschalten.

Den Preis der grafischen Pracht stellt allerdings die zwingende

Voraussetzung von 3-D-Funktionen in der Hardware dar. Wer ein System

sein eigen nennt, das über diese Funktionalität nicht verfügt oder

schlicht nicht in der Lage ist, die grafische Anzeige darzustellen,

muss auf einen Fallback-Modus von GNOME 3.0 zurückgreifen.

Weitere Neuerungen

Auch jenseits der GNOME Shell und des Windowmanagers Mutter bringt

GNOME 3.0

zahlreiche Neuerungen mit sich. So bricht GNOME 3

mit dem

alten Konzept der verteilten Konfiguration und bietet ein

vollständig neues Kontrollzentrum, das die wichtigsten Funktionen

unter einer Oberfläche vereint. Zudem wurden zahlreiche Anwendungen

an die neue Umgebung angepasst.

Das neue Kontrollzentrum und Benutzermenü.

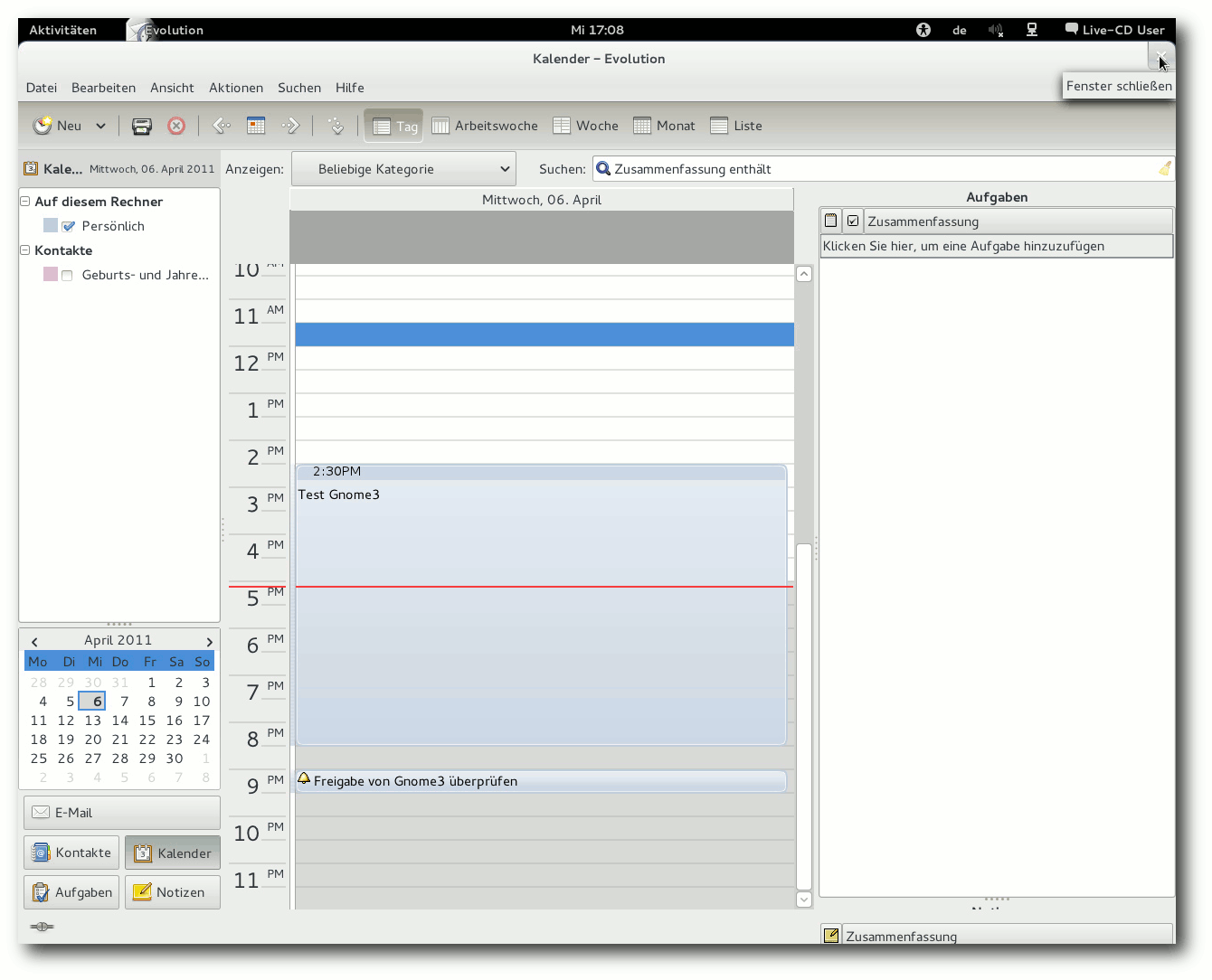

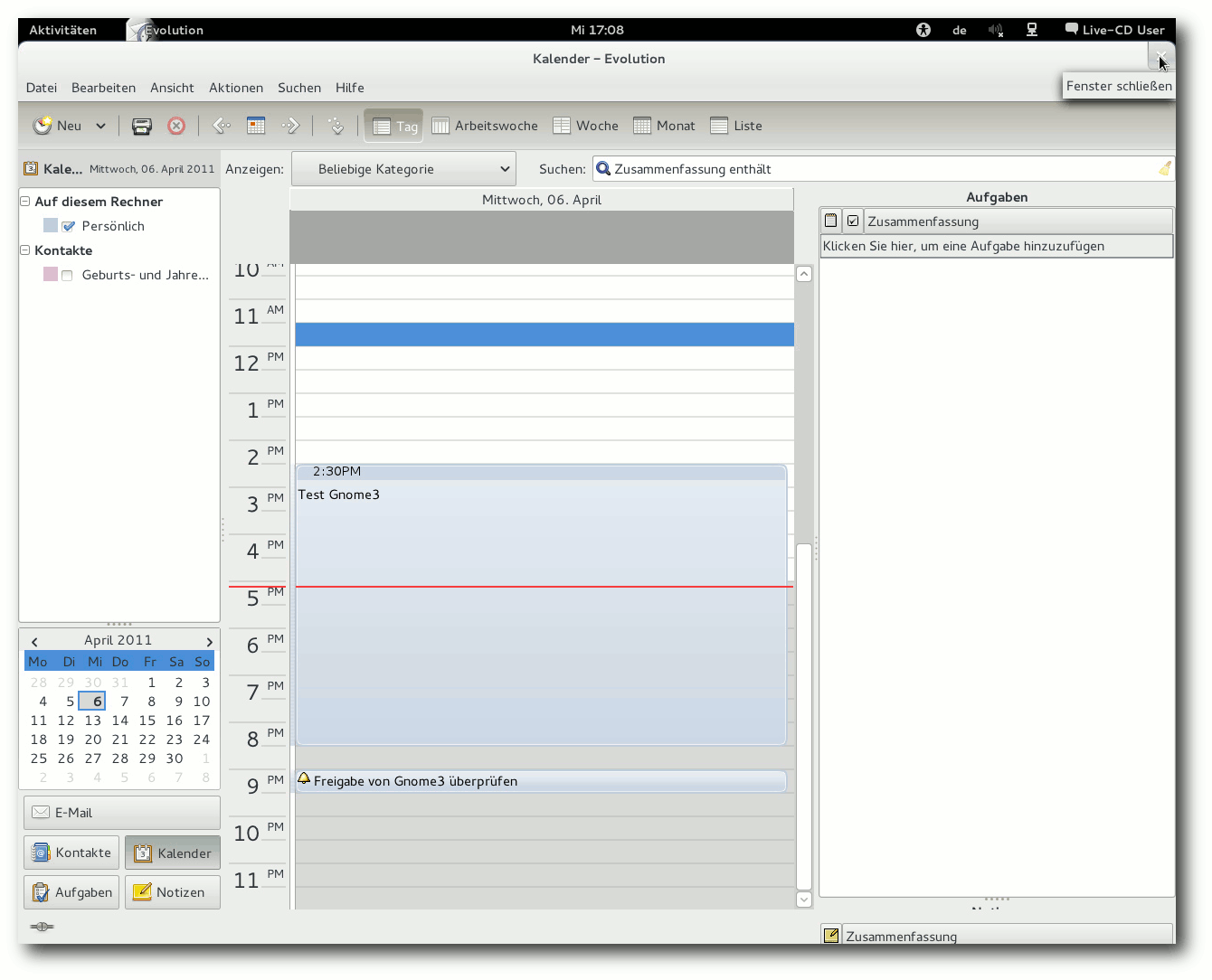

So wurde der Instant Messenger Empathy [5]

stärker in die Umgebung integriert. Zusammen mit dem neuen

Benachrichtungungssystem erlaubt die Applikation eine erheblich

schnellere Kommunikation. Eingehende Meldungen werden nun im unteren

Bereich nicht nur eingeblendet, sondern können dort auch beantwortet

werden. Das Setzen des Status im Benutzermenü hat zudem auch eine

Auswirkung auf die Applikation. Zu den weiteren neuen Funktionen

gehören unter anderem das Blocken von Konten und das Speichern von

Passwörtern. Darüber hinaus können eingehende Anrufe automatisch

abgelehnt werden.

Bedingt durch die neue Arbeitsweise wurde auch der Dateimanager

Nautilus [6] stark überarbeitet.

Die in der Vergangenheit am oberen Rand angebrachte Kontrollleiste

ist nun verschwunden. Ein ähnliches Schicksal erlitt die

Statusleiste. Stattdessen nimmt nun die Navigationsleiste einen

größeren Stellwert ein. Statusmeldungen werden dagegen als Overlay

eingeblendet.

Ebenfalls auf die Statusleiste verzichten muss der Webbrowser

Epiphany [7]. Der Downloadmanager

der Applikation wurde dagegen massiv überarbeitet. Neu ist ebenfalls

die Gruppierung von Seiten. Außerdem wird nun das Orten per

Geolocation in Epiphany unterstützt.

Evolution unter GNOME 3.0.

Des Weiteren haben die Entwickler die Hilfe der Umgebung komplett

umgekrempelt. Zu den weiteren Neuerungen in GNOME 3.0 gehören ferner

massive Überarbeitungen des Webcam-Tools Cheese.

GNOME 3.0 bringt zudem Verbesserungen für den Texteditor

gedit [8], wie beispielsweise eine

verbesserte Rechtschreibprüfung, vollständige Unterstützung für

komprimierte Dateien sowie die Möglichkeit, Dateien mit ungültigen

Zeichen zu bearbeiten. Die neue Version von gedit enthält weiterhin

eine neue Suchfunktion, welche die Sicht auf das bearbeitete

Dokument nicht einschränkt, und Reitergruppen erlauben das Anzeigen

mehrerer Dokumente gleichzeitig.

Auch Anjuta [9], die integrierte

Entwicklungsumgebung für GNOME, erhielt in Version 3.0 eine Reihe

von Verbesserungen. Zu den Neuerungen gehören unter anderem das

automatische Verbinden von Signalen mit Benutzeroberflächen,

verbesserte autotools- und pkg-config-Unterstützung und eine neue

Git-Unterstützung.

Der Unterbau

Die Implementierung von Mutter, GNOME Shell und die Änderung der

Arbeitsweise von GNOME stellen freilich nur die Spitze der in die

Umgebung eingeflossenen Arbeit dar. Das Gros der Arbeit machte die

Bereinigung der Umgebung aus. So haben sich die Entwickler dazu

durchgerungen, das alte Konfigurationssystem GConf durch eine

Kombination aus GSettings und DConf zu ersetzen. Dies hat zur Folge,

dass die Geschwindigkeit der Umgebung gesteigert werden konnte und

eine bessere Integration unter anderen Betriebssystemen ermöglicht

wird. Ganz entfallen wird GConf allerdings nicht, denn es existieren

durchaus noch Anwendungen, die auf die alte Lösung aufsetzen. Diese

anzupassen wird die Arbeit der kommenden Versionen sein.

Installierte Applikationen lassen sich einfach durchsuchen.

Ausgedient hat in GNOME 3 auch das Komponentensystem Bonobo, das nun

nicht mehr Bestandteil der Umgebung ist. Ferner haben die

Entwickler auch das virtuelle Dateisystem

gnome-vfs und die

Interface-Bibliothek libglade entsorgt. Daran glauben musste auch

libgnomeui.

Statt dessen setzen die Entwickler nun auf Clutter, dessen Entwicklung von Intel gesponsort wird.

Clutter stellt ein freies Toolkit dar, mit dem sich Fenster

und Bedienelemente erstellen lassen. Anders als die meisten anderen

Toolkits verwendet es allerdings OpenGL und optional OpenGL ES,

wobei sich die Entwickler nicht mit der Komplexität der

Grafikbibliotheken auseinandersetzen müssen.

Die zweite integrale Bibliothek stellt GTK+ 3.0 dar. Die neue

Version enthält eine große Zahl von Änderungen. Die Grafikausgabe

erfolgt nun durchweg über die Bibliothek Cairo, die im Gegensatz zu

GDK nicht nur für X11 verwendbar ist, sondern auch Grafikausgabe auf

Mac OS X, Windows, OpenGL, PostScript, PDF, SVG und Speicherbereiche

ermöglicht. Die Auswahl des Ziels der Grafikoperation kann zudem zur

Laufzeit erfolgen. Eingabegeräte werden nun auf moderne Weise

behandelt. Unter X11 äußert sich das in der Verwendung von X Input 2.

Eine beliebige Anzahl von Zeigergeräten, Tastaturen und anderen

Geräten wird nun unterstützt. Ein neues Theme-API mit CSS-Syntax

sorgt zudem für mehr Flexibilität beim Aussehen der Fenster und

Grafikelemente. Auch die Geometrieverwaltung wurde flexibler. Neue

Widgets und Tools wurden hinzugefügt. Anwendungen haben es leichter,

sich in die Plattform zu integrieren, und können über die Klasse

GtkApplication automatisch an D-Bus angebunden werden.

Firefox unter GNOME 3.0.

Fazit

Mit GNOME 3.0 liefert das Team der freien Desktopumgebung

zweifelsohne eine revolutionäre Arbeit ab. Die Umgebung wurde nicht

nur massiv überarbeitet, sondern bricht förmlich mit vielen

bekannten Paradigmen der Benutzerführung. Vor allem die Aktivitäten

bieten einen enormen Aha-Effekt, der durch eine sehr ansprechende

grafische Funktionalität überzeugen kann. Hinzu kommt noch ein

elegantes Aussehen und eine Führung, bei der sofort die klare Linie

der Vereinfachung der Benutzung ins Auge fällt.

Auf der anderen Seite unterscheidet sich die Benutzerführung der

aktuellen Generation maßgeblich von der Umgebung anderer Produkte.

Der Bruch wird vor allem Traditionalisten wenig gefallen. Der

Verzicht auf eine Taskleiste, der veränderte Start von Applikationen

oder die strikte Festlegung auf eine Anordnung der oberen Leiste

werden sicherlich nicht alle Geschmäcker treffen. Vieles lässt sich

an die eigenen Wünsche anpassen, doch allein die Tatsache, dass es

standardmäßig „so oder anders“ gehandhabt wird, könnte manch einen

Anwender vergraulen. Fakt ist aber auch, dass man dem neuen Konzept

auf jeden Fall Zeit geben sollte. Nicht alles, was neu ist, muss

schlecht sein.

GNOME 3.0 [10]

kann ab sofort im Quellcode von der Seite des Projektes heruntergeladen

werden [11]. Zum Kompilieren kann man

jhbuild verwenden. Binärpakete werden von verschiedenen Distributoren

bereitgestellt.

Links

[1] http://www.pro-linux.de/artikel/2/1501/gnome-30-bruch-mit-paradigmen.html

[2] http://www.gnome.org/

[3] http://www.pro-linux.de/news/1/11573/nokia-will-gtk-30.html

[4] http://live.gnome.org/GnomeShell

[5] http://live.gnome.org/Empathy

[6] http://live.gnome.org/Nautilus

[7] http://live.gnome.org/Epiphany

[8] http://live.gnome.org/Gedit

[9] http://live.gnome.org/Anjuta

[10] http://library.gnome.org/misc/release-notes/3.0/index.html.de

[11] http://ftp.gnome.org/pub/GNOME/

| Autoreninformation |

| Mirko Lindner (Webseite)

befasst sich seit 1990 mit Unix. Seit 1998 ist er aktiv in die

Entwicklung des Kernels eingebunden und verantwortlich für diverse

Treiber und Subsysteme für Linux und andere freie Plattformen.

Daneben ist er einer der Betreiber von Pro-Linux.de.

|

| |

Diesen Artikel kommentieren

Zum Index

von Mathias Menzer

Basis aller Distributionen ist der Linux-Kernel, der

fortwährend weiterentwickelt wird. Welche Geräte in einem halben

Jahr unterstützt werden und welche Funktionen neu hinzukommen,

erfährt man, wenn man den aktuellen Entwickler-Kernel im Auge

behält.

Linux 2.6.39

Die Entwicklung des 2.6.39 ging ähnlich ruhig weiter, wie sie begonnen hatte. Ein Scheduler-Problem, das letztlich auf einen fehlerhaft initialisierten Timer zurückgeführt wurde, hielt die Entwickler beschäftigt, wie Torvalds beim Veröffentlichen des 2.6.39-rc6 [1] verlauten ließ. Ein Problem am Dateisystem HPFS, das mit dem Rauswurf des Big Kernel Lock zusammenhing, trat bereits früh während der Entwicklungsphase auf. Es wurde damals kurzerhand als „BROKEN“ („Kaputt“) deklariert; -rc7 [2] brachte dann die benötigten Korrekturen dafür mit. Diese machten dann auch gleich den Löwenanteil an dem weiter geschrumpften Volumen an Änderungen aus. Ohne viel Federlesen folgte dann statt einer achten Vorabversion gleich 2.6.39 [3], nach nur 66 Tagen Entwicklungszeit.

BKL: Das war's, Leute!

Die neuen Funktionen klingen nicht ganz so spektakulär wie in mancher vorangegangenen Version, dennoch hat 2.6.39 etwas mehr als nur ein paar aktualisierte Treiber zu bieten. Allem voran, auch wenn dies schon mehrfach erwähnt wurde (siehe „Der April im Kernelrückblick“, freiesMagazin 05/2011 [4]), musste der Big Kernel Lock nun endgültig weichen; seit Arnd Bergmanns Patch mit der Bezeichnung „BKL: That's all, folks“ [5] wird man den Aufruf lock_kernel() nun – außer eventuell in der Dokumentation – nicht mehr im Kernel-Quellcode finden.

Mehr Pakete im Versand

Bei der Kommunikation mittels des Netzwerkprotokolls TCP/IP wird darauf geachtet, dass sich immer nur eine bestimmte Menge an Daten zwischen den beiden Endpunkten in der Zustellung befindet, also Pakete vom Sender abgeschickt wurden, ohne dass deren Eingang vom Empfänger bestätigt wurde. Bislang galten hier vier Segmente zu etwa 4 KB als Obergrenze zu Beginn einer Verbindung. Mitarbeiter von Google haben sich nun nach umfangreichen Tests dafür eingesetzt, diesen Wert auf zehn Segmente zu erhöhen; es wurde auch ein Vorschlag zur Änderung der entsprechenden Richtlinien bei der IETF (Internet Engineering Task Force) [6] eingereicht.

Die Änderung der Segment-Anzahl führte ohne erkennbare Netzwerkprobleme zu spürbaren Reduzierungen der Wartezeiten aus Sicht des Nutzers. Bislang funktionierte dies mit Linux nicht, da hier auf der Empfangsseite nur 6 KB zugelassen wurden. Nachdem dies in 2.6.38 bereits erhöht wurde, folgt nun die von Google vorgeschlagene Aufstockung des „Congestion Window“ auf zehn Segmente (entspricht ca. 10 KB).

IPset vereinfacht Firewall-Regeln

Ebenfalls auf Netzwerkseite rangiert IPset, eine Möglichkeit um Netzwerk-Ressourcen wie IP-Adressen oder Netzwerk-Ports zu einem Satz zusammen zu fassen. Die Sätze können dann von der im Kernel integrierten Firewall-Werkzeugsammlung Netfilter [7] verwendet werden. Damit ist es nun möglich, einen vergleichsweise einfachen Regelsatz vorzuhalten und dennoch in den IPsets lange Listen an Adressen und Ports zu pflegen.

Ext4 und Btrfs

Eine bereits mit 2.6.37 eingeführte Verbesserung am Dateisystem Ext4 bei der Nutzung auf Mehrprozessorsystemen wurde nun endlich in der Standardkonfiguration aktiviert. Bislang war die Verwendung von BIO-Layer (Block I/O – „Blockweise Ein-/Ausgabe“) noch nicht eingeschaltet. Die Übermittlung von Anfragen an den Ein-/"Äusgabe-Scheduler erfolgte über einen Buffer Layer („Zwischenpuffer“), der jedoch nicht effizient von mehreren Prozessoren genutzt werden kann.

Dem Dateisystem Btrfs wurde neben den üblichen kleineren Korrekturen und Verbesserungen noch die Möglichkeit gegeben, unterschiedliche Einstellungen für Komprimierung und das Schreiben auf den Datenträger für einzelne Dateien oder Verzeichnisse zu setzen, wodurch sich der Durchsatz z. B. durch eine geringere Komprimierungsrate bei kleinen, sehr häufig genutzten Dateien verbessert oder / und gleichzeitig eine hohe Komprimierung bei besonders großen Dateien eingesetzt werden kann.

Transzendenter Speicher

Etwas entrückt scheint das Konzept des Transzendenten Speichers (Transcendent Memory) anzumuten. Tatsächlich soll ein solcher Speicher das Wahrnehmbare überschreiten, allerdings nur in der Form, dass niemand zu wissen braucht, wie groß der Speicherbereich ist oder wo er physisch liegt. Er kann als eine Form des Arbeitsspeichers betrachtet werden, bei dem allerdings nicht sichergestellt ist, ob Schreibvorgänge auch erfolgreich verlaufen oder dass geschriebene Daten beim nächsten Leseversuch noch vorhanden sind. Dies sind eigentlich Eigenschaften eines Speichers, die einen Anwender eher abschrecken. Allerdings kann Transcendent Memory sonst ungenutzten Speicher in Beschlag nehmen und wird bei Bedarf einfach verdrängt, wodurch die Auslastung des Gesamtspeichers verbessert wird. Anwendungsbereiche liegen überall da, wo zum Beispiel nur ein Zwischenspeicher benötigt wird, dessen Verlust nicht tragisch ist, da die Inhalte noch woanders liegen.

Pstore sichert des Kernels letzte Worte

Fällt der Kernel wieder einmal auf die Nase, ist es manchmal schwierig, an Logdateien oder einen Speicherauszug zum Zeitpunkt des Crashs zu kommen, da mitunter auch die vom Kernel verwalteten Dateisysteme nicht mehr verfügbar sind. Abhilfe soll hier Pstore schaffen, ein Dateisystem, das den ACPI Error Record Serialization Table (ERST) nutzt, um die Fehlermeldungen eines Kernel-Crashs auch über einen Neustart hinweg zu speichern. ERST ist eigentlich zur Speicherung von Hardware-Fehlermeldungen auf einem nichtflüchtigen Speicher gedacht und in den ACPI-Spezifikationen beschrieben. Der Intel-Entwickler Tony Luck hat dabei nicht nur an die x86-Plattform gedacht, sondern Pstore als Framework umgesetzt, sodass auch andere Plattformen es nutzen können, um Informationen über den „letzten Atemzug eines abstürzenden Kernels“ sicherstellen zu können.

Darüber hinaus wurde wieder in großem Umfang an den bereits bestehenden Treibern gearbeitet und neue eingebracht. Eine vollständige Übersicht liefert die englischsprachige Seite Kernel Newbies auf zwei Übersichtsseiten zu den neuen Funktionen [8] und den Änderungen an den Architekturen und Treibern [9].

Linux 3.0

Richtig, es heißt nun Linux 3.0. Wer aus alter Gewohnheit den 2.6.40-rc1 erwartete, wurde diesmal enttäuscht, da Torvalds einen neuen Abschnitt bei den Versionsnummern eingeläutet hat. Auch Ingo Molnar stimmte ihm zu, dass .40 ausreichend groß sei, um eine neue Major-Version zu beginnen. Einige Zeit lang stand auch noch 2.8 als Nachfolger von 2.6 im Raum [10], allerdings wurde nun auch mit dem alten, bereits seit einigen Jahren nicht mehr gelebten Modell zur Unterscheidung von Entwickler- und Produktiv-Versionen gebrochen, sodass der neue Entwickler-Kernel nun unter 3.0-rc1

veröffentlicht wurde. Somit sind es nicht unbedingt technische Aspekte, die bei diesem Schritt im Vordergrund standen, sondern die ganz banale Faulheit der Entwickler, die nun jedes Mal einige Zeichen weniger zu tippen haben. ;-)

So sind die Änderungen auch eher unspektakulär und halten sich schon rein vom Volumen her unterhalb der Vorgängerversionen. „Keine ABI-Änderungen, keine API-Änderungen, keine märchenhaften neuen Funktionen – lediglich stetig voranschreitender Fortschritt“ beschrieb Torvalds den 3.0-rc1 [11], und das ist auch passend. Besonders erwähnenswert erschienen ihm Aufräumarbeiten an VFS (Virtual File System) und Korrekturen an der Virtuellen Speicherverwaltung (VM). Er plant, bei diesem Entwicklungszyklus besonders strikt bei der Übernahme von Änderungen zu sein, um aus dem Kernel 3.0 ein stabiles Stück Software zu machen.

Kurz erläutert: „Versionsnummerierung des Linux-Kernels“

Die ersten Versionsnummern folgten noch keinem zielgerichteten Muster, erst ab Version 1.0 sollte das folgende Schema gelten: Die erste Stelle wird nur bei tiefgreifenden Änderungen der Systemarchitektur erhöht. Die zweite Stelle bezeichnet die Major-Version, wobei stabile Kernel mit geraden (z. B. 2.4), reine Entwickler-Kernel mit ungeraden Ziffern gekennzeichnet wurden (z. B. 2.5). Die dritte Stelle ist die Minor-Version, die erhöht wird, wenn neue Funktionen hinzukommen.

Seit 2004 entfällt der reine Entwickler-Kernel, beginnend mit 2.6 wird die auf die aktuellste Version folgende Minor-Version als Entwickler-Kernel geführt und bis zur Veröffentlichung als stabile Version mit „-rc“ gekennzeichnet. Parallel dazu wurden immer noch Kernel aus der 2.4er-Reihe mit Änderungen gepflegt, die aus der 2.6er-Reihe zurückportiert wurden.

Die Versionsnummer 2.6.40 erschien Torvalds zu umständlich, daher wurde der Folge-Kernel zu 2.6.39 kurzerhand 3.0 getauft. Dies soll auch einen neuen Abschnitt in der Versionsnummerierung anzeigen, denn die Minor-Version fällt nun weg, der Nachfolger zu 3.0 wird 3.1 heißen. Nicht stabile Kernel-Versionen werden weiterhin mit einem „-rc“ und einer fortlaufenden Nummer gekennzeichnet, also zum Beispiel 3.0-rc1, 3.0-rc2 und so weiter. Darüber, was als Grund für einen Sprung auf 4.0 in Frage kommt, darf gerätselt werden, im Zweifel bis zur Veröffentlichung von Kernel 3.39.

|

Links

[1] https://lkml.org/lkml/2011/5/3/553

[2] https://lkml.org/lkml/2011/5/9/552

[3] https://lkml.org/lkml/2011/5/19/16

[4] http://www.freiesmagazin.de/freiesMagazin-2011-05

[5] https://lkml.org/lkml/2011/1/25/520

[6] http://de.wikipedia.org/wiki/Internet_Engineering_Task_Force

[7] http://de.wikipedia.org/wiki/Netfilter

[8] http://kernelnewbies.org/Linux_2_6_39

[9] http://kernelnewbies.org/Linux_2_6_39-DriversArch

[10] http://www.pro-linux.de/news/1/17079/abschied-von-linux-26.html

[11] https://lkml.org/lkml/2011/5/29/204

| Autoreninformation |

| Mathias Menzer (Webseite)

hält einen Blick auf die Entwicklung des Linux-Kernels. Dafür erfährt er frühzeitig Details über neue Treiber und interessante Funktionen.

|

| |

Diesen Artikel kommentieren

Zum Index

von Michael Schwarz

Ungern brüllt man Anweisungen von Büro zu Büro. Damit Angestellte

miteinander kommunizieren können, wird vielerorts zum Telefon gegriffen. Wird

bereits telefoniert, muss die dienstliche E-Mail herhalten, um

Kommunikationsbedürfnisse zu befriedigen. Was aber, wenn die Leitung belegt

und das Senden einer E-Mail derzeit nicht möglich ist? Situationen wie die

folgende waren und sind in Büros keine Seltenheit.

Wie alles begann – Vorgeschichte

Nahezu unhörbar vibriert das Mobiltelefon über den Tisch, schon der

Griff danach verspricht nichts Gutes – jedenfalls nicht jetzt, einige

Minuten vor Feierabend: „Technik, Schwarz?“ – Es ist der

Büroleiter, schwer in Rage darüber, dass der Mailserver mal wieder

seinen Dienst quittiert hat. Der Mailserver gehört zur weit entfernten

Hauptdienststelle und wird auch von dort aus administriert. Eigentlich

jedenfalls. Entsprechend sinnfrei, dass zu diesem Thema das Telefon

hier klingelt, einer kleinen Außenstelle – 30 Festangestellte und

einige Zeitarbeitskräfte verteilt auf drei Etagen. Hier gibt es

niemanden, der dafür die Verantwortung übernehmen, geschweige denn mit

einem magischen Fingerschnippen für neue Funktionalität sorgen könnte.

Unabhängig davon folgt die nächste Tirade: „Es ist ein Unding, dass

dieses blöde System dauernd Störmeldungen verursacht!“, schnaubt es am

anderen Ende der Leitung. Nicht zum ersten Mal folgt an dieser Stelle

die Erklärung, dass der Mailserver nicht in Zuständigkeit der

Außenstelle liegt und die Hauptdienststelle dieses Monopol inklusive

Adminrechte für sich behält. Freundlich wie man ist, bietet man an,

den Fehler zur Bearbeitung weiterzugeben … Aber offensichtlich ist dies

nicht die Zeit für Erklärungen und Angebote – und so endet das

Telefonat mit einem unerwarteten Klicken in der Leitung. Funkstille.

Aufgelegt.

Verärgerung macht sich breit: Prügelknabe durch Koinzidenz ist heute

derjenige, der zum falschen Zeitpunkt zum Telefon griff – jedoch bahnt

sich irgendwo zwischen limbischen System und Großhirn eine Lösung an:

„Keine Mitadministration“, „hausinterne Kommunikation“, „unabhängig“,

„kein Telefon“ – Gedankenbruchstücke führen zum Schluss, dass ein

Kommunikator benötigt wird, der im Störfall direkt vor Ort gewartet

werden kann, das Ganze hausintern ohne Anbindung nach „Oben“ und

möglichst textbasiert, fast so wie E-Mail. Nach kurzem Überlegen: Ein

Chatroom für alle, um Statusmeldungen und Mitteilungen an das Personal

verschicken zu können. Der Gedanke hält sich. Dann beginnt die

Internetrecherche: Auf die Stichworte „Hausinterne Kommunikation“

spuckt Wikipedia u. a. „Chat/Webkonferenz/Instantmessaging“ aus, auf

einer der anderen gefundenen Seiten wird „UnrealIRC“ für seine relativ

einfache Konfiguration und dessen Stabilität gelobt. Nach einer

Viertelstunde steht der Entschluss: Ein Chat ist die Lösung für das

Problem.

Grundkenntnisse

UnrealIRCd [1] bedeutet nichts anderes als „Unreal Internet Relay Chat

daemon“, wobei „Unreal“ der Eigenname ist und keine weitere Bedeutung

hat. „Internet Relay Chat“ oder eben kurz „IRC“ benennt die zugrunde

liegende Komponente, ein textbasiertes Chatsystem, für das Projekt. Der

„Daemon“ ist der Dienst, der Verbindungen sowie die generelle

Kommunikation ermöglicht. Ohne Betriebssystem keine Software, als

Grundgerüst dient daher ein Ubuntu 10.04 Server. Das schließt zwar, lässt

man größere Anpassungen außen vor, den Zugriff auf eine GUI aus, der

Vorteil ist aber der lange Unterstützungszeitraum. Ubuntu 10.04 bietet Long

Term Support. Die Servervariante wird bis April 2015, fünf Jahre nach

Veröffentlichung im April 2010, mit Updates versorgt.

Scheinwelt

Den IRC-Daemon sperrt man am Besten in eine virtuelle Maschine. Warum? Zur

Installation und Konfiguration wurde im beschriebenen Szenario ein alter

Pentium4-PC mit 2 GHZ und 512 MB Arbeitsspeicher genutzt. Ein normaler

Desktop-PC von „damals“ ist ökonomisch betrachtet nicht für den

24-Stunden-Betrieb vorgesehen und verpulvert unnötig Strom. Später, wenn das

Projekt ein voller Erfolg und die Belegschaft begeistert ist, wird ein

kleiner PC mit Stromspar-CPU den 24-Stunden-Dienst übernehmen und relativ

umweltfreundlich in einer Ecke des Büros stehen. Wenn der Tag gekommen ist,

wird die virtuelle Maschine mitsamt dem IRC-Daemon einfach den Gastgeber

wechseln. Die Virtualisierung des IRC-Daemon ist auch dann sinnvoll, wenn man

mit einer bereits produktiven IRC-Umgebung Tests durchführen möchte, ohne

dem Büro den lieb gewonnen Kommunikator zu schädigen. Stattdessen erstellt

man ein Backup der VM und experimentiert damit herum, ohne das produktive

System zu belästigen. Letzter Vorteil zum Thema virtuelle Maschine: Ist

bereits ein physischer, ununterbrochen laufender PC oder Server vorhanden,

drückt man diesem einfach zusätzlich die virtuelle IRC-Maschine aufs Auge.

Dabei ist es auch (fast) unwichtig, welches Betriebssystem die virtuelle

Maschine gastieren lässt, da es für alle gängigen Systeme entsprechende

Virtualisierungssoftware gibt.

Voraussetzungen

Zuerst die Virtualisierungssoftware zum Einrichten der virtuellen Maschine:

Im beschriebenen Fall erledigt VirtualBox [2] die

Aufgabe. Die Firma Oracle [3] bietet den Virtualisierer

kostenlos an, was den Geldbeutel schont. Darüber hinaus geht man mit

VirtualBox sicher, dass die eingerichtete virtuelle Maschine im Anschluss auf

Linux-, Windows- oder MacOS-X-Maschinen gleichermaßen eingesetzt werden kann.

Nach VirtualBox sollte die Servervariante von Ubuntu auf der zugehörigen

Homepage [4] heruntergeladen

werden. Dieses System wird später als virtuelle Maschine installiert.

Prinzipiell eignet sich auch eine andere Distribution als Unterbau für den

UnrealIRCd.

Als weitere Grundvoraussetzung ist entsprechende Hardware nötig, je

aktueller desto besser. Die durchgeführte Beispielinstallation begnügte

sich jedoch bereits, wie weiter oben beschrieben, mit einem

Pentium4-Prozessor und 512 MB Systemspeicher.

Vorbereitung

Mit heruntergeladenem Ubuntu-Server CD-Image und installiertem VirtualBox auf

dem Gastgebersystem geht es also ans Werk. Es wird eine virtuelle Maschine

erstellt. Benannt werden kann diese wie es beliebt. „Typ des

Gastbetriebssystems“ sollte „Linux“, Version „Ubuntu“ sein. Bei der

Zuweisung des VM-RAM spielt der reelle Arbeitsspeicher eine große Rolle. Bei

insgesamt 512 MB wäre eine Zuweisung von 512 MB an die virtuelle Maschine

mehr als töricht. Bei 2 GB und mehr verbautem Arbeitsspeicher aber durchaus

praktikabel. Ein Wert zwischen 256 MB und 512 MB sollte zur Installation

vorerst eingestellt werden. Tatsächlich ist der spätere Betrieb auch mit

lediglich 96 MB virtuellem Arbeitsspeicher möglich. Eine virtuelle

Festplatte wird am Folgebildschirm erzeugt. Hierbei wählt man optimalerweise

„dynamisch wachsendes Medium“ mit einer Größe von 3,70 GB. Dieser Wert

ist praktisch, da die komplette virtuelle Maschine, wann immer gewünscht,

auf einer DVD gesichert oder darauf von Gastgebersystem zu Gastgebersystem

transportiert werden kann. Letztlich sind 3,70 GB lediglich ein Vorschlag,

der Benutzer hat, gemessen an seiner Festplattenkapazität, die freie Wahl.

Nach einigen Klicks auf „Weiter“ ist die Baustelle „Virtuelle

Maschine“ also soweit hergerichtet, Zeit „Baustellenfahrzeuge“ und

„Baumaterial“ hinzuzufügen: Im Hauptfenster von VirtualBox markiert man

die soeben erstellte virtuelle Maschine und klickt auf „Ändern“.

Schließlich mangelt es am zu installierenden Ubuntu-Server bzw. dessen

CD-Image. Unter „Massenspeicher“ wählt man bei „IDE-Controller“ den

Eintrag „leer“. Am rechten Rand von „Attribute“ selektiert man das

kleine CD-Symbol und klickt auf „Datei für virtuelles CD/DVD-ROM-Medium

auswählen …“. Anschließend wird das CD-Image des Ubuntu-Server gesucht

und eingebunden.

Startet man jetzt die virtuelle Maschine, sollte nach dem

Hochfahren ein Ubuntu-Startmenü gezeigt werden.

Die Installation des Betriebssystems der virtuellen Maschine wird im

Anschluss durchgeführt. Benennt man die Ubuntu-Installation stimmig mit

unrealircd, ist eine Zuordnung im Netzwerk später einfacher. Die Frage

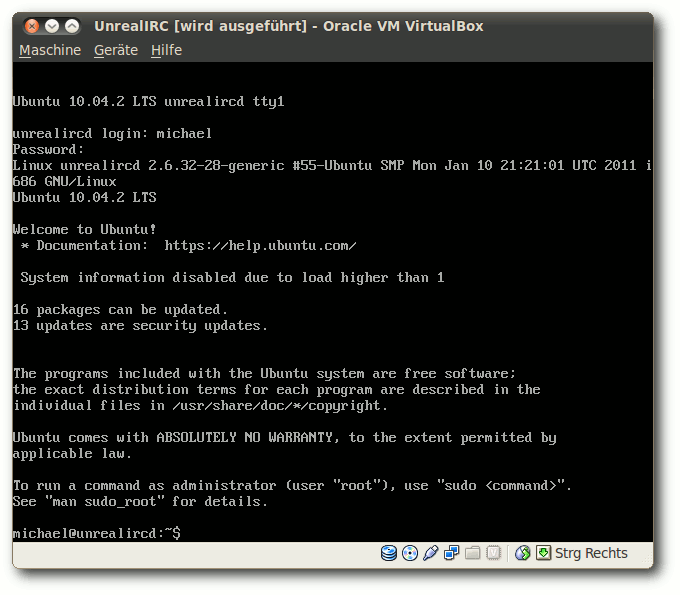

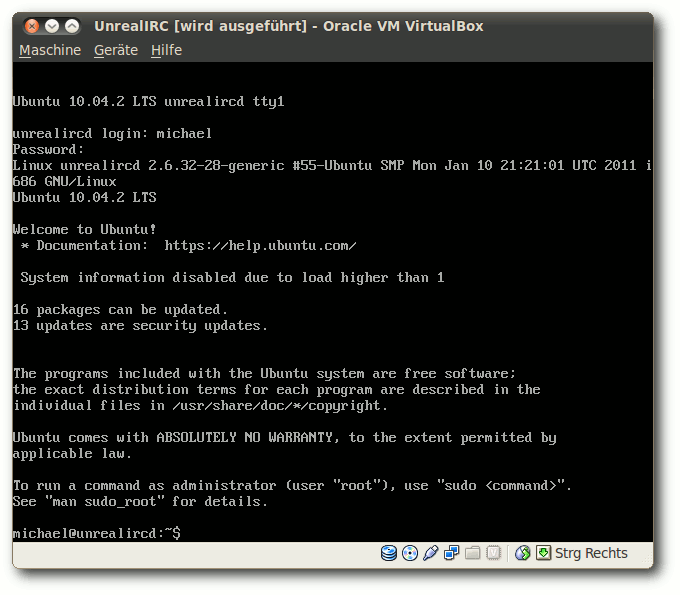

nach einem Proxy-Server während der Installation sollte erhöhte Beachtung