Zur Version ohne Bilder

freiesMagazin März 2013

(ISSN 1867-7991)

Fedora 18

Das neu erschienene Fedora 18 will den Benutzern wie jedes halbe Jahr die neueste freie Software und die neuesten Technologien bringen, von denen die wichtigsten im Laufe des Artikels erwähnt und, soweit möglich, auch ausprobiert werden. Vorrangig wird auf die Desktopumgebungen GNOME und KDE eingegangen. (weiterlesen)

Einführung in Docbook

Wer publiziert, Software dokumentieren möchte oder sich mit elektronischen Dokumentenformaten beschäftigt, der stößt irgendwann mit Sicherheit auf Docbook. Docbook stammt aus dem Bereich der EDV-Dokumentation und wird überwiegend, aber nicht ausschließlich, dafür verwendet. Docbook ist ausgereift und umfangreich genug, um eine Grundlage für die professionelle Buchproduktion zu sein, wird aber auch für kleinere Projekte verwendet, wie zum Beispiel die Linux-Manpages. Docbook wird mittlerweile vielfältig eingesetzt und es kann damit grundsätzlich plattformunabhängig bzw. -übergreifend gearbeitet werden. (weiterlesen)

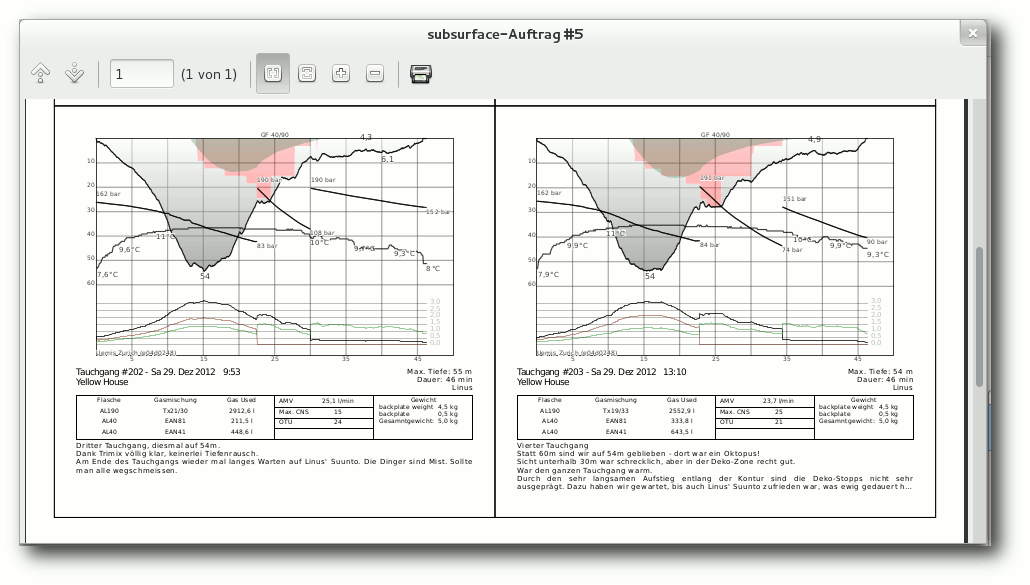

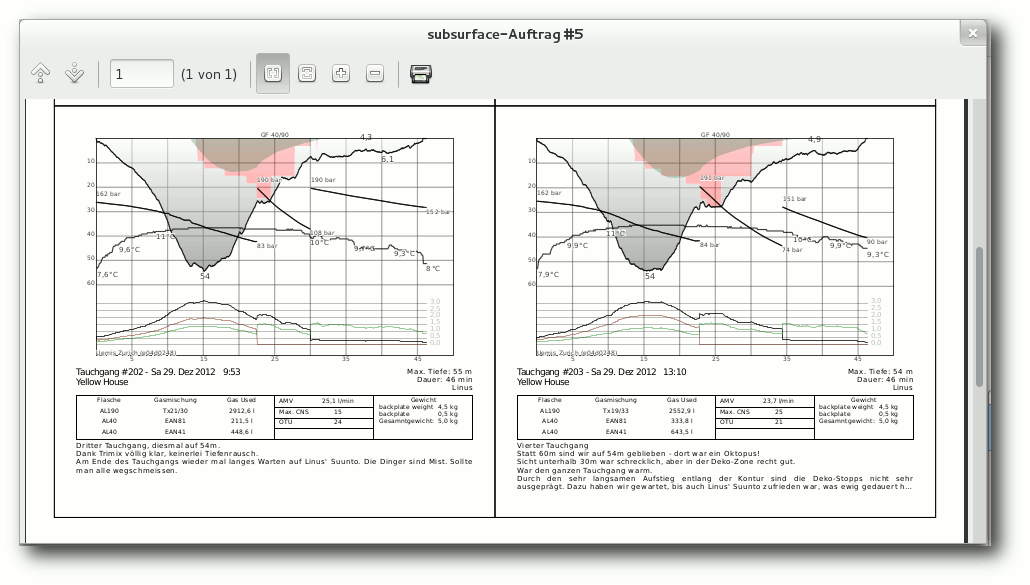

Subsurface – Tauchen unter Linux

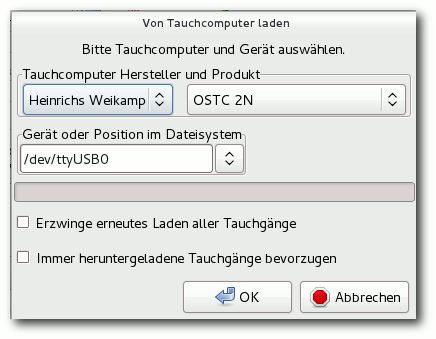

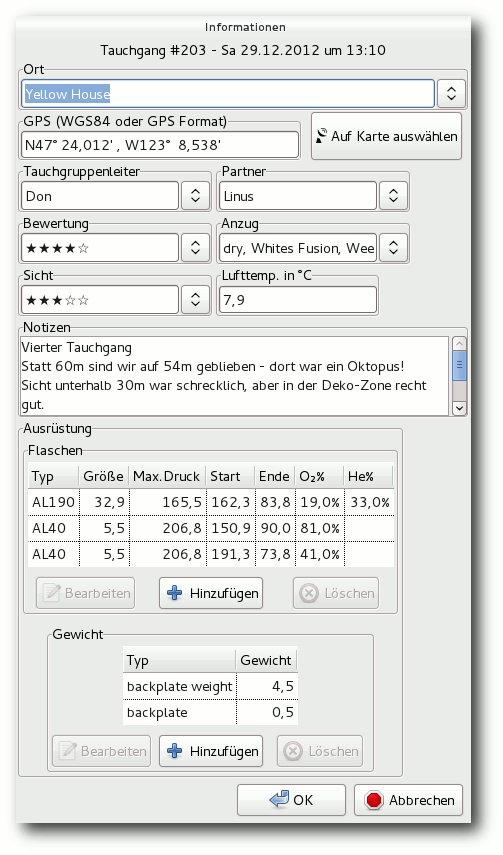

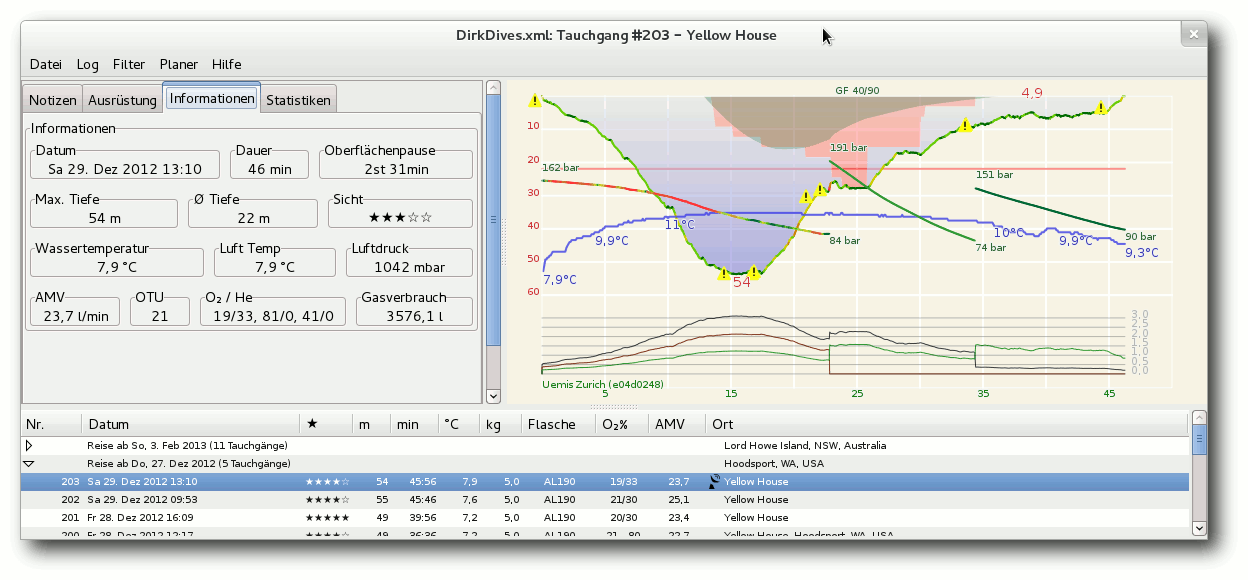

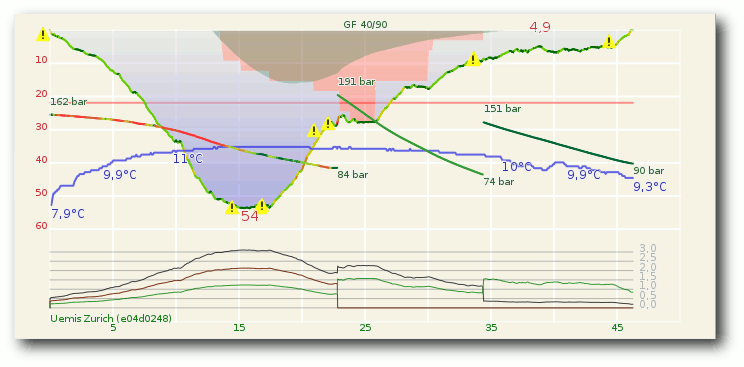

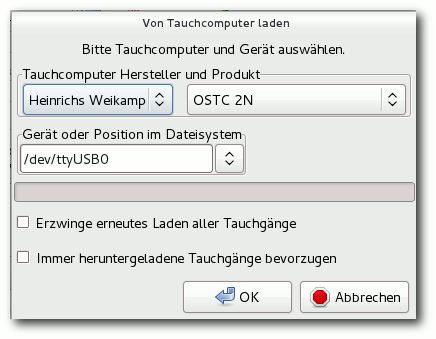

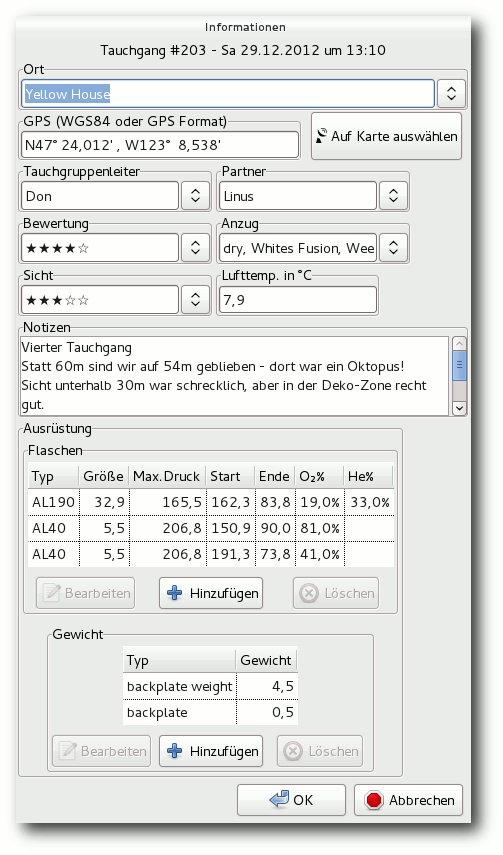

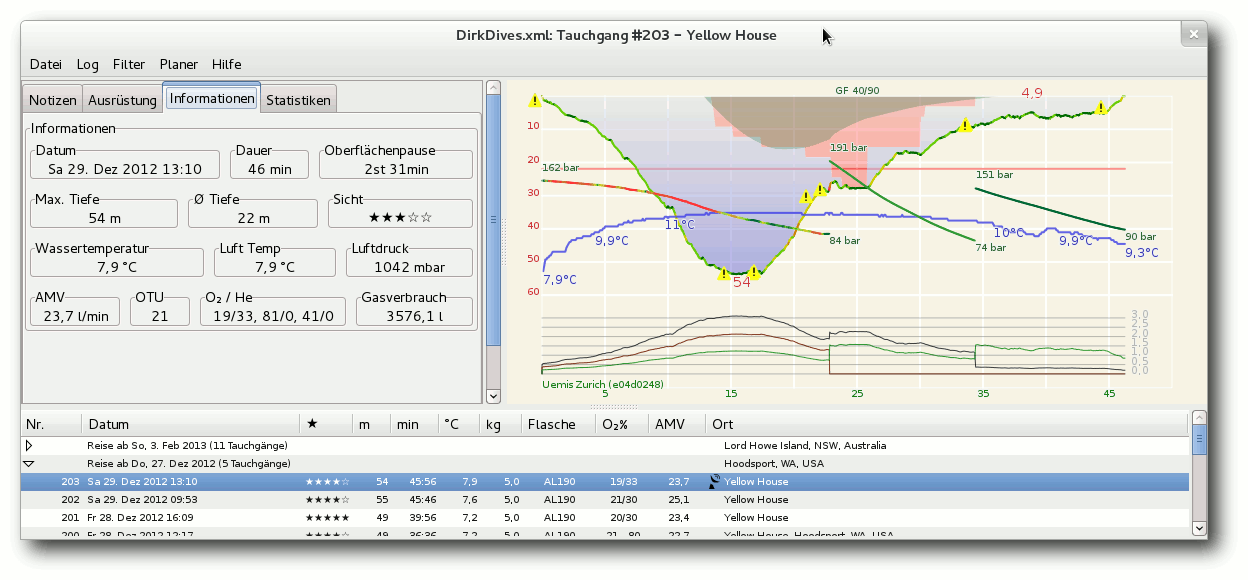

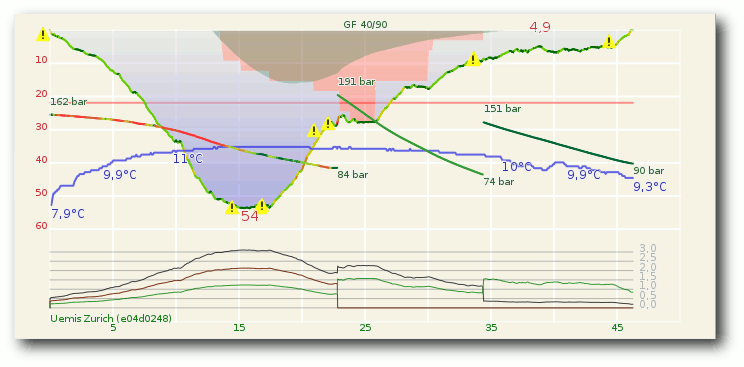

Subsurface ist ein quelloffenes und kostenloses Programm zur Verwaltung von Tauch-Logbucheinträgen für Linux, MacOS X und Windows. Es erlaubt den direkten Import von Daten aus einer Vielzahl von Tauchcomputermodellen und -programmen. Außerdem bietet es eine ansprechende grafische Aufbereitung der vom Tauchcomputer während des Tauchgangs aufgezeichneten Daten. Eine Fülle weiterer Informationen zu den Tauchgängen können vom Benutzer komfortabel erfasst und verwaltet werden. (weiterlesen)

Zum Index

Linux allgemein

Fedora 18

Der Februar im Kernelrückblick

Anleitungen

Firefox-Erweiterungen mit dem Add-on-SDK erstellen – Teil II

Einführung in Docbook

Eine kurze Einführung in Hadoop

Laufzeitanalyse mit gprof

Software

Subsurface – Tauchen unter Linux

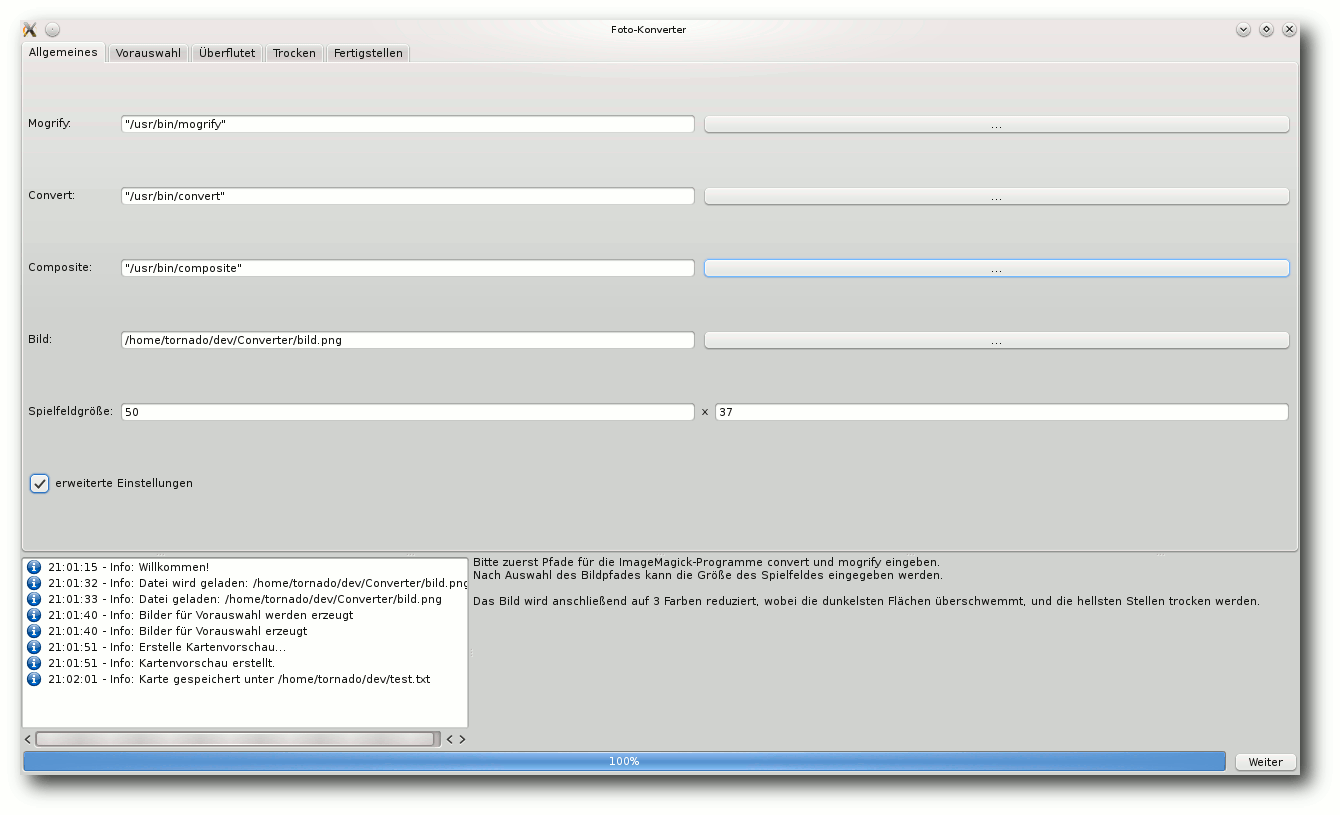

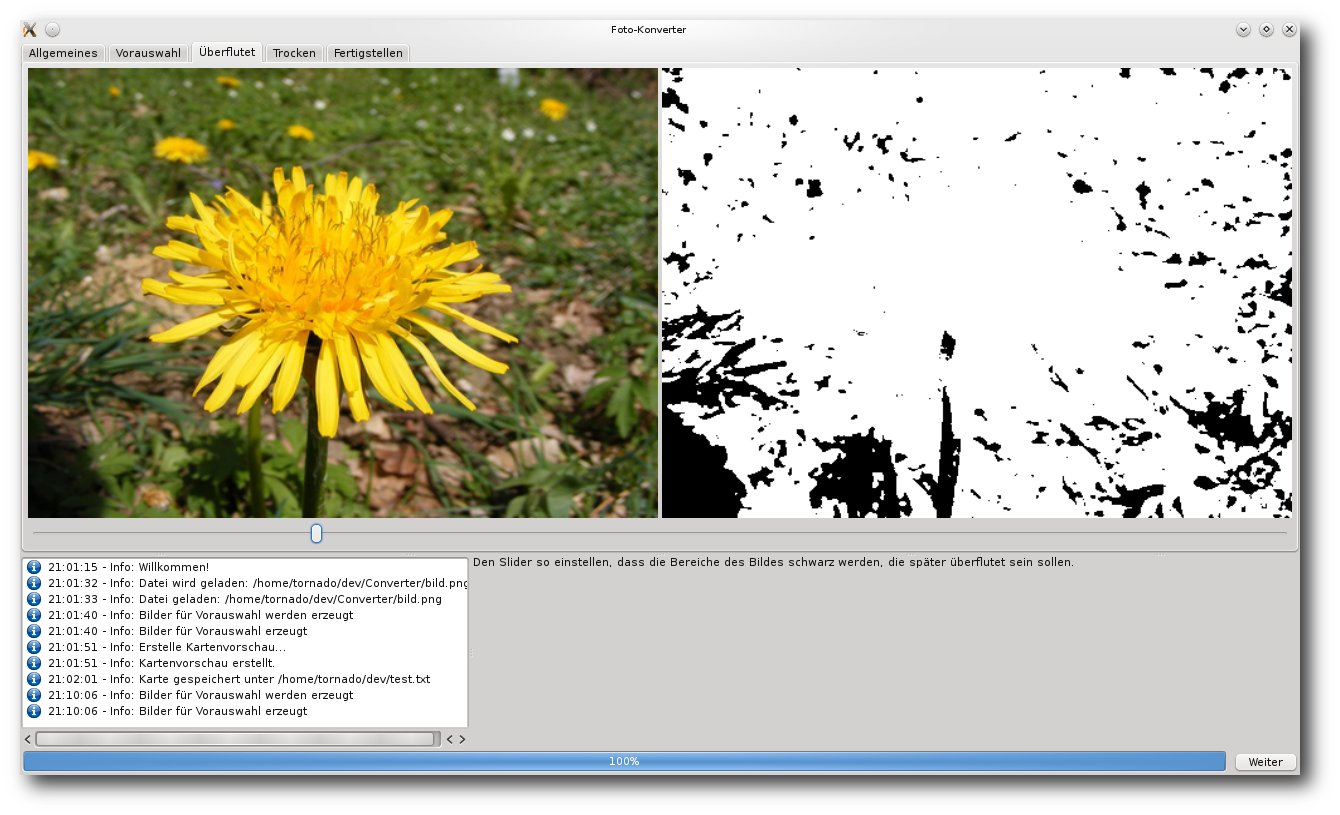

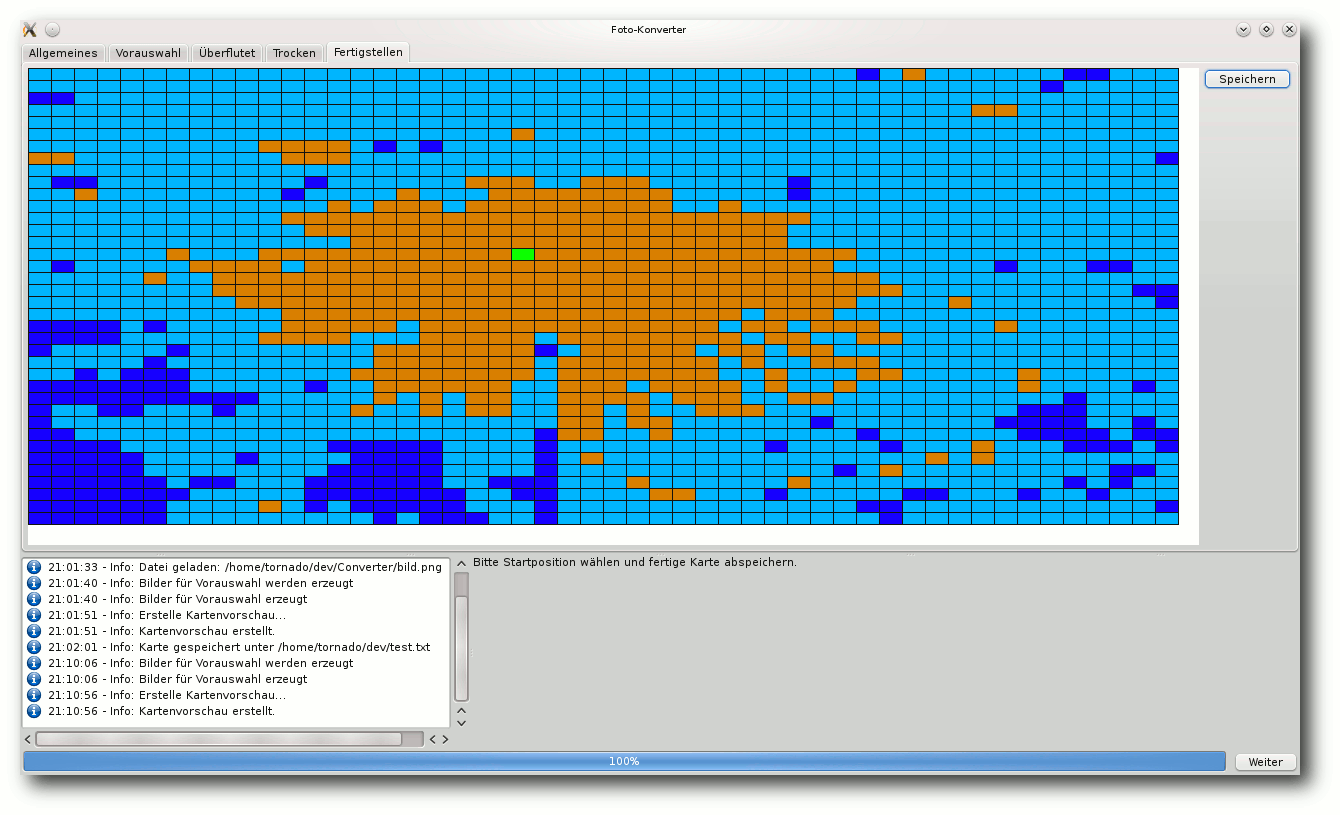

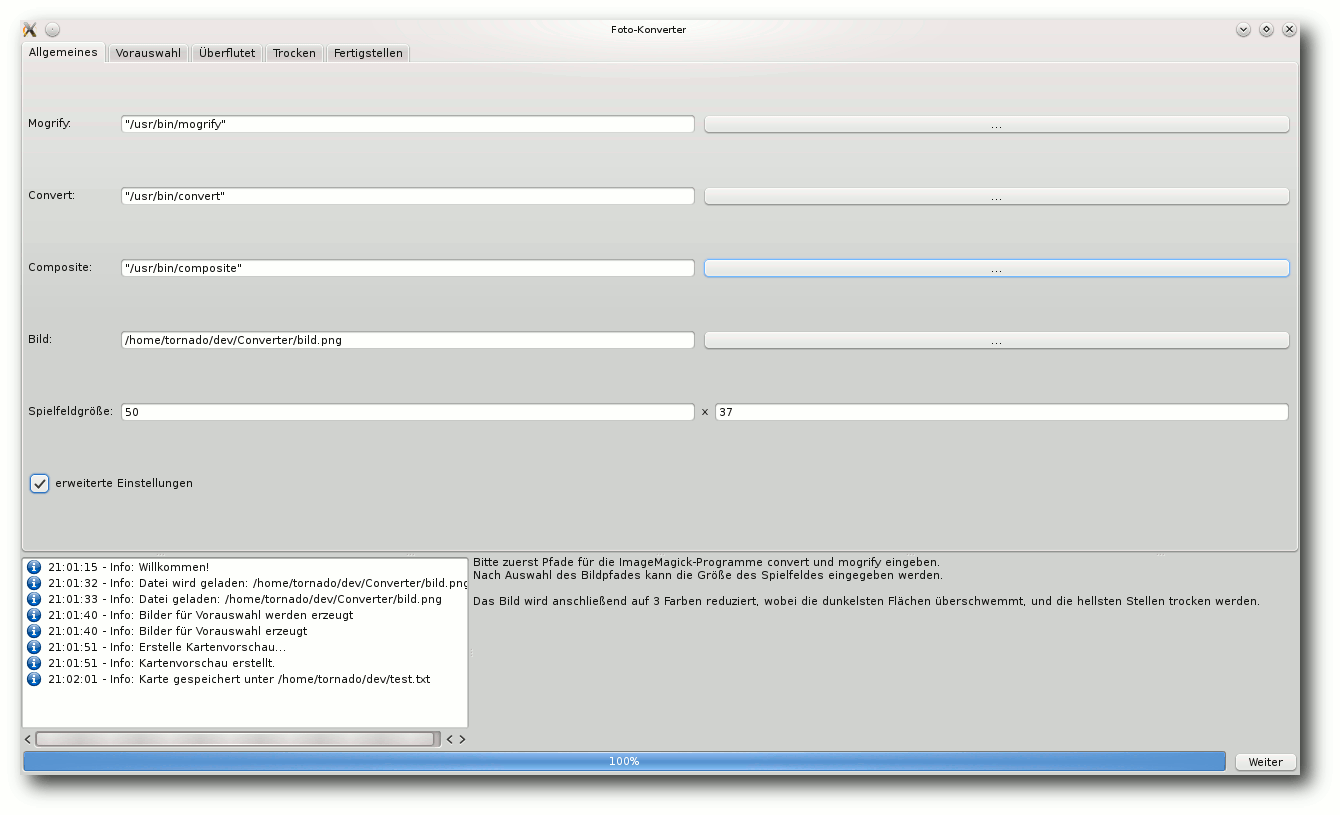

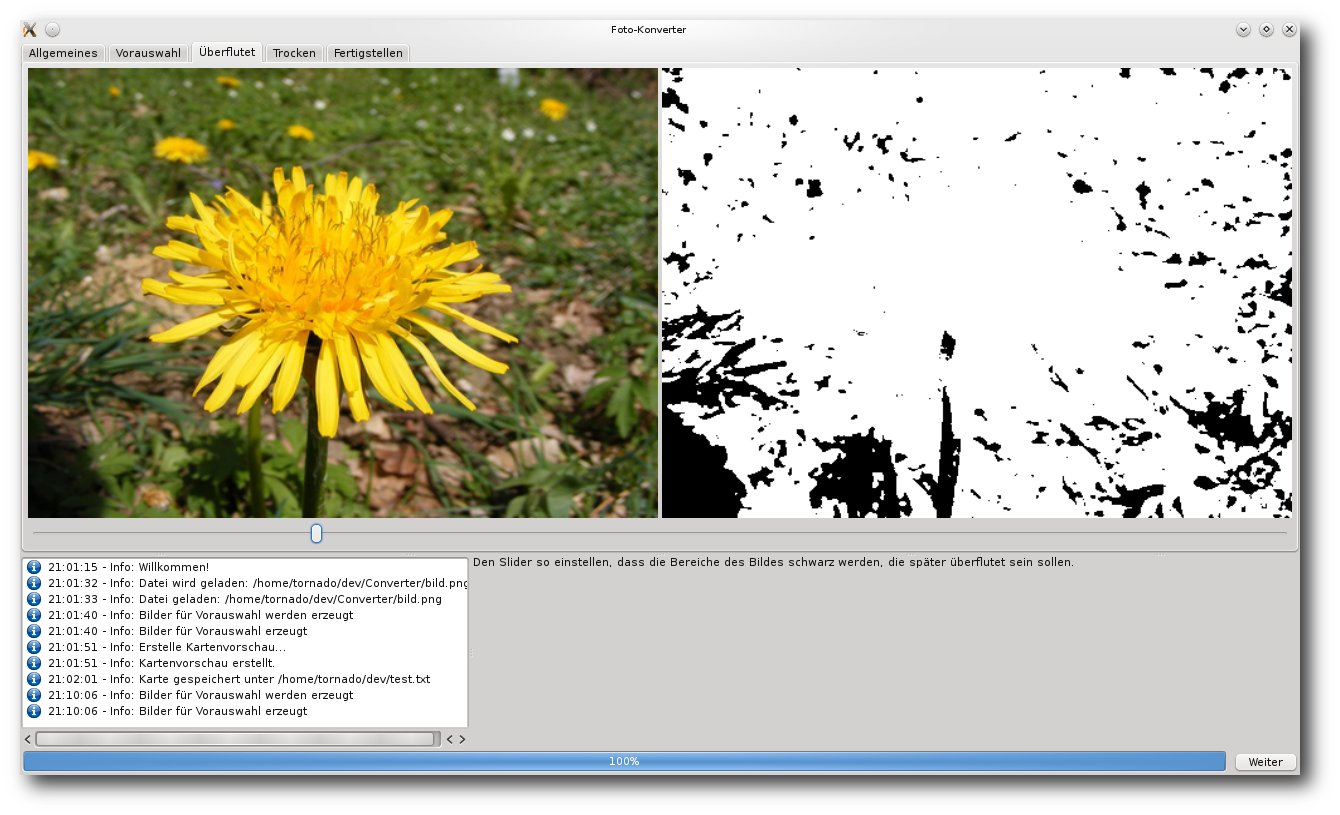

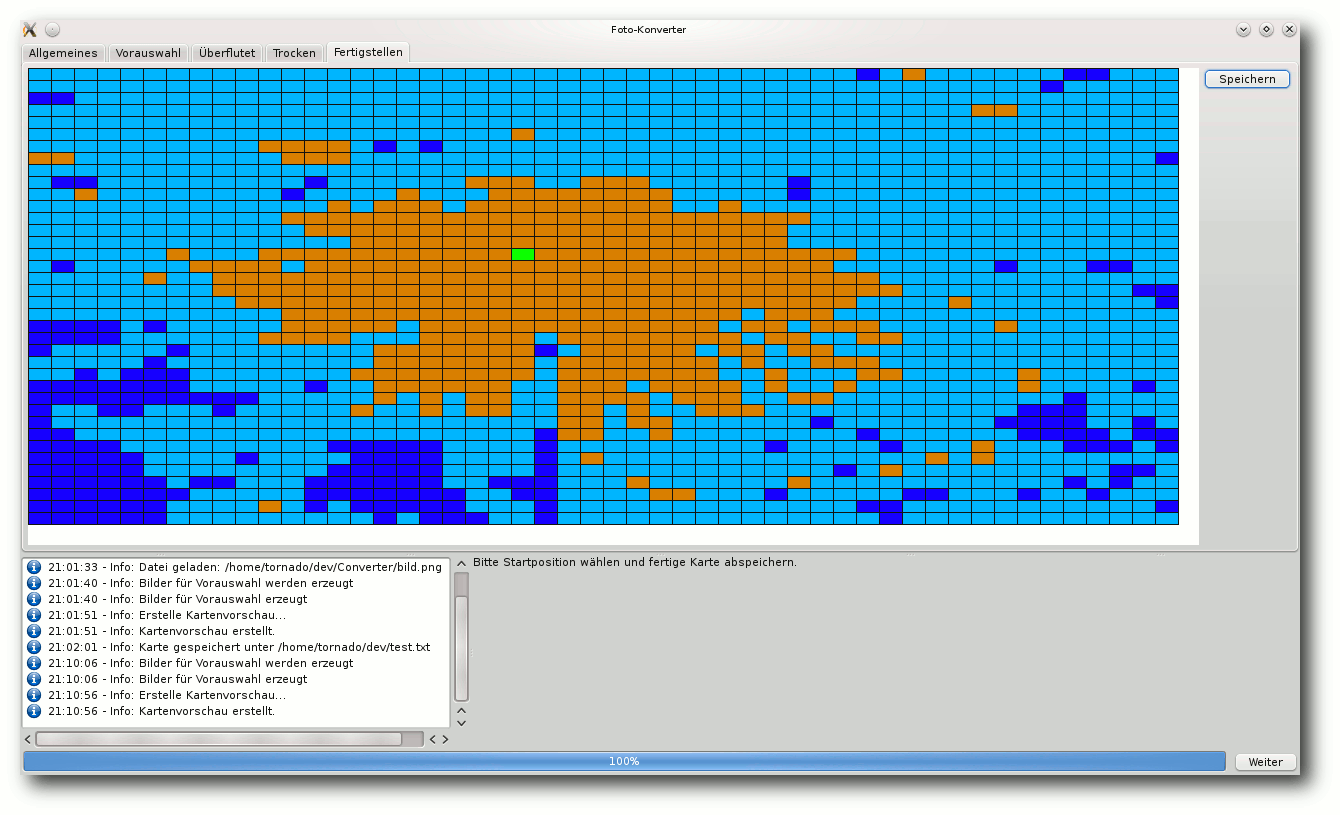

Foto-Kartengenerator

Community

Rezension: PC-Netzwerke: Das umfassende Handbuch (6. Auflage)

Rezension: Die Kunst des Vertrauens

Magazin

Editorial

Die Gewinner des sechsten Programmierwettbewerbs

Leserbriefe

Veranstaltungen

Vorschau

Konventionen

Impressum

Zum Index

Steam für Linux

Mitte Februar war es soweit: Steam für Linux wurde nach einer ausgiebigen

Beta-Phase für alle Linux-Nutzer freigegeben [1].

Wobei „alle“ vielleicht nicht alle meint, da offiziell erst einmal nur Ubuntu

unterstützt wird. Als vermutlich meist genutzte Distribution ist dies aber

natürlich ein verständlicher Schritt für Valve, der Firma hinter Steam.

Als Lockangebot gab es die ersten Tage zahlreiche Spieletitel zum

vergünstigten Preis mit 50 % oder gar 75 % Rabatt. Dabei vertreten waren

nicht nur Indie-Titel wie Dungeons of Dredmor, Osmos, World of Goo, Aquaria

oder Bastion, wie der eine oder andere vielleicht denken möchte. Valve hat

einige ihrer eigenen Triple-A-Spiele portiert und bietet diese für Linux

an. Darunter u. a. Serious Sam 3, Team Fortress 2, Half-Life oder

Counter Strike: Source.

Natürlich sollte man immer im Hinterkopf behalten, dass die Nutzungsbestimmungen

von Steam alles andere als kundenfreundlich sind. Und es gab auch schon des

öfteren Meldungen, dass Spieler nicht mehr auf ihre teuer gekauften Spiele

zugreifen konnten, weil Steam den Zugang gesperrt hat. Ein Wiederverkauf ist

völlig ausgeschlossen.

Dennoch bietet Steam für Linux eine gute Chance, dass viele Nutzer, die Windows

als Zweit-OS zum Spielen aufgespielt haben, sich komplett von Microsoft lösen.

Mit Windows 8 setzt Microsoft alles daran, Windows-Nutzer zu vergraulen, und

da wird es den einen oder anderen sicherlich freuen, dass es Steam auch für

Linux gibt.

Im Endeffekt muss jeder selbst entscheiden, ob er das Angebot wahrnimmt. Mit

den Humble Bundles [2] gibt es für den

Spaß zwischendurch eine gute Alternative, die einen auch so lange genug

beschäftigen können.

Ende des sechsten Programmierwettbewerbs – jetzt wirklich!

Der sechste freiesMagazin-Programmierwettbewerb [3]

nahm in den letzten Monaten immer mal wieder Raum im Editorial ein.

Jetzt ist aber Schluss damit, denn der Wettbewerb ist zu Ende und die

Auswertung wurde durchgeführt. Die Gewinner, Daten und auch ein paar

Hintergrundinformationen können Sie in einem

Extra-Artikel nachlesen.

Und nun wünschen wir Ihnen viel Spaß beim Lesen der neuen Ausgabe.

Ihre freiesMagazin-Redaktion

Links

[1] http://www.pro-linux.de/news/1/19455/steam-fuer-linux-freigegeben.html

[2] http://www.humblebundle.com/

[3] http://www.freiesmagazin.de/sechster_programmierwettbewerb

Das Editorial kommentieren

Zum Index

von Hans-Joachim Baader

Das neu erschienene Fedora 18 will den Benutzern wie jedes halbe Jahr die

neueste freie Software und die neuesten Technologien bringen. Der Artikel zeigt

die Neuerungen und was es dabei zu beachten gibt.

Redaktioneller Hinweis: Der Artikel „Fedora 18“ erschien erstmals bei

Pro-Linux [1].

Überblick

Fedora 18 [2]

enthält eine Vielzahl von Neuerungen, von denen die wichtigsten im Laufe des

Artikels erwähnt und, soweit möglich, auch ausprobiert werden. Vorrangig

wird auf die Desktopumgebungen GNOME und KDE eingegangen.

Wie immer sei angemerkt, dass es sich hier nicht um einen Test der

Hardwarekompatibilität handelt. Es ist bekannt, dass Linux mehr Hardware

unterstützt als jedes andere Betriebssystem, und das überwiegend bereits im

Standard-Lieferumfang. Ein Test spezifischer Hardware wäre zu viel Aufwand

für wenig Nutzen. Falls man auf Probleme mit der Hardware stößt, stehen die

Webseiten von Fedora zur Lösung bereit.

Da eine Erprobung auf realer Hardware nicht das Ziel des Artikels ist,

werden für den Artikel zwei identische virtuelle Maschinen, 64 Bit, unter

KVM mit jeweils 1 GB RAM verwendet. Außerdem wurde ein Netbook mit

32-Bit-CPU aber funktionierender Grafikbeschleunigung, von Fedora 17 auf 18

aktualisiert.

Installation

Fedora kann von DVDs, Live-CDs oder minimalen Bootmedien installiert werden.

Natürlich kann man aus einem ISO-Image auch ein USB-Medium für die

Installation erstellen. Die Live-CDs, in den Varianten GNOME, KDE, LXDE und

Xfce, sind aufgrund ihres geringen Umfangs eher eine Notlösung für die

Installation, denn es fehlen dann unter anderem LibreOffice und

Übersetzungen. Zwar erfolgt die Installation binnen Minuten, da hierbei

offenbar mehr oder weniger nur ein Abbild der CD auf die Platte geschrieben

wird, aber für normale, vollständige Installationen sind die DVD oder das

minimale Image vorzuziehen, bei dem die eigentliche Distribution über das

Netz installiert wird.

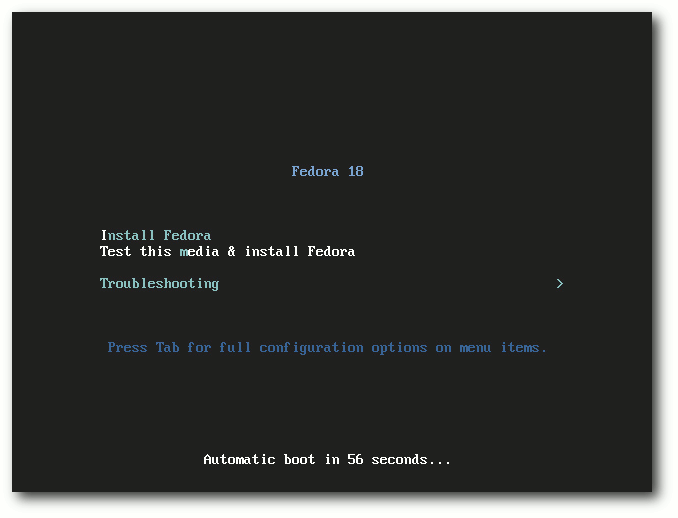

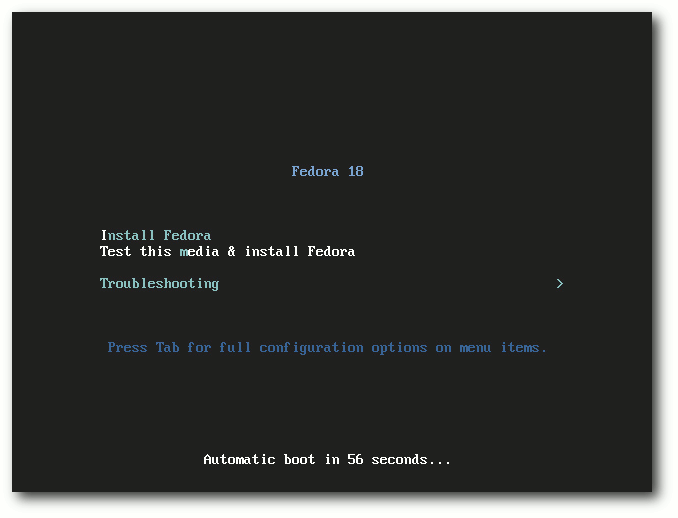

Bootscreen der DVD.

Die Installation von Fedora erfordert mindestens 786 MB RAM, wie schon in

Version 17 (siehe „Fedora 17“, freiesMagazin 08/2012 [3]. Für den Betrieb

werden mehr als 1 GB empfohlen, was aber allenfalls für ziemlich alte

Rechner zu einem Problem wird.

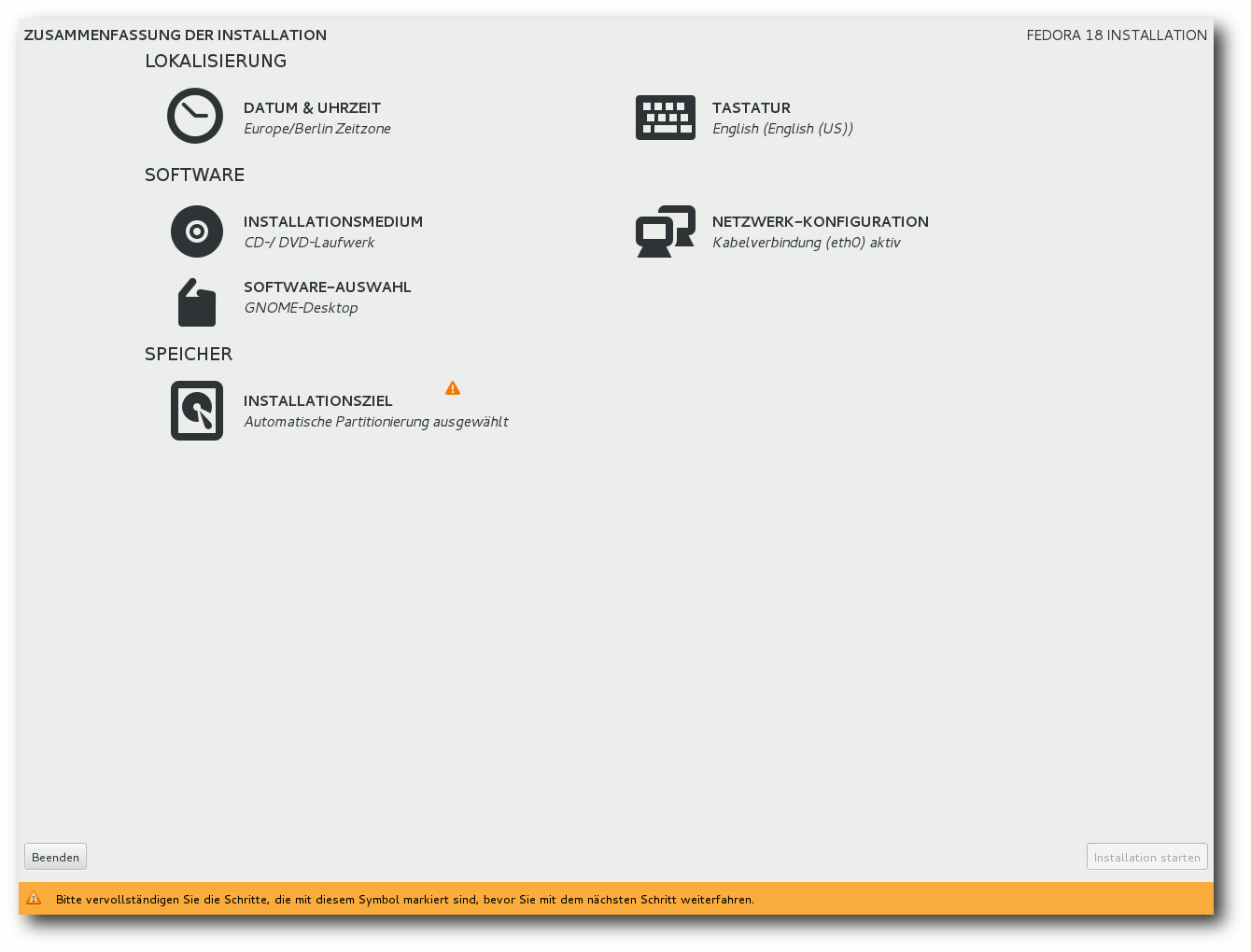

In Fedora 18 wurde das Installationsprogramm Anaconda gründlich überarbeitet

und seine

Oberfläche völlig neu

geschrieben [4].

Dies war der Hauptgrund für die außerordentliche Verzögerung der Freigabe

von Fedora 18 um über zwei Monate. Die neue Oberfläche soll einfacher zu

benutzen sein, aber dennoch alle Optionen bieten, wenn sie benötigt werden.

Bei der Sprachauswahl sollte man gleich die Option „Set keyboard“

aktivieren, sonst muss man die Tastatur später manuell konfigurieren. Danach

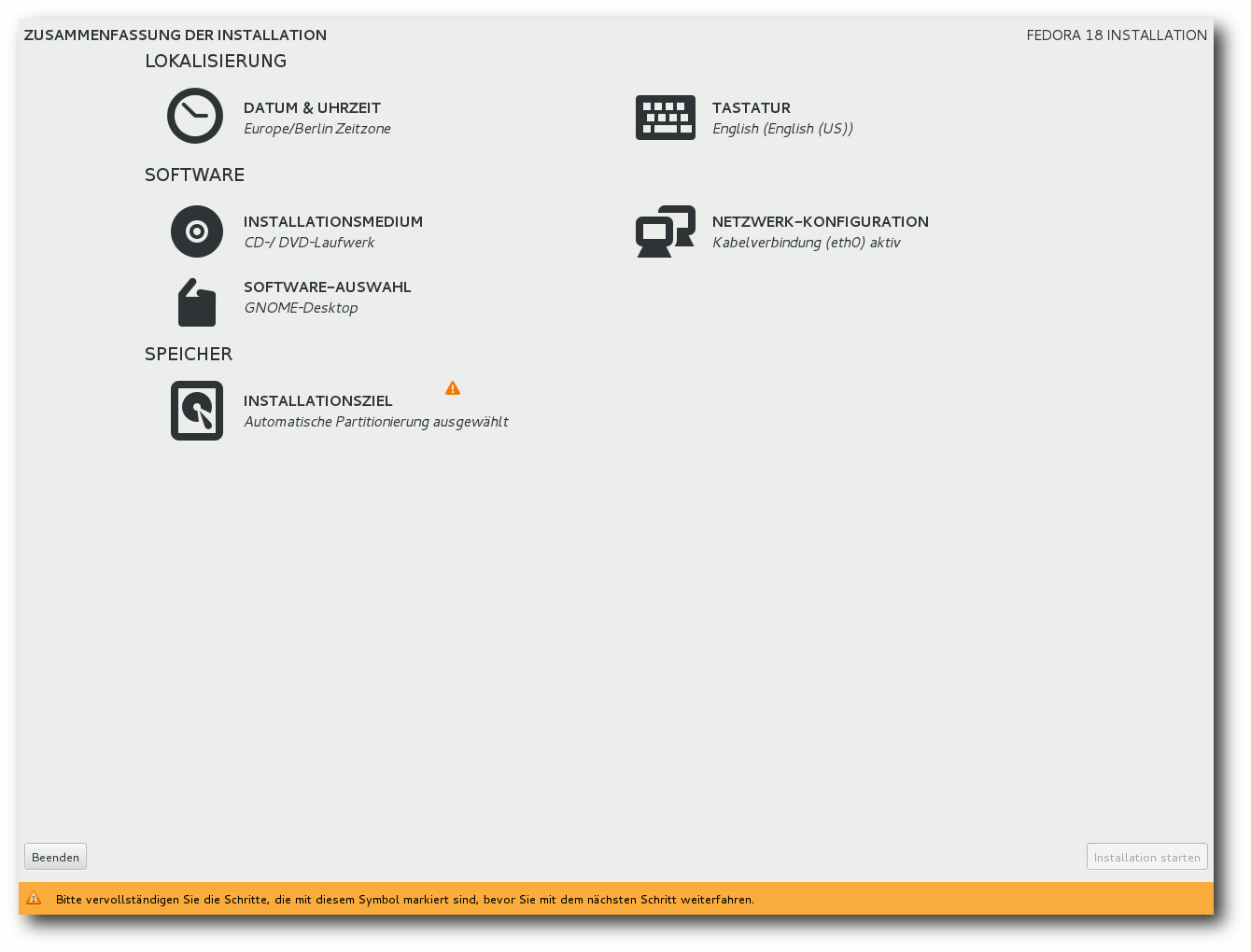

gelangt man in der neuen Installation zu einer Übersichtsseite. Warum hier

alle Texte in Großbuchstaben geschrieben wurden,

wissen wohl nur die

Entwickler. Auf der Seite sind alle Punkte, die vom Benutzer noch bearbeitet

werden müssen, mit einem gelben „Warndreieck“ markiert – als ob es ein

Fehler des Benutzers sei, dass diese Punkte noch offen sind.

Als erstes muss man das Installationsziel auswählen. Die erkannten

Festplatten werden durch ein Icon angezeigt, das allerdings die grundlegende

Information vermissen lässt, um welches Gerät (/dev/sda usw.) es sich

handelt. Stattdessen zeigen die Entwickler den Modellnamen des Gerätes an.

Hier gibt es ein schwerwiegendes Problem. Hat man zwei oder mehr Festplatten

desselben Modells verbaut, wie soll man sie unterscheiden? Ein Merkmal wäre

der Gerätename, ein anderes die Seriennummer – beides fehlt jedoch. Wenn man

plant, ein RAID-System einzurichten, mag das verschmerzbar sein, in anderen

Fällen besteht jedoch die Gefahr, dass man die falschen Partitionen

überschreibt. Bei genauerer Prüfung stellt sich

heraus [5], dass die

Entwickler die Platten auch in der falschen Reihenfolge anzeigen, was Fehler

geradezu herausfordert.

Bevor man die Installation starten kann, muss man die Installationsquelle

auswählen. Meist muss man hier nur die Vorgabe bestätigen, jedenfalls wenn

man von der DVD installiert. Warum die explizite Auswahl hier forciert wird,

obwohl man sie von der Übersichtsseite aus aufrufen kann, wenn man sie

braucht, ist nicht nachvollziehbar.

Auch die Software-Auswahl sollte man sich noch ansehen. Das sollte man

sowieso, wenn man nicht GNOME, sondern eine andere Oberfläche installieren

will, aber es ist auch nötig, häufig benötigte Anwendungen wie LibreOffice

explizit auszuwählen, sonst werden sie nicht mit installiert, und man muss

es später nachholen, was zusätzlichen Aufwand darstellt. Wenn man KDE

auswählt, sollte man darauf achten, dass auch Apper installiert wird,

ansonsten muss man später seine Software-Updates oder zusätzliche Programme

von der Kommandozeile aus installieren.

Zusammenfassung der Installation.

Nach Angaben der Entwickler ist Anaconda in dieser Version noch

unvollständig. Jedoch sind die gewohnten Optionen wie die Verschlüsselung

der gesamten Festplatte oder einzelner Partitionen, RAID und LVM vorhanden.

Auch das Dateisystem Btrfs wird wieder unterstützt, sogar mit seinen

spezifischen Funktionen wie Subvolumes. Wer die automatische Partitionierung

wählt, erhält eine LVM-Installation mit einer 500 MB großen

/boot-Partition und dem Rest als Root-Partition. Die Installation verlief

im Test unfallfrei, von den erwähnten Problemen abgesehen.

Wer bereits Fedora 17 installiert hat, kann mit dem Programm fedup auf

Version 18 aktualisieren. Üblicherweise bezieht man dabei die ca. 1400 zu

aktualisierenden Pakete über das Netz, aber auch andere Quellen sind

möglich. Das Update funktionierte problemlos, allerdings erst im zweiten

Anlauf. Anhand der Logdatei konnte man sehen, was passiert war: Das Update

schaufelt ein mehr als 300 MB großes Bootimage nach /boot. Ist nicht genug

Platz vorhanden, geht es schief, ohne dass der Benutzer informiert wird.

Dies dürfte dem Bugzilla-Fehler

#902498 [6] entsprechen.

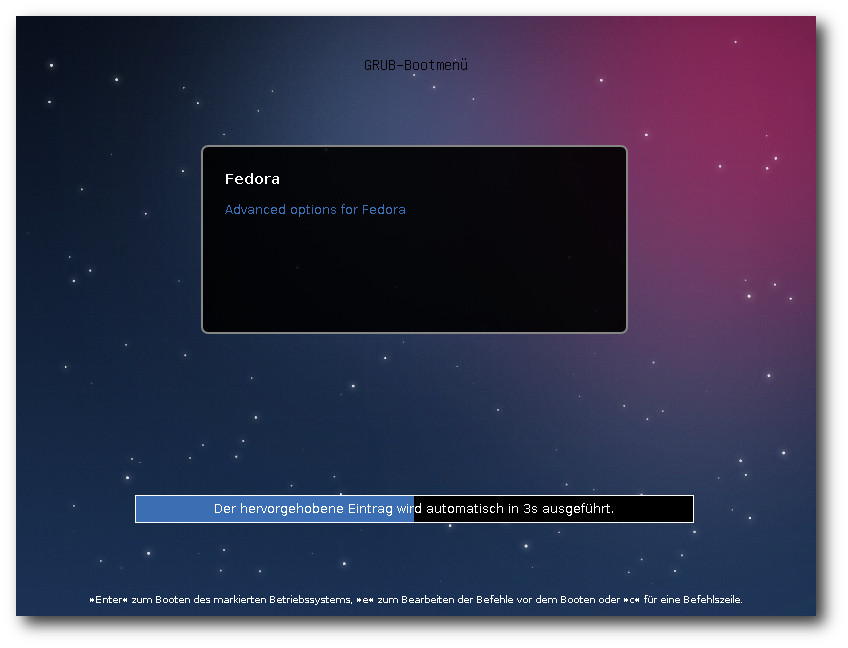

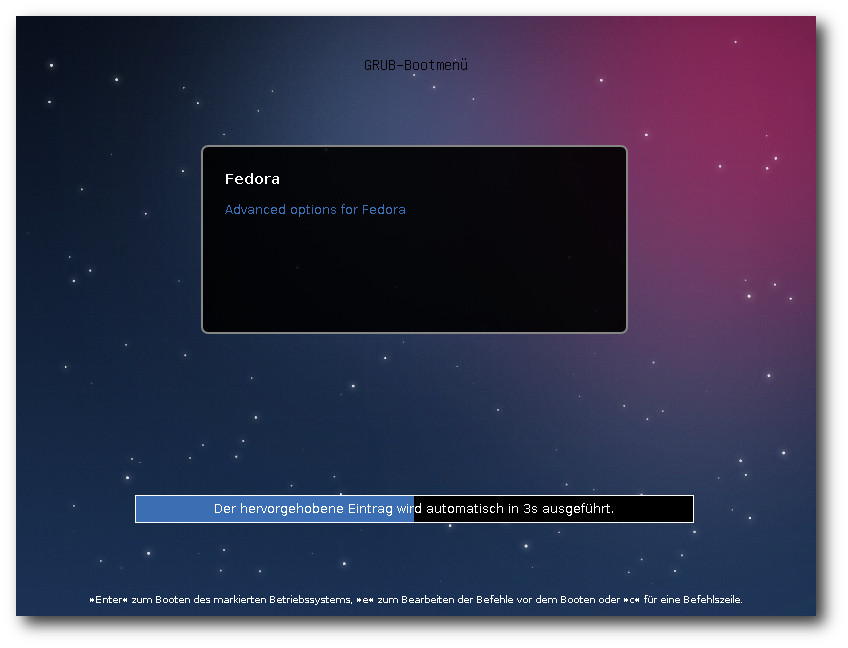

Bootscreen von Fedora 18.

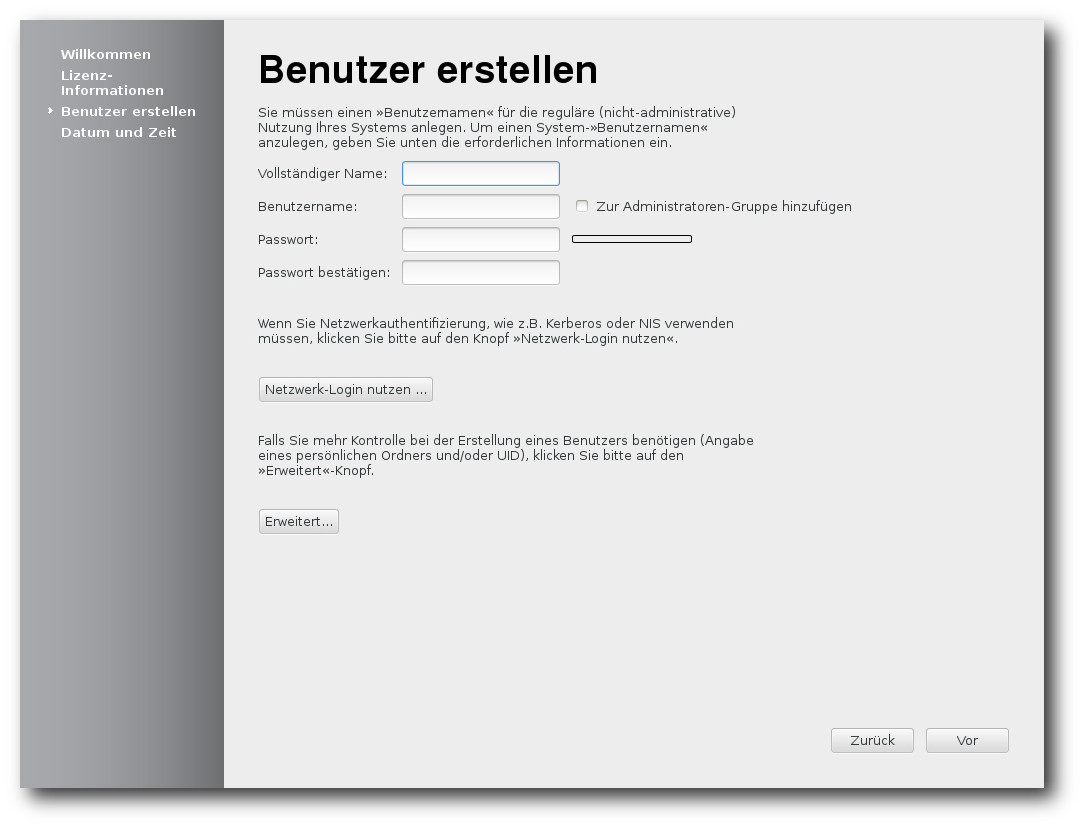

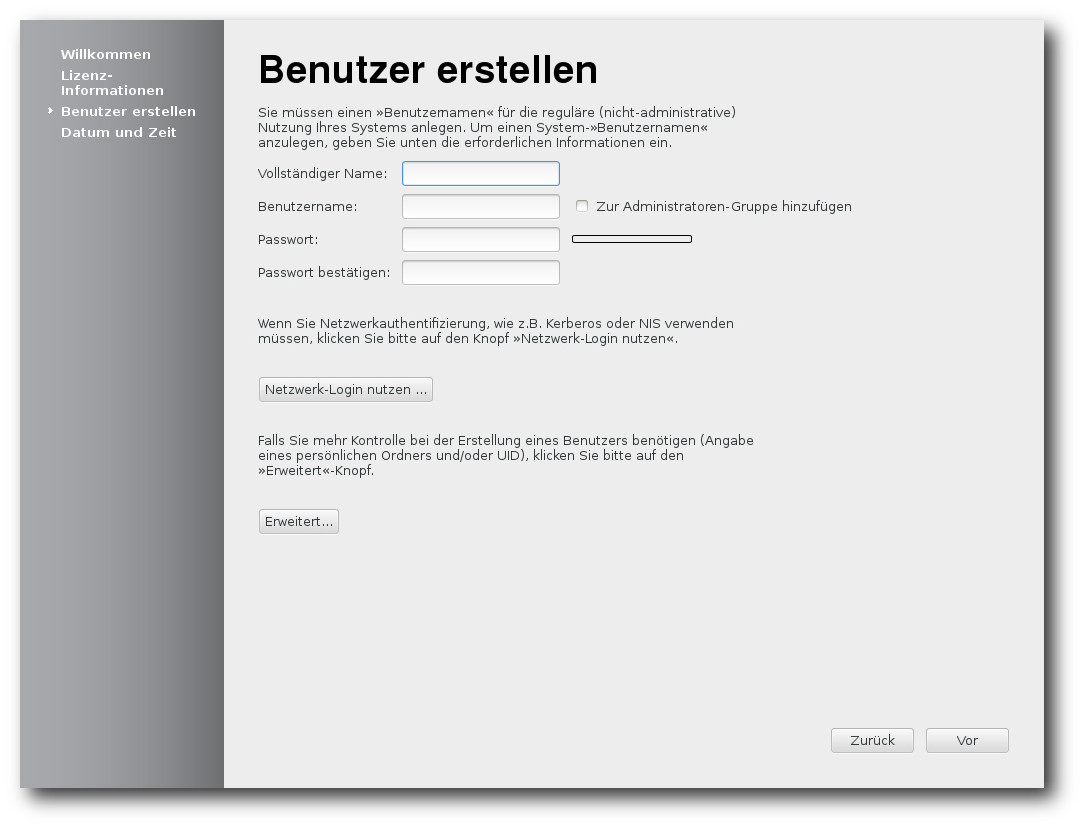

Beim ersten Booten des installierten Systems kommt das bekannte

Einrichtungsprogramm mit der Möglichkeit, Benutzer anzulegen.

Erstellung des ersten Benutzers.

Ausstattung

Der Kernel in Fedora 18 beruht auf Linux 3.7.2. Dazu gesellen sich

zahlreiche aktualisierte Softwarepakete. Fedora 18 enthält eine neue Version

des NetworkManagers, der die Nutzung von

WLAN-Hotspots [7]

deutlich erleichtern soll. Als Desktop-Umgebungen stehen in Fedora 18 unter

anderem KDE SC 4.9, GNOME 3.6, Xfce

4.10 und Sugar 0.98 zur Verfügung.

Außerdem wurden der GNOME-Fork Cinnamon und der GNOME2-Nachfolger Mate

aufgenommen. Die von Red Hat entwickelten Schriften „Liberation Fonts“

kommen in einer neuen Version. Avahi, die freie MDNS-Implementation, wird

auf Desktops standardmäßig aktiviert.

Administratoren finden in Fedora 18 unter anderem erstmals die

fehlertolerante und skalierbare NoSQL-Datenbank

Riak [8] und

Samba 4 [9], das SMB3 und

vertrauenswürdige Domänen von FreeIPA unterstützt. Ein Fedora 18-System soll

sich

auch leicht in eine Active Directory- oder FreeIPA-Domäne integrieren

lassen. Außerdem sind jetzt System-Updates

offline [10]

möglich, indem Pakete, die zuvor im Hintergrund heruntergeladen wurden, beim

Neustart des Systems in einem speziellen Update-Modus installiert werden,

bevor das reguläre System startet. Dadurch werden inkonsistente Zustände

vermieden, die bei Updates im laufenden System vorkommen können.

Für Administratoren ist es auch wichtig zu wissen, dass einige

Konfigurationsdateien in /etc/sysconfig nicht mehr verwendet werden

sollen. Stattdessen werden andere Dateien in /etc benutzt.

Einiges hat sich bei der Sicherheit getan. Die Installation unterstützt UEFI

Secure Boot. Der Daemon rngd, der dem Kernel-Zufallsgenerator zusätzliche

Entropie zuführen soll, wird standardmäßig installiert, aber nicht

gestartet. Mit SELinux und virt-sandbox können nun auch Dienste in sicheren

Sandkästen ausgeführt werden, auch als Root. Mit der Bibliothek libseccomp

können Anwendungen festlegen, welche Systemaufrufe sie ausführen wollen.

Qemu und KVM nutzen dies zur Erhöhung ihrer Sicherheit. Die Verwendung von

PolicyKit wurde weiter ausgedehnt.

Ein neues Kommandozeilenprogramm ssm (System Storage

Manager [11])

vereinheitlicht die Verwaltung von Speichergeräten, gleichgültig ob dabei

LVM, RAID oder Btrfs zum Einsatz kommen. Das Verzeichnis /tmp wird als

tmpfs im RAM

realisiert [12], was

sich aber ändern lässt. Ändern muss man es aber nur, wenn ein Programm gegen

die Konventionen verstößt und große Dateien in /tmp ablegt, statt den

Systempfad abzufragen oder als Fallback /var/tmp zu verwenden. Neu ist

FedFS [13], ein

Mechanismus, mit dem man eine konsistente Sicht auf den Dateibaum von

verschiedenen Dateiservern einrichten kann. Es ist allerdings noch im Status

einer Vorschau.

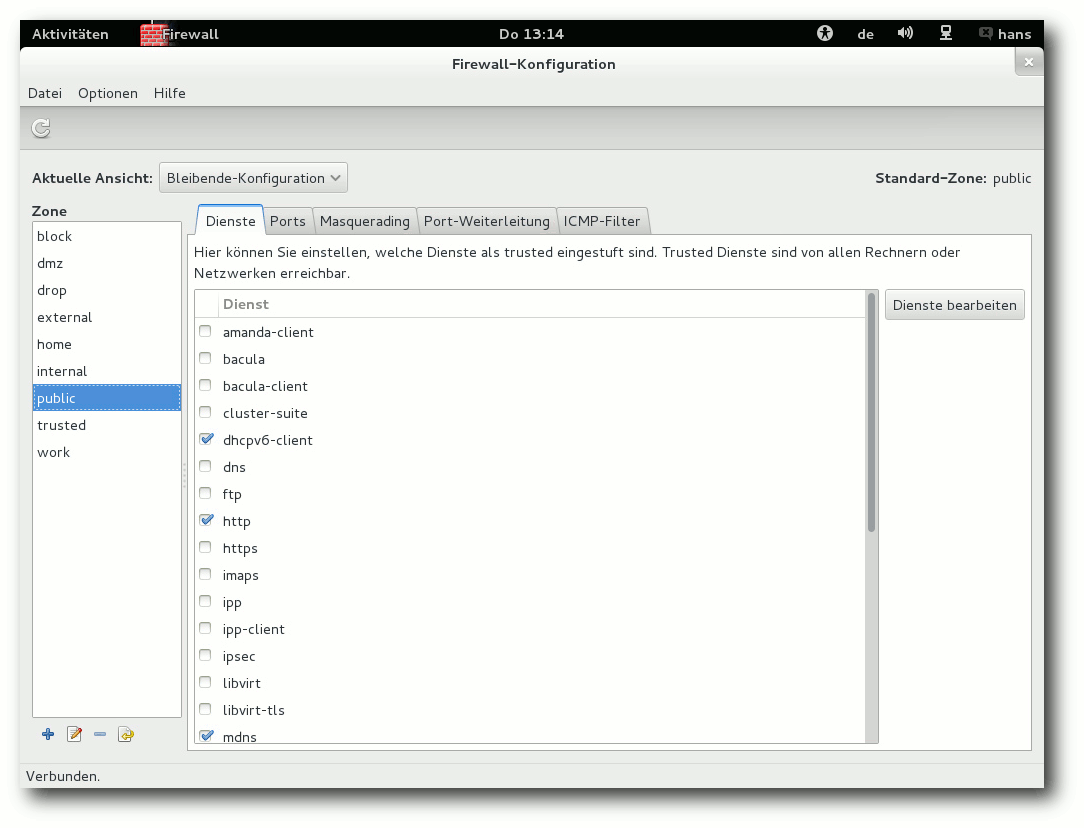

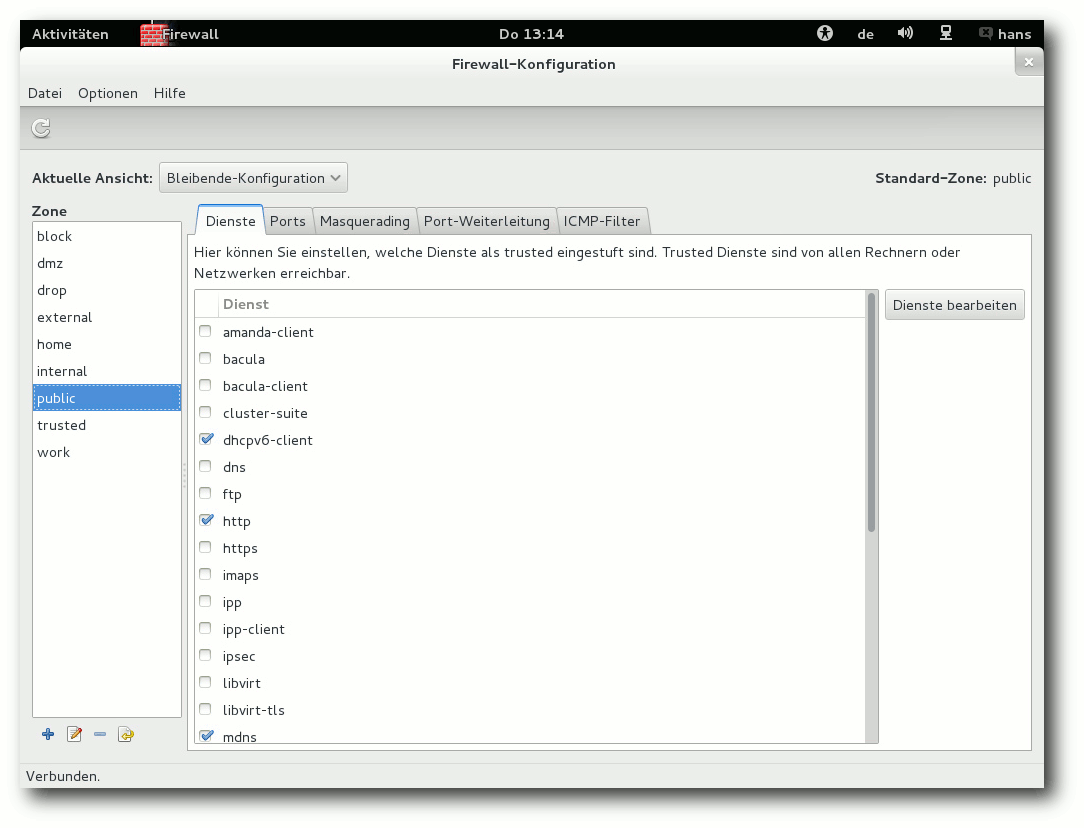

Firewalld [14] wird

anstelle von iptables standardmäßig als Firewall eingesetzt. Dadurch wird

die Firewall dynamisch und benötigt für Änderungen keinen Neustart mehr. Der

Paketmanager DNF ist erstmals als Alternative zu YUM verfügbar. In

einem

kurzen Test arbeitete er mindestens genauso schnell wie Yum, dem man

bekanntlich bisweilen mehr Geschwindigkeit wünscht, und teilweise auch

deutlich schneller. Yum besitzt aber wesentlich mehr Funktionen, vermutlich

ist DNF derzeit nur ein Extra. Systemtap, ein umfangreiches Trace-System,

wurde auf Version 2 aktualisiert; auch das Trace-System LTTng liegt in

Version 2.0 vor.

Firewall-Konfiguration.

Für Entwickler gab es zahlreiche Updates der Programmierumgebungen,

beispielsweise D und Haskell. Unterstützung für die Programmiersprache

Clojure kam neu hinzu. Perl (5.16), Python (3.3), Ruby on Rails (3.2) und

PHP wurden aktualisiert. Die Power7-Plattform ppc64p7 wird nun unterstützt.

Owncloud ist jetzt in der Distribution enthalten und Terminals können 256

statt nur 8 Farben nutzen.

Auch im Bereich Virtualisierung und Cloud wurde Fedora 18 erweitert.

OpenShift Origin, eine Platform-as-a-Service-Infrastruktur (PaaS), wurde

hinzugefügt. Mit Eucalyptus lassen sich private, Amazon-kompatible Clouds

verwalten. Die Plattform OpenStack für Infrastructure-as-a-Service (IaaS)

wurde auf die Version „Folsom“ aktualisiert, die alternative IaaS-Plattform

Eucalyptus auf Version 3.1. Das Projekt Heat zur

Orchestrierung von

Cloud-Anwendungen kam hinzu. Virt Live Snapshots machen es möglich,

Schnappschüsse von virtuellen Maschinen unter Qemu und libvirt zu machen,

ohne die Gastsysteme anzuhalten. oVirt wurde auf Version 3.1 gebracht und

enthält jetzt auch grafische Werkzeuge.

Fedora 18 startet etwa genauso schnell wie sein Vorgänger. Wie immer ist

SELinux eingebunden und aktiviert. Als normaler Benutzer merkt man überhaupt

nichts davon, solange die Konfiguration korrekt ist. In Fedora 18 wie auch

in der Vorversion trat kein sichtbares Problem im Zusammenhang mit SELinux

auf. Für den Fall, dass ein Problem auftritt, sei es nach der Installation

von zusätzlicher Software oder anderen Änderungen, steht ein

Diagnosewerkzeug zur Verfügung.

KDE benötigt in Fedora 18 direkt nach dem Start mit einem geöffneten

Terminal-Fenster etwa 420 MB RAM, Gnome dagegen hat sich auf 470 MB

aufgebläht, hauptsächlich durch die GNOME-Shell. Bei der Geschwindigkeit

lässt sich kein nennenswerter Unterschied zwischen den Desktops feststellen,

sofern genug RAM vorhanden ist. Die Angaben zum Speicherverbrauch sind nur

als Anhaltswerte zu sehen, die sich je nach Hardware und Messzeitpunkt

erheblich unterscheiden können.

GNOME

GNOME 3.6 ist der Standard-Desktop von Fedora 18, wenn man nicht

ausdrücklich KDE, Xfce,

oder anderes auswählt. Gegenüber GNOME 3.4 ist

der Menüpunkt Ausschalten anstelle des als nutzlos kritisierten Suspendieren

zurückgekehrt. Die Aktivitätenübersicht der GNOME-Shell besitzt nun einen

Gitter-Button in der Startleiste (Dash), mit dem man angeblich schnell zu

einzelnen Anwendungen wechseln kann. Schnell ist daran allerdings nichts,

weil man dennoch meistens nach der Anwendung suchen muss. Die Eingabe von

Suchbegriffen soll durch das Hervorheben der Suchleiste vereinfacht werden.

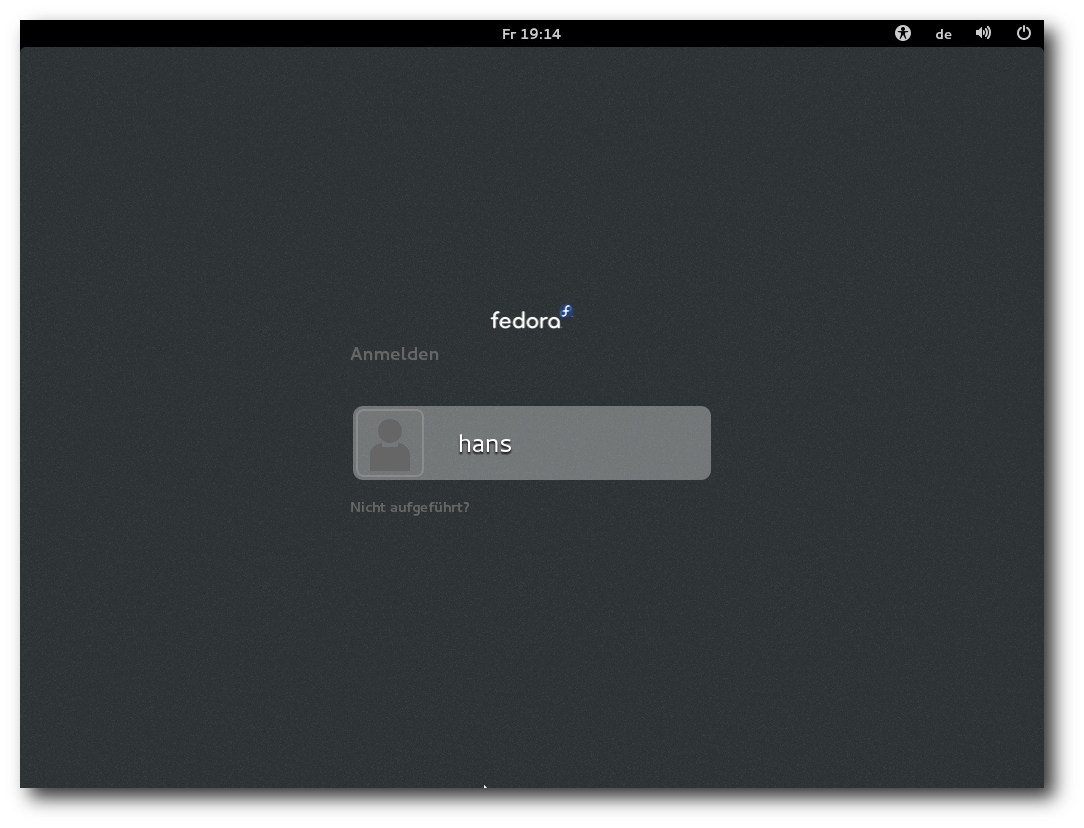

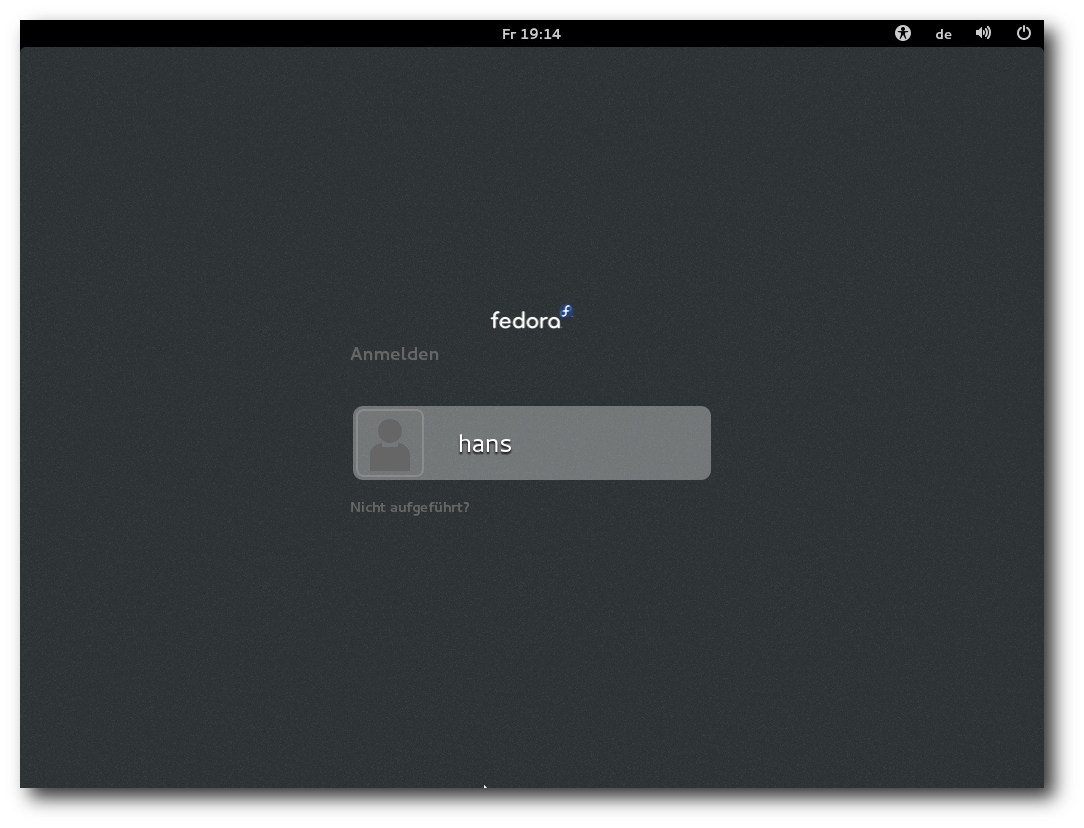

Der Login-Bildschirm von GNOME.

Das Sperren des Bildschirms folgt nun dem Paradigma einer Jalousie, die vor

dem Bildschirm heruntergezogen wird, und wurde direkt in die GNOME-Shell

eingebaut. Der gesperrte Bildschirm zeigt eine große Uhr,

Anpassungsmöglichkeiten fehlen. Der gesperrte Bildschirm

erlaubt aber auch

das Anhalten und Ändern der Lautstärke, falls Audio abgespielt wird. Das

kann man zu Recht kritisch sehen. Überdies werden auch Benachrichtigungen

eingeblendet, was allerdings abschaltbar ist. Doch es ist paradox, dass

ausgerechnet eine Funktion, bei der es keiner Option bedarf – die

Privatsphäre gebietet es, dass keinerlei Benachrichtigungen in Abwesenheit

des Benutzers angezeigt werden – eine Option besitzt und auch noch die

falsche Standardeinstellung hat, während das GNOME-Team sonst jegliche

individuellen Einstellungen verweigert, jedenfalls in der grafischen

Oberfläche.

Eine der wichtigsten Neuerungen ist ferner die Überarbeitung der

Benachrichtigungen. Früher wurden Benachrichtigungen am oberen

Bildschirmrand unter der Systemleiste eingeblendet; nun haben sie eine

eigene Leiste am unteren Bildschirmrand erhalten, die aber nur eingeblendet

wird, wenn man mit der Maus für einen Moment an den unteren Bildschirmrand

fährt. Wenn die Leiste eingeblendet wird, überlappt sie sich nicht mit den

Bildschirminhalten, sondern schiebt diese nach oben. Die Elemente in der

Leiste wurden größer, klarer und verschieben sich nicht. Die

Benachrichtigungen selbst können geschlossen werden, und einige davon bieten

die Möglichkeit, direkt auf sie zu reagieren, beispielsweise durch Eingabe

einer Antwort in ein Instant-Messaging-System. Wenn man mit einer Anwendung

im Vollbildmodus arbeitet oder ein Spiel spielt, werden nur wichtige

Nachrichten angezeigt, die anderen werden erst später präsentiert. Wie sich

diese Änderung in der Praxis bewährt, kann dieser Test nicht aufzeigen.

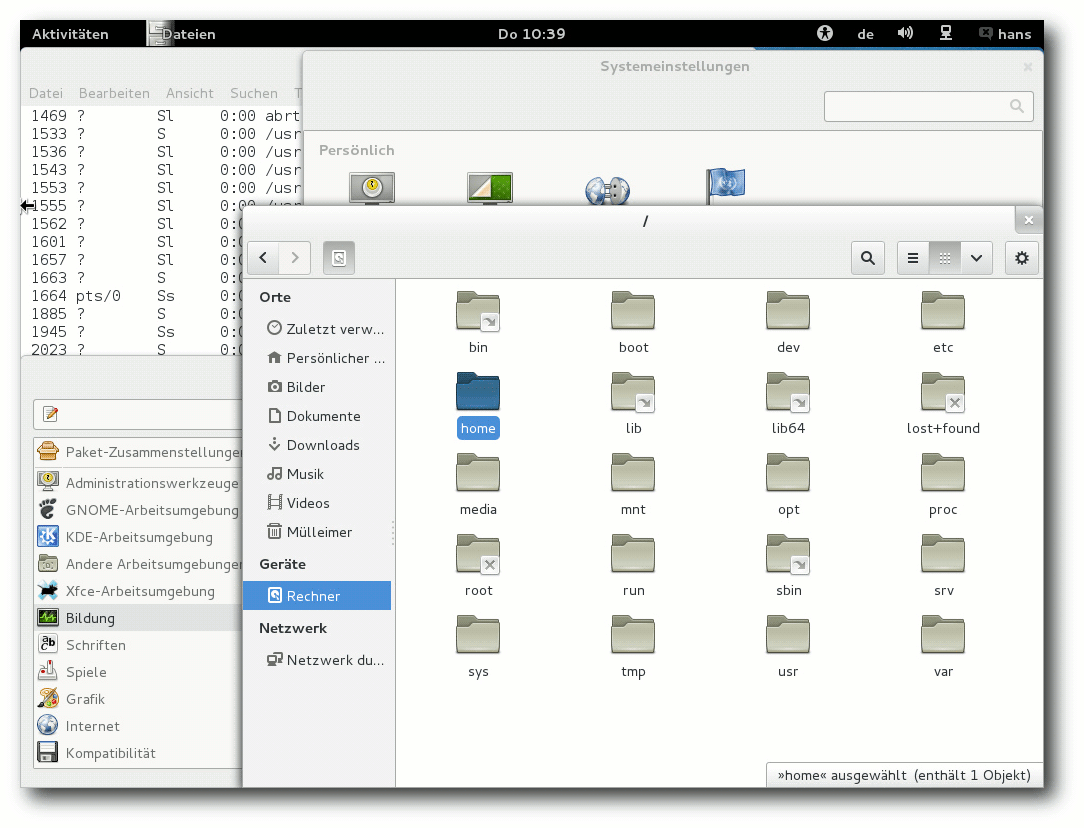

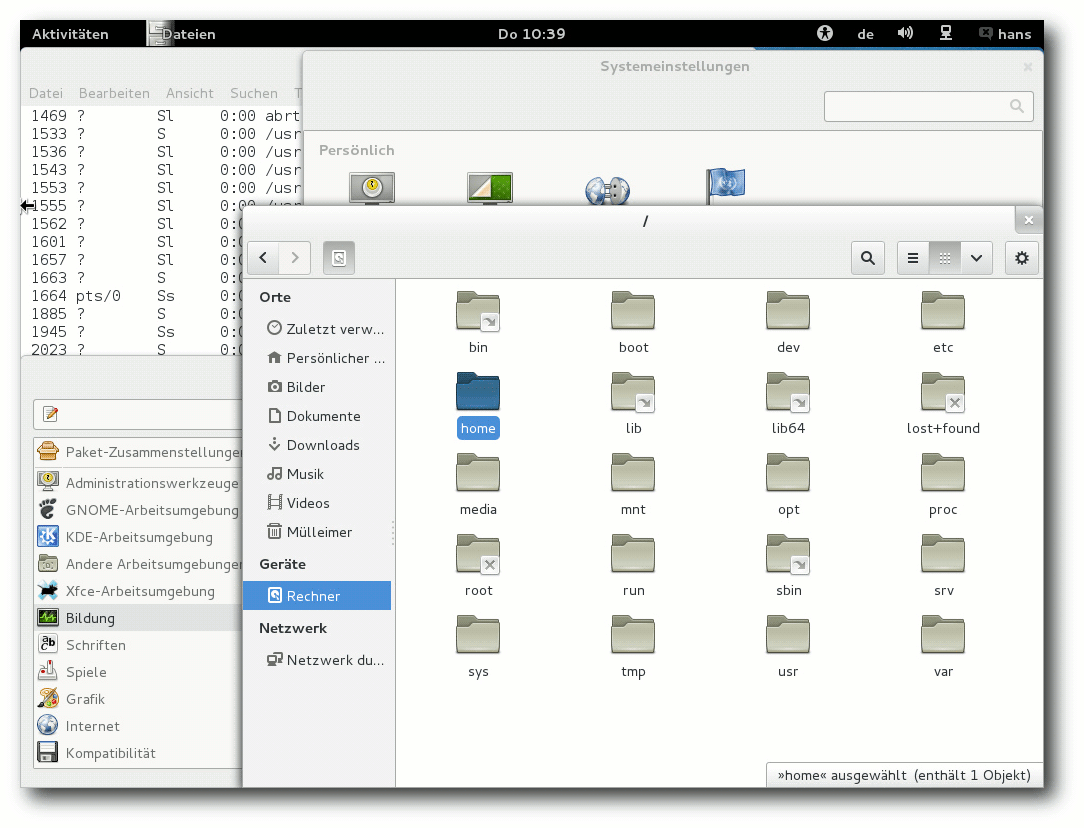

Desktop von GNOME 3.6 mit Anwendungen.

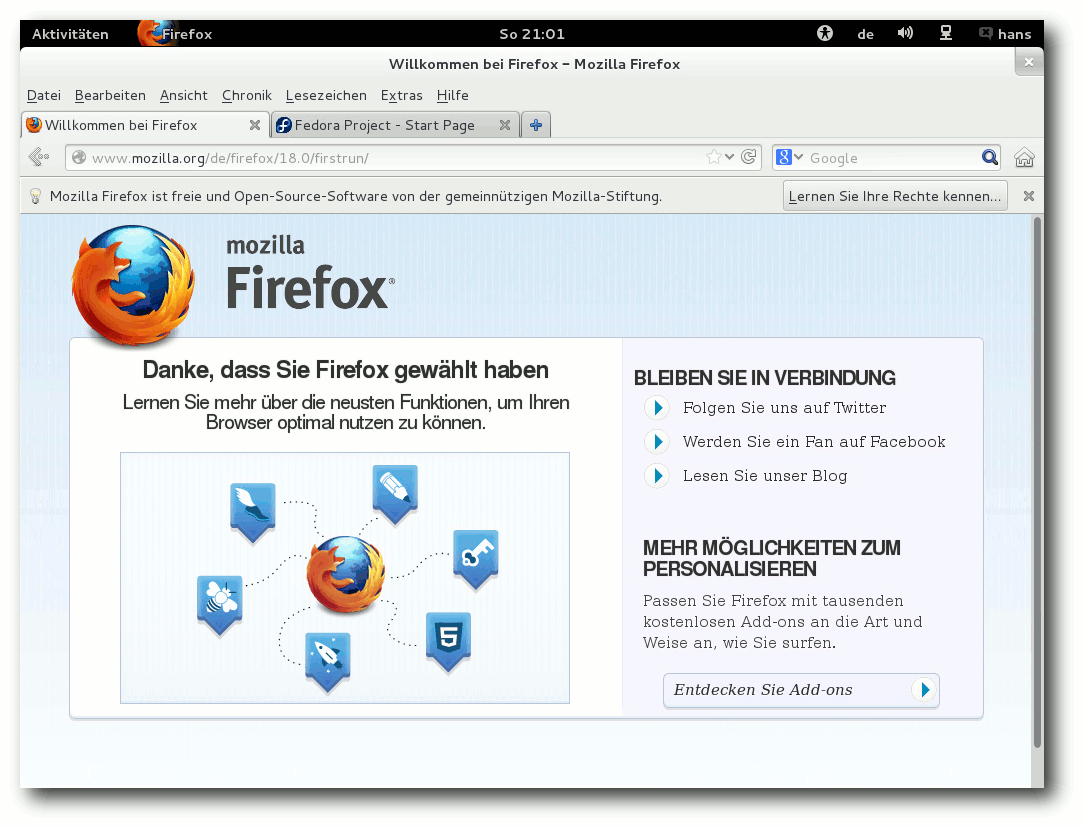

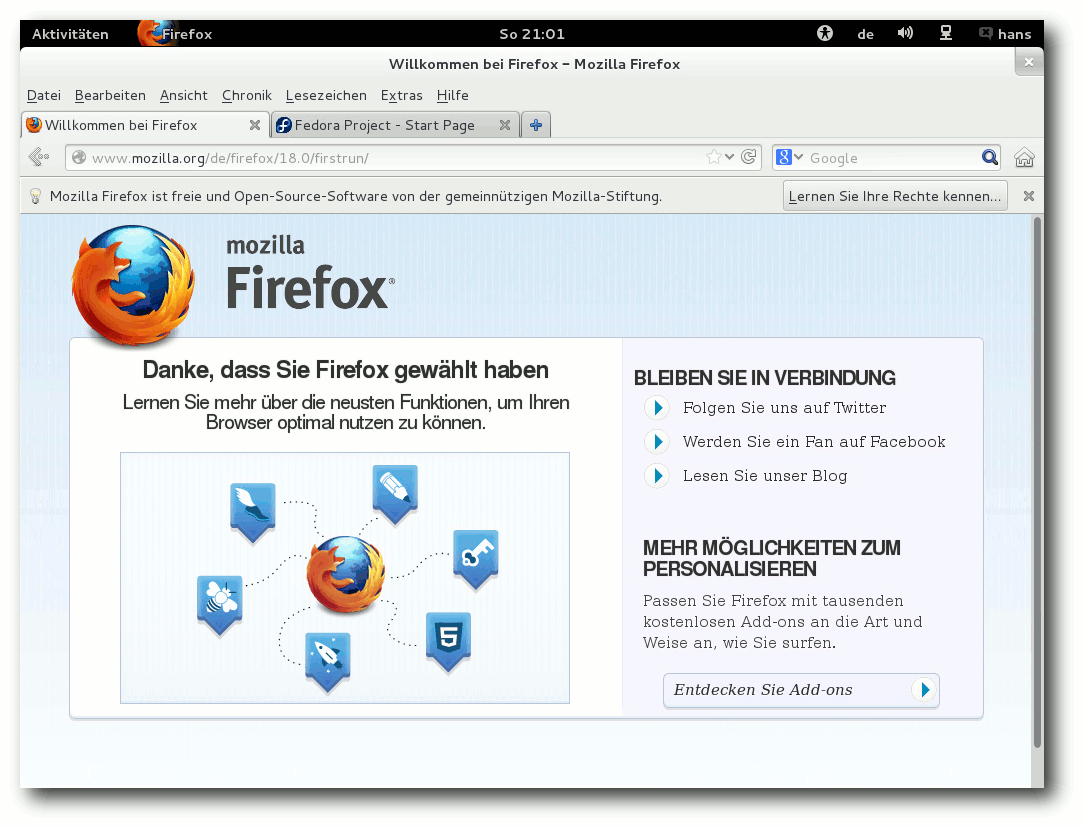

Der Standard-Webbrowser unter GNOME ist Firefox 18.0, nicht der mit GNOME

mitgelieferte. Der Dateimanager Files, ehemals Nautilus, erhielt eine stark

verbesserte Suchfunktion, leichten Zugriff auf kürzlich benutzte Dateien,

verbesserte Werkzeug- und Seitenleisten, bessere Menüorganisation und

Optionen zum Verschieben oder Kopieren an einen ausgewählten Ort. Allerdings

wurden auch Funktionen entfernt, die von einigen Benutzern geschätzt wurden.

Der Webbrowser Web erhielt eine Übersicht, wie sie auch andere Browser

bieten, und einen

verbesserten Vollbildmodus. Weitere erwähnenswerte

Verbesserungen sind die vollständige Integration von Funktionen zur

Barrierefreiheit, also zur Unterstützung von Anwendern, die verschiedene

Arten von Behinderungen aufweisen, und die Integration von alternativen

Eingabemethoden, wie sie zur Eingabe vieler nichteuropäischer Schriften

benötigt werden.

Firefox 18.0 unter GNOME 3.6.

Die GNOME-Shell kann dank Software-Rendering auf jeder Hardware laufen, der

Fallback-Modus steht optional aber noch zur Verfügung. Im Gegensatz zu Unity

unter Ubuntu 12.10 ist das Software-Rendering aber einigermaßen schnell und

durchaus noch benutzbar, doch beim Abspielen von Videos versagt es. Das

globale Menü für Anwendungen ist weiterhin nicht mit der Tastatur

erreichbar, und Tastenkürzel für die Menüpunkte fehlen. Weiter fehlt es an

Möglichkeiten, GNOME nach eigenen

Vorstellungen zu konfigurieren. Zum Glück

ist es möglich, über Erweiterungen der GNOME-Shell einiges zu ändern, und

einige dieser Erweiterungen sind über die Paketverwaltung verfügbar.

Anwendungsübersicht in der GNOME-Shell.

Die neue Anwendung Boxes enttäuscht durch einen gravierenden Mangel an

Einstellungen. Virtuelle Maschinen sind komplexe Gebilde mit vielen

Optionen, da können die wenigen Optionen, die Boxes bietet, nur einige

völlig anspruchslose Fälle abdecken. Ähnlich primitiv ist die

Dokumentenverwaltung, die zudem nutzlos ist, wenn man nicht bereit ist,

Dokumente in irgendwelche Clouds zu stellen.

KDE

KDE ist in Version 4.9 enthalten, aber jetzt nur noch ein „Spin“ von Fedora.

Es gibt eine KDE-Live-CD, aber keine Installations-DVD mehr. Zur

Installation verwendet man jetzt die

Fedora-Installations-DVD und bei

der Software-Auswahl wählt man KDE sowie die benötigten Anwendungen aus. Den

Umfang der installierten KDE-Anwendungen bestimmt man damit selbst.

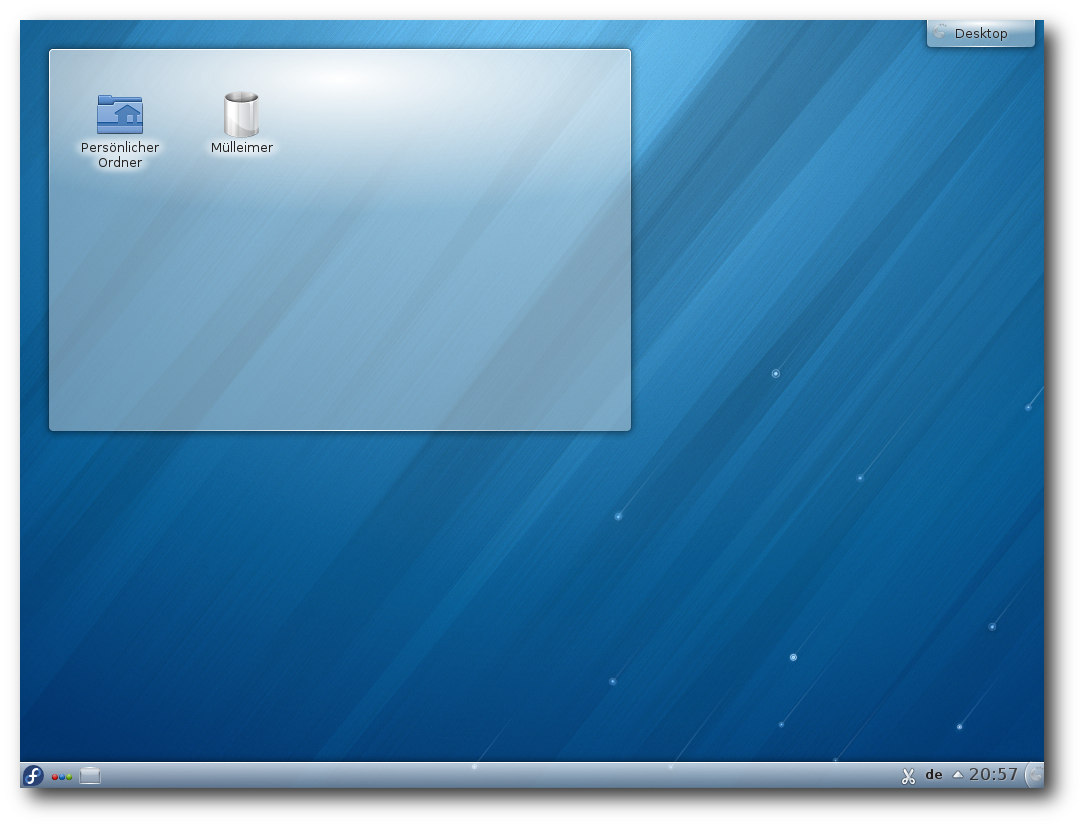

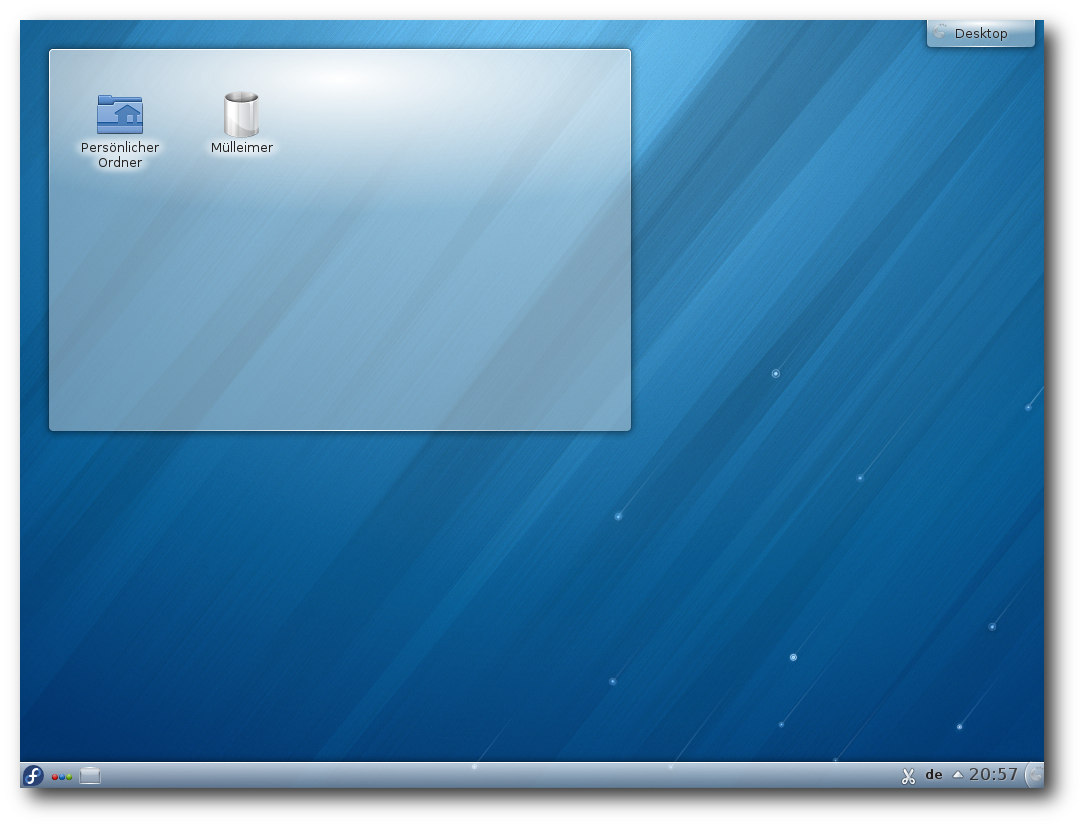

Desktop von KDE 4.9.

KDE 4.9 setzt noch mehr auf Qt Quick. Insgesamt halten sich die größeren

Änderungen gegenüber KDE 4.8 in Grenzen. Eine Reihe von Verbesserungen gab

es im Dateimanager Dolphin und in der Terminal-Emulation Konsole. Viele

weitere Anwendungen und Spiele bekamen kleinere neue Funktionen und

Verbesserungen.

Die Aktivitäten wurden stärker mit Dateien, Fenstern und anderen Ressourcen

integriert. Es soll jetzt leichter sein, Dateien und Fenster einer Aktivität

zuzuordnen und so die eigenen Arbeitsflächen passender zu organisieren. Die

Ordneransicht kann nun Dateien anzeigen, die zu einer Aktivität gehören, und

es so erleichtern, die Dateien

in sinnvolle Zusammenhänge zu stellen.

Private Aktivitäten können verschlüsselt werden. Der Window-Manager KWin

erhielt Änderungen, so dass man Fensterregeln für Aktivitäten definieren kann.

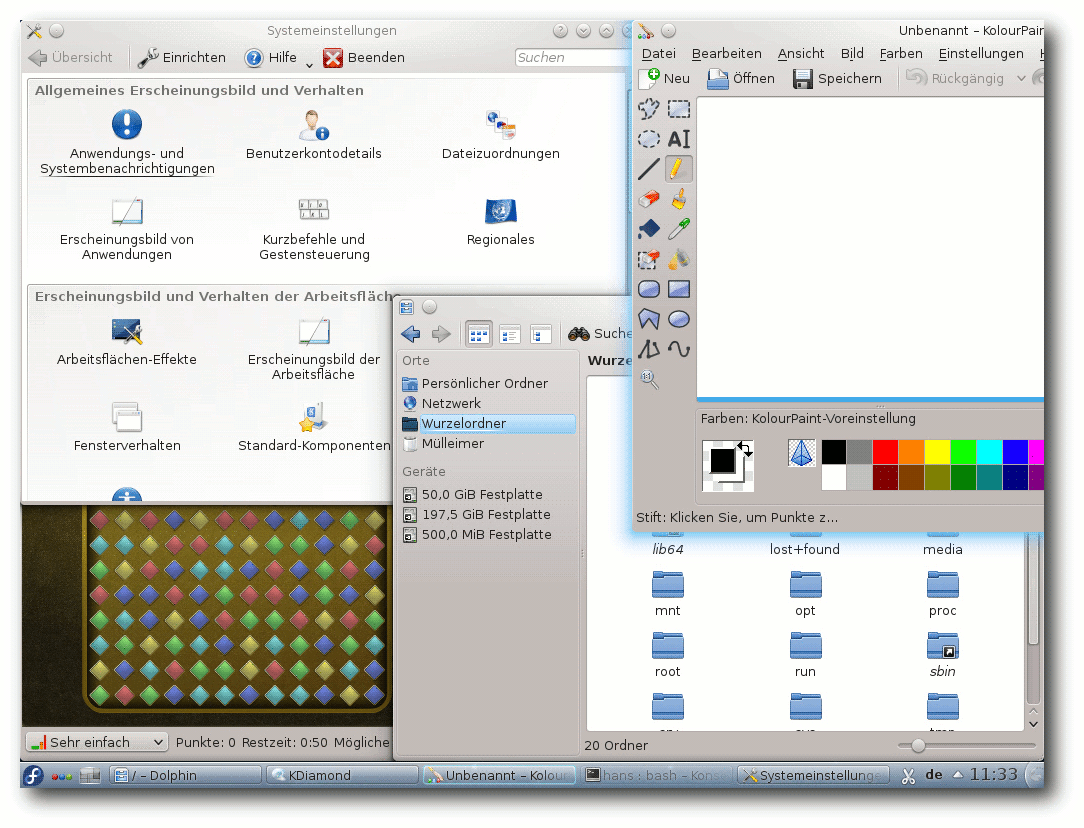

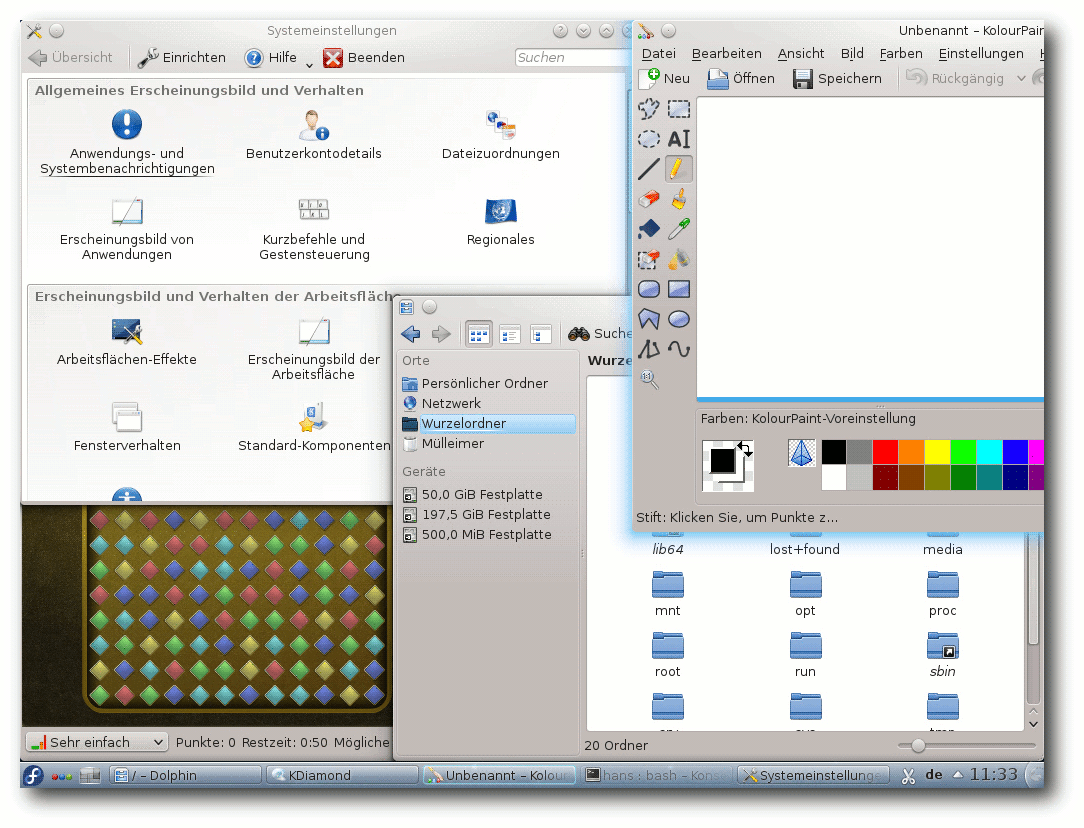

Desktop von KDE 4.9 mit Anwendungen.

KDE ist im Prinzip der exakte Gegenpol zu GNOME. Hier sind die

traditionellen Bedienelemente unbeschädigt erhalten und es gibt

Einstellungsmöglichkeiten bis zum kleinsten Detail. Die Plasma-Oberfläche

für Mobilgeräte ist vollständig separat von der Desktop-Variante und kann

diese daher auch nicht beeinträchtigen. Die Anwendungen bieten einen großen

Funktionsumfang und sind konfigurier- und erweiterbar. Natürlich gibt es

bisweilen andere freie Anwendungen,

die den KDE-Anwendungen überlegen sind

oder von einigen Benutzern bevorzugt werden, aber viele KDE-Anwendungen sind

gut und nützlich.

Die Kritikpunkte an KDE sind dieselben wie eh und je: KDEPIM wird des

öfteren kritisiert, besonders KMail. Da ich selbst noch nie KMail-Benutzer

war, kann ich dazu nichts weiter sagen, aber es sieht so aus, als ob die

KDEPIM-Entwickler einiges an der Robustheit der Software verbessern müssten,

um ihren Ruf wieder herzustellen. Aktivitäten sind trotz aller

Verbesserungen in den letzten Versionen etwas, was von vielen nur als

unnütze Komplexität angesehen wird, weil sie keinen Nutzen erkennen. Ich dachte, dass

man mit Aktivitäten eine Gruppe von Anwendungen gemeinsam starten und

stoppen könnte; das könnte wirklich nützlich sein. Tatsächlich sind

Aktivitäten, die man einmal definiert hat, immer vorhanden. Man kann sie

zwar stoppen, aber ihre Anwendungen laufen weiter. Speicherplatz lässt sich

so offenbar nicht sparen. Welchen Nutzen aber haben sie dann, den man mit

virtuellen Desktops nicht erzielen könnte? Leider sind derzeit Menüpunkte

und Optionen zu Aktivitäten überall in Plasma vorhanden, angefangen mit dem

Button oben rechts auf dem Desktop, der sich nicht entfernen lässt.

Es

sollte eine Möglichkeit geben, alle Optionen auszublenden.

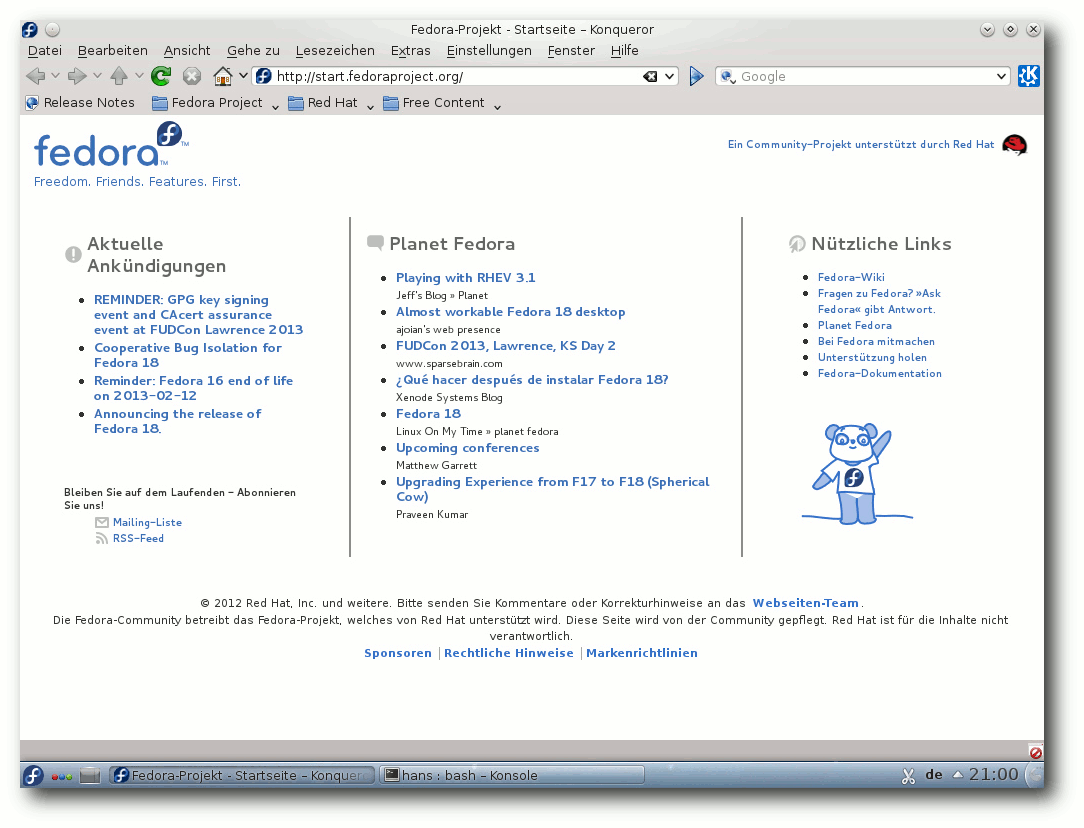

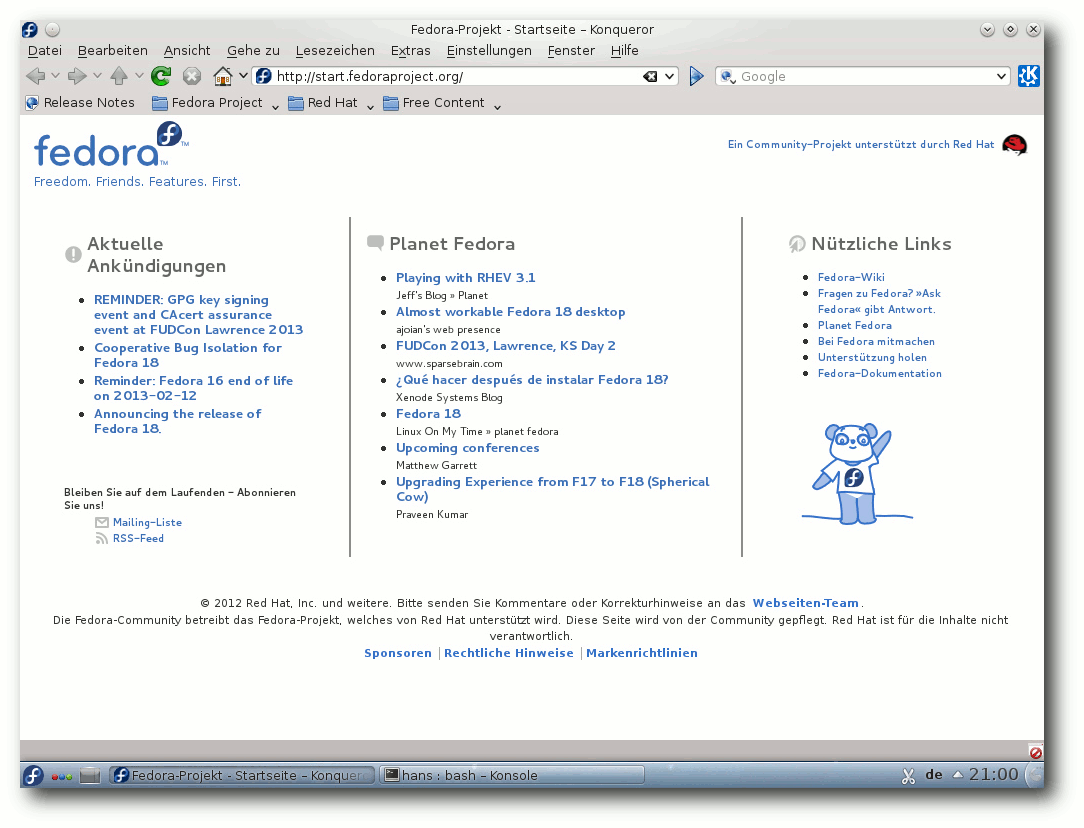

Konqueror.

Ein weiteres Problem werden wohl viele Benutzer schon erlebt haben, die sich

an einem frisch installierten KDE einloggen wollten: Man kommt nicht weit,

der Desktop stürzt einfach ab. Der Grund ist der, dass standardmäßig

zahlreiche Effekte eingeschaltet sind, und je nach Hardware und

Grafiktreiber kann da Vieles schiefgehen. Die Lösung besteht darin, sich im

„abgesicherten Modus“ einzuloggen und die Effekte abzuschalten. Korrekt

wäre, alle Effekte standardmäßig abzuschalten, so wie es beispielsweise Suse

Linux Enterprise macht. Wenn ein Benutzer Effekte aktiviert, dann auf

eigenes Risiko, und wenn das einen Absturz zur Folge hat, sollte ihm dann

klar sein, woran es lag.

Multimedia im Browser und Desktop

Wegen der Softwarepatente in den USA kann Fedora, ebenso wie die meisten

anderen Distributionen, nur wenige Medienformate abspielen, da es viele

benötigte Codecs nicht mitliefern kann. Wenn man versucht, eine MP3- oder

Videodatei abzuspielen, dann bieten die gängigen Player aber die Option an,

über die Paketverwaltung nach passenden Plug-ins zu suchen.

Damit die Suche in der Paketverwaltung Aussicht auf Erfolg hat, muss man

vorher die zusätzlichen Repositories von RPM Fusion eintragen. Das muss man

wissen oder durch Suchen herausfinden. Die Repositories kann man eintragen,

indem man die Webseite von RPM Fusion [15] besucht.

Von dieser kann man Pakete installieren, die die Repositories hinzufügen.

Dies gilt für GNOME wie für KDE.

Nach dieser Vorbereitung sollten die Player unter GNOME und KDE in der Lage

sein, die benötigten Plug-ins selbsttätig zu installieren. Merkwürdigerweise

hat Totem aber ein Problem, wenn man ausgerechnet mit der Suche nach einem

MP3-Plug-in anfängt und noch keine Codecs installiert sind – diese Suche

schlägt fehl. Bei Videoformaten funktioniert es aber. Am schnellsten und

einfachsten ist allerdings eine manuelle Installation der GStreamer-Plugins,

insbesondere gstreamer-ugly und gstreamer-ffmpeg. Denn wenn man die

Plug-ins von Totem installieren lässt, treten, wie schon in der Vorversion,

eine Reihe von Merkwürdigkeiten auf:

- Nach der Installation muss Totem neu gestartet werden, sonst sieht er die

neuen Plug-ins nicht.

- Das Spiel mit Suchen und Installieren muss ggf. mehrmals wiederholt

werden, denn das Programm scheint unfähig zu sein, alle benötigten Codecs

auf einmal zu ermitteln.

- Zur Installation ist die Eingabe des eigenen Passworts nötig. Trotz

korrekter Eingabe schreibt die Dialogbox jedoch „Entschuldigung, das hat

nicht geklappt“, nur um dann fortzufahren und die Pakete korrekt zu

installieren.

Totem erscheint bei Installation von DVDs auch unter KDE als

Standard-Medienplayer, auch für MP3-Dateien. Das hängt wohl damit zusammen,

dass bei der KDE-Installation eine Menge GNOME-Pakete mitinstalliert werden.

Dragonplayer ist als Alternative installiert.

Die Flash-Situation in den Browsern bleibt mittelmäßig. Ohne den Adobe Flash

Player geht nicht allzuviel. Nichts hat sich bei Gnash getan, das bei

Version 0.8.10 blieb. Es kann viele Flash-Videos im Web nicht abspielen. Die

freie Alternative Lightspark ist jetzt in Version 0.7.1 in den Repositories

von RPM Fusion enthalten und kann vermutlich einige Videos mehr abspielen.

Konqueror, der Standard-Browser unter KDE, stürzte beim Versuch, ein

Youtube-Video abzuspielen, ab. Offensichtlich verwendet man besser einen

anderen Browser unter KDE.

Bei der Installation des Adobe Flash Players kann man ähnlich vorgehen wie

bei RPM Fusion. Zunächst lädt man von Adobe eine RPM-Datei herunter, die das

Repository anlegt. Dann kann man über die Paketverwaltung das eigentliche

Plug-in installieren. Die Alternative zu Flash, das WebM-Format, sollte in

Firefox seit Version 4 kaum Probleme bereiten.

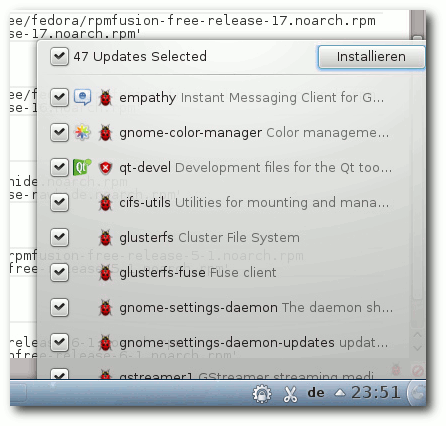

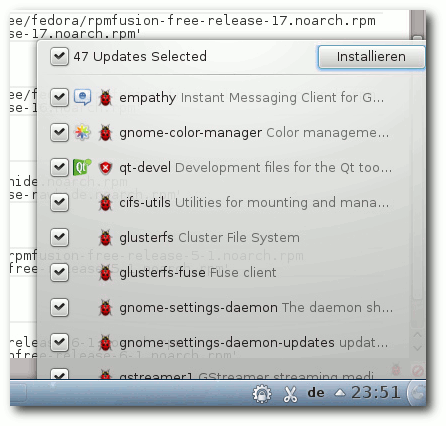

Paketverwaltung und Updates

Wenig hat sich bei der Paketverwaltung getan. Installation bzw.

Deinstallation und das Aktualisieren von Paketen sind weiterhin separate

Anwendungen, die aber auch von der Paketverwaltung aus aufgerufen werden

können. Sie funktionieren normalerweise reibungslos und die Updates, wenn

sie auch zahlreich sind, sind dank Delta-RPMs oft erstaunlich klein und

schnell installiert.

Die Paketverwaltung baut unter GNOME und KDE grundsätzlich auf PackageKit

auf. Die Programme – gpk-application 3.6.1 bzw. apper 0.8.0

– sind

komfortabel genug. Etwas Vergleichbares wie das Software Center von Ubuntu

bietet Fedora jedoch nicht.

Installation von Updates in KDE von der Benachrichtigung aus.

Etwas merkwürdig ist, dass man beim ersten Update gefragt wird, ob man der

Paketquelle vertraut. Eigentlich sollten die Schlüssel der

Standard-Repositories bereits vorinstalliert sein und Fedora sollte seinen

eigenen Quellen automatisch vertrauen.

Fazit

Fedora 18 wurde von einigen Benutzern, darunter sogar Alan Cox, als die

bisher schlechteste Version bezeichnet, und das mag sogar zutreffen.

Allerdings muss man das relativieren. Die Kritik, die beispielsweise

hier [5] sehr

überzogen wirkt, bezieht sich hauptsächlich auf das neue Anaconda und GNOME.

Andere Fehler werden meistens schnell behoben und werden wesentlich

seltener, je länger man mit dem Update wartet. Zu Anaconda ist festzuhalten,

dass es im Test keine Probleme gab. Er mag stellenweise unvollständig und

noch nicht optimal bedienbar sein, kann dann aber so schlecht doch nicht

sein. Zudem werden viele Benutzer einfach ein Update mit fedup durchführen

und mit Anaconda gar nichts zu tun haben. Mehr als 400 Updates in den ersten

fünf Tagen allein in der Standardinstallation dürften einen neuen Rekord

darstellen. Es bedeutet aber auch, dass jetzt schon deutlich weniger

Probleme auftreten dürften.

Das andere Problem ist GNOME, aber dagegen hilft, eine andere

Desktopumgebung zu installieren. GNOME mit der GNOME-Shell ist eben nach wie

vor Geschmackssache. Manche argumentieren, es sei nur gewöhnungsbedürftig.

Dann sei aber die Frage erlaubt, warum man sich an eine Software gewöhnen

sollte. Muss es nicht eher umgekehrt so sein, dass sich die Software perfekt

an die eigenen Vorstellungen anpassen lassen muss? Grundsätzlich stellt sich

auch die Frage, warum die GNOME-Entwickler mit aller Gewalt etwas ändern

mussten (ich meine hier das Desktop-Paradigma), das überhaupt keinen Mangel

aufwies.

Fedora bringt reichliche und häufige Updates, Fedora 18 vielleicht noch mehr

als üblich, und ist damit immer aktuell. Doch genau hier liegt auch die

größte Schwäche der Distribution: Die Basis ändert sich ständig und es gibt

keine Version mit langfristigem Support. Alle sechs Monate ist das Update

auf die neueste Version Pflicht. Während das für fortgeschrittene Anwender

eine einfache Tätigkeit darstellt, die sie leicht beherrschen, ist es

normalen Anwendern einfach nicht zumutbar. Andere Distributionen,

insbesondere Ubuntu oder Debian, bieten nicht nur wesentlich längeren

Support, sondern ermöglichen auch das Update ohne Unterbrechung des

Betriebs. Man könnte nun argumentieren, dass normale Benutzer statt Fedora

Red Hat Enterprise Linux oder eine davon abgeleitete Distribution nutzen

sollten, die ja weitgehend zu Fedora kompatibel sind. Dagegen spricht

nichts, ganz im Gegenteil, aber diese Distributionen sind eben nicht exakt

Fedora.

Für mich bleibt es dabei, dass Fedora in erster Linie für erfahrene Benutzer

geeignet ist, die immer die neueste Software wollen und auch kein Problem

mit den Updates haben.

Links

[1] http://www.pro-linux.de/artikel/2/1611/fedora-18.html

[2] https://fedoraproject.org/wiki/F18_release_announcement

[3] http://www.freiesmagazin.de/freiesMagazin-2012-08

[4] https://fedoraproject.org/wiki/Features/NewInstallerUI

[5] http://www.dedoimedo.com/computers/fedora-18-kde.html

[6] https://bugzilla.redhat.com/show_bug.cgi?id=902498

[7] https://fedoraproject.org/wiki/Features/RealHotspot

[8] https://fedoraproject.org/wiki/Features/Riak

[9] https://fedoraproject.org/wiki/Features/Samba4

[10] https://fedoraproject.org/wiki/Features/OfflineSystemUpdates

[11] http://fedoraproject.org/wiki/Features/SystemStorageManager

[12] http://fedoraproject.org/wiki/Features/tmp-on-tmpfs

[13] http://wiki.linux-nfs.org/wiki/index.php/FedFsUtilsProject

[14] http://fedoraproject.org/wiki/Features/firewalld-default

[15] http://rpmfusion.org/

| Autoreninformation |

| Hans-Joachim Baader (Webseite)

befasst sich seit 1993 mit Linux. 1994 schloss er erfolgreich sein

Informatikstudium ab, machte die Softwareentwicklung zum Beruf

und ist einer der Betreiber von Pro-Linux.de.

|

Diesen Artikel kommentieren

Zum Index

von Mathias Menzer

Basis aller Distributionen ist der Linux-Kernel, der

fortwährend weiterentwickelt wird. Welche Geräte in einem halben

Jahr unterstützt werden und welche Funktionen neu hinzukommen, erfährt

man, wenn man den aktuellen Entwickler-Kernel im Auge behält.

Linux 3.8 Entwicklung

Die bedeutendste Änderung der sechsten Entwicklerversion [1] dürfte wohl das Abschalten des Treibers „samsung-laptop“ in dem Fall sein, dass der Linux-Kernel mittels EFI [2] gestartet wurde. Der Hintergrund hierfür liegt im Bekanntwerden eines Fehlers, durch den einige Laptop-Modelle des Herstellers Samsung nach dem Start eines Linux-Systems unbrauchbar wurden. Zwischenzeitlich wiesen jedoch einige Kernel-Entwickler darauf hin, dass das Problem nicht jener Treiber, sondern die UEFI-Firmware selbst sein und der Fehler daher von Samsung behoben werden müsse [3]. Dass es auch unter Windows möglich ist, ein solches Gerät unbrauchbar zu machen, dürfte ihre These untermauern [4]. Die letzte Entwicklerversion im Reigen hieß -rc7 [5]. Sie hatte lediglich Korrekturen im Gepäck und war daher gut geeignet, den Entwicklungszyklus abzuschließen.

Linux 3.8 Release

Nach 70 Tagen Entwicklungszeit – und das über Weihnachten und den Jahreswechsel hinweg – steht Linux 3.8 nun zum Einsatz bereit [6]. Der neue Kernel hat nicht so viele Änderungen aufzuweisen, wie der Vorgänger, er bewegt sich eher in einem normalen Rahmen.

Mit als erstes bekannt wurde der Wegfall der Unterstützung für die 386-Prozessoren [7]. Eigentlich war dieser Prozessortyp die Wiege für Linux, da Torvalds seinen Kernel ursprünglich hierfür entwickelte. Doch von Sentimentalität war nicht viel zu spüren und so nahm der den entsprechenden Patch auf.

Es steht wieder ein neues Dateisystem zur Verfügung. F2FS ist speziell auf die Anforderungen von Flash-Speichern zugeschnitten, wie sie zum Beispiel in Solid State Drives [8] (SSD) zum Einsatz kommen. Generell existieren bereits mehrere für Flash-Speicher geeignete Dateisysteme wie Logfs oder UBIFS, doch die berücksichtigen nicht den Flash Translation Layer [9], den SSDs als Zwischenschicht zum System nutzen. Dieser optimiert Zugriffe auf die Flash-Speicherelemente auch für herkömmliche Dateisysteme, sodass der jeweilige SSD-Datenträger wie ein ganz normales blockorientiertes Gerät gehandhabt werden kann. F2FS kann mit dieser Zwischenschicht umgehen und ihre Optimierungs- und Schutzfunktionen für die Flash-Speicherbausteine mitnutzen.

Auch die altgedienten Dateisysteme wurden mit Verbesserungen bedacht. Ext4 [10] kann nun sehr kleine Dateien direkt in Inodes ablegen. Dort befinden sich normalerweise nur die Metadaten zu Dateien und Verweise auf die Speicherblöcke, in denen die Dateien tatsächlich physikalisch gespeichert sind. Die Inodes sind normalerweise sehr klein – 256 Byte in der Standardeinstellung – doch dieser Platz wird meist nicht vollständig gebraucht. Passt in einen solchen Inode die zugehörige Datei noch mit hinein, so wird nicht nur etwas Speicherplatz gespart, da ein ansonsten 4 Kilobyte großer Block verschwendet werden würde, sondern die Zugriffe auf die Datei erfolgen auch schneller, da die Suche nach dem zugehörigen Speicherblock entfällt.

Btrfs [11] ist ein äußerst flexibles und vergleichsweise junges Dateisystem und

bringt mit fast jeder Kernel-Version neue Funktionen hervor. Diesmal haben die Entwickler den Austausch physikalischer Datenträger ins Visier genommen. Bislang war es zwar möglich, einen neuen Datenträger in ein btrfs-Dateisystem einzubinden und daraufhin einen anderen wieder zu entfernen, doch nahmen die darauf folgenden Operationen viel Zeit in Anspruch. Mit der neuen Funktion „replace“ wird letzten Endes das Gleiche erreicht, doch arbeitet btrfs hier wesentlich performanter solange keine weiteren Datenträger-Operationen anfallen. Der Austausch des Datenträgers erfolgt im laufenden Betrieb, es ist nicht notwendig irgendwelche Operationen zu stoppen oder gar das Dateisystem auszuhängen. Eine Abfrage zum Status des Austauschs und auch der Abbruch ist über das Kommandozeilen-Tool für btrfs möglich.

Die Speicherverwaltung des Kernels wurde um eine Funktion zum Ordnung halten erweitert. „Huge Pages“ (deutsch: „Große Seiten“) sind spezielle Speicherseiten, die größer als die üblichen 4KB-Speicherseiten sind, sie werden als spezielle Funktion von der Speicherverwaltung der CPU bereitgestellt. Diese Huge Pages wurden nun erweitert, um „Zero Pages“ (deutsch: „Null-Seiten“) abbilden zu können, quasi Speicherseiten die vollständig mit Nullen gefüllt sind. Zero Pages werden von Anwendungen

genutzt, um Speicherplatz zu reservieren. So kann die Speicherverwaltung letztlich Speicherplatz einsparen, indem einige dieser Seiten nicht zugewiesen werden, sondern stattdessen auf eine bereits existierende Zero Page verwiesen wird.

Die „Cgroups“ (Control Groups) sind eine Funktion des Kernels, mittels der die Verteilung von Ressourcen des Systems, wie zum Beispiel Prozessor-Zeit oder Speicher, auf Prozess-Gruppen gesteuert werden kann. Die Cgroups wurden nun erweitert, sodass der Speicher, der zur Verwaltung von Prozessen durch den Kernel benötigt wird, limitiert und abgegrenzt werden kann. Das kann zum einen die Sicherheit des Systems erhöhen, zu anderen die Stabilität, da mit oder ohne Absicht schadhaft geschriebene Programme in ihrem Ressourcenverbrauch wirksam eingeschränkt werden können. Auch die berüchtigten Fork-Bomben [12] sollen hierdurch ihren Schrecken verlieren.

NUMA (Non Uniform Memory Access) [13] ist eine Architektur der Speicheranbindung für Multiprozessor-Systeme, die für jeden Prozessor seinen eigenen lokalen Speicher vorsieht. Dieser kann dann jedoch auch von anderen Prozessoren angesprochen werden, wobei natürlich der Zugriff auf den eigenen Speicher schneller erfolgen kann als auf den anderer CPUs. Insofern ist es günstig, wenn Prozesse auf dem Prozessor ausgeführt werden, in dessen Speicher auch die benötigten Daten liegen. Um dies zu optimieren, wurde in Linux 3.8 mit nun die Grundlage gelegt. Detaillierte Regeln, nach denen NUMA dann Prozess- und Speicher-Zuweisung steuert, werden im kommenden Kernel folgen.

Eine vollständige Übersicht über alle Neuerungen und Verbesserungen von Linux 3.8 findet sich auch diesmal wieder auf der Seite Linux Kernel Newbies [14].

Spekulationen, dass Linux 3.8 wieder ein Longterm-Kernel werden würde, hat Greg Kroah-Hartman im Übrigen bereits vorzeitig beendet [15]. Er pflege derzeit Linux 3.0 und 3.4 für noch mindestens 2 Jahre, zusätzlich zu den normalen Kernel-Versionen und seiner Tätigkeit bei der Kernelentwicklung. Einen dritten Longterm-Kernel könne er nicht betreuen, ohne noch mehr Haare zu verlieren.

Ein D-Bus im Kernel

Seit sieben Jahren schon steht mit D-Bus [16] unter Linux ein System für die Interprozesskommunikation [17] (IPC) zur Verfügung, das mittlerweile von den gängigsten Desktop-Umgebungen und Anwendungen verwendet wird. Doch D-Bus basiert auf einem Daemon. Greg Kroah-Hartman hegt nun Pläne, ein IPC-System in den Linux-Kernel direkt zu implementieren [18]. Er verspricht sich davon, dass die Kommunikation zwischen Prozessen und Systemkomponenten beschleunigt wird, außerdem würde es allen Linux-Anwendungen zur Verfügung stehen, sobald nur der Kernel gestartet ist. Damit hätte es auch die besten Aussichten, zu einem neuen Standard zu werden. Zu D-Bus kompatible Schnittstellen sollen es ermöglichen, das IPC-Framework zu wechseln, ohne dass Desktop-Umgebung oder Anwendung etwas davon mitbekommen. Zwar existiert mit AF-Bus bereits ein IPC-System für den Linux-Kernel, doch der eigne sich nach Ansicht von Kroah-Hartman eher für die „verrückten Linux-Entwickler aus der Automobilbranche“. So findet sich AF-Bus auch im LTSI-Kernel, jedoch wurde seine Aufnahme in den Mainstream-Kernel von der Entwicklergemeinde bisher abgelehnt.

Keine Secure-Boot-Schlüssel im Kernel

Mit der Anfrage um die Aufnahme einiger Patches wandte sich der Red-Hat-Entwickler David Howells an Torvalds. Konkret ging es darum, dass der Kernel in die Lage versetzt werden sollte, neue Schlüssel für die Verwendung im Zusammenhang mit Secure Boot automatisch zu importieren [19]. Torvalds lehnte die Aufnahme der Patches erst einmal ab, da ihm die neue Funktion und worauf sie aufbaut nicht gefiel. Unter anderem störte er sich daran, dass die Schlüssel aus PE-Dateien [20] extrahiert werden sollen, weil Microsoft nur diese signiere, der Linux-Kernel aber X.509 [21] unterstütze, welches ein Standard für Zertifikate ist. Das Parsen der PE-Binärdateien solle im Userland geschehen. Auch im weiteren Verlauf der Diskussion zeigte sich Torvalds nicht kompromissbereit. Er glaube nicht, dass sich jemand um von vertrauenswürdigen Stellen signierte Schlüssel schere. Da sich auch weitere Entwickler skeptisch zeigten, scheint es eher unwahrscheinlich, dass eine Schlüsselverwaltung in den Kernel integriert wird, die mit den von der Microsoft-Zertifizierungsstelle für die Signierung vorausgesetzten PE-Binärdateien zurechtkommt. Für Linux bedeutet das im Zusammenhang mit Secure Boot, dass zum Beispiel das Aufwachen des Systems nach dem Ruhezustand, was kein eigentlicher Bootvorgang ist, nicht funktioniert oder Fehlermeldungen erzeugt.

Gregs 2012

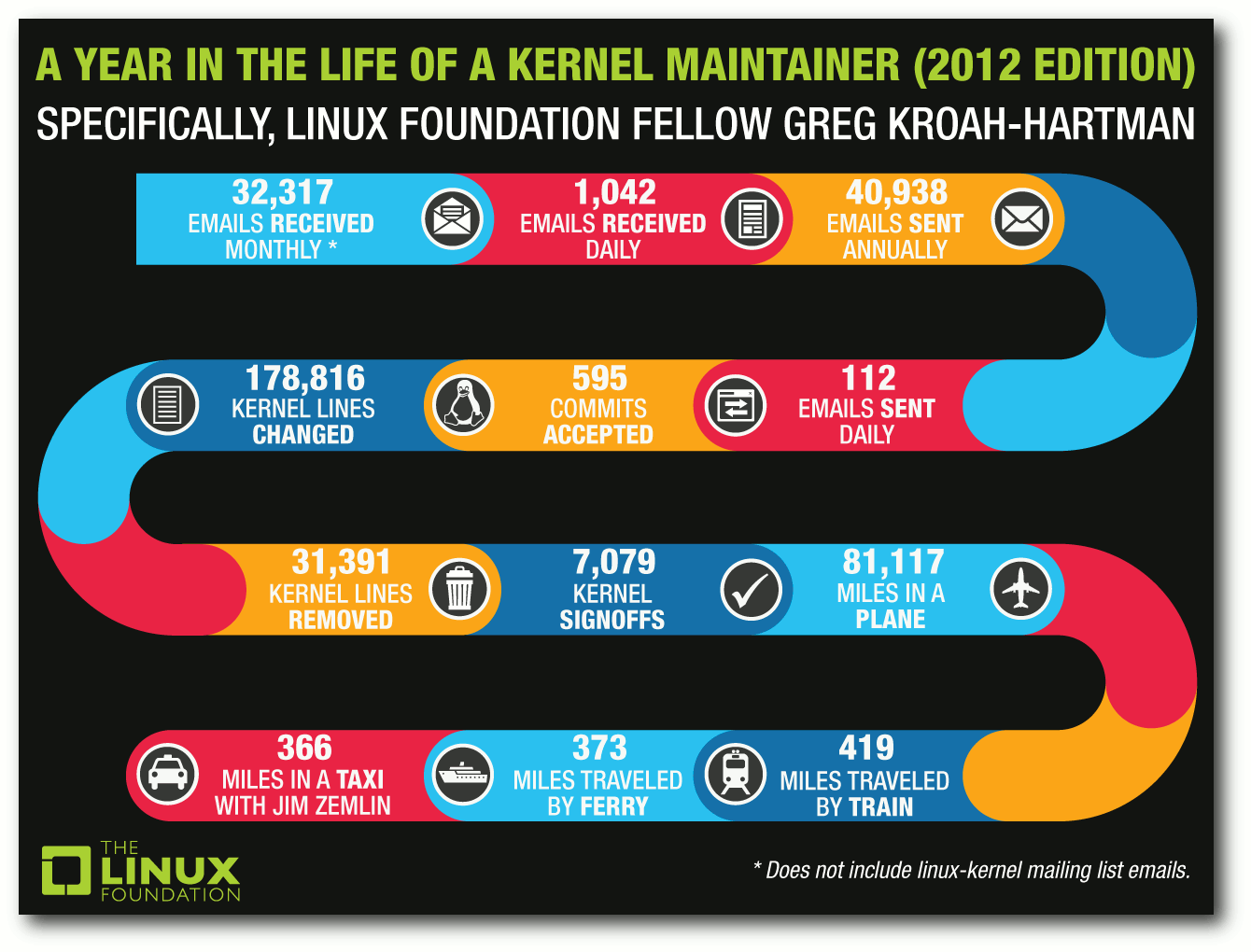

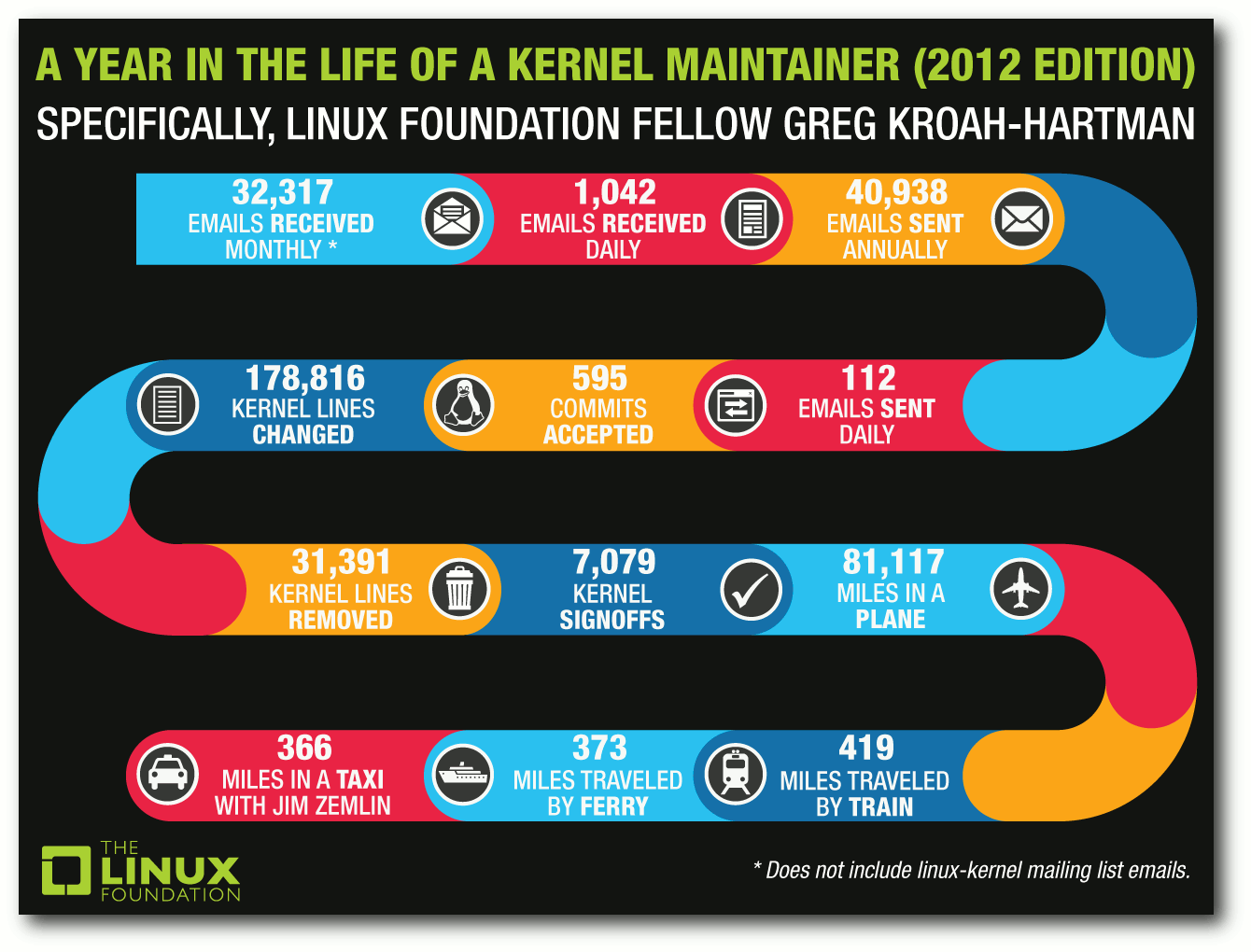

Sicherlich kann Greg Kroah-Hartman auf vieles im Jahr 2012 zurückblicken. Doch die Linux Foundation interessierte sich insbesondere für seine Tätigkeit als Kernel-Maintainer und hat hier einige Zahlen zusammengefasst [22].

Ein Jahr im Leben eines Kernel-Maintainers.

© The Linux Foundation (CC-BY)

So bekam Kroah-Hartman über 32.000 E-Mails pro Monat, die Kernel-Mailing-Liste nicht hinzugerechnet, und mehr als 40.000 E-Mail hat er in 2012 verschickt. Fast 179.000 Zeilen Code hat er selbst geändert, dazu kommen über 31.000 entfernte Zeilen. 595 Commits wurden von ihm akzeptiert und über 7.000 hat er abgesegnet.

Links

[1] https://lkml.org/lkml/2013/1/31/593

[2] https://de.wikipedia.org/wiki/Unified_Extensible_Firmware_Interface

[3] http://www.pro-linux.de/news/1/19432/garret-uefi-problem-mit-samsung-laptops-noch-nicht-behoben.html

[4] http://heise.de/-1801269

[5] https://lkml.org/lkml/2013/2/8/470

[6] https://lkml.org/lkml/2013/2/18/476

[7] https://de.wikipedia.org/wiki/Intel_80386

[8] https://de.wikipedia.org/wiki/Solid-State-Drive

[9] https://en.wikipedia.org/wiki/Flash_Translation_Layer#Translation_layers

[10] http://de.wikipedia.org/wiki/Btrfs

[11] https://de.wikipedia.org/wiki/Forkbomb

[12] https://de.wikipedia.org/wiki/Non-Uniform_Memory_Access

[13] http://kernelnewbies.org/Linux_3.8

[14] http://www.kroah.com/log/linux/3.8-is_not_longterm_stable.html

[15] https://de.wikipedia.org/wiki/D-Bus

[16] https://de.wikipedia.org/wiki/Interprozesskommunikation

[17] http://www.pro-linux.de/news/1/19435/aufnahme-von-d-bus-in-den-kernel-geplant.html

[18] http://www.pro-linux.de/news/1/19498/uefi-secure-boot-schluessel-signierung-vorerst-nicht-im-linux-kernel.html

[19] https://de.wikipedia.org/wiki/Portable_Executable

[20] https://de.wikipedia.org/wiki/X.509

[21] https://de.wikipedia.org/wiki/Linux_Foundation

[22] http://www.linuxfoundation.org/news-media/infographics/year-life-kernel-maintainer-2012-greg-kroah-hartman

| Autoreninformation |

| Mathias Menzer (Webseite)

wirft gerne einen Blick auf die Kernel-Entwicklung, um mehr über die

Funktion von Linux zu erfahren

und um seine Mitmenschen mit seltsamen

Begriffen und unverständlichen Abkürzungen

verwirren zu können.

|

Diesen Artikel kommentieren

Zum Index

von Markus Brenneis

Im ersten Teil der Reihe [1]

wurde erläutert, wie das Add-on-SDK eingerichtet und ein Symbol zur

Add-on-Leiste hinzugefügt wird. Es soll nun mit der Erweiterung möglich

sein, den gerade markierten Begriff in Wikipedia nachzuschlagen. Außerdem

wird erklärt, wie ein Eintrag im Kontextmenü angelegt wird und wie man seine

Erweiterung mit anderen Firefox-Nutzern teilen kann.

Ermitteln des ausgewählten Textes

Die an die Erweiterung gestellte Aufgabe umfasst zwei Teilaufgaben: Als

erstes muss festgestellt werden, welcher Text gerade markiert ist und

anschließend muss der Wikipedia-Artikel in einem neuem Tab geöffnet werden.

Um den Inhalt der aktuellen Auswahl zu bekommen, stellt das SDK das Modul

selection [2]

zur Verfügung. Um das Modul nutzen zu können, muss es zunächst – wie schon

vom widget-Modul bekannt – per

var selection = require("sdk/selection");

in die main.js eingebunden werden. Mit der Ende Januar erschienenen

SDK-Version 1.13 hat sich die Syntax von require übrigens ein wenig

verändert [3].

Wegen Änderungen an der SDK-Struktur muss nun sdk/ vor den Modulnamen

geschrieben werden; die alte Syntax (require("selection")) ist aber aus

Kompatibilitätsgründen zur Zeit auch noch gültig.

Die aktuelle Auswahl soll dann ausgelesen werden, wenn das „W“-Widget

angeklickt wird. Dafür wird eine Funktion verwendet, die aufgerufen wird,

wenn das

click-Event [4]

des Widgets ausgelöst wird. Ein erster Ansatz, der die aktuelle Auswahl

selection.text in die

Fehlerkonsole [5]

schreiben soll, könnte so aussehen:

var selection = require("sdk/selection");

var widgets = require("sdk/widget");

var widget = widgets.Widget({

id: 'wikipedia-icon',

label: 'Wikipedia',

content: '<b style="font-family:Times">W</b>',

onClick: function() {

console.log(selection.text);

}

});

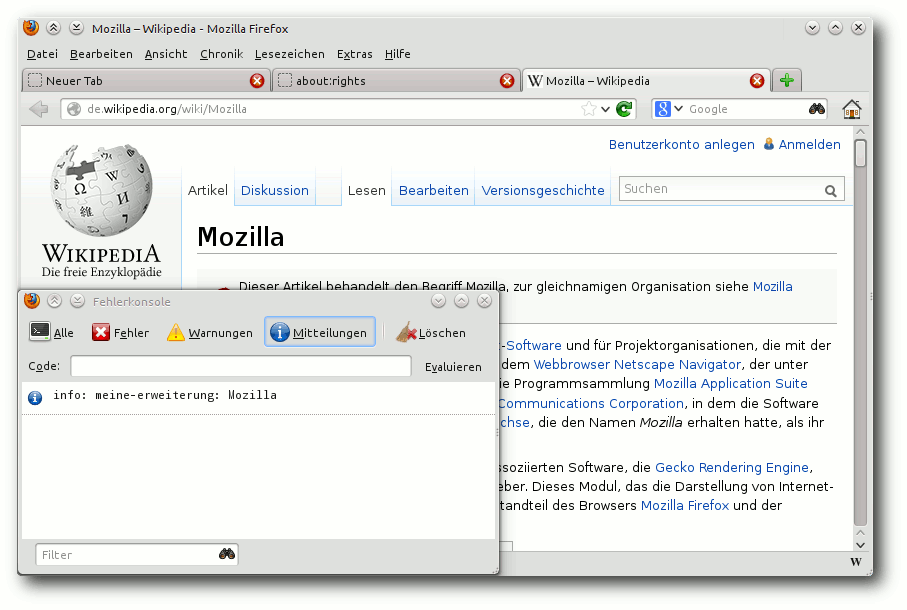

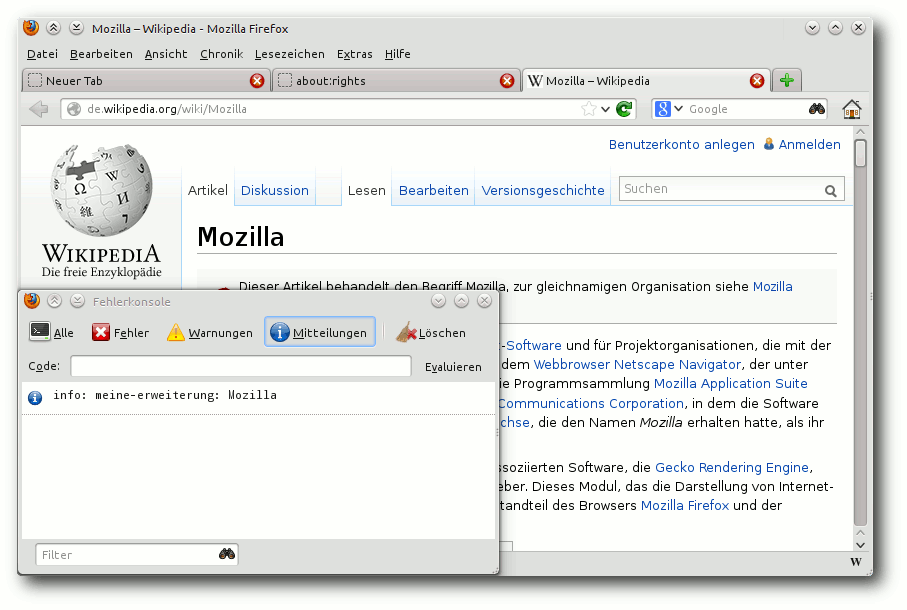

Testet man nun den Code mit cfx run (vorher das Laden des SDK per

source bin/active nicht vergessen!), öffnet eine Webseite, markiert Text, klickt

auf das „W“ und schaut in der Fehlerkonsole

(„Extras -> Web-Entwickler -> Fehlerkonsole“)

nach, sieht man aber nur „info: meine-erweiterung: null“.

null bedeutet, dass kein Text markiert ist. Wie kann das sein? Sobald auf

das „W“ geklickt wird, verliert die Webseite – und damit auch die Selektion

– den Fokus und es gibt nun tatsächlich keinen markierten Text mehr.

Das Problem lässt sich lösen, indem sich die Erweiterung immer den zuletzt

markierten Text merkt. Dazu wird das select-Ereignis des

selection-Moduls verwendet:

var selectedText;

function selectionChanged(event) {

selectedText = selection.text;

}

selection.on("select", selectionChanged);

Die Funktion selectionChanged wird jedes Mal aufgerufen, wenn ein anderer

Text markiert wird. Dieser Text wird dann in der Variablen selectedText

gespeichert. Die onClick-Funktion muss jetzt noch in

console.log(selectedText);

geändert werden. Erneutes Testen zeigt, dass dieser Lösungsansatz wie

gewollt funktioniert.

Das Wort „Mozilla“ wurde markiert und mit einem Klick auf das „W“ öffnet sich die Fehlerkonsole.

Öffnen eines Tabs

Nun soll der zum ausgewählten Text passende Wikipedia-Artikel in einem neuen

Tab angezeigt werden. Das dafür nötige Modul heißt

tabs [6]

und wird mit

var tabs = require("sdk/tabs");

eingebunden. Um einen neuen Tab zu öffnen, wird die Funktion open verwendet:

onClick: function() {

console.log(selectedText);

tabs.open("http://de.wikipedia.org/w/index.php?search=" + selectedText);

}

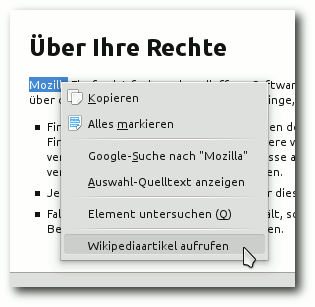

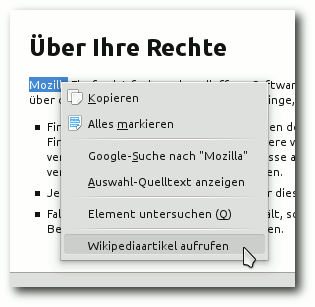

Ein Eintrag im Kontextmenü

Damit der Benutzer der Erweiterung mit der Maus nicht immer den „langen“ Weg

zum „W“-Symbol zurücklegen muss, soll nun ein Eintrag im

Kontextmenü [7] angelegt werden.

Das benötigte Modul

context-menu [8]

wird wie üblich mit

var cm = require("sdk/context-menu");

geladen. Der Code zum Erzeugen des Menüeintrags könnte so aussehen:

cm.Item({

label: "Wikipediaartikel aufrufen",

context: cm.SelectionContext(),

contentScript: 'self.on("click", self.postMessage);',

onMessage: function() {

console.log(selectedText);

tabs.open("http://de.wikipedia.org/w/index.php?search=" + selectedText);

}

});

Die Beschriftung des Menüeintrags ist „Wikipediaartikel aufrufen“ (label)

und der Eintrag wird nur dann angezeigt, wenn auf der angezeigten Seite Text

markiert ist (context).

Um mit der Benutzeroberfläche (also auch

Menüeinträgen) zu kommunizieren, werden sogenannte „Content

Scripts“ [9]

verwendet. Der Sinn der Content-Skripte ist der, dass es, wenn in Firefox in

Zukunft die Benutzeroberfläche, Add-ons und auch Webinhalte in

unterschiedlichen Prozessen ausgeführt werden, nicht mehr möglich sein wird,

dass Skripte des Benutzeroberflächen-Prozesses auf Inhalte der

Add-on-Skripte zugreifen können; deshalb werden diese schon jetzt strikt

getrennt.

Content-Skripte werden in der Regel als separate Dateien angelegt (dazu gibt

es in einem späteren Teil mehr Informationen). Da in diesem Fall das Skript

nur aus einem Befehl besteht, ist es auch legitim, diesen Befehl direkt in

der main.js anzugeben. Das Skript sendet mit self.postMessage eine

(leere) Nachricht an die

Erweiterung, sobald das click-Event ausgelöst

wird. Dann wird die unter onMessage angegebene Funktion aufgerufen, welche

dann auf die bekannte Weise den Wikipediaartikel lädt.

Um doppelten Code zu vermeiden, ist es sinnvoll, den Code zum Anzeigen des

Artikels in eine eigene Funktion zu schreiben:

function openArticle() {

console.log(selectedText);

tabs.open("http://de.wikipedia.org/w/index.php?search=" + selectedText);

}

cm.Item({

label: "Wikipediaartikel aufrufen",

context: cm.SelectionContext(),

contentScript: 'self.on("click", self.postMessage);',

onMessage: openArticle

});

Die onClick-Eigenschaft des Widgets wird analog angepasst.

Der Menüeintrag „Wikipediaartikel aufrufen“.

Erstellen von XPI-Dateien

Wenn man anderen seine Erweiterung zur Verfügung stellen möchte, gibt man

diese in der Regel als installierbare

XPI-Datei [10] weiter.

Eine solche Datei

erzeugt man mit dem Befehl

$ cfx xpi

Die XPI-Datei wird dann durch Ziehen in ein Firefox-Fenster installiert.

Nach der Installation sollte die Add-on-Leiste automatisch eingeblendet

werden. Ist dies nicht der Fall, so liegt das daran, dass der Benutzer die

Add-on-Leiste in der Vergangenheit manuell geschlossen hat. Sie kann dann

über „Ansicht -> Symbolleisten -> Add-on-Leiste“ wieder angezeigt werden.

Zusammenfassung und Ausblick

Bisher wurde gezeigt, wie man Widgets in der Add-on-Leiste anzeigt (Modul

widget), die aktuelle Auswahl abfragt (selection), Tabs öffnet (tabs)

und Einträge im Kontextmenü erzeugt (context-menu). Im nächsten Artikel

wird unter anderem gezeigt werden, wie Panels (kleine Pop-Ups) erstellt

werden.

Die komplette Erweiterung kann als Archiv ffox_addonsdk_2.tar.gz und

als installierbare Erweiterung ffox_addonsdk_2.xpi heruntergeladen

werden.

Links

[1] http://www.freiesmagazin.de/freiesMagazin-2013-02

[2] https://addons.mozilla.org/en-US/developers/docs/sdk/latest/modules/sdk/selection.html

[3] https://blog.mozilla.org/addons/2013/01/25/changes-to-require-syntax/

[4] https://addons.mozilla.org/en-US/developers/docs/sdk/latest/modules/sdk/widget.html#click

[5] https://developer.mozilla.org/en-US/docs/Error_Console

[6] https://addons.mozilla.org/en-US/developers/docs/sdk/latest/modules/sdk/tabs.html

[7] https://de.wikipedia.org/wiki/Kontextmenü

[8] https://addons.mozilla.org/en-US/developers/docs/sdk/latest/modules/sdk/context-menu.html

[9] https://addons.mozilla.org/en-US/developers/docs/sdk/latest/dev-guide/guides/content-scripts/index.html

[10] https://de.wikipedia.org/wiki/XPI

| Autoreninformation |

| Markus Brenneis (Webseite)

hat 2007 sein erstes Firefox-Add-on geschrieben und 2012 beim Entwickeln der

Erweiterung LanguageToolFx erstmals das Add-on-SDK benutzt.

|

Diesen Artikel kommentieren

Zum Index

von Daniel Stender

Wer publiziert, Software dokumentieren möchte oder sich mit

elektronischen Dokumentenformaten beschäftigt, der stößt irgendwann

mit Sicherheit auf Docbook. Docbook stammt aus dem Bereich der EDV-Dokumentation

und wird überwiegend, aber nicht ausschließlich, dafür verwendet.

Docbook ist ausgereift und umfangreich genug, um eine Grundlage für

die professionelle Buchproduktion zu sein (so basiert zum Beispiel

die gesamte Produktionskette des Verlages O'Reilly darauf), wird

aber auch für kleinere Projekte verwendet, wie zum Beispiel die

Linux-Manpages. Docbook wird mittlerweile vielfältig eingesetzt und

es kann damit grundsätzlich plattformunabhängig bzw. -übergreifend

gearbeitet werden.

Hallo, Docbook!

Docbook [1] ist eine auf XML basierende

Auszeichnungssprache für verschiedenartige Dokumente. Es umfasst eine

ganze Reihe von rein semantisch definierten Tags, mit denen sich die

einzelnen Elemente zum Beispiel eines Artikels, wie Überschriften und

Textabschnitte, zunächst völlig darstellungsneutral aufnehmen lassen.

Docbook-Dateien sind reine Textdateien; in einem weiteren

Produktionsschritt lassen sich daraus verschiedene Ausgabeformate

wie HTML/XHTML, EPUB [2] und PDF

erzeugen. Die Trennung von Masterdatei und daraus bzw. davon

gesetztem Dokument wird einigen Lesern bereits von dem Textsatzsystem

LaTeX [3] her bekannt sein. Docbook

unterscheidet sich davon allerdings dadurch, dass hier die

Quelldatei keine direkten Typensatzbefehle enthält, sondern einzelne

Text- und Dokumentelemente ausgezeichnet werden, die bei Erzeugen

des Ausgabeformates beliebig verwendet werden können. Textabschnitte

zum Beispiel, die in der Masterdatei mit <emphasis> gekennzeichnet

worden sind, können im Ausgabeformat beliebig gehandhabt, kursiv

oder fett gesetzt oder aber auch gar nicht hervorgehoben werden.

Die strikte Trennung in Inhalt und Form (Prinzip: „was“ und nicht:

„wie“) macht Docbook sehr flexibel. So können zum Beispiel auch

verschiedenen Sprachversionen oder auch andere Varianten desselben

Textes in eine einzige Masterdatei geschrieben und dann

verschiedene Dokumente daraus generiert werden.

Dieser Artikel führt in die Benutzung von Docbook 5.0 auf einem

typischen Linuxsystem (Ubuntu 12.04 LTS) ein; dabei werden

zumindest grundlegende XML-Kenntnisse vorausgesetzt. Als

weiterführende Literatur empfiehlt sich der bei O'Reilly im Druck

vertriebene „Definitive Guide” zu Docbook 5.0 von Norman Walsh, der

als Referenz-Dokumentation mittlerweile auch frei im Netz angeboten

wird [4], und zwar zusammen mit seinem

Docbook-Quellcode [5].

Empfohlen sei an dieser Stelle auch das sehr ausführliche Handbuch

„Docbook-XML – Medienneutrales und plattformunabhängiges Publizieren”

von Thomas Schraitle (ISBN 978-3-938626-14-6).

Schemata

Docbook wurde zunächst als DTD-Schema für den XML-Vorgänger SGML

entwickelt. Ab Version 4.1 wurde daneben auch eine

Dokumenttypdefinition (DTD) für XML bereit gestellt. Seit 5.0 ist

Docbook ausschließlich in XML umgesetzt, und zwar hauptsächlich in

der gegenüber von DTD stark weiterentwickelten XML-Schemasprache

Relax NG [6] in Verbindung mit

einigen Ergänzungen in Schematron [7].

Die daneben offiziell gepflegten Schemata in den Sprachen DTD und

W3C XML Schema (XSD) haben nicht ganz denselben Funktionsumfang wie

diese. Die Docbook-Schemata werden mittlerweile vom Docbook

Technical Commitee bei OASIS betreut und stehen unter der freien

BSD-Lizenz. Die aktuelle Version von Docbook ist 5.0 [8],

welche neben Version 4.1 und 4.5 ein offizieller OASIS-Standard

ist [9]. Der 4.x-Zweig ist

mit der eingefrorenen Version 4.5 abgeschlossen worden und das

zukünftige Docbook 5.1 hat mittlerweile das 7. Betarelease erreicht.

Auf Debian-basierten APT-Systemen wie Ubuntu sind die älteren, aber

noch gebräuchlichen SGML und XML-DTDs bis hoch zu Version 4.5 in den

Paketen docbook und docbook-xml verfügbar, während sich die

aktuellen Docbook 5.0-Schemata mit dem Paket docbook5-xml bequem

installieren lassen. Das Relax NG-Schema (.rng) befindet sich dann

zusammen mit seiner Variante in kompakter Syntax (.rnc) im

Verzeichnis /usr/share/xml/docbook/rng/5.0, während sich die

Schematron-Ergänzungen (docbook.sch), sowie die Konvertierungen in

DTD- und XML-Schemata in entsprechenden, parallelen Verzeichnissen

vorfinden. Die XML-Schemata lassen sich aber ohne Weiteres auch

per Hand von der OASIS-Seite zum Beispiel direkt in das

Arbeitsverzeichnis einspielen und von dort aus verwenden.

Hello, world!

Das XML einer Docbook-Datei lässt sich grundsätzlich mit jedem

beliebigen Texteditor schreiben und bearbeiten. Eine rudimentäre

Docbook-Datei sieht nun folgendermaßen aus:

<?xml version="1.0" encoding="UTF-8"?>

<article version="5.0" xmlns="http://docbook.org/ns/docbook">

<title>Testdokument</title>

<para>Hello, world!</para>

</article>

In der ersten Zeile steht die für XML übliche Standard-Deklaration,

welche die Datei als XML-Dokument ausweist und die Textcodierung

festlegt. Docbook 5.x hingegen wird in Betrieb genommen, indem man

für eines der gültigen Wurzelelemente davon (hier: article) die

gewünschte Versionsnummer und die für Docbook 5.x vorgesehene URI

als Standard-Namensraum festlegt.

Eine Datei foo.xml (gebräuchlich ist auch die Dateiendung .dbk für

Docbook-Dateien) wie diese lässt sich nun gegenüber des

Docbook-Schemas validieren, zum Beispiel mit xmllint aus dem Paket

libxml2-utils:

$ xmllint --relaxng /usr/share/xml/docbook/schema/rng/5.0/docbook.rng foo.xml

OASIS empfiehlt im Docbook-Howto [10]

dafür allerdings den Multi-Schema XML Validator (MSV) von

Sun [11], der in Java

implementiert ist:

$ java -jar ~/Downloads/msv/msv.jar /usr/share/xml/docbook/schema/rng/5.0/docbook.rng foo.xml

Sollen modulare Dokumente benutzt werden, bei denen Teilstücke in

die Masterdatei mittels

XInclude eingefügt werden, so muss gegenüber

den Schemata docbookxi.rng/.rnc validiert werden, die sich auch in

docbook/rng/5.0 befinden. Aus einem syntaktisch und strukturell

fehlerfreien, d.h. wohlgeformten und gültigen Docbook-Dokument

können dann in einem weiteren Schritt mit gängigen XML-Tools

verschiedene Ausgabeformate hergestellt werden (siehe weiter unten).

Docbook-Elemente

Docbook 5.0 beschreibt 385 verschiedene Elemente mit

entsprechenden Tags, die im Verhältnis zu anderen Elementen im

Sinne der Baumstruktur von XML auf unterschiedlichen hierarchischen

Ebenen angesiedelt sind. Neben den reinen Steuerungselementen sind

diese in die Gruppen Strukturelemente, Blockelemente und

Inline-Elemente zusammengefasst.

Von den Strukturelementen sind zunächst die Wurzelelemente <set> und

<book> (ein <set> enthält mehrere <book>s) zu nennen. Ein Buch

(<book>) [12] enthält

zunächst einen <info>-Abschnitt, der den Buchtitel trägt und unter

anderem den Autorennamen [13] beinhaltet.

Es kann mit verschiedenen Komponenten ausgestattet werden, wie z. B. einer

Widmung (<dedication>), einem Vorwort (<preface>) und verschiedenen

Dingen wie einem Inhaltsverzeichnis (<toc>), Indices (<index>) oder

einem Glossar (<glossary>). Es besteht aber vor allem natürlich aus

Artikeln (<article>) oder Kapiteln (<chapter>), die Textabschnitte

(<para>) enthalten, welche wiederum in verschiedene Abschnitte (u. a.

<section>) unterteilt sein können. Blockelemente sind nun diejenigen

Elemente, die auf der Ebene von <para> angewendet werden können. Es

handelt sich dabei z. B. um Listen, Tabellen und Blockzitate. Die

z. B. aus den Büchern von O'Reilly bekannten separaten Hinweise

(admonitions) gehören auch hierzu (<caution>, <important>, <tip>).

Die Inline-Elemente schließlich sind diejenigen, die im laufenden

Text Verwendung finden. Es handelt sich hierbei zum Beispiel um

<emphasis>, Abkürzungen, Fußnoten, und Querverweise. Da Docbook aus

der Software-Dokumentation stammt, finden sich für diesen Zweck

besonders viele nützliche Elemente.

Ein <article> kann, wie oben gesehen, auch auch als selbständiges

Wurzelelement verwendet werden und kann – ähnlich wie ein Buch – mit

verschiedenen Komponenten wie einem Inhaltsverzeichnis, Indices,

Glossaren usw. ausgestattet werden [14].

Die Datei docbook_test.xml (aus Gründen der

Übersichtlichkeit nur verlinkt) zeigt gegenüber dem obigen „Hello, world!“-Beispiel ein mit Info-Block und verschiedenen Abschnitten

versehenes, aufwändigeres Beispiel.

Docbook mit Emacs

Es ist unbequem, XML mit einem Editor zu schreiben, der nicht

speziell dafür gedacht ist oder nicht zumindest besondere

Funktionen dafür bereithält und in Sachen XML-Komfort gibt es große

Unterschiede zwischen diesen Programmen. Wer nach freien Lösungen

Ausschau hält, stößt recht schnell auf die Möglichkeit, Docbook

komfortabel mit Emacs [15] zu

edieren, dem gewöhnungsbedürftigen, aber vielseitigen

Editor-Schwergewicht. Seit Version 23.2 von GNU Emacs ist

nXML [16] der

Standard-XML-Modus [17].

Es handelt sich bei nXML um einen sehr leistungsstarken Major-Mode,

der neben speziellen Eingabehilfen wie Syntax-Highlighting,

Autoeinrückung, Tag-Vervollständigung und

Wohlgeformtheits-Überwachung auch eine Echtzeit-Gültigkeitsprüfung

für Relax NG-Schemata sowie kontextsensitive Tag-Vorschläge

möglich macht.

nXML schaltet sich in Emacs automatisch hinzu, sobald Dateien mit

den Endungen .xml, .xsl, .rng oder .xthml ediert werden. Die

für Ubuntu

gepflegten GNU Emacs 23-Pakete beinhalten für nXML

verschiedene XML-Schemata (nXML verwendet Relax NG in kompakter

Syntax), gegenüber denen automatisch validiert wird. Die

im

aktuellen Paket auf Ubuntu 12.04 (23.3+1-1ubuntu9) und anderen

Distributionen verwendete Docbook-Schemadatei ist allerdings

veraltet, denn es handelt sich dabei immer noch um Version 4.2 und

ein konformes Docbook 5.0-Dokument wird dementsprechend als

ungültig bewertet. Eine einfache Lösung für dieses Problem ist, für

die geöffnete Datei ein eigenes, lokales nXML-Schemaregister zu

erstellen: Nach der Tastenkombination „Strg“ + „C“ „Strg“ + „S“ „Strg“ + „F“ kann die

korrekte Schemadatei eingegeben werden, worauf dann ein Register

schemas.xml dafür im aktuellen Arbeitsverzeichnis angelegt wird.

Im nXML gibt es mit „Strg“ + „Enter“ eine jeweils kontextsensitive Liste mit

allen möglichen Vervollständigungen von Tags und Attributen, sodass

bei einem eingegebenen <p dabei unter anderem das Element <para>

vorgeschlagen wird, falls es an dieser Stelle gültig ist. Eine

andere wichtige Funktion ist das Einfügen von korrespondierenden

End-Tags mit „Strg“ + „C“ „Strg“ + „F“. Fehler im Dokument werden rot

hervorgehoben [18].

GNU Emacs 23 im nXML-Modus beim Bearbeiten einer Docbook-Datei.

Das Element <para> in Zeile 10 wird als Fehler angezeigt, weil ein

Textabschnitt innerhalb von <book> nur innerhalb eines <chapter>

vorkommen darf, während die Auto-Vervollständigung die an der

aufgerufenen Stelle möglichen Elemente <chapter> und <colophon>

vorschlägt.

Docbook XSL

Für Docbook gibt es eine umfangreiche Sammlung von Stylesheets für

die Herstellung von verschiedenen Ausgabeformaten mittels

XSL-Transformationen (XSLT): Docbook XSL. Sie sind ebenfalls weit

entwickelt, sehr vielseitig und können neben den Schemata als

zweite Hälfte von Docbook

angesehen werden. Im Paket docbook-xsl-ns

ist für Ubuntu 12.04 eine aktuelle, für Docbook 5 vorgesehene

Version 1.76 (letzte Veröffentlichung: 1.78) der Stylesheets bequem

verfügbar. Diese befinden sich nach der Installation in

verschiedenen Unterverzeichnissen von

/usr/share/xml/docbook/stylesheet/docbook-xsl-ns. Brandaktuelle

Snapshots von Docbook XSL werden regelmäßig gepackt [19].

Mit Hilfe eines der üblichen XSLT-Prozessoren wie Saxon, Xalan, oder

Xsltproc können verschiedene Ausgabeformate wie HTML/XHTML, EPUB

oder XSL-FO (als Vorstufe u. a. für PDF-Dateien) aus einem

Docbook-Master erzeugt werden. Die Stylesheets liegen im XSLT-Format

1.0 vor, und die XSLT 2.0-Version davon ist bisher rein

experimentell. Die Stylesheets sind gut dokumentiert; Bob Staytons

„Docbook XSL – The definitive guide” (der auch als generelle

Einführung gelesen werden kann) ist frei im Netz verfügbar [20].

Dies gilt auch für Norman Walshs

„Reference Documentation“ [21].

Für den Prozessor Saxon (Paket libsaxon-java) gibt es für die

Verarbeitung von Docbook spezielle Erweiterungen im Paket

docbook-xsl-saxon.

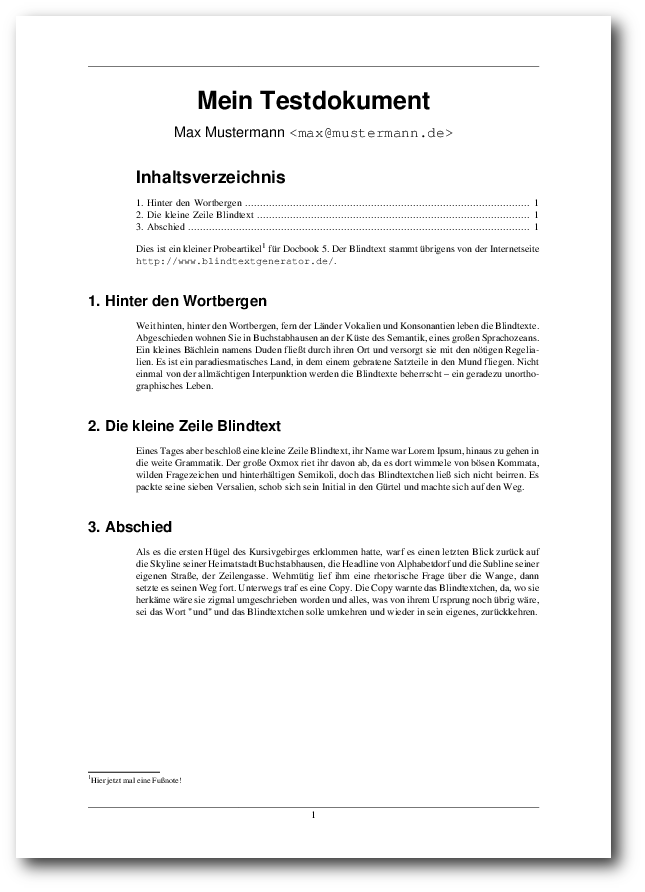

PDF erzeugen

Um mit Docbook eine PDF-Datei zu erzeugen, muss nun zunächst aus der

Masterdatei mit Hilfe des dafür gedachten Stylesheets eine

XSL-FO-Datei hergestellt werden:

$ saxon-xslt -o foo.fo foo.xml /usr/share/xml/docbook/stylesheet/docbook-xsl-ns/fo/docbook.xsl

Danach kann die .fo-Datei mit einem FO-Formatierer wie FOP in die

gewünschte PDF-Datei umgewandelt werden:

$ fop foo.fo foo.pdf

Es empfiehlt sich, für die verschiedenen oft ausgeführten

Kommandozeilen-Operationen ein Shellscript oder ein Makefile für die

Benutzung mit GNU Make anzufertigen. Mit dem Tool Dblatex können aus

Docbook PDF-Dateien mit Hilfe von LaTeX auch ohne Docbook XSL

erzeugt werden; dazu müssen allerdings umfangreiche Abhängigkeiten

erfüllt sein bzw. mitgezogen werden.

Parameter manipulieren

Die Voreinstellungen der XSL-Stylesheets lassen sich grundsätzlich

auf zwei Arten manipulieren: indem bei Aufruf des XSLT-Prozessoren

Parameter an diesen übergeben werden und/oder durch eine separate

Anpassungsdatei. Die Anpassungsdatei docbook_test.xsl verändert für die

XSL-FO-Ausgabe die Standardwerte für Papiergröße (paper.type) von US

Letter auf DIN A4 [22],

schaltet die automatische Abschnittszählung (section.autolabel) ein,

ändert bei den obersten Abschnittsüberschriften

(section.title.level1.properties) die Schriftgröße auf das 1,5-Fache

der Brotschrift, und erhöht für diese den oberen Abstand auf

15 pt [23].

Es handelt sich dabei selbst um eine konforme XSLT-Datei, in der

alle Elemente dem dafür vorgesehenen Namensraum xsl zugeordnet sind.

Dem XSLT-Prozessor kann dieses selbsterstellte Stylesheet dann

anstatt der originalen Datei

docbook-xsl-ns/fo/docbook.xsl angegeben

werden, die von dieser mit xsl:import reimportiert wird. Auf diese

Art und Weise lassen sich die Ausgabedateien bis in alle

Einzelheiten kontrollieren.

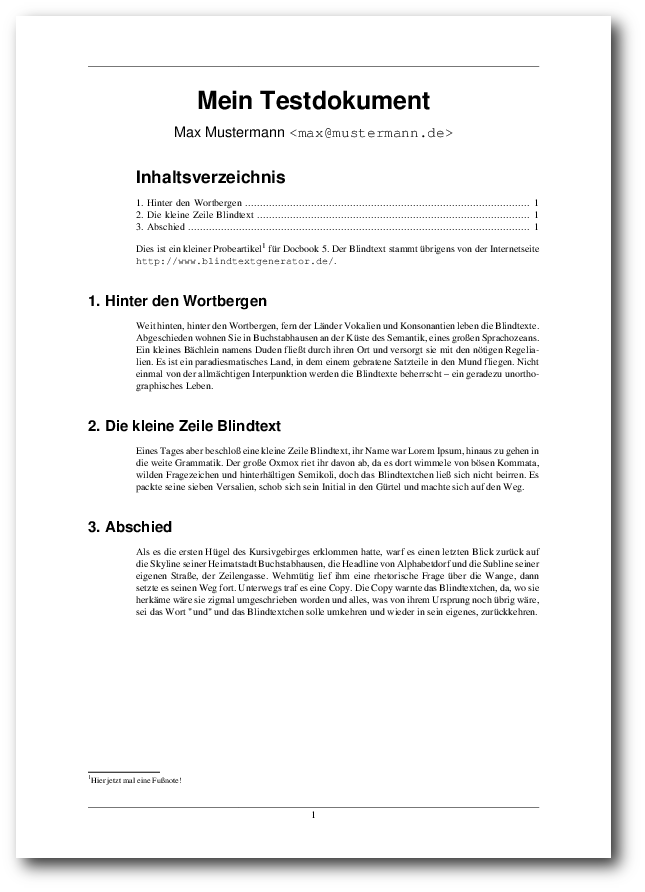

Eine aus docbook_test.xml resultierende PDF-Datei.

Das automatisch generierte Inhaltsverzeichnis lässt sich übrigens

verhindern, indem man dem Paramater generate.toc die Einstellung

article nop übergibt. Eine sehr reichhaltige Sammlung von

Docbook-Hacks ist Thomas Schraitles

DoCookBook-Projekt [24].

Links

[1] http://www.docbook.org/

[2] https://de.wikipedia.org/wiki/Epub

[3] https://de.wikipedia.org/wiki/LaTeX

[4] http://docbook.org/tdg5/

[5] http://docbook.svn.sourceforge.net/viewvc/docbook/trunk/defguide/en/

[6] https://de.wikipedia.org/wiki/Relax_NG

[7] https://de.wikipedia.org/wiki/Schematron

[8] http://www.docbook.org/xml/5.0/

[9] https://www.oasis-open.org/standards#dbv5.0

[10] http://docbook.org/docs/howto/

[11] http://java.net/downloads/msv/releases/

[12] http://www.docbook.org/tdg5/en/html/book.html

[13] http://www.docbook.org/tdg5/en/html/info.html

[14] http://www.docbook.org/tdg5/en/html/article.html

[15] https://de.wikipedia.org/wiki/Emacs

[16] http://www.thaiopensource.com/nxml-mode/

[17] http://ergoemacs.org/emacs/emacs23.2_features.html

[18] http://infohost.nmt.edu/tcc/help/pubs/nxml/emacs-commands.html

[19] http://snapshots.docbook.org/

[20] http://www.sagehill.net/docbookxsl/

[21] http://docbook.sourceforge.net/release/xsl/current/doc/reference.html

[22] http://docbook.sourceforge.net/release/xsl/current/doc/fo/paper.type.html

[23] http://www.sagehill.net/docbookxsl/TitleFontSizes.html

[24] http://doccookbook.sourceforge.net/

| Autoreninformation |

| Daniel Stender (Webseite)

hat einen Magister in Indologie, ist Debian-Maintainer und entwickelt im

Bereich Digital humanities.

|

Diesen Artikel kommentieren

Zum Index

von Jens Dörpinghaus

Mit Hilfe von Hadoop können Anwendungen entwickelt werden, die auf großen

Datenmengen effektiv arbeiten. Dieser Artikel soll eine erste thematische

Einführung geben und eine kleine Beispielanwendung für MapReduce in Java

vorstellen. Grundkenntnisse in Java werden für diesen Teil vorausgesetzt.

Hadoop im Umfeld von Big Data

Wenn es darum geht, große Datenmengen zu verarbeiten (das englische

Schlagwort dazu lautet „Big Data“) scheinen heutzutage keine Grenzen mehr

gesetzt zu sein. Doch das ist natürlich nicht ganz richtig. Datenmengen, die

etliche Terabyte erreichen, können meist ohne größere Probleme auf

verbundenen Datenbank- und Rechnersystemen in akzeptabler Geschwindigkeit

verarbeitet werden. Doch viele Firmen und Forschungseinrichtungen

verarbeiten schon wesentlich größere Datenmengen. Zu nennen ist hier

beispielsweise Google, das einen riesigen Index von Suchbegriffen und

Webseiten speichert. Niemand möchte aber allzu lange auf seine

Suchergebnisse warten und so ist es kein Wunder, dass

Hadoop [1] im Umfeld von Google entwickelt wurde.

Hadoop stellt für die schnelle und parallele Verarbeitung vieler, oft

komplexer Anfragen über große Datenmengen auf Computerclustern verschiedene,

in Java geschriebene Anwendungen und Bibliotheken als Framework zur

Verfügung, die es ermöglichen, Lösungen in diesem Bereich zu entwickeln.

Zu nennen ist hier etwa das Hadoop Distributed File System

(HDFS [2]), dass verteilt auf verschiedenen

Rechnern läuft und sich aus dem seit 2003 entwickelten Google Distributed

File System (GFS [3])

entwickelt hat.

HDFS wurde entwickelt, um sehr große Dateien zu speichern und, auch unter

etwaigen Anfangsverzögerungen, einen großen Durchsatz beim Lesen der Dateien

zu erreichen. Außerdem wurde Wert darauf gelegt, dass das Dateisystem auf

normaler Hardware ausfallsicher läuft. Dies sind allerdings auch die größten

Defizite: So ist ein zügiger Zugriff auf die Daten nicht immer gewährleistet

und das Dateisystem wird ineffizient bei vielen kleinen Dateien. Für weitere

Informationen sei auf das Buch „Hadoop: The Definitive

Guide“ [4] von Tom White verwiesen.

Weiter kommt Hadoop mit zwei Datenbanken für große Datenmengen (HBase und

Hive) und verschiedenen weiteren Programmen.

Was ist MapReduce?

„Map“ bezeichnet ein Verfahren, in dem auf jedes Element einer gegebenen Liste

eine bestimmte Funktion angewendet wird. „Reduce“ wiederum ist eine Technik,

in dem eine Datenstruktur analysiert und neu zusammengestellt wird. Das

„MapReduce“-Verfahren hat seinen Namen aus diesen beiden Systemen erhalten,

funktioniert aber ein wenig anders.

In der Map-Phase wird die Eingabe, bzw. die Datenmenge auf der das Verfahren

ausgeführt werden soll, in kleinere Untermengen aufgebrochen, die dann auf

verschiedene Knoten des Rechnerclusters verteilt werden. Dieses Verfahren

kann von den Knoten rekursiv weiter ausgeführt werden, in jedem Fall wird

aber das Ergebnis wieder zurückgegeben. In der Reduce-Phase werden diese

Ergebnisse gesammelt und zu einem Gesamtergebnis zusammengestellt. Die Map-

und Reduce-Prozesse können und werden idealerweise auch parallel ausgeführt.

Auch MapReduce wurde 2004 von Google

veröffentlicht [5]. Ebenso war Yahoo an

den Entwicklungen beteiligt und 2008 ging es als Projekt zu Apache.

Voraussetzungen für MapReduce

Als Grundlage der zu analysierenden Daten ist die Statistik der

Beherbergungsbetriebe in Deutschland gewählt worden, die man als CSV-Datei

aus der Regionaldatenbank Deutschland [6]

herunterladen kann. Dazu kann man unter „Themen“ die entsprechende Tabelle

auswählen und mit „Werteabruf“ anzeigen lassen. Über das CSV-Icon kann man

die entsprechenden Daten herunterladen.

Man kann die Analyse der Rohdaten natürlich programmseitig gestalten, aber um

das Beispiel einfach zu halten, seien die Daten nun im festen Abstand wie folgt

gesetzt:

1995;0000016068;0000000030;0000001124;0000106919;0000035943

1995;0000016069;0000000060;0000002817;0000399859;0000082828

1995;0000016070;0000000106;0000003633;0000376252;0000142199

1995;0000016071;0000000045;0000001963;0000348688;0000066315

Jahr;Region;Beherbergungsbetriebe;Gästebetten;Gästeübernachtungen;Gästeankünfte

Die Daten werden auf das HDFS kopiert und dort mit dem

MapReduce-Ansatz bearbeitet, um das Jahr mit der größten Anzahl von

Beherbergungsbetrieben in einer bestimmten Region zu bestimmen.

Auch wenn das folgende Beispiel in Java geschrieben ist, müssen

MapReduce-Anwendungen nicht in Java geschrieben werden.

Ebenso würde die Installation von Hadoop den Rahmen dieses Artikels

sprengen, dazu gibt es genügend Informationen im Internet. Wer es

beispielsweise nur auf einem Knoten ausprobieren möchte, sei auf die

detaillierte Einführung von Michael Noll

verwiesen [7]. Es liegen auch Pakete für einige Distributionen

bereit und zu guter Letzt gibt es auch automatische Installationsverfahren,

beispielsweise die Data Platform von

Hortonworks [8].

Die heruntergeladene CSV-Datei muss jetzt in das HDFS-Dateisystem kopiert

werden. Das kann folgendermaßen bewerkstelligt werden:

$ hadoop dfs -copyFromLocal beispiel.csv /

Dem Befehl hadoop dfs können verschiedene, aus der Shell bekannte Parameter

übergeben werden, etwa -ls oder -mv. Eine genaue

Auflistung mit

Erklärungen findet sich in der

Hadoop-Dokumentation [9].

Eine MapReduce-Anwendung

Das folgende Beispiel soll nun das Maximum der Beherbergungsbetriebe über

die Jahre ermitteln. Dazu soll ihrem Aufruf die Eingabedatei und das

Ausgabeverzeichnis übergeben werden.

Man erstelle nun eine Klasse MaxGuest. In der Main-Funktion prüft man,

ob die Anzahl der Parameter stimmt:

if (args.length < 2)

{

System.exit(-1);

}

Nun wird ein Job-Objekt erstellt. Dieses kümmert sich darum, dass der

benötigte Code an die Knoten verteilt wird. Dazu muss ihm eine JAR-Datei

oder einfach eine bestimmte Klasse, in diesem Fall die Klasse selber,

übergeben werden.

import org.apache.hadoop.mapreduce.Job;

...

Job job = new Job();

job.setJarByClass(MaxGuest.class);

job.setJobName ("MaxGuest");

Weiterhin muss eine Mapper- und Reducer-Klasse gesetzt werden, diese sollen

später implementiert werden:

job.setMapperClass(MaxGuestMapper.class);

job.setReducerClass(MaxGuestReducer.class);

Den Eingabe- und Ausgabepfad kann man an dieser Stelle auch setzen:

import org.apache.hadoop.fs.Path;