Zur Version ohne Bilder

freiesMagazin Juli 2012

(ISSN 1867-7991)

Kdenlive

Durch die vielfältigen Möglichkeiten, fast immer und überall Videos erstellen zu können, kommt man irgendwann an den Punkt, dass man sie nicht nur auf der Festplatte schmoren lassen, sondern auch Freunden und Bekannten präsentieren möchte. Nur muss vielleicht nicht jedes Detail einer Party zusehen sein. Als Linux-Nutzer ist man dabei bei Kdenlive an der richtigen Adresse. (weiterlesen)

Trac

Software für das Customer Relation Management (CRM) und zur Koordinierung von Neukundenakquisen gibt es in vielerlei Varianten. Aber manchmal muss es gar keine spezielle Software sein. Auch Software, die eigentlich für einen anderen Zweck geschrieben wurde, kann diese Aufgabe gut und effizient erfüllen: Trac. (weiterlesen)

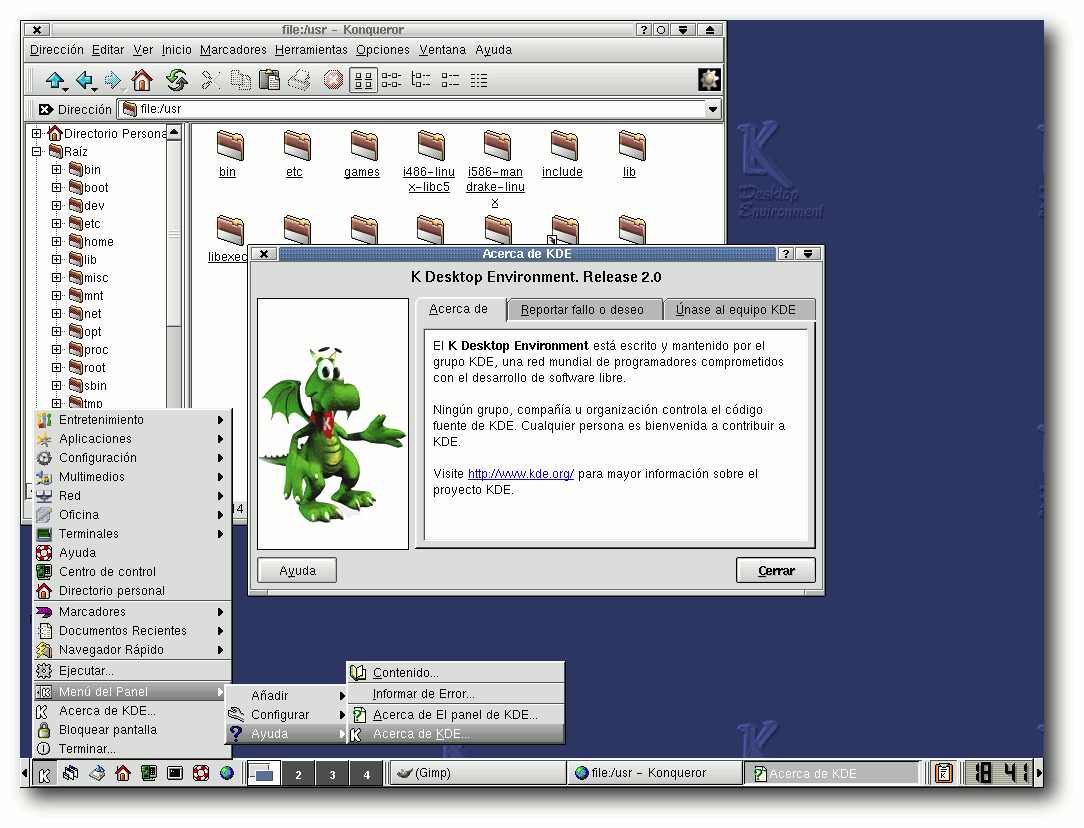

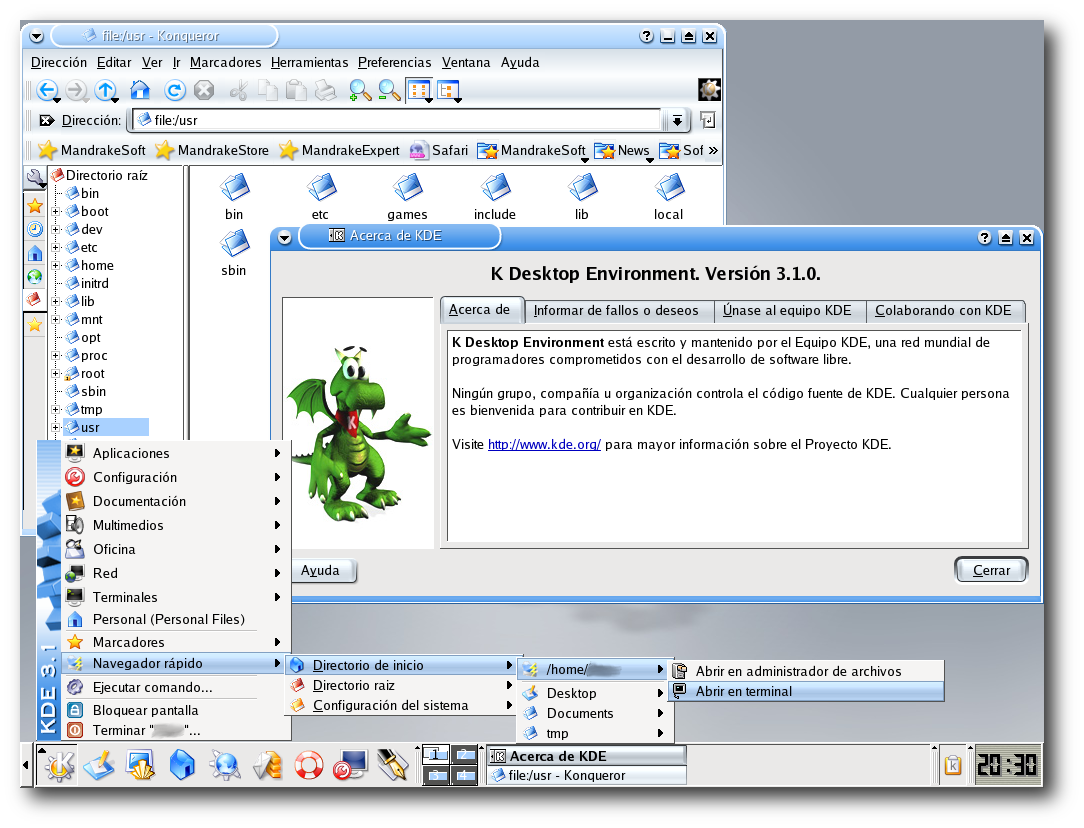

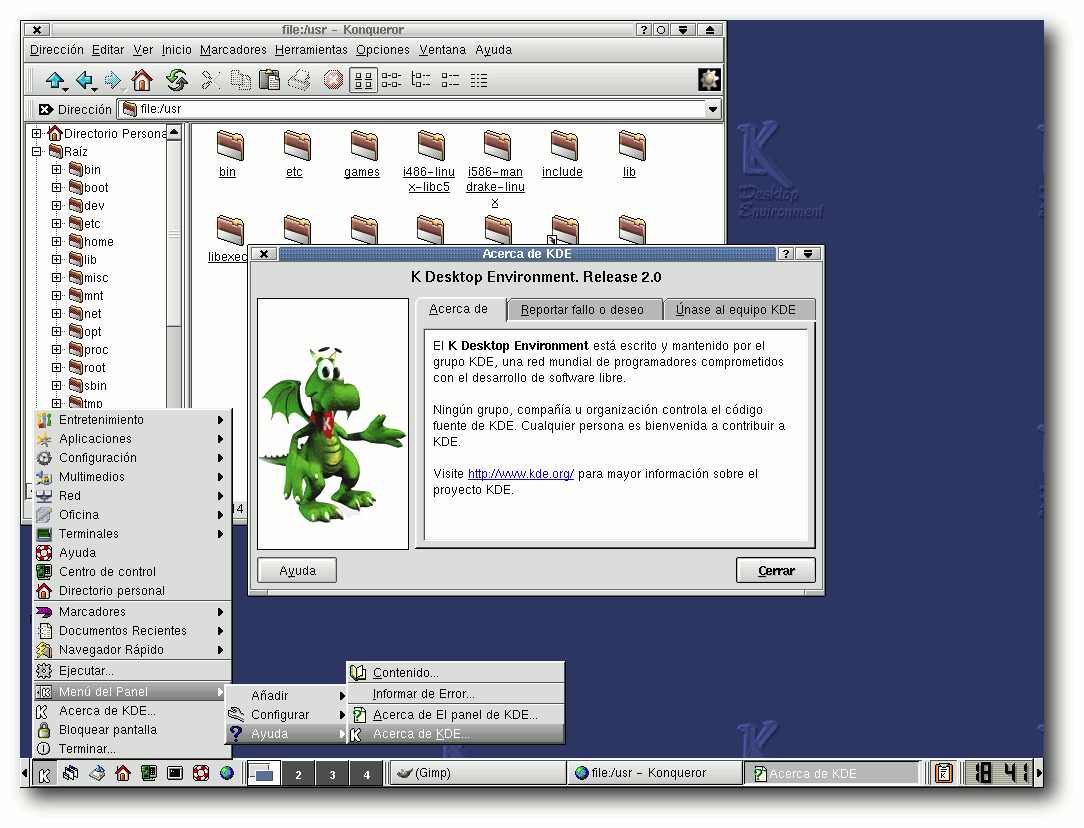

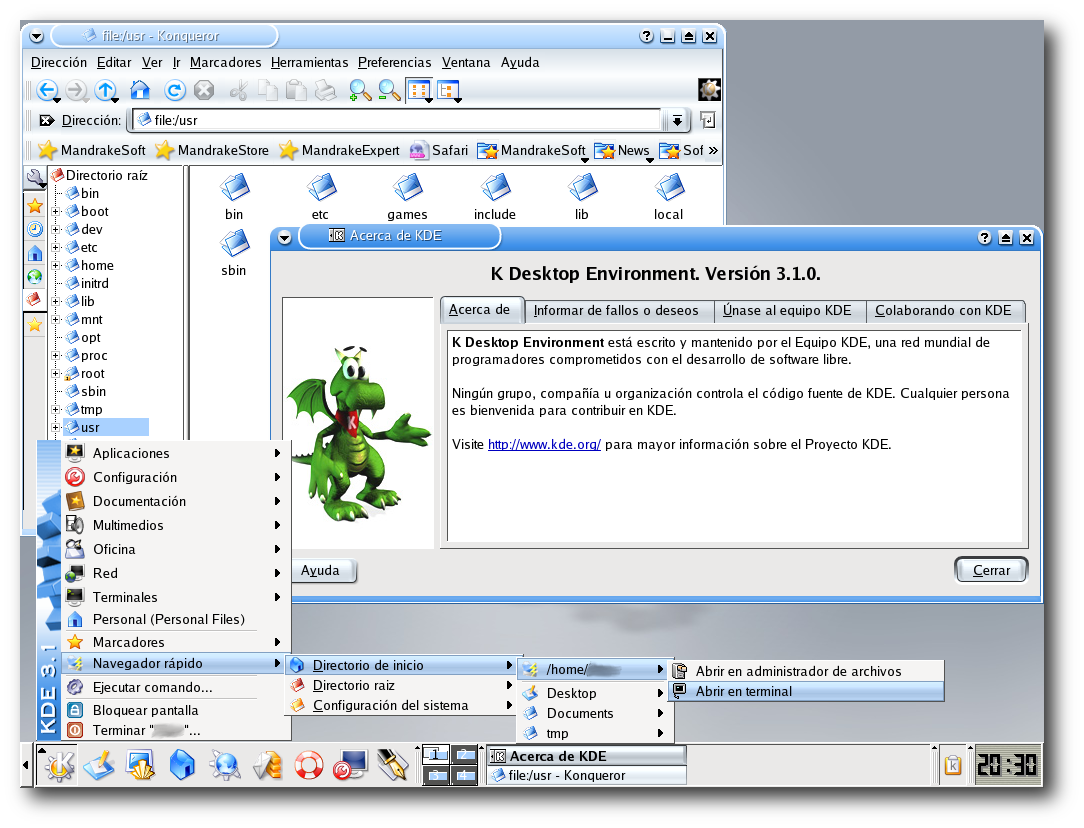

KDE-Geschichte

Im Oktober des letzten Jahres konnte die KDE Community ihren 15. Geburtstag feiern. Grund genug einmal die Geschichte dieser Community zu beleuchten, die mittlerweile zu einer der größten Freien-Software-Communities der Welt aufgestiegen ist. (weiterlesen)

Zum Index

Linux allgemein

Der Juni im Kernelrückblick

Anleitungen

Perl-Tutorium – Teil 7

Software

Kdenlive – Der freie Videoeditor für Linux, Mac OS X und FreeBSD

Trac statt CRM – ein Erfahrungsbericht

Catacomb Snatch

Nicht nur für Zombies: Einstieg in IronPython

Community

KDE-Geschichte

Rezension: HTML5 & CSS3 for the Real World

Rezension: Apps mit HTML5 und CSS3 für iPad, iPhone und Android

Magazin

Editorial

Leserbriefe

Veranstaltungen

Vorschau

Konventionen

Impressum

Zum Index

Spielen unter Linux

Letzten Monat [1]

haben wir Sie zum Thema „Linux als Spieleplattform” gefragt, ob Sie

Linux als eine eine realistische Alternative zu Windows ansehen, wenn

es um Spiele geht. Dass es zumindest einige gute Spiele gibt, beweist

die Vielzahl an Indie-Spielen, aber genügt dies? Die Meinungen einiger

unserer Leser finden Sie in den Leserbriefen am Ende der Ausgabe.

freiesMagazin als Debian-Paket

Wer jeden Monat nicht per RSS-Feed sondern per Paketverwaltung über

die Neuerscheinung von freiesMagazin informiert werden will, kann sich

zumindest als Ubuntu-Nutzer freuen. Der Benutzer MarcusLS [2] stellt jeden Monat freiesMagazin als

deb-Paket in seinem PPA (Personal Package Archive) zur Verfügung.

Das jeweils richtige PPA für seine Ubuntu-Version findet man auf der

Übersichtsseite [3]. Dort klickt

man auf den jeweiligen Eintrag mit „LTS“ oder „nonLTS“ und fügt das

PPA wie gewohnt seiner Paketverwaltung hinzu.

An dieser Stelle möchten wir darauf hinweisen, dass fremde

Paketquellen Probleme bei Paketaktualisierungen bereiten können, vor

allem, wenn sehr viel Software in ihnen vorhanden ist. Die Benutzung

geschieht also auf eigene Gefahr. Daneben erfolgt das Angebot nicht

von der freiesMagazin-Redaktion direkt, sondern ist ein reines

Privatangebot. Wer es nutzen möchte, ist aber herzlich dazu

eingeladen.

Nach der EM das Sommerloch?

Autoren sind natürlich das Salz in der Suppe eines Magazins, denn

ohne diese wäre die Setzer und Korrektoren arbeitslos. Da freiesMagazin

keine feste Autorenmannschaft hat, sind wir auf Zusendungen aus der

Community angewiesen. Dabei gilt: (Fast) jeder kann einen Artikel

über das schreiben, was ihn interessiert.

Eigentlich müssen Sie dafür nur Spaß am Schreiben haben und sich

verständlich ausdrücken können, sodass jeder Leser Ihren Artikel

oder Ihre Anleitungen nachvollziehen kann. Gerne gesehen sind vor

allem Softwarevorstellungen und Spiele, aber auch HowTos oder

Tutorials wünschen sich unsere Leser sehr. Eine übersichtliche Liste

von gewünschten Themen finden Sie in unserer

Artikelwunschliste [4].

Sicherlich kennen Sie sich in einem dieser Gebiete aus. Und wenn

nicht, sind wir auch immer offen für ganz neue Vorschläge aus den

Bereichen GNU/Linux, Freie Software und/oder Open Source.

Wir freuen uns auf Ihre Artikel!

Ihre freiesMagazin-Redaktion

Links

[1] http://www.freiesmagazin.de/freiesMagazin-2012-06

[2] https://launchpad.net/~marcusls/

[3] https://launchpad.net/~marcusls/+related-software

[4] http://www.freiesmagazin.de/artikelwuensche

Das Editorial kommentieren

Zum Index

von Mathias Menzer

Basis aller Distributionen ist der Linux-Kernel, der

fortwährend weiterentwickelt wird. Welche Geräte in einem halben

Jahr unterstützt werden und welche Funktionen neu hinzukommen, erfährt

man, wenn man den aktuellen Entwickler-Kernel im Auge behält.

Anfang Juni schloss Torvalds das Merge Window für Linux 3.5 und legte

der Linux-Gemeinde die erste Entwicklerversion

vor [1]. Die Anzahl der Änderungen

hielt sich in etwa im Rahmen der letzten Kernelversionen, die größeren

Neuerungen sind ähnlich überschaubar. Torvalds selbst machte auf den

„CoDel Packet Scheduler“ aufmerksam. CoDel steht für Controlled Delay

(gesteuerte Verzögerung) und soll die Größe des Warteschlange für zu

sendende Netzwerkpakete entsprechend des Netzwerkdurchsatzes anpassen.

Weiterhin wurde der Code des Virtualisierers

KVM [2] unter

der PowerPC-Architektur überarbeitet und aus dem Bereich der

x86-Architektur wurde die Unterstützung für den alten und vermutlich

sowieso nicht mehr genutzten

MCA-Bus [3]

entfernt.

Treiberseitig kann der Zugang von Grafiktreibern für die 200er Serie

von ASpeed Technologies sowie für die alten G200-Chipsätze von Matrox

vermeldet werden. Ebenfalls neu ist ein Treiber, der eine Cirrus-Grafik

unter QEMU [4] emuliert.

Der eine oder andere altgediente Netzwerker wird sich ein Tränchen

vielleicht nicht verkneifen können – die Unterstützung für Token

Ring [5] wurde vollständig

entfernt. Diese Art der Computervernetzung war eine frühe und äußerst

stabile Art um Datenpakete zu übertragen. Letztlich konnte die damit

mögliche Übertragungsrate jedoch nicht mit Ethernet Schritt halten.

Verbesserungen in der Art der Verkabelung erhöhten zwar die Toleranz

gegenüber fehlerhafter Verkabelung, jedoch konnte sich Token Ring

letztlich nicht durchsetzen. Da mittlerweile der Pflegeaufwand der

entsprechenden Implementierung im Linux-Kernel den Nutzen aus Sicht der

Entwickler weit übersteigt, wurde die Unterstützung eingestellt.

Entwicklerversion Nummer Zwei [6]

folgte bereits sechs Tage

später. Der Grund dafür war nicht, dass keine Pull Requests mehr

bei ihm eingegangen wären, sondern eine Reise in seine Heimat Finnland

um den Millenium-Preis der finnischen Akademie für Technologie

entgegenzunehmen [7]. Entsprechend ist der -rc2

auch etwas kleiner als erwartet, bringt mit „Frontswap“ jedoch den

zweiten Teil des Transzendenten Speichers. Der erste Teil, Cleancache,

wurde bereits vor einem Jahr eingeführt (siehe „Der Mai im

Kernelrückblick“, freiesMagazin 06/2011 [8]). Frontswap wird künftig die letzte Chance für

wenig genutzte Speicherbereiche sein, um nicht direkt in den

langsameren Swap-Bereich auf der Festplatte verschoben zu werden. Dabei

wird nicht garantiert, dass Frontswap übergebene Speicherseiten auch

annimmt. Jedoch ist gewährleistet, dass diese auch später noch

vorhanden sind. Bei Cleancache sieht das etwas anders aus. Die hier

gespeicherten Daten können zu einem späteren Zeitpunkt verschwunden

sein, weshalb sich hier nur die Ablage redundanter Daten empfiehlt, zum Beispiel

um sie zu cachen.

Die Idee hinter Transcendent Memory ist das bessere Ausnutzen des

Arbeitsspeichers, indem dieser maximal möglich belegt wird. Weiterhin

verwenden Cleancache und Frontswap verschiedene Tricks wie

Deduplizierung [9] und Komprimierung, um möglichst viele Daten unterzubringen.

Ein kleines bisschen größer war die dritte

Entwicklerversion [10], deren

Änderungen jedoch

fast durchgängig mit den Worten „fixes“ und „updates“ beschrieben

waren. Eine der wenigen Ausnahmen stellt die Aufnahme eines Treibers

für die Netzwerkkomponente von Tileras

Tile-Gx-Prozessorfamilie [11]

dar, die auch direkt mit knapp der Hälfte der hinzugekommenen

Code-Zeilen auftrug.

Weitere KVM-Korrekturen für die PowerPC-Architektur bringt dann Linux

3.5-rc4 [12] mit, gewürzt von

Korrekturen des i915-Treibers für Intel-Grafiken. Letztere sollen

unnötige Abfragen am

Displayport [13] verhindern, die zum

Flackern eines angeschlossenen Anzeigegeräts führen können. Die am

meisten auftragende Änderung des eigentlich recht kleinen -rc4 waren

Korrekturen an printk(), der für die Ausgabe von Kernel-Meldungen an

dmesg, Syslog und die Konsole zuständigen Schnittstelle. Nun können auch Binärdaten, die im Ausgabepuffer landen, entsprechend weitergereicht

werden.

Links

[1] https://lkml.org/lkml/2012/6/3/84

[2] https://de.wikipedia.org/wiki/Kernel-based_Virtual_Machine

[3] https://de.wikipedia.org/wiki/Micro_Channel_Architecture

[4] https://de.wikipedia.org/wiki/QEMU

[5] https://de.wikipedia.org/wiki/Token_Ring

[6] https://lkml.org/lkml/2012/6/8/596

[7] http://www.pro-linux.de/news/1/18474/millennium-preis-fuer-linus-torvalds-und-shinya-yamanaka.html

[8] http://www.freiesmagazin.de/freiesMagazin-2011-06

[9] https://de.wikipedia.org/wiki/Deduplizierung

[10] https://lkml.org/lkml/2012/6/16/181

[11] http://www.tilera.com/products/processors/TILE-Gx_Family

[12] https://lkml.org/lkml/2012/6/24/117

[13] https://de.wikipedia.org/wiki/DisplayPort

| Autoreninformation |

| Mathias Menzer (Webseite)

wirft gerne einen Blick auf die Kernel-Entwicklung, um mehr über die

Funktion von Linux zu erfahren und um seine Mitmenschen mit seltsamen

Begriffen und unverständlichen Abkürzungen verwirren zu können.

|

Diesen Artikel kommentieren

Zum Index

von Herbert Breunung

Die objekt-orientierte Programmierung OOP (siehe aktuelle

freiesMagazin-Serie) war in den letzten Jahren eines der bereicherndsten Themen für Perl.

Nachdem im letzten Teil gezeigt wurde, wie bisher Objekte gestrickt wurden,

wird jetzt der Zugang zu den neuen Wegen geöffnet, die weit mehr beinhalten,

als man von Perl gewohnt war.

Hefte raus

Doch zuerst soll die Hausaufgabe verglichen werden. Die Methode

zufuege_notiz sollte um 3 Zeilen verlängert, sowie deren Anbindung

angepasst werden. Neben dem richtigen Umgang mit splice kam es vor allem

darauf an zu verstehen, dass die Hilfsmethode valider_index in diesem

Fall unbrauchbar ist. Die neue Nachricht darf ja auch an die hinterste bisher

nicht existierende Position. Dahinter verbirgt sich ein sehr häufiges,

grundsätzliches Problem. Das richtige Fingerspitzengefühl, ob man besser

valider_index erweitert, oder eine zusätzliche Methode schreibt, macht

„echte” Programmierer aus. In diesem Fall kopierte der Autor die entscheidende

Zeile aus valider_index und passte sie an. Auch wenn das scheinbar

gegen das heilige DRY-Gesetz verstößt und ein Prediger des sauberen Codes

empfehlen würde, etwas neues zu schreiben, statt nur eine Zeile sich

wiederholen zu lassen, waren andere Gründe ausschlaggebend. Erstens ist das

Projekt noch sehr jung und „vorzeitige Optimierungen sind der Grundstein allen

Übels”, wie ein anderer oft wiederholter Vers berichtet. Zum anderen ist es

nicht sinnvoll, für einen absehbar einmaligen Spezialfall eine weitere Routine

zu schreiben.

sub zufuege_notiz {

my ($selbst, $text, $index) = @_;

$index = $selbst->letzter_index + 1 unless defined $index;

return 1 unless $index >= 0 and $index <= $selbst->letzter_index + 1;

splice(@{$selbst->{'notizen'}}, $index, 0, $text);

return 0;

}

Hinter der dritten Zeile verbirgt sich eine weitere wichtige Überlegung. Wenn

kein index als zweiter Parameter angegeben wird, erscheint die Notiz an

letzter Position. Das entspricht dem bisherigen Verhalten und alle alten

Aufrufe dieser Funktion funktionieren weiterhin. Mindestens genauso wichtig ist

aber auch, dass man so beim Aufruf der Funktion die Anzahl der Notizen nicht

kennen muss. Es ist ja der Sinn eines Objektes, die Innereien zu verbergen. Das

verhindert auch, dass die Programmteile wie ein Wollknäuel zusammenhängen und

Änderungen immer schwerer werden. Optional könnte man auch -1 für den

letzten Index angeben. Viele Perlbefehle wie substr und splice

erlauben negative Indizes bei denen von hinten statt von vorne

gezählt wird. -2 wäre dann die vorletzte Position und so weiter. Um das

nachzuahmen, bräuchte zufuege_notiz statt der alten vierten Zeile:

return 1 if abs($index) > $selbst->letzter_index + 1;

$index = $selbst->letzter_index + 2 - $index if $index < 0;

abs liefert den absoluten Wert einer Zahl (lässt das Vorzeichen weg).

Wer gnädiger gestimmt ist, kann auch bei nicht existierenden Positionen statt

1 zurückzugeben und die (noch nicht existierende) Hilfe anzuzeigen

ebenfalls die letzte Position anwählen. Um die Zeilen ein wenig abzukürzen und

verständlicher zu machen, wird noch $selbst->letzter_index + 1 in eine

Variable verpackt. Die Routine sieht dann endlich so aus:

sub zufuege_notiz {

my ($selbst, $text, $index) = @_;

my $letzte_pos = $selbst->letzter_index + 1;

$index = $letzte_pos unless defined $index;

return 1 if abs($index) > $letzte_pos;

$index = $letzte_pos + 2 - $index if $index < 0;

splice(@{$selbst->{'notizen'}}, $index, 0, $text);

return 0;

}

Auf der anderen Seite des Aufrufes wurde aus:

when ($kommando{'neu'}) {

continue if $daten->zufuege_notiz($notiz);

}

folgendes:

when ($kommando{'neu'}) {

my($vor_dp, $nach_dp) = split ':',substr($notiz, 1);

my $pos;

if (defined $nach_dp) {

$notiz = ' '.$nach_dp;

$pos = $vor_dp;

}

continue if $daten->zufuege_notiz($notiz, $pos);

}

Wer mag kann 3 Zeilen zu einer schrumpfen lassen:

($pos, $notiz) = ($vor_dp, ' '.$nach_dp) if defined $nach_dp;

$pos muss vorher angemeldet werden, sonst dürfte es nicht im letzten

Aufruf verwendet werden (use strict; ist aktiv). Da (wie in den Teilen 1

bis 4 erläutert) im Falle einer simplen Eingabe (notiztext) $pos

undef bleibt, ist es für zufuege_notiz als bekäme sie keinen

Parameter index.

Das alles würde eine sehr gute Lösung ergeben, aber mittlerweile hat fast jede

when-Klausel fast die gleiche Zeile mit split. Deshalb wurde es

nach oben bewegt:

given ( substr($notiz, 0, 1) ) {

my($vor_dp, $nach_dp) = split(':',substr($notiz, 1), 2);

when ($kommando{'neu'}) {

my $pos;

if (defined $nach_dp) {

$notiz = ' '.$nach_dp;

$pos = $vor_dp;

}

continue if $daten->zufuege_notiz($notiz, $pos);

}

...

Dadurch konnten die nächsten zwei Klauseln um die verschobene Zeile gekürzt

werden:

when ($kommando{'aendere'}){

continue if length($notiz) < 4;

continue if $daten->aendere_notiz($nach_dp, $vor_dp);

}

when ($kommando{'bewege'}) {

continue if length($notiz) < 4;

continue if $daten->bewege_notiz($vor_dp, $nach_dp);

}

Die neue Einheitlichkeit macht den Code zusätzlich verständlicher. Außerdem

wurde split zuletzt noch ein dritter Parameter gegeben. Er bestimmt,

dass nur in 2 Teile zerlegt wird. Wenn die Notiz nämlich auch einen Doppelpunkt

enthält, teilt split in drei Teile. Dann geht der hintere Teil der

Nachricht verloren, da ihn keine Variable speichert. Mit dem Limit bekommt

$nach_dp die gesamte Notiz, selbst wenn sie Doppelpunkte enthält.

Diese Lösung (bn.pl) ist sicherlich noch nicht astrein und

endgültig, aber für den derzeitigen Stand genau genug.

Jetzt kommt der Elch

Nun endlich zur angekündigten Objektorientierung! Dafür ist diese Folge

bestimmt zu kurz, denn Moose (englisch für Elch) verdient ein eigenes,

zehnteiliges Tutorial. (Ein kleines, deutsches Tutorial ist gerade

erschienen [1].)

Moose führt nebenbei noch Datentypen, erstellbare Subtypen, Delegation,

Teilklassen (roles), Wrapping und sehr viel mehr ein. Durch Ergänzungen aus

dem kreativen MooseX-Ökosystem erhält man sogar echte Signaturen und neue,

passende Schlüsselworte. (Das „X” am Ende steht für Module, die ohne

Rücksprache mit den Autoren von Moose ins CPAN geladen werden.)

Wie kam Stevan Little dazu, solch eine umfangreiche Spracherweiterung

aufzubauen? Die meisten anderen Objektsysteme im CPAN erleichtern gerade einmal

das Schreiben der new-Methode und die Erzeugung von Attributen

(autogenerierte getter/setter). Wie so oft steckt dahinter Larry Wall. Mit dem

immer noch nicht vollendeten Entwurf der Schwestersprache „Perl 6” legte er ein

Objektsystem vor, wie es sich viele auch für Perl 5 wünschen.

Nur leider ist

vieles von seiner Mächtigkeit an Funktionalität gekoppelt, die Perl 5 ebenfalls

nicht besitzt. Somit konnte hier nicht, wie sonst üblich, ein einzelnes

Feature in ein Modul verpackt werden, dessen Name mit Perl6:: beginnt,

damit auch Perl 5-Benutzer in dessen Genuss kommen.

Stevan schuf mit Class::MOP

erst einmal ein an Common Lisp angelehntes Metaobjektsystem, mit dem sich jeder

sein eigenes Objektsystem gestalten könnte. Das rief natürlich die Spielkinder

auf dem Plan und nach einiger Zeit flossen verlockend aussehende Möglichkeiten

aus Smalltalk, Java, BETA, OCaml, Ruby und anderen Sprachen in Moose ein.

Überhaupt zeichnet Moose eine hohe Beteiligung auf allen Ebenen aus. Viele

wichtige Projekte setzen es ein und es wird sogar auf

perl.org [2]

und

enlightenedperl.org [3]

als Standardweg empfohlen. Ab Perl 5.16 weist es auch die Kerndokumentation als

lobenswerte Alternative aus [4]. Es

ist außerdem geplant nach 5.16 (erschien letzten Monat) eine kleine Auswahl aus

Moose in den Sprachkern aufzunehmen. Stevan Little arbeitet bereits daran.

Der Erfolg von Moose kam auch daher, dass seine Objekte voll kompatibel sind,

was für viele andere Objektsysteme nicht zutrifft. Alles, was in der letzten

Folge geschrieben wurde (bis aus die Syntax zur Erzeugung von Objekten), gilt

hier auch. Moose-Klassen vererben ihre Schätze an alte Klassen wie bereits

bekannt und ebenso können Moose-Klassen mithilfe von MooseX::NonMoose

alte Klassen beerben.

Wer das CPAN kennt, der weiß auch, dass ein großes und erfolgreiches Modul sehr

schnell Nachahmer findet, welche es beschleunigen und auf das Wesentliche

reduzieren wollen. Mouse ist eine fast vollständig kompatible Alternative ohne

Class::MOP, die erheblich schneller startet. Moo ist nicht kompatibel, sondern

nur ähnlich und auf das reduziert, was die 40 anderen Objektsysteme auch

bieten. Nur ist es sehr schnell, hat keine Abhängigkeiten und an Moose Gewöhnte

müssen kaum umlernen. In diesem Tutorialteil wird jedoch nur ein Ersatz für die

Daten.pm entwickelt, der Moose benutzt.

Objekte deklarativ

Genau gesagt wird

MooseX::Declare [5]

benutzt, welches die beliebtesten Erweiterungen gleich mit lädt. Moose

orientiert sich nämlich sehr konservativ an den Schreib- und Verhaltensweisen

von Perl 5, da es für den professionellen Gebrauch getrimmt ist. Mit

MooseX::Declare heißt die Klasse class, die Methode method

und nicht package und sub wie sonst in Perl 5. Es spart auch

wiederkehrende Phrasen wie

my $self = shift;

sowie das

__PACKAGE__->meta->make_immutable;

mit dem die Klasse verspricht, sich zur Laufzeit nicht mehr ändern zu wollen

und dafür an Geschwindigkeit gewinnt. Die Unterschiede sind noch wesentlich

tiefgreifender, aber das waren (mit den hinzukommenden Signaturen) die Gründe

dieses Module zu wählen, um Moose von seiner elegantesten Seite zu zeigen.

Da Moose-Klassen so andersartig geschrieben werden, sollte das Modul ganz neu

aufgezogen werden. Dabei bekommt nur die Datei, aber nicht die Klasse einen

neuen Namen, damit eine kleine Änderung in Zeile 5 einen einfachen Wechsel

erlaubt. use (wie im Teil 5 beschrieben) befiehlt ja im wesentlichen

nur, eine bestimmte Datei zu laden. Die enthaltene Klasse oder das enthaltene

Modul hat zwar in den meisten Fällen den gleichen Namen, aber das ist

freiwillig. Das Grundgerüst der MDaten.pm ist also:

use v5.12;

use MooseX::Declare;

use YAML;

class Daten {

}

Den Namensraum der Klasse in geschweifte Klammern zu legen, ist für

Perl-5-Programmierer ungewohnt. Aber auch in diesem Detail versucht

MooseX::Declare, so weit es geht, sich Perl 6 anzunähern. Bemerkenswert

ist zudem, dass die notorische 1; in der letzten Zeile des Moduls

weggelassen werden darf, was aber auch mit Moose funktioniert hätte.

Der wichtigste Befehl den Moose einführt ist has. Es ist das

Schlüsselwort mit dem auch in Perl 6 Attribute angemeldet werden.

Und da seine

Akzessoren (Getter und Setter) normale Methoden sind, in denen sich all die

Magie verbirgt, die hier noch bestaunt wird, kann Moose auch kompatibel

mit den alten Klassen sein.

Attribute

Das erste Attribut der Klasse ist der Name der zu ladenden Datei, in der alle

Notizen gespeichert sind. Ihm werden bereits in der Definition Eigenschaften

gegeben, über deren Einhaltung Moose wachen wird.

has 'datei' => (

isa => 'Value',

is => 'ro',

required => 1,

trigger => sub {

my $datei = shift->datei;

die "Datei: '$datei' nicht lesbar!" unless -r $datei;

},

);

Zuerst einmal ist das Attribut datei vom Typ Value. Das bedeutet,

dass leere Werte oder auch Referenzen als Inhalte nicht akzeptiert werden und

zur Laufzeit einen harten Fehler (mit Programmabbruch) ergeben. Ein praktische

Übersicht zu allen Moose-Datentypen und mehr hat der Spickzettel von Oliver

Gorwits [6].

ro steht für readonly, denn der Inhalt von datei soll nur einmal

beim Erzeugen des Objektes gesetzt und nie wieder verändert werden. Wird er

nicht angegeben, gibt das auch einen Error, da required => 1 dieses

Verhalten festlegt. Wenn es keinen Dateinamen gibt, braucht das Programm auch

nicht zu starten. Wo sollen denn dann die Notizen gespeichert werden?

Es sollte außerdem geprüft werden, ob die besagte Datei anwesend ist. Dies

übernimmt der letzte Eintrag, da die durch trigger bestimmte Routine

immer ausgeführt wird, wenn sich der Inhalt von datei verändert. Die

Routine bekommt das Objekt als Parameter, wie jede andere Methode auch. Vom

Objekt interessiert aber nur das Attribut datei. Dieses wird mit dem in

Folge 2 erklärten Dateitestoperator für die Lesbarkeit der Datei (-r)

überprüft und bei Fehlschlag mit Fehlermeldung abgebrochen. Da das Attribut

automatisch angelegt wird, gibt es keine Methode neu mehr. Die neue

Erzeugung des Objektes lautet daher:

my $daten = Daten->new( datei => 'notizblock.yml' );

Um noch mit der alten Klasse kompatibel zu bleiben, könnte man die Parameter in

geschweifte Klammern legen:

my $daten = Daten->new({ datei => 'notizblock.yml'});

Moose kann mit dieser verbreiteten Schreibweise gut umgehen, nur die Methode in

der Daten.pm muss angepasst werden. Denn die Methode muss jetzt

new heißen und bekommt ihre Parameter mit Namen in einem Hash:

sub new {

my ($klasse, $param) = @_;

my $selbst = bless ({ }, $klasse);

$selbst->datei_lesen( $param->{'datei'} ) if defined $param->{'datei'};

$selbst->{'notizen'} = [] unless exists $selbst->{'notizen'};

return $selbst;

}

Um solche Codeblöcke nebst allen Prüfungen der eingehenden Daten nicht mehr

schreiben zu müssen, wurde Moose entwickelt.

Das andere derzeit benötigte Attribut ist die Liste der Notizen.

has 'notizen' => (

isa => 'ArrayRef[Value]',

is => 'rw',

lazy => 1,

default => sub { [ YAML::LoadFile( shift->datei ) ] },

);

Sie muss ein Array aus echten Werten sein, die auch schreibbar sein sollten.

(rw steht wie auf Rohlingspackungen für read and write – lesen und

schreiben). lazy (faul) sagt aus, dass der Anfangswert erst dann erzeugt

wird, wenn die erste Leseanfrage an das Attribut kommt. Und default

zeigt auf eine Codereferenz, welche den Anfangswert ermittelt. Da

LoadFile einen Array liefert aber notizen als

ArrayRef[Value] (Referenz auf einen Array aus Werten) definiert ist,

mussten eckige Klammern drumherum, welche die gewünschte Referenz anlegen. Auf

diese Art ist sicher gestellt, dass der Dateiname bekannt ist, wenn die Datei

geladen wird.

Methoden

Die Methoden anzupassen, geht relativ einfach. Man muss nur auf $self

aufpassen. Diese von MooseX::Declare automatisch angelegte Variable

beinhaltet die Referenz auf das Objekt. Aber wenn die Methoden eigene Parameter

aus @_ fischt (siehe letzte Folge), dann ist das Objekt immer noch der

erste Parameter. Deshalb könnte man schreiben:

method datei_schreiben {

YAML::DumpFile( $self->datei, @{ $self->notizen } )

}

oder

method datei_schreiben {

my ($selbst) = @_;

YAML::DumpFile( $selbst->datei, @{ $selbst->notizen } )

}

zufuege_notiz, bewege_notiz und loesche_notiz brauchen

deshalb nicht geändert werden, nur aus sub muss method werden.

Normalerweise wird der Akzessor wie $selbst->notizen(...)angewendet.

Aber da hier splice mit vier Parametern verwendet wird, ändert das auch den

Inhalt des Attributes notizen.

In aendere_notiz wird ein

Arrayelement wie folgt geändert:

$selbst->notizen->[$index] = $text;

Manche mögen überlegen, die Notizen immer am Ende in die Datei zu schreiben.

Dann ließe sich der Aufruf von datei_schreiben im Hauptprogramm sparen.

(Kein Code kann keine Fehler beinhalten.) Dazu muss nur der Inhalt oder ein

Aufruf in die Methode

method DEMOLISH { ...

die immer am Ende der Lebensdauer eines Moose-Objektes aufgerufen wird. Da sich

aber die Bedienung sicher noch ändern wird, sollte der Vermerk darüber wann

gespeichert wird im Hauptprogramm bleiben („vorzeitige Optimierungen …”).

Signaturen

Eine der lautesten und berechtigsten Kritikpunkte an Perl ist das Fehlen von

Signaturen. Sicher ist jede Art der Parameterübergabe an Routinen mit

@_ möglich, doch steht auf den eigenen Fahnen, dass es mehr als einen

Weg gibt. Daher sollte auch der, den Java, Python & Co gehen, und der für

tausende Programmierer der gewohnte und natürliche ist, möglich sein. Die Rede

ist von der Definition der Parameter in runden Klammern nach dem Namen der

Routine. Wer die Änderungen der letzen Perlversionen aufmerksam verfolgte,

merkt, dass Vorbereitungen in diese Richtung getroffen werden. Wer jedoch volle

Signaturen sofort haben will, der nehme ein Modul wie signatures,

Sub::Signatures oder MooseX-Method-Signatures. Letzteres ist in

MooseX::Declare enthalten. Angewandt wird aus

method valider_index {

my ($selbst, $index) = @_;

return 0 if $index != int $index;

return 1 if $index >= 0 and $index <= $selbst->letzter_index;

}

Folgendes:

method valider_index (Num $index) {

return 1 if $index >= 0 and $index <= $self -> letzter_index;

}

Denn spätestens an dieser Stelle muss $self verwendet werden. Dafür wacht Moose,

dass wirklich Zahlen übergeben werden und erstellt sofort gleichnamige, lokale

Variablen, was die Methoden weiter verkürzt. Ein vorangehender Doppelpunkt in

der Signatur ermöglicht sogar benannte Parameter (wie bei new) und ein

nachgestelltes Fragezeichen stimmt Moose sehr gnädig, wenn dieser Parameter

fehlt (er ist dann optional). Notwendige Parameter (wie mit required =>

1 verlangt), hätten ein Ausrufezeichen an der Stelle. Positionale Parameter

sind von Haus aus notwendig und benannte optional – alles wie in Perl 6. In

Signaturen lassen sich auch Datentypen, selbsterdachte Subtypen und

Defaultwerte angeben.

method beispiel (Str :$name = "Max Mustermann", Int :$alter! where { $_ > 0 } ) {...

Da MooseX::Declare Moose::Util::TypeConstraints ebenfalls lädt,

könnte man damit einen eigenen Subtypen von Int anlegen, welcher nur

gültige Listenpositionen umfasst. So könnte Moose auch den Auftrag bekommen

aufzupassen, dass nur gültige Indizes gewählt werden, statt dafür wiederholt

etwas in die Methoden zu schreiben. Da dies einen Methodenaufruf in der

Subdefinition verlangt, würde das aber über den hiesigen Rahmen gehen. Als

kleines Beispiel soll ein Typ für gerade Zahlen genügen, der seine eigene

Fehlermeldung mitbringt.

subtype 'Gerade'

=> as Int

=> where { $_ % 2 == 0}

=> message { "$_ ist ungerade!" };

Abschluss

Diese bisher nicht beachtete Methode kann als überflüssig angesehen werden:

method numerische_reihenfolge { @{ $self->notizen } }

Andere Sortierreihenfolgen sind jedoch geplant, und werden erscheinen, wenn

Perls Alleskönner in Zeitfragen (das Modul DateTime) im übernächsten

Teil vorgestellt wird. Hausaufgabe soll eine optionale, alphabetische sortierte

Anzeige der Notizen sein. Da in dieser Folge die Grenzen von split und

substr sichtbar wurden, sollen beim nächsten Mal erste, einfach reguläre

Ausdrücke eingesetzt werden. Die vollständigen Dateien des aktuellen Standes

sind beigefügt. Es wurde auch der Text verbessert, mit dem nach Eingabe des

Kommandos gefragt wird.

Links

[1] http://www.heise.de/developer/artikel/Moose-Eine-post-moderne-OOP-Erweiterung-fuer-Perl-1584651.html

[2] http://www.perl.org/about/whitepapers/perl-object-oriented.html

[3] http://www.enlightenedperl.org/projects.html

[4] http://metacpan.org/module/perlootut

[5] http://metacpan.org/module/MooseX::Declare

[6] http://gorwits.me.uk/data/files/moose-quick-ref.pdf

| Autoreninformation |

| Herbert Breunung (Webseite)

ist seit sieben Jahren mit Antworten, Vorträgen, Wiki- und Zeitungsartikeln in

der Perl-Gemeinschaft aktiv. Dies begann mit dem von ihm entworfenen Editor

Kephra, den er

leidenschaftlich gerne pflegt. Daneben beschäftigt er sich hauptsächlich mit

wxPerl und Perl 6.

|

Diesen Artikel kommentieren

Zum Index

von Stephan Theelke

Durch die vielfältigen Möglichkeiten, fast immer und überall Videos

erstellen zu können, kommt man irgendwann an den Punkt, dass man sie

nicht nur auf der Festplatte schmoren lassen, sondern auch Freunden

und Bekannten präsentieren möchte. Nur muss vielleicht nicht jedes

Detail einer Party zusehen sein. Als Linux-Nutzer ist man dabei bei

Kdenlive [1] an der richtigen Adresse.

Ein anderes Beispiel ist die Rettung von alten privaten

Videokassetten. Sind sie erst einmal auf dem PC, ist es ganz einfach,

sie aufzufrischen, zu schneiden oder auch zusammenzufassen. Das heißt,

fehlerhafte oder langatmige Stellen können herausgeschnitten oder

gekürzt werden. Farb- und Tonkorrekturen sind natürlich ebenfalls

möglich.

Dieser Artikel stellt das Programm Kdenlive in den Grundzügen vor und will ein

erstes Interesse an Videobearbeitung unter Linux wecken.

Allgemeine Informationen

Die Entwicklung des freien Videoeditors geht bis auf das Jahr 2002

zurück. Zehn Jahre später erschien im Mai 2012 die Version 0.9.2. Ziel

der Entwickler ist außerdem, zum Ende des Jahres 2012 die

erste 1.0er Version veröffentlichen zu können.

Die Installation des Programms lässt sich bequem über die

Paketverwaltung durchführen.

Wie der Name andeutet, ist das Programm auf den KDE-Desktop

zugeschnitten und seit letztem Jahr auch Bestandteil der KDE SC, was

unter anderem bedeutet, dass Übersetzungen zentral verwaltet werden.

Somit ist Kdenlive für alle Distributionen, die KDE unterstützen,

verfügbar.

Außerdem gibt es Pakete für FreeBSD und den Mac. Einschränkend muss

man dazu sagen, dass es die Mac-Pakete nicht nativ gibt, sondern dass sie nur

für MacPorts [2] zur Verfügung

stehen.

Unterstützte Formate

Kdenlive unterstützt viele bekannte Formate. Es ist möglich, von

Videokameras Filme auf den Rechner zu importieren, da Kdenlive mit den

gängigen Camcorder-Formaten zusammenarbeitet. Im Speziellen sind das

MiniDV, HDV und AVCHD, wobei letzteres noch experimentell ist. Daneben

beherrscht es aktuelle Video-, Audio- und Bildformate. Man kann unter

anderem Flash-Videos, ohne sie umzuwandeln, bearbeiten oder die

angesammelten Handyvideos endlich ansprechend präsentieren.

Wenn der Film fertiggestellt ist, stellt sich die Frage, ob man ihn

z. B. ins Internet stellen oder auf DVD festhalten will. Zum Glück

bringt Kdenlive auch dafür alles Erforderliche mit. In den

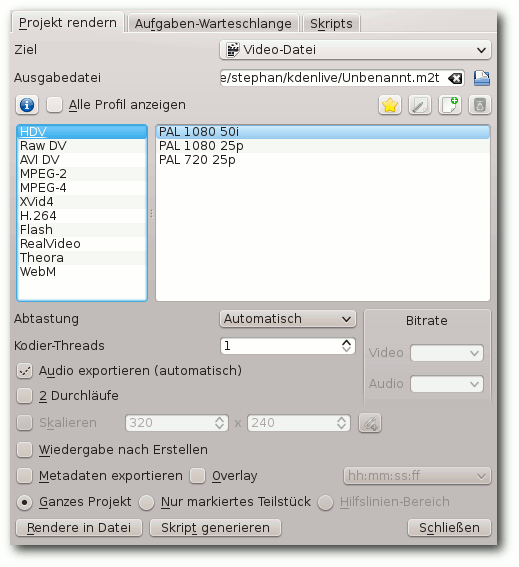

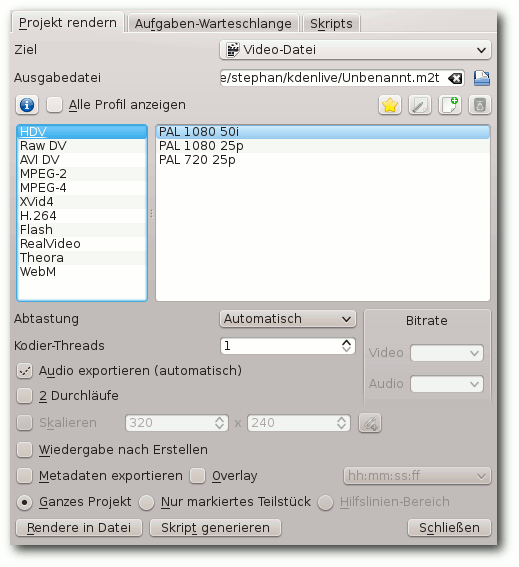

Einstellungen zum Rendern findet man sehr viele passende Profile, die

das Leben in dieser Beziehung stark vereinfachen und trotzdem ein

hervorragendes Ergebnis zu Tage fördern.

Rendereinstellungen.

Wem die gebotene Auswahl nicht ausreicht, der kann sich darüber hinaus

ganz einfach ein eigenes Render-Profil anlegen.

| Unterstützte Formate (Auswahl) |

| Video | flv, mpeg, avi, mp4 und mov |

| Audio | mp3, vorbis, wav, ogg und ac3 |

| Bild | gif, png, jpeg, xcf und svg |

Benötigte Hardware

Soll die Bearbeitung und später das Rendern nicht Ewigkeiten in

Anspruch nehmen, ist die nötige Hardware, gerade bei hochauflösenden

Aufnahmen in HD, gefragt.

Empfohlen wird für den normalen Nutzer ein PC ab Baujahr 2006. Das

entspricht einem Rechner mit Single oder Dual Core. Für die Filme wird

freier Festplattenplatz von mindestens 20 GB benötigt, außerdem ein

Firewire-Anschluss für die Aufnahme von einem Camcorder. Zudem sollten

mindestens 1 GB RAM an Arbeitsspeicher verbaut sein und auf dem

Schreibtisch ein Bildschirm mit einer Auflösung von mindestens

1024x768 Pixel stehen.

Fortgeschrittene und Semi-Profis sollten sich aber damit nicht

zufrieden geben. Sie sind mit einer Maschine, die einen Vierkern-Prozessor

und mindestens 4 GB RAM enthält, besser beraten. Auch ist

eine Grafikkarte, die zwei Bildschirme unterstützt, von großem

Vorteil, da alle Fenster in Kdenlive abgedockt und beliebig auf dem

Desktop arrangiert werden können. Zuletzt wird für einen vernünftigen

Datendurchsatz ein Festplattenaufbau im

RAID5-Verbund [3] nahegelegt.

Programmstart

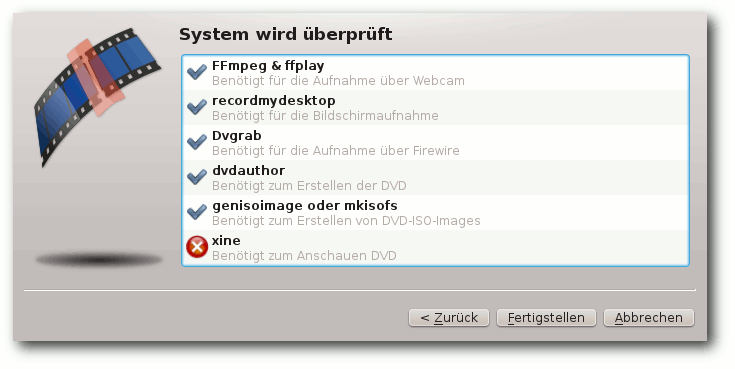

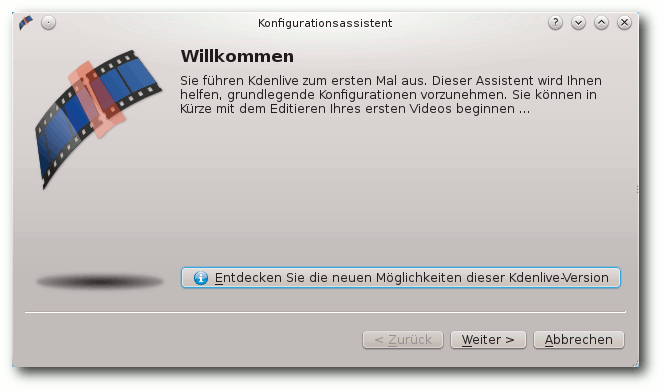

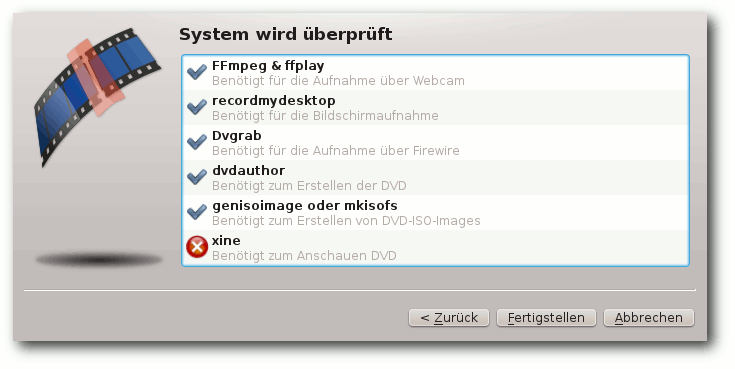

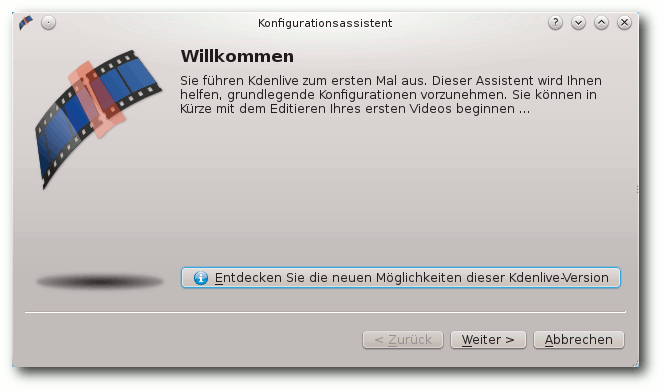

Beim ersten Start von Kdenlive öffnet sich der Konfigurationsassistent, in dem man

die Grundeinstellungen vornimmt. Dort werden zuerst die installierten

Module und Codecs, die zum Arbeiten mit den Audio- und Videodateien

benötigt werden, geprüft. Ggf. muss etwas nachinstalliert werden, was

im Assistenten durch ein rotes Kreuz angezeigt wird.

Xine ist nicht installiert.

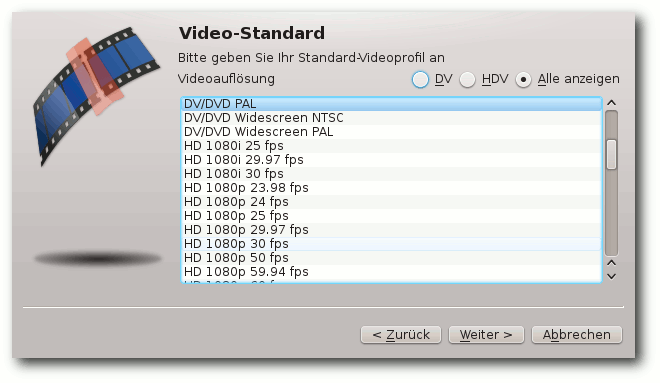

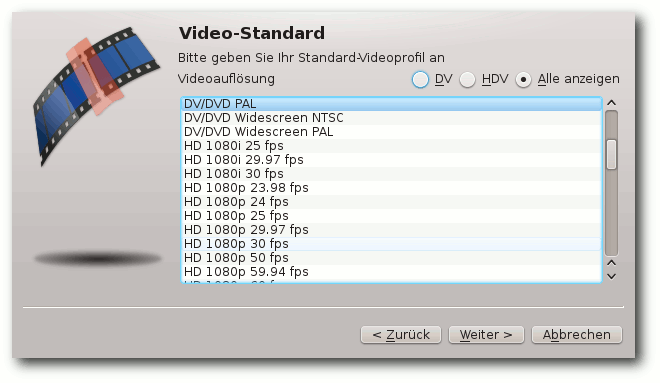

Als nächstes kann man das Videoprofil für das Projekt auswählen. Die

Einstellung des Profils sollte immer mit der Auflösung, der

Bildwiederholfrequenz und dem Seitenverhältnis des zu bearbeiteten

Videomaterials übereinstimmen. Eine genauere Erklärung kann man dazu

im Kdenlive-Forum [4]

finden. Danach

folgt die Auswahl des Standardordners für die Projekte, und

anschließend wird überprüft, ob eine Webcam vorhanden ist. Zum Schluss

folgt die Abfrage, ob die benötigten Zusatzprogramme, zum Beispiel für

das

Importieren des Films über Firewire oder die Aufnahme des Desktops,

installiert sind.

Einige der möglichen Videoprofile.

Der Konfigurationsassistent.

Das Abbrechen des Assistenten stellt auch kein Problem dar, da man ihn

jederzeit über den Menüpunkt „Einstellungen“ erreicht.

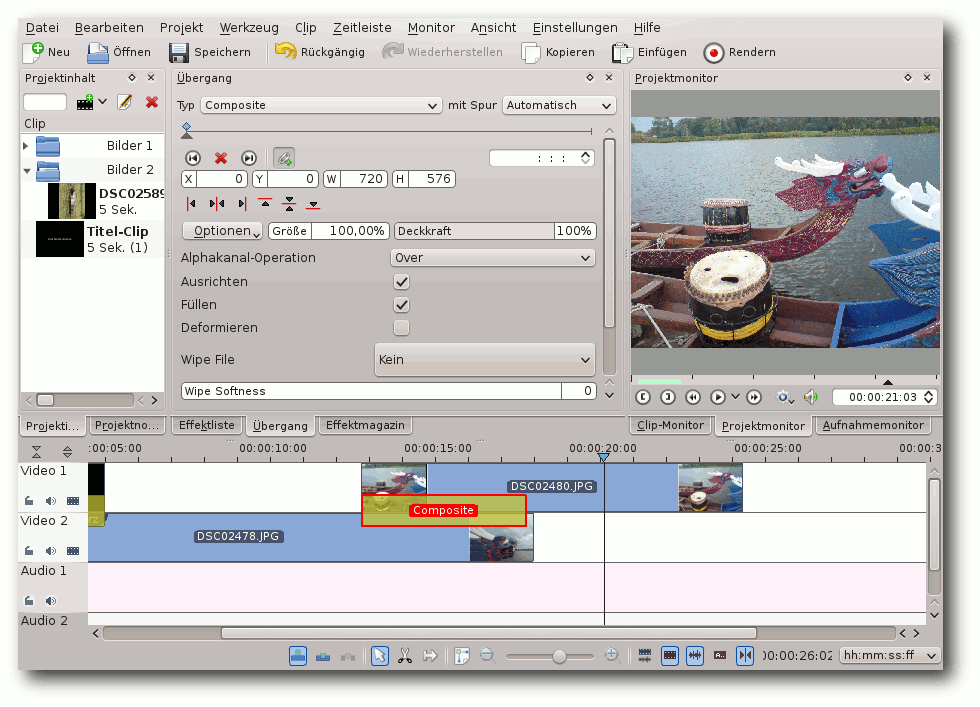

Aufbau der Programmoberfläche

Der Aufbau von Kdenlive gestaltet sich denkbar einfach und gliedert

sich grob in vier Teile.

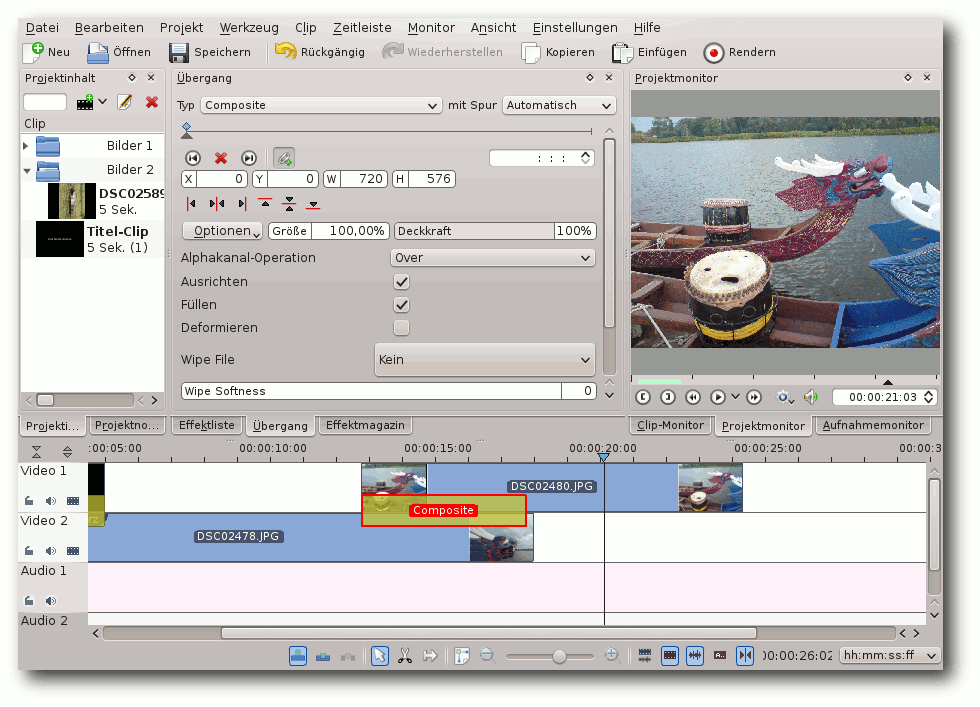

Gesamtübersicht von Kdenlive.

Im Projektbereich werden alle Dateien, also Filme, Bilder und Musik,

verwaltet.

Die Effektebene beherbergt alles, um die Projektdaten bild- und

tontechnisch zu bearbeiten, angefangen bei Helligkeits- und

Farbkorrekturen bis hin zur Tongestaltung und Entzerrung von

Tonfrequenzen.

Daneben gibt es mehrere Monitore. Zum einen kann im Aufnahmemonitor

das Überspielen auf den Rechner vom Camcorder oder von der Webcam gestartet

werden. Im Clip-Monitor werden dagegen die Rohdateien aus dem

Projektbereich

angezeigt. Um die Bearbeitung zu visualisieren wird der

Projektmonitor benötigt. In ihm werden die in den Audio- und

Videospuren lagernden Daten wiedergegeben.

Somit bilden die Audio- und Videospuren den vierten Teil des Aufbaus.

Hier findet also

das Schneiden und Arrangieren zum fertigen Film statt.

All dies wird in den nächsten Abschnitten ausführlicher beschrieben.

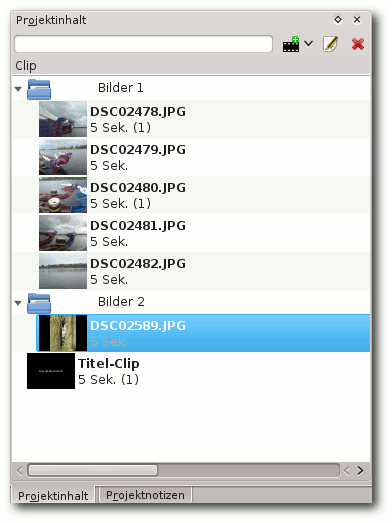

Der Projektbereich

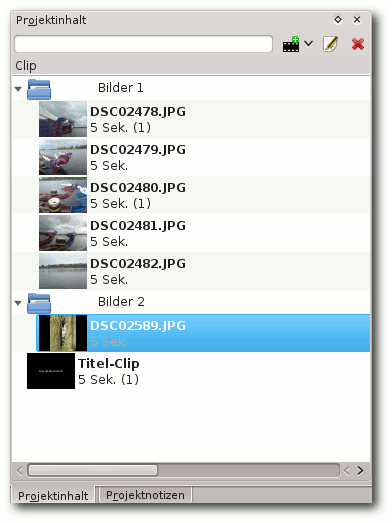

Im Projektinhalt finden sich die Projekt-Rohdaten wieder. Durch einen

Klick auf den Filmstreifen oder durch Auswahl von „Datei hinzufügen“

im Kontextmenü, können sie eingebunden werden.

Gruppierter Projektinhalt.

Die Vielzahl von unterstützten Formaten hat den Vorteil, dass das

aufwendige Umwandeln von Video-, Audio- und Bilddateien entfällt.

Neben den Rohdaten werden im Projektinhalt auch Clips für den Vor- und

Abspann aufgelistet. Kommen weitere Clips oder Generatoren hinzu, kann

leicht die Übersicht verloren gehen, bevor die eigentliche Arbeit

begonnen hat. Kdenlive bietet natürlich auch hier Abhilfe.

Über das Kontextmenü kann man Ordner zum Projektinhalt hinzufügen.

Dadurch werden die Projektdaten strukturiert, zugleich sind sie

einfacher zu handhaben.

Zum Schluss ist noch die Registerkarte „Projektnotizen“ zu erwähnen. Durch

sie bleibt der Überblick selbst dann erhalten, wenn längere Zeit nicht

an einem Film gearbeitet wurde.

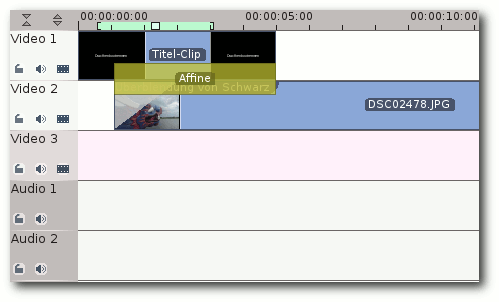

Der Bereich mit den Video- und Audiospuren

Aus dem nun übersichtlich gestalteten Projektinhalt kann man per

Drag & Drop die Dateien auf die Spuren ziehen und arrangieren. Zur

besseren Unterteilung gibt es Audio- und Videospuren, deren Anzahl

beliebig angepasst werden kann. Die Grundeinstellung von drei Video-

und zwei Audiospuren reicht aber in den meisten Fällen aus.

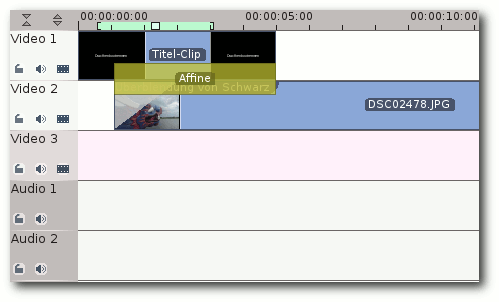

Die Standardvideospuren.

Oberhalb der Spuren befindet sich die Zeitleiste. Sie zeigt die Länge

des Films einmal in Zeiteinheit oder in der Anzahl der Bilder (Frames)

an. Ihre Zoomstufe ist mittels des Schiebers in der Statusleiste

veränderbar. Zoomstufe 13 ist die höchste; mit ihr ist ein genaues

Bild-für-Bild-Bearbeiten möglich. 0 ist die niedrigste Zoomstufe und

ermöglicht je nach Länge des Films einen Gesamtüberblick.

Die Statusleiste.

An der linken Seite befinden sich die Köpfe der Spuren. Hier können

sie entweder umbenannt oder für die Bearbeitung gesperrt werden.

Daneben besteht die Option, sie stumm zu schalten und zu verbergen.

Jetzt folgen ein paar grundlegende Möglichkeiten der Bearbeitung.

Zum Kürzen eines Videos reicht es, mit der Maus an das Ende oder den

Anfang eines Clips zu fahren. Dort erscheint ein grüner, blinkender

Pfeil und der Mauszeiger ändert seine Form zu einem Pfeil mit einem

senkrechten Balken an der Spitze. Jetzt einfach die Maustaste gedrückt

halten und in die zu kürzende Richtung ziehen.

Des Weiteren kann man Clips teilen oder gruppieren. Zum Teilen wird das

Scherensymbol

unterhalb der Spuren ausgewählt und auf die zu teilende

Stelle im Clip geklickt. Zum Verbinden wählt man zuerst die Clips aus und

klickt dann im Kontextmenü auf „Clips gruppieren“.

Interessant ist zudem die Funktion „Audio teilen“, die man ebenfalls

über das Kontextmenü erreicht. Mit dieser Funktion wird der

Audioanteil von einem Video getrennt; beide Teile sind somit

separat editierbar. Ein kleines Anwendungsbeispiel: Es wurde eine Rede

aufgenommen. Um sie visuell aufzupeppen zeigt man Bilder eines anderen

Clips (z. B. die Zuschauerränge). Es ist also möglich, Teile des

Redeclips zu entfernen und mit anderen Szenen zu ersetzen. Der

Audioanteil bleibt so unverändert und doch wird die Rede durch

abwechslungsreiche Szenen aufgelockert.

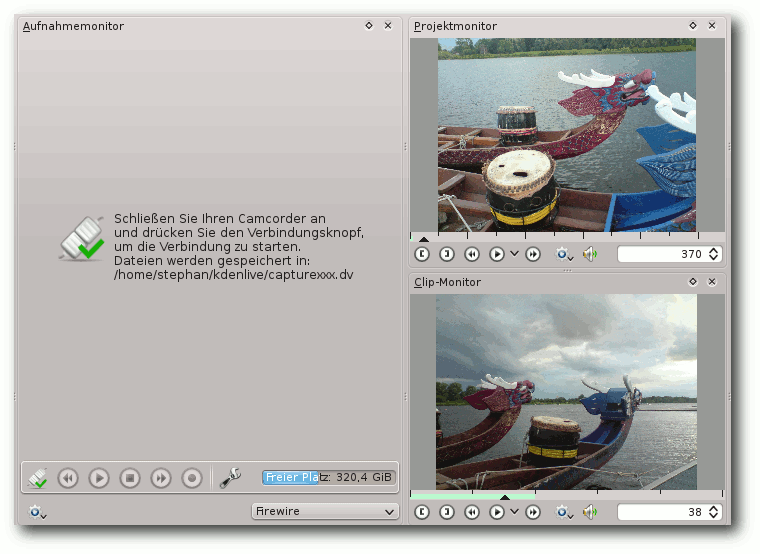

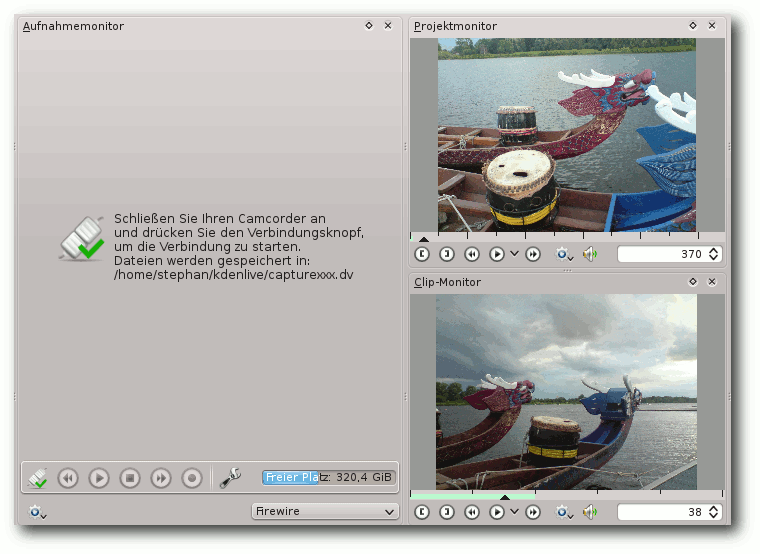

Der Monitorbereich

Wie eingangs erwähnt bietet Kdenlive drei Monitore. Der

Aufnahmemonitor verwaltet das Übertragen (engl. „Capture“) von

angeschlossenen Endgeräten auf den Rechner. Das kann zum Beispiel eine

Webcam oder ein Camcorder sein. Die Bildschirmaufnahme wird auch

angeboten, doch dazu am Ende dieses Abschnittes mehr.

Die Monitore.

Nun folgt die Vorgehensweise zum Capturen eines Films von einem

Camcorder. Dazu muss der Camcorder per Firewire an den PC

angeschlossen und der Abspielmodus aktiviert werden. Im

Aufnahmemonitor wird per Auswahlmenü „Firewire“ eingestellt. Über die Knöpfe

Verbinden, Vor- und Zurückspulen, Start/Stop und Aufnahme wird das

Capturen verwaltet.

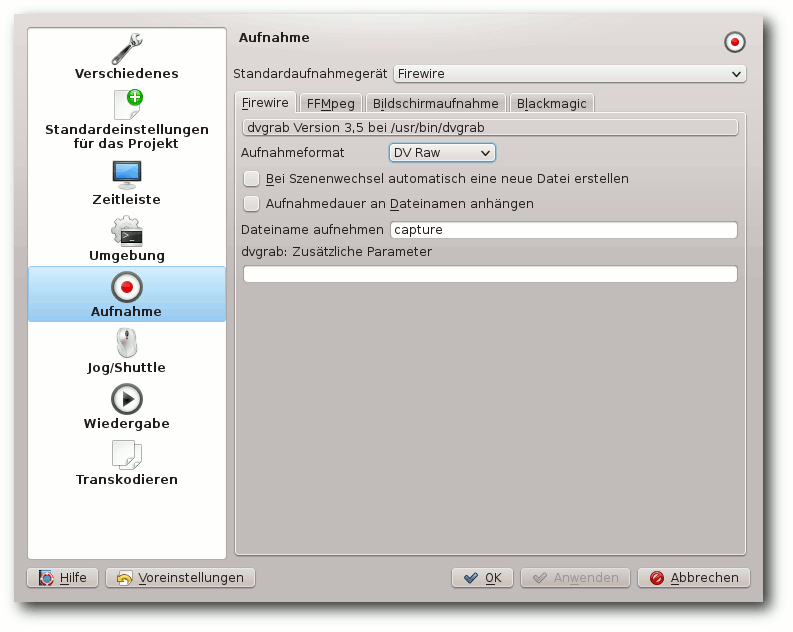

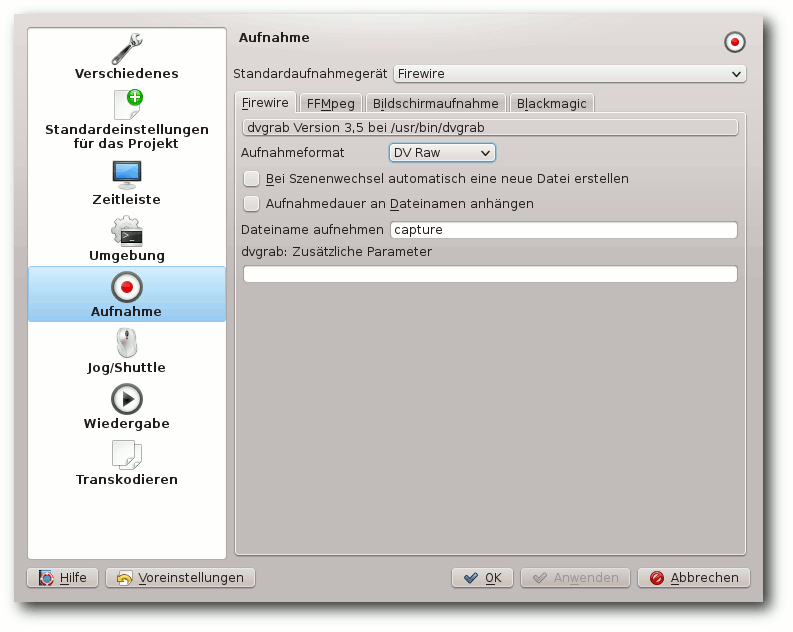

Mit dem Schraubenschlüsselsymbol gelangt man in die Aufnahme-Optionen,

in denen beispielsweise das Aufnahmeformat oder das Verhalten beim

Szenenwechsel verändert werden kann. Die aufgenommenen Daten werden im

Standardordner abgespeichert. (Zur Erinnerung: Dieser Ordner wurde zu

Beginn im Konfigurationsassistenten eingerichtet).

Die Aufnahme einrichten.

Ist die Hardware verbunden, klickt man auf „Verbinden“. Danach kann die

Aufnahme gestartet und per Monitor verfolgt

werden.

Da in der Standardeinstellung ein aufgenommener Clip sofort zum

Projekt hinzugefügt wird, kann gleich zur Kontrolle des Videomaterials

übergegangen werden.

Hierzu kommt der Clip-Monitor ins Spiel. Mit ihm können alle Medien,

die im Projektinhalt vorhanden sind, angesehen bzw. angehört werden.

So ist es möglich, die Aufnahme auf

Übertragungsfehler zu überprüfen

und man spart sich den Schritt, Dateien zur reinen Vorauswahl in eine

Spur ziehen zu müssen.

Alles, was auf den Spuren abgelegt ist, wird nämlich über den

Projektmonitor wiedergegeben. Die Auswirkungen von Schnitten, Effekten

und Übergängen werden darüber angezeigt. Auch wie sich die gewählte

musikalische Untermalung zu einer Szene macht, kann man so beurteilen.

Bevor zum nächsten Teil übergegangen wird, noch ein paar Worte zur

Bildschirmaufnahme.

Kdenlive nutzt dazu das Modul

„RecordMyDesktop“ [5].

Die letzte Version dieses Moduls erschien 2008. Sollte die Aufnahme

daher nicht das gewünschte Ergebnis bringen, kann auf ein Programm

zurückgegriffen werden, das unabhängig von Kdenlive und

RecordMyDesktop funktioniert.

Besagtes Programm heißt

Vokoscreen [6]. Auf der Internetseite des Programms

gibt es weiterführende Informationen und ein Demovideo, und man kann es auch

von dort herunterladen.

Der Effektebereich

Der folgende Abschnitt ist wohl für die meisten Leser der

interessanteste, denn hier sind alle Möglichkeiten der Audio- und

Videomanipulation zusammengefasst.

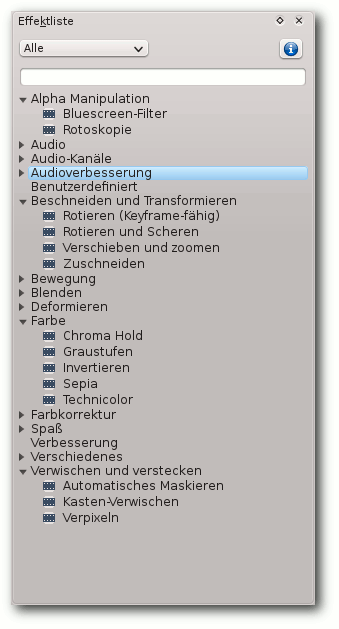

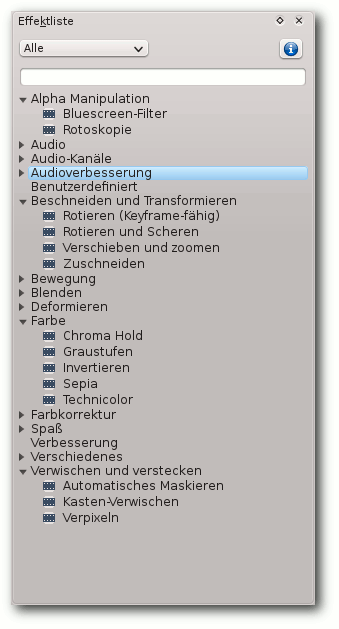

Kdenlive bringt von Haus aus eine Vielzahl von Effekten mit.

Außerdem – ein großer Vorteil von Open Source – kann jeder etwas zur

Erweiterung und Verbesserung beitragen. Wer das unter anderem schon

getan hat, kann man in den Credits nachschlagen. Es geht aber auch

wesentlich schneller: Verweilt man mit der Maus über einem Effekt,

erscheint im Pop-Up-Menü neben den Effektinfos auch dessen Autor.

Doch nun zum eigentlichen Thema dieses Abschnittes. Einen Effekt zu

nutzen ist sehr einfach. Es reicht, ihn per Drag und Drop aus der

Effektliste auf einen Clip zu ziehen. Damit wird der Effekt auch nur

auf diesen Clip angewendet. Soll aber aus einem Farbfilm nachträglich

ein Schwarzweißfilm gemacht werden, so muss man nicht erst alle Clips

auswählen. Wird der Effekt auf den Spurkopf fallen gelassen, gilt er

für die gesamte Spur. Dadurch erreicht man viel schneller und

einfacher dieses Ziel.

Eine kleine Effekteauswahl.

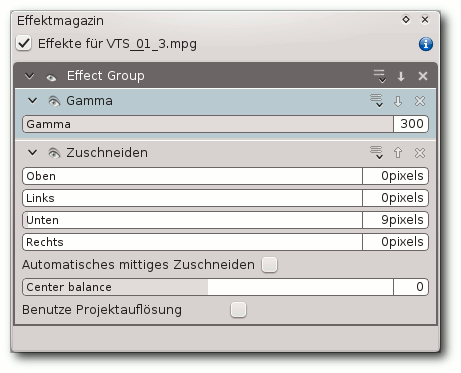

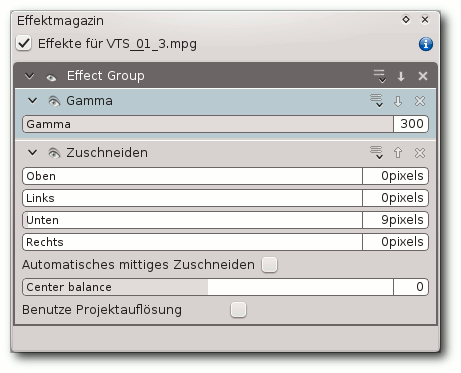

Das Effektmagazin verwaltet die Effekte. Je nachdem ob ein Clip oder

eine Spur ausgewählt wurde, erscheinen die enthaltenen Effekte. Hier

können die Einstellungen nach Belieben angepasst, Effekte gruppiert

oder sogar exportiert werden. Die folgende Auswahl soll nur einen

kleinen Überblick geben und ist bei Weitem nicht vollständig.

Gruppierte Effekte.

Beschneiden und Transformieren

- Bild beliebig drehbar, mit und ohne Animation

- das Bild zuschneiden, z. B. um den unteren Bildteil wegzunehmen, der bei alten Videos gerne beschädigt ist

Bewegung

- ein Standbild erzeugen

- verändern der Abspielgeschwindigkeit

- Stroboskop-Effekt erzeugen

Blenden

- Ton ein- und ausblenden

- Bild schwarz ein- und ausblenden

Deformieren

- Bild ist unter anderem horizontal oder diagonal spiegelbar

- horizontale oder vertikale Wellen einstellbar

Audiokanäle

- Balance ist veränderbar

- Mono in Stereo ändern

- Kanäle vertauschen

Spaß

- Bildwackler oder Bildrauschen einfügen

- Staubpartikel hinzufügen, die Anzahl und Größe ist einstellbar

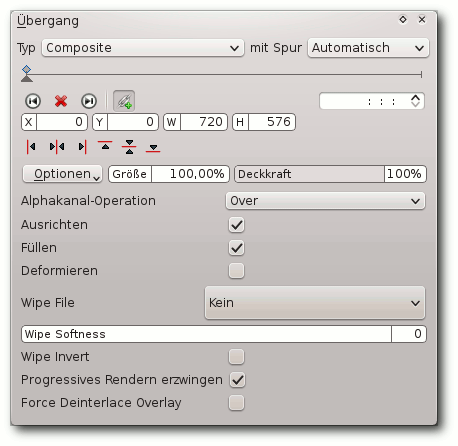

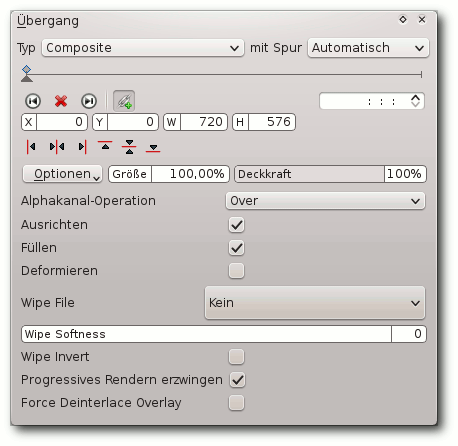

Zu den Effekten gehören auch Szenenübergänge. So kann sich z. B.

eine Szene von oben, unten, rechts oder links vor eine andere

schieben oder sich einfach auflösen.

Beispiel für einen Übergang.

Interessant ist auch die Bild-in-Bild-Option. Möchte man

beispielsweise einen Kommentator zu einer Szene einblenden, so ist das

darüber möglich.

Zu beachten ist, dass Übergänge nur auf sich überlappenden Clips

angewandt werden können. D. h. die zu verbindenden Clips müssen in

unterschiedlichen Spuren liegen, dann wählt man einen Clip aus und wählt per

Kontextmenü „Übergang hinzufügen“ aus. Die Anwendungsbereiche

sind vielfältig, und einige Varianten sollen kurz vorgestellt werden.

| Übergänge und Beschreibung |

| Affine | Größe, Ausrichtung, Drehwinkel und Scherung verändert werden |

| Bereich | Auf das überlagernde Bild einen Wischeffekt (Wipe File) anwenden. Wischeffekte sind u. a. spiral-, wolken- oder explosionsförmig |

| Slide | Szene von beliebiger Seite über eine andere schieben lassen |

| Wipe | Szenen fließen ineinander über |

Erwähnenswertes

Kdenlive bietet daneben noch automatische Backups an, um möglichem

Datenverlust vorzubeugen.

Auf der Internetseite des Programms sind viele Erklärungen und

Informationen zu Effekten vorhanden. Es gibt ausführliche Artikel zum

Farben-Histogramm, das für die Darstellung der Farbverteilung wichtig ist,

oder zum Vectorscope, das für den Farbabgleich interessant ist, und

natürlich vieles mehr. Ein Forum [7],

in dem man sich austauschen und Hilfe

finden kann, gibt es selbstverständlich auch.

Effekte, Übergänge und einiges mehr können im Programm über

„Einstellungen“ heruntergeladen und über die Internetseite kann selbst

erstelltes Material mit anderen geteilt werden. Dadurch wächst stetig

der Pool an Erweiterungen.

Als letztes sind noch die Videotutorials hervorzuheben, die auf

anschauliche Weise einzelne Funktionen näher bringen.

Fazit

Kdenlive bringt alles mit, um seine Videos aufzubereiten. Es hat den

Vorteil, dass es nativ die unterschiedlichsten Formate beherrscht.

Um das Programm fit für die Zukunft zu machen, wurde Mitte März 2012

ein Spendenaufruf [8] gestartet.

Das Geld wird verwendet, um den Entwickler und Programmierer Till

Theato zwei Monate in Vollzeit an Kdenlive arbeiten zu lassen.

Hauptsächlich dreht es sich dabei um die Überarbeitung des

Programmkerns. Damit vereinfacht sich neben der Wartung auch die

Erweiterbarkeit.

Schon wenige Tage nach Beginn des Spendenaufrufs wurde die

erforderliche Summe von 4000 US-Dollar eingesammelt. Insgesamt kamen

7419 US-Dollar zusammen. Man kann also auf viele weitere Features gespannt sein!

Links

[1] http://www.kdenlive.org/

[2] http://www.macports.org/

[3] https://de.wikipedia.org/wiki/RAID

[4] http://kdenlive.org/forum/output-size-not-same-clips

[5] https://de.wikipedia.org/wiki/RecordMyDesktop

[6] http://www.kohaupt-online.de/hp

[7] http://www.kdenlive.org/forum

[8] http://www.indiegogo.com/kdenlive-re

| Autoreninformation |

| Stephan Theelke

arbeitet seit langem mit Linux und möchte die

Möglichkeiten und Vorteile von Open-Source-Software bekannter machen.

|

Diesen Artikel kommentieren

Zum Index

von Jochen Schnelle

Software für das Customer Relation Management, kurz

CRM [1] und zur

Koordinierung von Neukundenakquisen gibt es in vielerlei Varianten. Aber manchmal

muss es gar keine spezielle Software sein. Auch Software, die eigentlich

für einen anderen Zweck geschrieben wurde, kann diese Aufgabe gut und effizient

erfüllen. So geschehen auch im folgenden geschilderten Fall, wo

Trac [2], eine Webanwendung, welche

eigentlich in der Softwareentwicklung zu Hause ist, erfolgreich zur

Koordination und Dokumentation einer Neukundenakquise-Aktion genutzt wurde.

Anforderungen

In einem mittelständischem Unternehmen mit einer eindeutig definierten,

fokussierten und überschaubaren Kundengruppe – hier Aluminium-, Eisen- und

Stahlgießereien – sollte eine gezielte Neukundenakquise für ein bestehendes

Produkt durchgeführt werden, um einen größeren Marktanteil zu gewinnen. Es war

von vornherein klar, dass im Rahmen der Akquise weniger als 200 Kunden

kontaktiert werden würden. Des weiteren war klar, dass die Akquiseaktion

schrittweise verläuft, d. h. nicht alle potentiellen Kunden auf einmal

kontaktiert werden.

Die Akquisen sollten natürlich dokumentiert werden, d. h. wer wurde wann

kontaktiert, wie ist der aktuelle Status (z. B. Angebot geschickt, bemustert,

erste Testbestellung erhalten usw.) und wer (= welcher Mitarbeiter) ist

federführend für diesen (potentiellen) Kunden zuständig. Außerdem sollte der

Status schnell und ohne weitere Zwischenschritte jederzeit aktuell abrufbar

sein. Und das für jeden Mitarbeiter, der Zugriff auf das Intranet der Firma

hat. Der schreibende Zugriff sollte weiterhin eingeschränkt und nur bestimmten

Mitarbeitern vorbehalten sein.

Softwareseitig sollte die Software zur Koordination der Akquise auf einem

Server im Intranet der Firma laufen. Dazu stand entweder eine

Microsoft-basierte Infrastruktur (Windows Server, Sharepoint) oder ein

Linux-Server (Ubuntu 10.04 LTS) zur Verfügung, wobei letzterer in einer

virtuellen Maschine läuft. Prinzipiell wäre auch eine spezielle Serverlösung

möglich gewesen, sofern sich diese virtualisieren lässt. Diese Option wurde

aber nicht präferiert und sollte nach Möglichkeit nicht zum Zug kommen.

Ebenfalls stand fest, dass die Anzahl der Zugriffe auf das System eher gering

sein würde, zu Spitzenzeiten immer noch deutlich weniger als 500 Zugriffe pro

Tag. Von daher spielte die Performance der Software bzw. des Servers und der

Datenbank hier auch keine entscheidende Rolle.

Des Weiteren sollte die Softwarelösung frei im Sinne von kostenlos sein, es

sollte also weder kommerzielle Software noch kommerzieller Support in Anspruch

genommen werden. Ob die Software frei im Sinne einer freien, Open Source Lizenz

ist, spielte (fast) keine Rolle. Ebenfalls eine untergeordnete Rolle spielte,

ob die Software „nur“ in Englisch vorliegt oder auch auf Deutsch lokalisiert

ist, da klar war, dass alle Nutzer hinreichend gut Englisch verstehen bzw.

sprechen und schreiben können.

Softwareauswahl

Im Rahmen der Softwareauswahl war relativ schnell klar, dass die vorhandene

interne Software Microsoft

Sharepoint [3] und

Dynamics

Nav [4] mit

den vorhandenen Bordmitteln die Anforderungen nicht umsetzen können, d. h. hier

wären kostenpflichtige Zusatzmodule oder Support notwendig gewesen, was – wie

bereits gesagt – nicht gewünscht war.

Es gab auch relativ schnell die Idee, dass die Anforderungen wohl auch von

einem Ticketsystem [5]

abgedeckt werden könnten, sofern dessen Felder einfach und frei konfigurierbar

wären. In der Vergangenheit war bereits für einen gewissen Zeitraum das

Ticketsystem Roundup [6] im Einsatz.

Dieses war aber – zumindest damals – relativ aufwendig anzupassen und nicht

wirklich einfach zu installieren und zu konfigurieren. Von daher kam es nicht in

die engere Auswahl.

Der Autor kannte als Nutzer bereits das Ticketsystem von Trac, das

zumindest aus Anwendersicht sehr einfach und komfortabel zu bedienen ist. Ein

Blick in die Dokumentation [7]

offenbart, dass der Betrieb von Trac sehr einfach (dazu später mehr) und

das Ticketsystem leicht anpassbar ist. Von daher wurde kurzerhand der

Entschluss gefasst, eine Trac-Instanz versuchsweise aufzusetzen und für

den angedachten Zweck zu testen. Dabei sollte Trac auf dem virtuellen

Linux-Server laufen.

Trac besteht aus noch weiteren Komponenten als nur dem Ticketsystem.

Weitere Kernbestandteile sind ein Wiki und ein Repository Browser. Letzterer

bleibt aber weitgehend im Hintergrund, wenn man kein Repository

einbindet.

Trac installieren und konfigurieren

Wie bereits erwähnt gestaltet sich die Installation von Trac sehr

einfach, im vorliegenden Fall wurde die (zum Zeitpunkt der Installation)

aktuelle Version 0.11 verwendet.

Voraussetzung für den Betrieb ist nur eine Python-Version zwischen 2.4 und

2.7 [8] – eine Voraussetzung, die selbst alte

Linux-Distributionen ohne Weiteres erfüllen. Da Trac standardmäßig

SQLite [9] als Datenbank nutzt, muss dieses

ebenfalls installiert werden. SQLite ist in Python ab Version 2.5 bereits

enthalten, so dass hier keine manuelle Installation mehr notwendig ist.

Um die Installation zu vereinfachen, sollten ebenfalls die Python

Setup-Tools [10] installiert sein.

Diese lassen sich ebenfalls über die Paketverwaltung der meisten

Linux-Distributionen nachinstallieren.

Sind diese beiden Voraussetzung erfüllt, so bringt der Befehl

# easy_install trac

die aktuellste stabile Version von Trac auf das System, allerdings ohne

Lokalisierung, d. h. „nur“ in Englisch. Wer das System lokalisieren möchte, der

muss vorher noch Babel

installieren [11].

Danach muss noch eine neues Projekt angelegt werden, im Rahmen von Trac

„Environment“ genannt. Dies geschieht auch über die Kommandozeile:

# trac-admin /var/www/meinprojekt initenv

# chown -R www-data /var/www/meinprojekt

Damit wären die Vorbereitungen abgeschlossen – Trac kann jetzt gestartet

werden. Dazu dient der Befehl:

# su www-data -c "tracd --port 8000 /var/www/meinprojekt"

Noch ein Hinweis: Wer Trac nur in einem geschlossenen Netzwerk testen

möchte, der kann das Environment auch einfach im eigenen Home-Verzeichnis

anlegen und der Trac-Daemon (siehe unten) mit Nutzerrechten starten.

Davon ist aber für den Produktivbetrieb natürlich dringend abzuraten.

Trac läuft jetzt mit den Voreinstellungen, d. h. alle Nutzer können

aktuell nur lesend auf das System zugreifen. Da sich die Konfiguration des

Ticket-Systems aber bequem über die Weboberfläche erledigen lässt, muss noch

ein Benutzer angelegt werden, der Admin-Rechte hat:

# trac-admin /var/www/meinprojekt permission add jochen TRAC_ADMIN

Damit werden dem Benutzer „jochen“ die vollen Rechte eingeräumt. Trac

kennt eine Reihe von verschiedenen Rechten, so dass sich diese recht

detailliert einstellen

lassen [12].

Der letzte Schritt ist, dass alle Nutzer, die mehr als lesenden Zugriff

haben sollen, in einer Passwort-Datei hinterlegt werden, die beim Start der

Trac-Instanz eingelesen wird. Trac benutzt damit „normale“

htpasswd-Dateien, wie sie auch die verschiedenen Webserver einsetzten.

# htdigest -c /var/www/meinprojekt/.htpass projekt jochen

Damit Trac die Datei beim Starten auch einliest, muss folgender Befehl

verwendet werden:

# su www-data "tracd --port 8000 --auth "meinprojekt,/var/www/meinprojekt/.htpass,projekt" /var/www/meinprojekt/"

Nun ist die Weboberfläche unter localhost:8000/meinprojekt erreichbar.

Außer dem angelegtem Benutzer „jochen“, welcher Admin-Rechte hat, sind

keinerlei Anpassungen erfolgt. Wer Trac produktiv betreiben möchte,

sollte einen weiteren Blick in die Dokumentation werfen, in der

viele weitere mögliche

Konfigurationen

und Anpassungen beschrieben sind. Ein

Teil der Einstellungen können auch in der Weboberfläche im Adminstrationsmenü

unter dem Punkt „Permissions“ vorgenommen werden, wenn man sich mit

Admin-Rechten eingeloggt hat.

Ticketsystem konfigurieren

Jeder angelegte Nutzer kann sich nun durch einen Klick auf „Login“ in der

Weboberfläche anmelden. War dies erfolgreich und hat man Admin-Rechte,

erscheint in der Menüleiste ganz rechts eine Schaltfläche mit der Beschriftung

„Admin“. Hierüber gelangt man ins Adminstrationsmenü, in dem auch das

Ticketsystem individuell anpassbar ist.

Im hier beschriebenen Fall wurden die Felder wie folgt belegt:

- „Components“

- Industriezweig, in dem der potentielle Kunde tätig ist

- „Milestones“

- aktueller Status, also z. B. „Angebot gemacht“, „bemustern“,

„erste Bestellung wird erwartet“ usw.

- „Priorities“

- Priorität, die das Ticket hat, also z. B. „niedrig“,

„mittel“, „hoch“

- „Resolutions“

- beschreibt, wie das Ticket geschlossen wurde, also z. B.

„akquiriert“, „kein Interesse“, „braucht das Produkt nicht“ usw.

- „Severities“

- wird im beschriebenen Fall nicht genutzt

- „Tickettypes“

- beschreibt, ob in der Vergangenheit schon einmal Kontakt mit

dem Kunden bestand oder ob es ein Neukontakt ist. Die Werte für dieses Feld

sind also „neuer Kontakt“ oder „erneuter Kontakt“.

Die Änderungen werden sofort wirksam, d. h. es können direkt Tickets angelegt

werden.

Der Software ist es letztendlich egal, wie man welches Feld benennt, da es für

Trac „nur“ Felder in einer Datenbank sind. Es ist beim Anlegen jedoch

ratsam darauf zu achten, dass man in den Standardansichten („Queries“, siehe

folgender Abschnitt) eine brauchbare und übersichtliche Zusammenfassung erhält.

Einige Ticketfelder sind nicht konfigurierbar. Diese sind:

- „Summary“

- Titel des Tickets

- „Reporter“

- wer hat das Ticket erstellt

- „Description“

- ein Textfeld für die ausführliche Beschreibung

- „Owner“

- wem wird/ist das Ticket zugeordnet, also z. B. der Name des

Kundenbetreuers oder Vertreters

- „Keywords“

- Schlüsselworte, können z. B. später zur Suche verwendet werden.

Im vorliegenden Fall wurde vereinbart, dass in das Feld „Summary“ immer der

Kundenname eingetragen wird. Dies hat sich im laufenden Betrieb auch als sehr

zweckmäßig erwiesen, da dieses Feld in allen Reports immer als erstes angezeigt

wird.

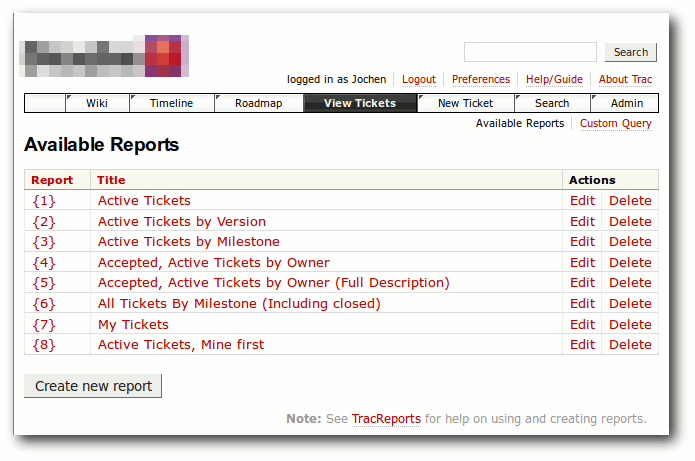

Tickets abfragen

Alle Tickets – egal, ob offen oder abgeschlossen – können nun in der

Weboberfläche unter dem Punkt „View Tickets“ abgefragt werden.

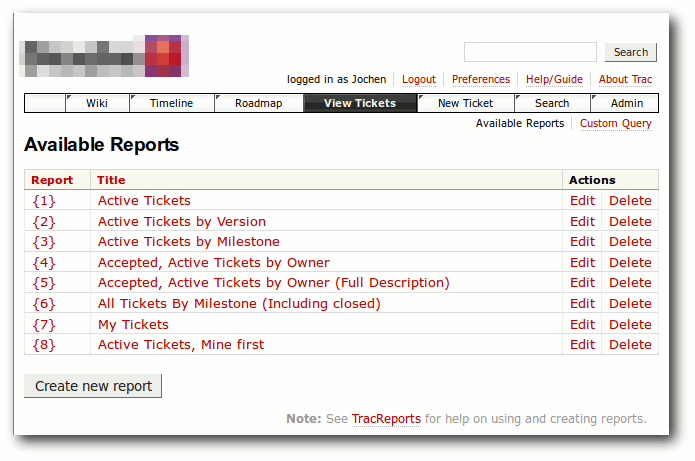

Standardabfrage der Tickets unter Trac.

Es gibt acht fertig vordefinierte Abfragen. Der Unterschied liegt primär in der

Sortierung bzw. welche Tickets (nicht) angezeigt werden. Im vorliegenden Fall

hat sich die Abfrage Nr. 6 „All Tickets By Milestone (Including closed)“ am

praktischsten erwiesen, weil dort alle Tickets – egal, ob offen oder

geschlossen – sortiert nach „Milestone“ angezeigt werden, so dass man sofort

den aktuellen Status pro Ticket sieht.

Wer eine spezifischere Abfrage außerhalb der Reports benötigt, der kann durch

einen Klick rechts oben im Fenster auf „Custom Query“ per Weboberfläche

komfortabel eine eigene Abfrage erstellen. Dies ist z. B. praktisch, wenn man

sich alle Tickets anzeigen lassen will, die einem bestimmten „Owner“ zugeordnet

sind. Das Erstellen einer Custom Query ist dabei ganz einfach, weil sie sich

komfortabel per Weboberfläche „zusammenklicken“ lässt.

Milestones und Roadmap

Die Weboberfläche von Trac zeigt noch zwei weitere Menüpunkte an,

nämlich „Milestones“ und „Roadmap“. Diese werden z. B. in der

Softwareentwicklung genutzt, um schnell aufzuzeigen, welche Tickets noch offen

sind bzw. welche Punkte noch abgearbeitet werden müssen (bevor die nächste

Software-Version veröffentlicht werden kann).

Wer z. B. festlegen möchte, dass jeder Kunde bis zu einem bestimmten Datum ein

Angebot erhalten haben muss, der kann in der Konfiguration des Ticketsystems

für jeden Milestone zusätzlich ein „Due Date“ (= Fälligkeitsdatum)

hinterlegen. Dies wurde im vorliegenden Fall jedoch nicht gemacht, so dass auch

die Milestone- (und Roadmap-) Ansicht nicht genutzt wird.

Informationsfluss

Es ist natürlich etwas umständlich, wenn jeder Nutzer immer wieder die

Weboberfläche aufrufen muss, um zu sehen, ob sich etwas geändert hat oder ein

neues Ticket erstellt wurde. Dafür bietet Trac zwei

Benachrichtigungsmöglichkeiten. Zum einem gibt es ein konfigurierbares

E-Mail-System, welches Informationen über Änderungen per Mail versendet. Zum

anderen gibt es die Möglichkeit, diverse Seiten als RSS-Feeds zu abonnieren, so

auch die Report-Seiten. Im vorliegenden Anwendungsfall wurde letzterer Weg

gewählt. Zum einem, weil es im System keine verfügbaren E-Mail-Server gibt,

über den Trac Mails verschicken könnte. Zum anderen, weil das auf allen

Rechnern installierte Outlook (Version 2003 oder neuer) RSS-Feeds direkt

einbinden kann, so dass Nachrichten von Trac „E-Mail-ähnlich“

erscheinen.

Nutzung und Benutzererfahrung

Nun nutzt aber bekanntlich das beste System nichts, wenn es von den Nutzern

nicht akzeptiert wird, weil z. B. die Benutzbarkeit zu schlecht ist, die

Eingabe und Abfrage von Daten zu lange dauert etc.

Erfreulicherweise war dies bei der hier beschriebenen Anwendung überhaupt nicht

der Fall. Das optische Erscheinungsbild von Trac bzw. dessen

Weboberfläche kann zwar durchaus als „minimalistisch” bezeichnet werden,

dadurch ist es aber auch sehr übersichtlich, alle Informationen sind sofort

auffindbar. Gleiches gilt für die Eingabe von Daten bzw. das Anlegen von

Tickets. Auch das Abonnieren des RSS-Feeds des Reports via Outlook und die

damit verbundenen Benachrichtigungen wurden von den Benutzern als komfortabel empfunden.

Der Schulungsbedarf bei der Einführung von Trac war auch durchaus

überschaubar. Nutzer, welche nur lesend auf das System zugreifen sollten,

konnten nach einer ca. zehnminütigen Schulung ohne Probleme mit dem System

umgehen. Die Nutzer, die zusätzliche Schreibrechte besitzen, erhielten noch eine

ca. 15-minütige Schulung zum Anlegen und Editieren von Tickets.

Dadurch bedingt wurde das System sehr schnell akzeptiert und aktiv genutzt.

Probleme, weder beim Betrieb von Trac auf dem Server als auch seitens

der Nutzer, sind nicht bekannt.

Links

[1] https://de.wikipedia.org/wiki/Customer-Relationship-Management

[2] http://trac.edgewall.org/

[3] http://sharepoint.microsoft.com/de-de/Seiten/default.aspx

[4] http://www.microsoft.com/de-de/dynamics/erp-nav-ubersicht.aspx

[5] https://de.wikipedia.org/wiki/Issue-Tracking-System

[6] http://roundup.sourceforge.net/

[7] http://trac.edgewall.org/wiki/TracGuide

[8] http://www.python.org

[9] http://www.sqlite.org/

[10] http://pypi.python.org/pypi/setuptools

[11] http://trac.edgewall.org/wiki/TracPermissions

| Autoreninformation |

| Jochen Schnelle (Webseite)

arbeitet im technischen Vertrieb eines KMU. Im hier beschriebenen

Anwendungsfall konnte er Beruf und Hobby (Python und Open-Source-Software)

erfolgreich vereinigen.

|

Diesen Artikel kommentieren

Zum Index

von Daniel Nögel

Das Humble Bundle [1] erfreut sich

mittlerweile durchaus einiger Beliebtheit: Zu einem frei wählbaren Preis kann

jeder ein Spiele-Paket erstehen und den Erlös auf die Entwickler und/oder

verschiedene Wohltätigkeitsorganisationen verteilen. Mittlerweile gab es neben

dem „Humble Indie Bundle“ verschiedene weitere Aktionen, wie etwa das „Humble

Bundle for Android“ oder das „Humble Bundle Mojam“. Um letzteres soll es in dem

Artikel gehen – dabei besonders um das daraus hervorgegangene Spiel

Catacomb Snatch.

Humble Bundle Mojam

Das Humble Bundle Mojam war eine besondere Aktion des Humble Bundles. In

Zusammenarbeit mit den Minecraft-Machern von

Mojang [2] sollte an einem

Februar-Wochenende innerhalb von 60 Stunden ein neues Spiel

entstehen [3].

Die Entwicklung wurde dabei von Kameras begleitet und war im Internet als

Livestream zu sehen.

Wer das Humble Bundle Mojam erstand, sollte am Ende nicht nur das fertige Spiel

erhalten, sondern hatte während der Aktion auch Zugriff auf Vorabversionen des

Spiels. Recht kurzfristig schlossen sich auch das Oxeye Game Studio

und Wolfire

Games der Aktion an, so dass während des Humble Bundle Mojam insgesamt drei

Spiele live entwickelt wurden.

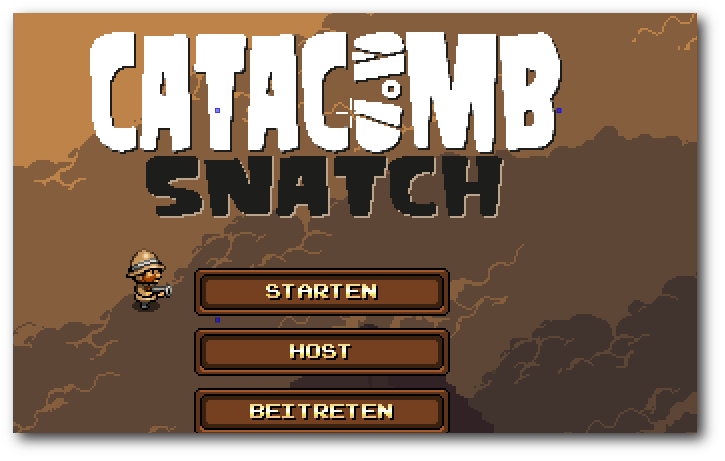

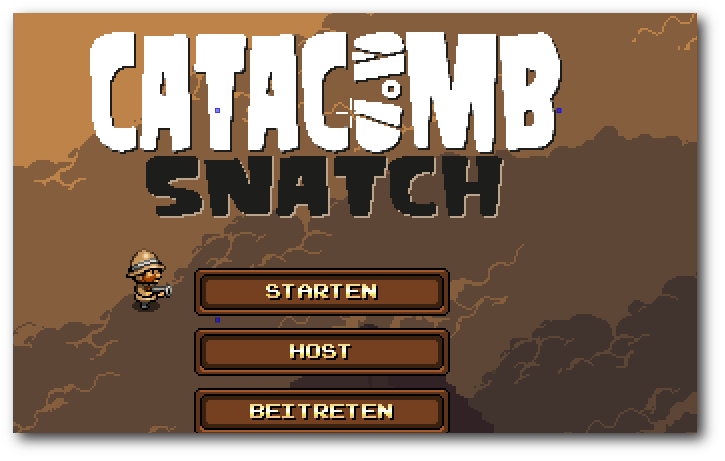

Catacomb Snatch

Erwartungsgemäß erhielt das Team von Mojang besonders viel Aufmerksamkeit. Dies

ist sicher damit zu erklären, dass sich durch das Spiel Minecraft ein

regelrechter Personenkult um den Entwickler Markus „Notch“ Persson und sein

Team gebildet hat.

Nach einer Umfrage bezüglich Genre und Ausrichtung des Spiels hatte sich das

Team auf ein Echtzeitstrategie-„Shoot 'em up“ mit Steampunk-Elementen und

Einflüssen des alten Ägyptens festgelegt. Während der sechzigstündigen

Liveübertragung nahm diese etwas diffuse Beschreibung zunehmend Form an:

Zuschauer konnten beobachten, wie das Spiel in Java umgesetzt wurde und auch

dem Grafikdesigner bei der Arbeit zuschauen. Die erste Vorabversion des Spieles

ließ allerdings noch wenig von dem späteren Spiel

erahnen [4].

Zwar tat sich bis zum Ende der Aktion noch Einiges an dem Spiel – allerdings

waren noch immer Platzhaltergrafiken zu sehen – etwa in den

Menüs [5]. Auch

Spieleabstürze, Probleme im Multiplayer-Modus und eine nicht sonderlich

benutzerfreundliche Steuerung ließen keinen Zweifel daran, dass das Spiel noch

nicht fertig gestellt war.

Der Startbildschirm von Catacomb Snatch.

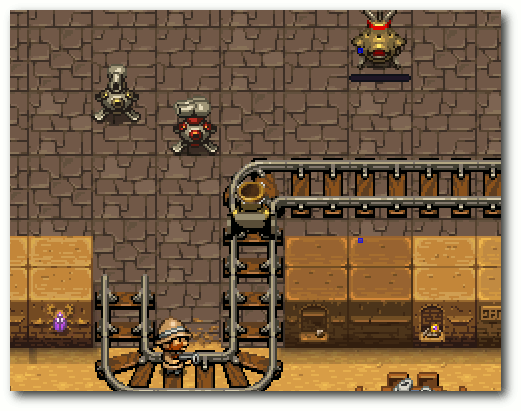

Was ist das Ziel?

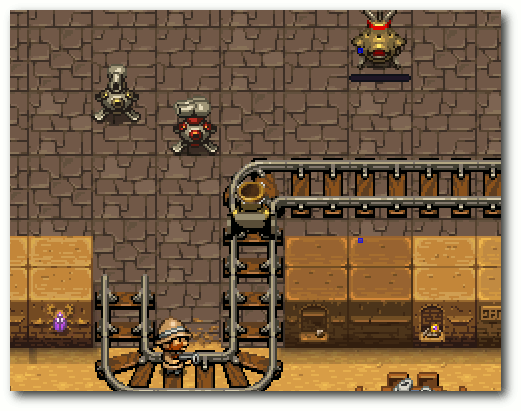

Das (un)fertige Spiel hat auch deshalb für Irritationen gesorgt, weil das

Spielziel für einige Spieler nicht ersichtlich war: Der Spieler erkundet eine

alte ägyptische Pyramide und trifft dabei auf feindlich gesinnte Mumien,

Fledermäuse und Schlangen. Mit seiner Waffe setzt er sich gegen diese zur Wehr,

sammelt dabei Münzen und kauft sich von diesen Geschütztürme, Münzsammler und

Bomben. Mit den Bomben sprengt er sich den Weg zu einem Schatz frei, den es

fortzuschaffen gilt. Dazu werden Gleise verlegt, über die kleine Roboter zu dem

Schatz fahren und diesen in die heimische Zeltstadt transportieren. Um zu

verhindern, dass die Roboter von feindlichem Getier angegriffen werden, muss

die Route mit den Geschütztürmen abgesichert werden. Münzsammler ziehen von

Gegnern fallen gelassene Münzen an, so dass der Spieler kleine

Geld-Sammel-Anlagen errichten kann.

Haben die Roboter ausreichend viel von dem Schatz gesammelt, gewinnt der

Spieler das Spiel. In der Mehrspieler-Variante kämpfen zwei Menschen um den

Schatz und versuchen sich mit den Geschütztürmen in Schach zu

halten.

Damit hat Mojang nicht nur alle vorher festgelegten Elemente in dem Spiel

berücksichtigt, sondern gleichzeitig die Basis für die Weiterentwicklung

gelegt: Nach Meinung der Entwickler sollten bei der zukünftigen Entwicklung

besonders die Tower-Defense-Elemente ausgebaut werden.

Droiden auf Gleisen transportieren den Schatz ins Lager.

Die Weiterentwicklung

Da Mojang nicht nur das Spiel, sondern auch den dazugehörigen Quelltext

zugänglich gemacht hat, bildeten sich bald verschiedene Abspaltungen des Spiels

– sogenannte

„Forks“ [6].

Diese behoben nicht nur die bekannten Fehler, sondern ersetzten die hässlichen

Platzhalter-Grafiken und versuchten das Spiel nach eigenem Gutdünken weiter zu

entwickeln.

Zu den prominenteren Weiterentwicklungen gehören die Forks von einigen

Reddit-Nutzern [7],

dem belgischen Entwickler

Maescool [8] sowie der

Spieleschmiede UberSoft

Technologies [9]. Die

Reddit-Variante scheint mittlerweile aber eingestellt worden zu sein – das

Github-Projekt existiert nicht mehr. Die Abspaltung von UberSoft wird zwar sehr

häufig im Zusammenhang mit Catacomb Snatch erwähnt – die Entwickler

stellen allerdings nur die Binärversion des Spieles bereit. Nur um die

Abspaltung von Maescool scheint sich derzeit eine größere

OpenSource-Gemeinschaft zu formieren. Derzeit existieren auf GitHub etwa 140

Abspaltungen von Maescools

Code [10], auch eine

Internetseite [11] und ein

Forum [12] haben sich um das Projekt

gebildet. Dort steht unter anderem die jeweils letzte Entwicklungsversion zum

Herunterladen bereit, sodass interessierte Nutzer das Programm nicht selbst

kompilieren müssen [13].

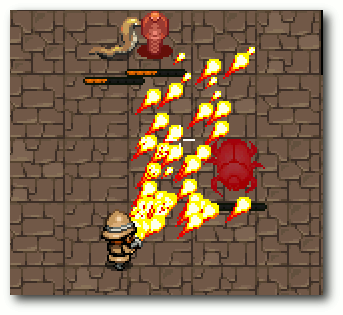

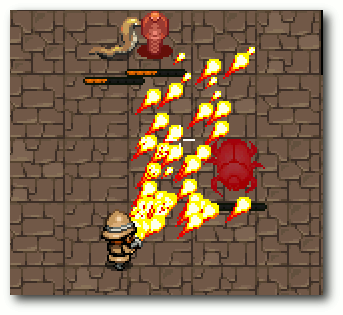

Neue Funktionen

Durch die Weiterentwicklung der Gemeinschaft um Maescool wurden verschiedene

neue Funktionen in das Spiel integriert. Neben mehrsprachigen Menüs und einigen

neuen Optionen hat

das Spiel mittlerweile einen integrierten Leveleditor, lässt

sich mit der Maus steuern und unterstützt Upgrades für Türme und Münzsammler.

Auch neue Monster und Waffen, ein Levelsystem und verschiedene optische

Verbesserungen wurden verwirklicht. Außerdem wurden neue Levelbausteine

(sogenannte Tiles) eingefügt, so dass es mittlerweile Schatztruhen, Fallen und

einstürzende Bodenplatten gibt.

Den Flammenwerfer gab es im Original noch nicht.

Mitmachen

Da zur Zeit die Catacomb Snatch-Abspaltung um Maescool das einzig

größere, aktive Gemeinschaftsprojekt zu sein scheint, können sich

interessierte

Entwickler und Grafiker hier vermutlich am besten einbringen. Über Git kann

schnell eine Kopie der aktuellen Entwicklungsversion bezogen werden. Bei Mojang

findet sich darüber hinaus eine Anleitung, in der erklärt wird, wie der

Quelltext in Eclipse importiert

wird [14].

Auch unerfahrene Java-Entwickler können sich in das Projekt durchaus

einbringen, kleine Verbesserungen wie etwa neue Levelbausteine lassen sich ohne

große Programmiersprachenkenntnisse umsetzen und führen zu schnellen

Erfolgserlebnissen.

Lizenzprobleme

Auch wenn der Quelltext vom Mojang verfügbar gemacht und bereits von hunderten

Entwicklern bearbeitet und modifiziert wurde: Nominell gibt es noch keine

Freigabe des Programmcodes unter einer freien Lizenz. Auch auf mehrere

Nachfragen gab es von Mojang keine Freigabe, sodass weiterhin alle Rechte bei

dem schwedischen Spieleentwickler liegen. Einzig ein Tweet von dem

Mitentwickler Jens Bergensten geht auf diese Problematik genauer ein: Dort

heißt es, dass Spiel sei zu Wohltätigkeitszwecken entwickelt worden und der

Code für die Bildung

bestimmt [15].

Auch wenn auf Grund dieser Äußerungen davon ausgegangen werden kann, dass

Mojang nicht gegen die Weiterentwicklung und Redistribution ihres Spiels

vorgehen wird, muss Catacomb Snatch damit als proprietär bezeichnet

werden. In Linux-Distributionen wie Debian wird es damit auf absehbare Zeit

keinen Einzug erhalten.

Links

[1] http://www.humblebundle.com/

[2] https://de.wikipedia.org/wiki/Minecraft

[3] https://de.wikipedia.org/wiki/Humble_Bundle#The_Humble_Bundle_Mojam

[4] http://www.youtube.com/v/FWQamrtEcCs

[5] http://www.youtube.com/v/naHw4YEPJVk

[6] https://de.wikipedia.org/wiki/Abspaltung_(Softwareentwicklung)

[7] https://github.com/rCatacombSnatch/Catacomb-Snatch--Reddit-Edition

[8] https://github.com/Maescool/Catacomb-Snatch

[9] http://main.ubersoftech.com/project/ucs/

[10] https://github.com/Maescool/Catacomb-Snatch/network

[11] http://www.catacombsnatch.net/

[12] http://forum.catacombsnatch.net/

[13] http://www.catacombsnatch.net/download.html

[14] http://www.mojang.com/2012/02/how-to-use-the-catacomb-snatch-source-code

[15] https://twitter.com/#!/jeb_/status/171547946821750785

| Autoreninformation |

| Daniel Nögel (Webseite)

hat die Entwicklung von Catacomb Snatch vom Livestream bis

zu den verschiedenen heutigen Ablegern verfolgt und findet neben der

Spielidee besonders die Beobachtung der Weiterentwicklung des Spiels

interessant.

|

Diesen Artikel kommentieren

Zum Index

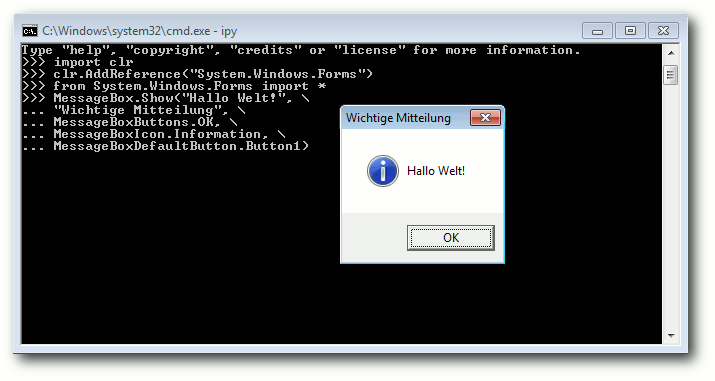

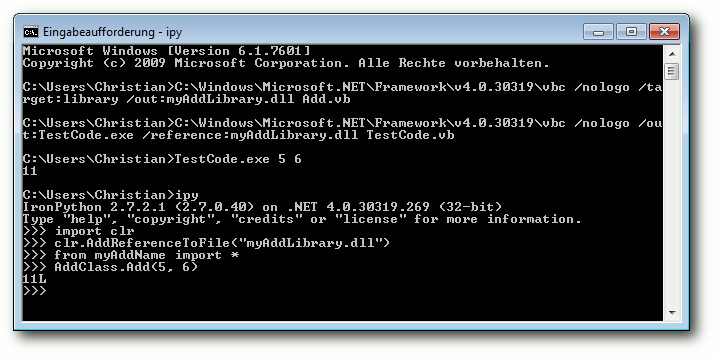

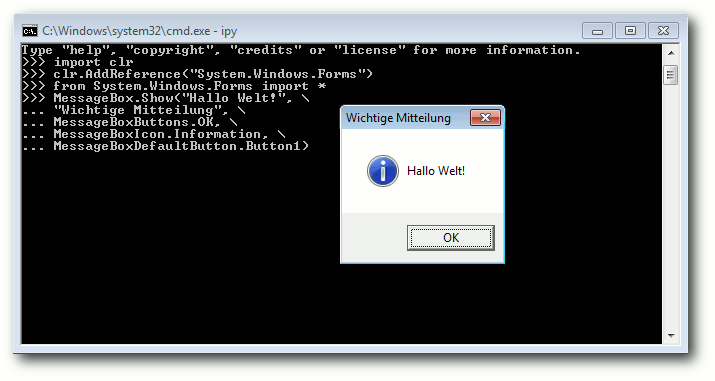

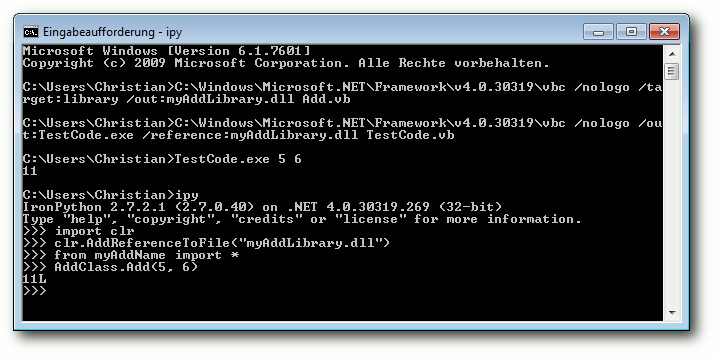

von Christian Imhorst

Wenn einem IronPython wie ein semi-toter Zombie [1]

erscheint, der kaum Nutzer hat, liegt das zum großen Teil an

IronPython selbst: Es ist ein Nischenprodukt und wird das vermutlich

auch bleiben, was schade ist, da IronPython wunderbare Einblicke in das

.NET-Framework gewährt.

Im Jahr 2000 wurde .NET von Microsoft ins Leben gerufen und ist heute

eine populäre Plattform für objektorientierte Programmierung unter

Windows. Beschäftigt man sich mit IronPython, muss man Python kennen

und mögen, was Gerüchten zufolge nicht jedermanns Sache ist.

IronPython eignet sich auch nur schlecht dazu, die

Programmiersprache selbst zu lernen.

Als Anfänger startet man am

besten mit der offiziellen Python-Referenz CPython, um sich die

Konzepte der Sprache anzueignen. Dann muss man sich noch im

.NET-Framework von Microsoft auskennen und sich damit auch

beschäftigen wollen. Außerdem ist IronPython für Anwendungen im

Geschäftsumfeld so gut wie irrelevant, da Microsoft mit C#, VB.NET

und der PowerShell selbst Programmier- und Skriptsprachen für die

.NET-Plattform anbietet. Nachdem IronRuby und IronPython im Oktober

2010 an die Open-Source-Community übergeben

wurden [2],

ging darüber hinaus auch noch die aktive Unterstützung durch

Microsoft verloren, was zur Folge hatte, dass IronPython seitdem nicht

mehr so schnell weiterentwickelt wird.

Dabei hat IronPython einige spannende Sachen zu bieten, wie zum

Beispiel seine Geschichte, warum es überhaupt existiert. Um 2003

herum gab es einige Berichte im Internet, in denen behauptet wurde,

dass die Common Language Runtime (CLR), das Herz und die Seele des

.NET-Frameworks, für dynamische Sprachen wie Python einfach

ungeeignet sei. Jim Hugunin, der zuvor JPython, das heute Jython

heißt, für die Java Virtual Machine (JVM) entwickelt

hatte [3], fragte sich deshalb:

Was hat Microsoft mit der CLR unter .NET bloß so falsch gemacht,

dass sie mit Python nicht funktionieren soll?

Er wollte dieser Frage

ein paar Wochen lang auf den Grund gehen und am Ende das Ergebnis im

Artikel “Why the CLR is a terrible platform for dynamic

languages” [4]

zeigen. Zu seiner Überraschung stellte Hugunin aber fest, dass sich

Python sehr gut für die CLR eignet. Also erschien 2006 die Version

1.0 von IronPython als vollständig in C# geschriebene

Implementierung der Programmiersprache Python. Dabei hält sich

IronPython an die in der Programmiersprache C geschriebene

Referenz-Implementierung und ist vollständig kompatibel zu CPython.

Anfangs stand IronPython noch unter Microsofts eigener Open

Source-Lizenz Micosoft Public License, ist mittlerweile aber zur

Apache-Lizenz 2.0 gewechselt.

Da .NET von Anfang an als ein sprachunabhängiges Framework

konzipiert worden war, können Programmierer in unterschiedlichen

Programmiersprachen wie C#, VB.NET oder Visual C++ arbeiten.

Software, die in diesen .NET-Sprachen geschrieben wurde, wird

mithilfe eines Just-In-Time-Compilers in eine Zwischensprache

übersetzt, der Common Intermediate Language (CIL), bevor sie von der

Laufzeitumgebung CLR ausgeführt wird. IronPython ist in diesem Sinne

der .NET-Compiler für eine Programmiersprache namens Python. Wie in

.NET üblich, kann man auf Bibliotheken zugreifen, die in anderen

.NET-Sprachen geschrieben wurden, und mit Einschränkungen auch