Zur Version ohne Bilder

freiesMagazin März 2010 (ISSN 1867-7991)

Topthemen dieser Ausgabe

Mandriva Linux 2010

Am 3. November 2009 hat Mandriva S. A. wie angekündigt die neue Version der gleichnamigen Linux-Distribution Mandriva Linux 2010 veröffentlicht. Glaubt man den Release Notes, so wird die neue Version alle anderen Distributionen in den Schatten stellen, und in der Tat sind neben den üblichen Aktualisierungen einige interessante Neuerungen dabei - allen voran der smarte Desktop. (weiterlesen)

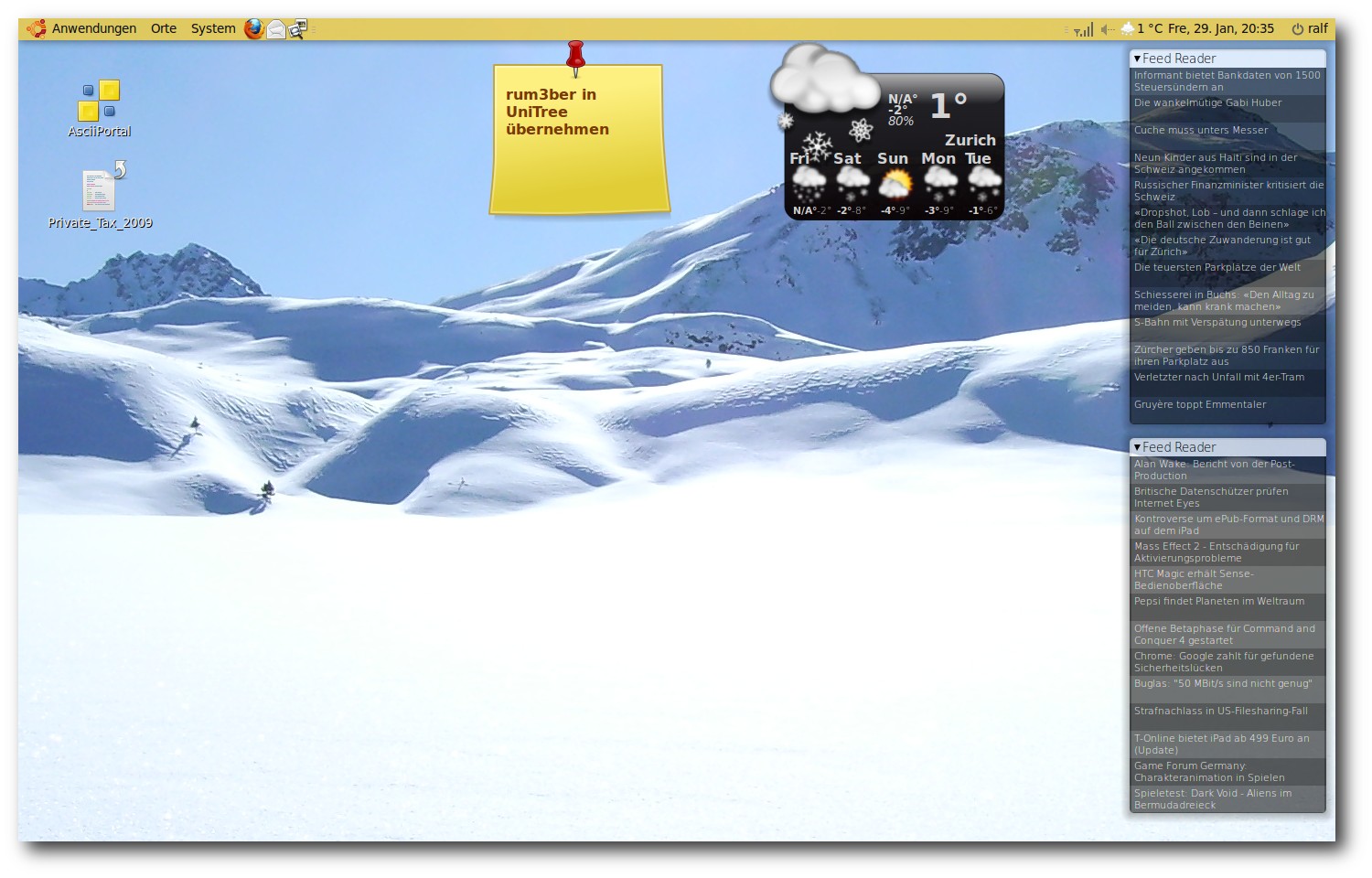

Pimp my Desktop

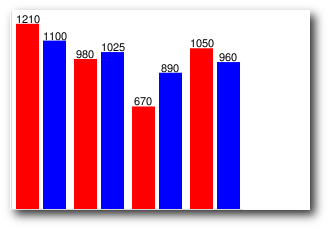

Die Arbeitsoberfläche der Linux Desktops ist von Haus aus eine Wüste, die zu 5 % aus Panels, Menüs und Startern besteht und zu 95 % ein Hintergrundbild ohne weitere Information oder Funktion zeigt. Viele Anwender sind mit diesem Zustand zufrieden, andere wünschen sich mehr Inhalt auf der Oberfläche. In dem Artikel werden Maßnahmen beschrieben, um den Informationsgehalt des Desktops zu erhöhen und ihn optisch ansprechender zu gestalten. (weiterlesen)

Die Z-Shell (zsh) - Eine mächtige Alternative zur Bash

Die Standardshell auf den meisten Linux-Systemen ist die Bash. Sie ist sehr mächtig und erlaubt es, viele Aufgaben zu automatisieren. Dieser Artikel soll sich einer sehr interessanten, noch mächtigeren Shell widmen, der Z-Shell - kurz zsh. (weiterlesen)

Zum Index

Linux allgemein

Mandriva Linux 2010

Der Februar im Kernelrückblick

Anleitungen

Pimp my Desktop

Eigene Paketquellen zusammenstellen

mit local-apt

Software

Die Z-Shell (zsh) - Eine mächtige

Alternative zur Bash

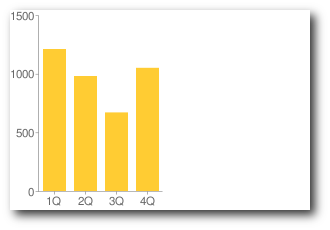

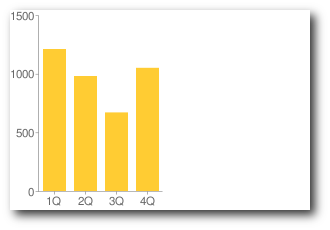

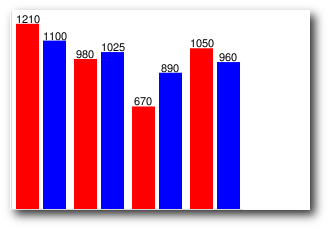

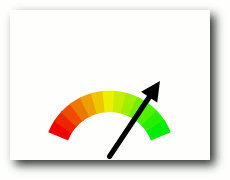

Google Charts - Diagramme über das

Internet erstellen

Vim und das Surround-Plug-in

Effektives automatisiertes Bearbeiten

von Daten mit sed

Community

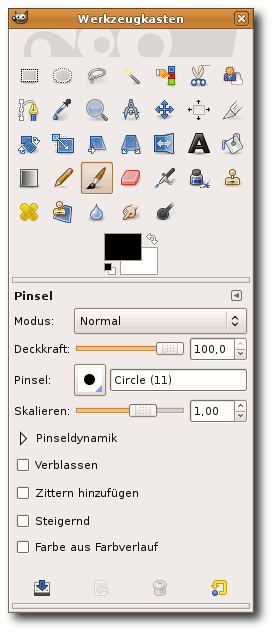

Rezension: GIMP - kurz & gut

Rezension: Python - kurz & gut

Magazin

Editorial

Leserbriefe

Veranstaltungen

Vorschau

Impressum

Zum Index

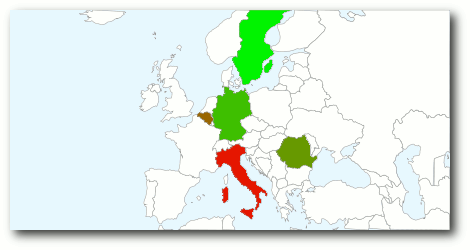

Open Source in verschiedenen Variationen

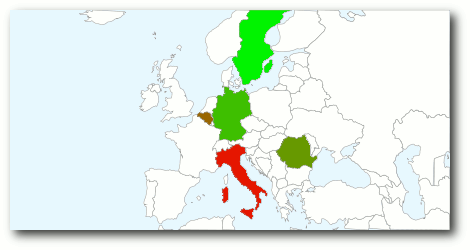

Open Source ist böse

Bewegte letzten Monat noch die Zugriffssperrung gewisser Staaten auf den

Quellcode, der bei SourceForge [1] lagert,

die Gemüter (siehe „Editorial“, freiesMagazin 02/2010 [2]),

sorgt diesen Monat ein Antrag der International Intellectual Property

Alliance (IIPA) - die entgegen des Namens nicht international arbeitet,

sondern eine rein US-amerikanische Instituition ist - für Aufregung.

Diese hat sich an das US-Handelsministerium gewandt, um alle Länder,

die Open-Source-Software empfehlen und einsetzen, auf eine gesonderte

Beobachtungsliste zu setzen, denn Open Source sei eine Gefährdung

geistigen Eigentums („Intellectual Property“) [3].

Hinter diesem Antrag steht natürlich die Angst der IIPA, dass Länder

verstärkt die eingesetzte Software selbst anpassen und sich nicht mehr

in die Abhängigkeit eines proprietären Software-Herstellers begeben,

bei dem man bei Fehlern und neuen Funktionen nur hoffen kann, dass

dieser sie irgendwann einmal ausbessert bzw. umsetzt - dann natürlich

nur gegen bare Münze.

Dass Closed-Source-Software-Hersteller natürlich dank Open Source

an Marktmacht verlieren werden, ist logisch und man kann es der IIPA

nicht einmal wirklich vorwerfen, dass sie sich an dem hohen Ast

festklammern, auf dem sie sitzen - der Fall zurück auf den Boden

(der Tatsachen) würde sehr weh tun. Was aber Open-Source-Software mit

Piraterie zu tun haben soll, ist unklar. Und auch das Copyright wird

- neben den verschiedenen Lizenzen - in der Open-Source-Szene extrem

geachtet. Man darf nicht vergessen: Die meisten Open-Source-Lizenzen,

wie die bekannte GNU General Public License [4],

sind eine Erweiterung des Copyrights, kein Ersatz. Sie stellen sicher, dass der Urheber („Copyright-Holder“) der Software immer genannt wird und auch nicht

das Recht an seinem Code verliert. Daneben gestatten solche Lizenzen

aber trotz dieser „Einschränkung“ des Copyrights die weitere Nutzung

und Veränderung von Quellcode, was eben den Kern der

Open-Source-Software-Entwicklung ausmacht. Aus diesem Grund spricht man

auch von einem Copyleft.

Ernst nehmen kann man den Antrag der IIPA daher nicht, selbst wenn

er von der US-Regierung akzeptiert werden sollte.

Open Source ist (wieder) gut

Und noch einmal zurück zu SourceForge: Kurz nach unserem Editorial

letzten Monat kam am Montag darauf die freudige Nachricht, dass

SourceForge die Sperre in die Hände seiner Nutzer

legt [5].

Jedes Projekt kann in den Einstellungen wählen, dass jeder Zugriff haben darf.

Der Text laut SourceForge ist:

„This project DOES incorporate, access, call upon or otherwise use

encryption. Posting of open source encryption is controlled under

U.S. Export Control Classification Number „ECCN“ 5D002 and must be

simultaneously reported by email to the U.S. government. You are

responsible for submitting this email report to the U.S. government

in accordance with procedures described in:

http://www.bis.doc.gov/encryption/PubAvailEncSourceCodeNotify.html

and Section 740.13(e) of the Export Administration Regulations

(„EAR“) 15 C.F.R. Parts 730-772“

Die Sperre betrifft also vor allem Projekte, die mit Verschlüsselung

arbeiten, was sicherlich nur ein kleiner Bruchteil der SourceForge-Projekte

betrifft. Im Nachhinein zeigt dies aber auch, dass die erste globale

Sperre seitens SourceForge absolut unverhältnismäßig war.

Open Source ist verwirrend

Auch freiesMagazin muss sich mit Lizenzproblemen herumschlagen.

Es sind keine Probleme im engeren Sinne, nur werden wir ab und an gefragt,

wieso wir für die Artikel eine so „freizügige“ Lizenz wie die GNU Free

Documentation License [6] einsetzen.

Die Lizenz erlaubt (in knappen Stichpunkten) einen Artikel ...

- ... anderswo unter Berücksichtigung der GFDL zu verwenden,

ohne die Zustimmung des jeweiligen Autors einholen zu müssen.

- ... unverändert für Print- und Onlinepublikationen zu

übernehmen. Die Kopie muss dabei vollständig erfolgen, insbesondere ist

der jeweilige Urheber und die Lizenz mit anzugeben.

- ... auch kommerziell zu nutzen, also beispielsweise eine

gedruckte Version zu verkaufen.

- ... zu verändern. Insbesondere muss dabei Folgendes gegeben

sein:

- Die veränderte Version oder das neue Werk muss wieder unter der

GFDL lizenziert sein.

- Der Autor/die Autoren des Originalwerkes müssen genannt werden.

Einige Autoren sehen vor allem in Punkt 3 eine Aushöhlung ihrer

Rechte bzw. eine Nichtwürdigung ihrer kreativen Arbeit - man könnte

auch „Intellectual Property“ sagen (siehe oben). Es gibt bei

solchen Einschätzungen aber immer zwei Standpunkte. Das „Free“ in

GFDL gibt einem Lizenznehmer eben sehr viele Freiheiten - und das ist

etwas, was wir bei freiesMagazin explizit wünschen und fördern wollen.

Natürlich kann man immer noch darüber streiten, ob ein gemeinfreies

Lizenzmodell („Public Domain“ genannt, was es im deutschen Recht aber

nicht wirklich gibt) nicht noch viel freier wäre, schließlich wäre die

Wiederverwertung eines Artikels dann an gar keine Beschränkungen mehr

gebunden. Hierin sehen wir aber wirklich eine Nichtwürdigung der

kreativen Leistung eines Autors. Der Urheber eines Werkes muss immer

erhalten bleiben.

Ob die virale Verbreitung unter der GFDL notwendig ist, darüber lässt sich

diskutieren. Gegebenfalls wäre eine Lizenz wie die

Creative-Commons-Attribution-Lizenz [7]

die bessere Wahl. Bislang haben wir aber mit der GFDL nur gute

Erfahrungen gemacht.

Und ja, auch eine kommerzielle Verwertung ist erlaubt. Nicht zwingend

durch freiesMagazin, das Projekt wird (hoffentlich) immer

nichtkommerziell bleiben, aber eben durch Dritte wie z. B. gedruckte

Linux-Zeitschriften, die sich in der Vergangenheit des Öfteren bei

freien Linux-Magazinen (wie zum Beispiel bei dem ehemaligen

Yalm [8]) bedient haben. Wir denken,

solange der Autor (und die Lizenz) gewahrt werden, ist dies okay.

Die Autoren in solchen freien Magazin schreiben in der Regel, um sich

selbst zu verwirklichen, anderen zu helfen, Ruhm und Ehre einzuheimsen,

aber in den seltensten Fällen, um einen finanziellen Gewinn

herauszuschlagen.

Daneben ist es immer noch problematisch zu entscheiden, was genau

kommerziell bedeutet. Klar ist, dass der Abdruck in einer Zeitschrift,

die dann für 10 Euro über den Ladentisch geht, als kommerziell eingestuft

werden kann. Aber was ist mit der Veröffentlichung in einem Blog,

auf dem Werbung geschaltet ist? Ab welchem Ertrag ist so ein Blog

als kommerziell zu sehen? Sobald 1 Cent Gewinn gemacht wird? Oder

erst wenn der Gewinn die Kosten der Webseite überschreitet?

Diesem Thema hat sich auch Creative Commons letztes Jahr angenommen

und dazu einen 255-seitigen Bericht veröffentlicht [9]. Die Essenz:

Die Ansichten sind sehr unterschiedlich, was genau unter „kommerziell“

verstanden wird, auch wenn sich eine Mehrheit für den Punkt

Gewinnerzielung ausspricht (S. 167 ff im Bericht). Es reicht also,

wenn der Urheber eines NC-Werkes andere Ansichten als der

Nutzer und Wiederverwerter des NC-Werkes hat, damit es zu einem rechtlichen Konflikt

kommt.

Wer also Angst hat, dass seine Artikel kommerziell ausgebeutet werden

könnten, kann diese immer noch unter eine NonCommercial-Lizenz

stellen. Nur ist dann leider kein Platz mehr in freiesMagazin dafür.

(Anmerkung: Bei den Comics machen wir generelle Ausnahmen und bei

den Bildern gelegentlich, weil diese nur schmückendes Beiwerk sind und

leicht entfernt werden können, um den Artikel dann „korrekt“

weiterverarbeiten zu können.)

Wie sehen Sie dieses Thema denn? Hält Sie die GFDL vor der

Veröffentlichung eines Artikels in freiesMagazin ab? Oder nutzen Sie

selbst keine NC-Lizenzen für Ihre verbreiteten Inhalte (z. B. in Blogs),

weil es eine zu große Einschränkung ist oder weil nicht klar definiert

ist, was „kommerziell“ bedeutet? Wir freuen uns über Ihre Meinung,

die Sie über den Kommentarlink unten oder direkt per E-Mail an

senden können.

senden können.

Aprilausgabe erscheint früher

Die meisten werden es sicher wissen: Am 4. April 2010 ist Ostersonntag.

Da ein Großteil des freiesMagazin-Teams zu der Zeit mit Ostereier suchen

beschäftigt sein wird und kein Magazin korrigieren will, haben wir uns

entschieden, die Aprilausgabe etwas vorzuziehen und diese einen Tag vor

Karfreitag zu veröffentlichen. Und wer nun nachrechnet, wird feststellen,

dass dies der 1. April ist. Hoffentlich hält dann niemand die

freiesMagazin-Aprilausgabe für einen Scherz ...

Wir wünschen Ihnen nun viel Spaß mit der neuen Ausgabe

Ihre freiesMagazin-Redaktion

Links

- http://www.sourceforge.net/

- http://www.freiesmagazin.de/freiesMagazin-2010-02

- http://www.gulli.com/news/lobbyorganisation-open-source-software-gleich-raubkopie-2010-02-25

- http://www.gnu.org/licenses/gpl.html

- http://sourceforge.net/blog/some-good-news-SourceForge-removes-blanket-blocking/

- http://www.gnu.org/licenses/fdl.html

- http://creativecommons.org/licenses/by/3.0/deed.de

- http://www.freiesmagazin.de/yalm

- http://wiki.creativecommons.org/Defining_Noncommercial

Das Editorial kommentieren

Zum Index

von Thorsten van Lil

Am 3. November 2009 hat Mandriva S. A. wie angekündigt die neue

Version der gleichnamigen Linux-Distribution Mandriva Linux 2010

veröffentlicht. Glaubt man den Release Notes [1],

so wird die neue Version alle anderen Distributionen in den Schatten

stellen, und in der Tat sind neben den üblichen Aktualisierungen

einige interessante Neuerungen dabei - allen voran der smarte Desktop.

Redaktioneller Hinweis: Der Artikel „Mandriva Linux 2010“ erschien erstmals bei

Pro-Linux [2]

und wird unter der GNU Free Documentation License [3]

veröffentlicht.

Mandriva und die Editionen

Mandriva Linux gibt es prinzipiell in vier Editionen: die Live-CD

„One“, die Installer-DVD „Free“, die kommerzielle Version

„Powerpack“ und Mandriva „Flash“ als USB-Stick.

Die Live-CD „One“ eignet sich für all jene, die sich noch unsicher

sind. In der Live-CD sind proprietäre Treiber und einige Codecs

enthalten. So lässt sich bereits im Live-Modus testen, ob die

verbaute Hardware erkannt wird und ob Mandriva den eigenen

Anforderungen genügt. Mandriva One gibt es dabei als KDE4-

und als GNOME-Version.

Mandriva „Free“ bietet als Installations-DVD die Flexibilität einer

Paketauswahl, beinhaltet dagegen aber keine proprietären Treiber

und Codecs, da hier nur quelloffene Software verwendet wird. Nach

oder während der Installation lassen sich jedoch mit wenigen Klicks

die Software-Quellen einbinden, in denen dann auch proprietäre

Software enthalten ist.

Das „Powerpack“ als kommerzielle Edition ist ebenfalls eine

Installations-DVD, enthält jedoch bereits die proprietären Treiber

und Codecs, die selbst in den Non-Free-Quellen nicht enthalten

sind. Zudem ist der Fluendo-DVD-Player enthalten.

Mandriva „Flash“ ist ein USB-Stick mit persistentem Speicher und

einigen Codecs.

Einen guten ersten Überblick über die Versionen erhält man auf der

Vergleichsseite von Mandriva [4].

Für komplette Mandriva-Neulinge scheint Mandriva „One“ als Live-CD

besonders interessant zu sein. Hier im Test werden

Mandriva Linux „Free“ und „One“ verwendet.

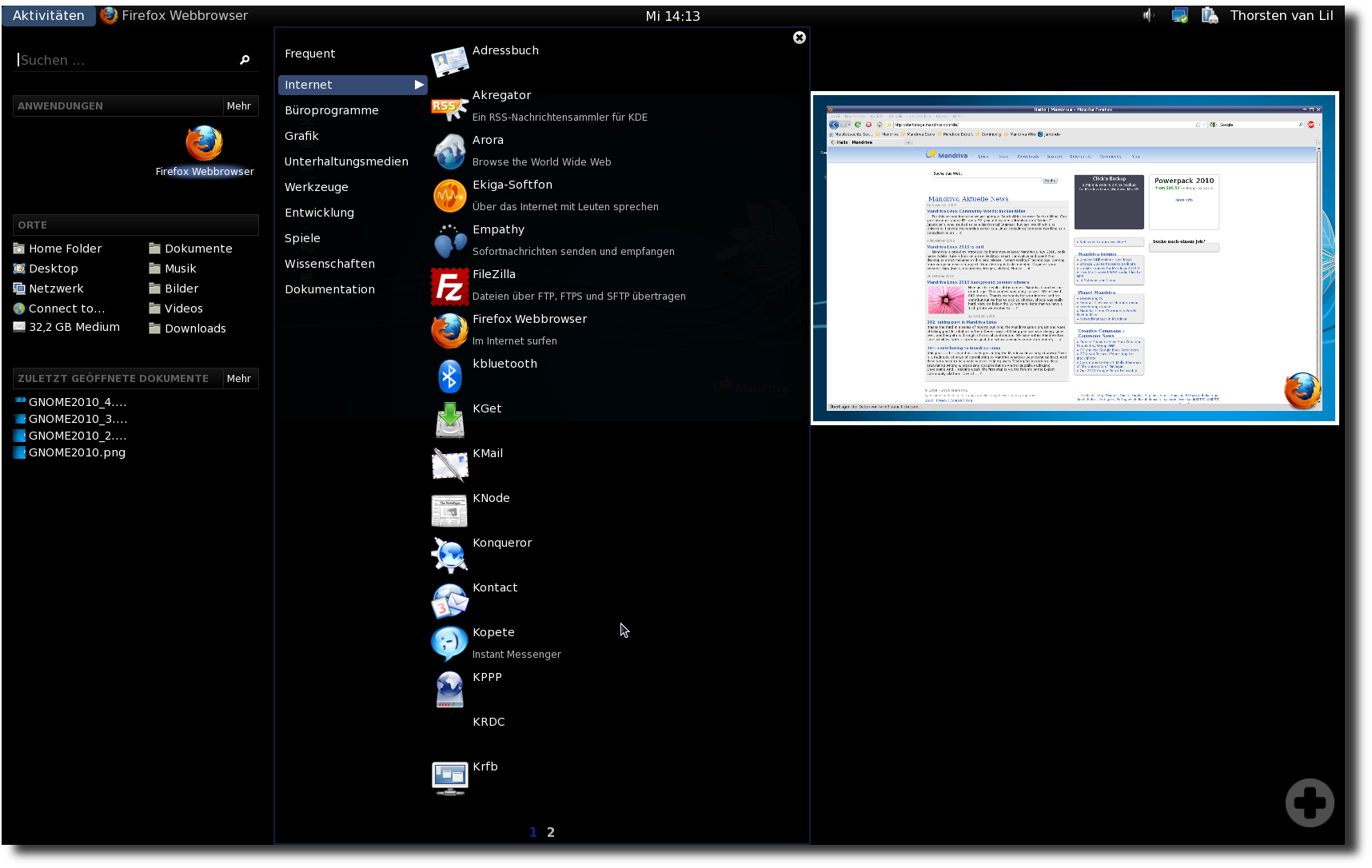

Mandriva Linux 2010 One mit KDE.

Software

Natürlich kommt Mandriva Linux mit der aktuellsten Software. Als

beliebte Desktopumgebungen sind GNOME in der Version 2.28.1, KDE in

Version 4.3.2 und Xfce in Version 4.6.1 dabei. Für Netbooks stehen

die angepassten Oberflächen Sugar und Moblin 2 bereit. Die Basis

von Mandriva Linux 2010 bildet der Kernel 2.6.31 inklusive der

üblichen Patches von Mandriva. Mozillas Browser Firefox wurde auf

die Version 3.5.5, OpenOffice.org (basierend auf dem Projekt

Go-OO [5]) auf die Version 3.1.1 angehoben.

Weiterhin wurde zur grafischen Darstellung des Startvorgangs

Plymouth ins Boot geholt und ersetzt damit Splashy.

Als grafischer Server wird X.org 7.3 mit dem X-Server 1.6.5

verwendet. Der Pulsbo-Treiber (psb) unterstützt 2-D und 3-D der

Intel-Grafikgeräte.

Testhardware

Als Hardware standen für den Test ein Thinkpad Z60m, auf dem bis

dato Mandriva Linux 2009 lief, und ein alter Desktop-Rechner mit

AMD Athlon XP 2000+ (1,7 GHz), 512 MB RAM und NVIDIA GForce 440MX

zur Verfügung. Der zweite Rechner dient als Härtetest. Hier soll

die KDE-Version als Live-CD verwendet werden. KDE4 hat den Ruf,

nicht unbedingt ressourcensparend zu sein. Als Live-CD auf einem

Rechner mit 512 MB RAM dürfte das nicht unbedingt viel Freude

bereiten. Dafür sollte die alte Hardware problemlos erkannt werden.

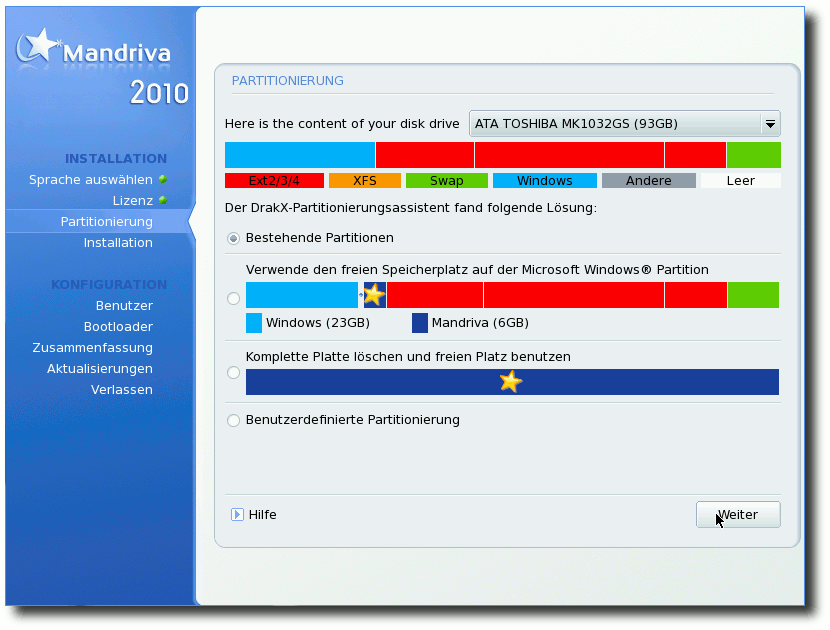

Installation

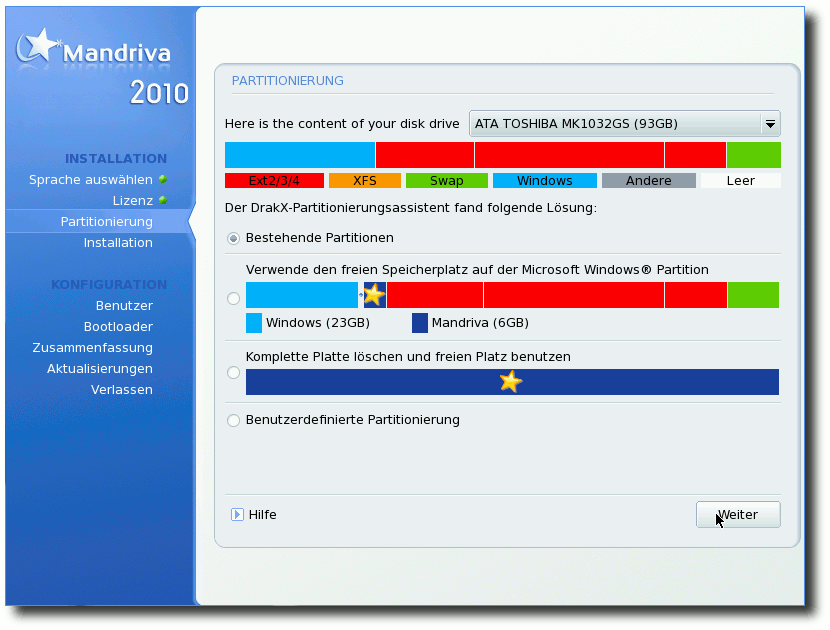

Bei beiden Installationen ist wenig Überraschendes zu berichten.

Sowohl die Live-Installation als auch der Installationsassistent

der Free-DVD sind logisch aufgebaut und verlangen wenig

Vorkenntnisse vom Anwender. Der Knackpunkt einer Installation ist

jeweils die Partitionierung. Hier bietet Mandriva zwei Features,

die das Ganze klarer machen sollen. Zum einen werden die drei

Optionen (Partitionen beibehalten, freien Platz der

Windows-Partition nutzen und komplette Platte für Mandriva nutzen)

grafisch dargestellt, wobei die Mandriva-Partition jeweils mit

einem Stern gekennzeichnet wird. Bei der benutzerdefinierten

Partitionierung besteht zudem die Möglichkeit, sich den Inhalt der

Partitionen anzeigen zu lassen. Als Standard-Dateisystem für neu

angelegte Partitionen wird Ext4 genutzt.

Neues Feature bei der Partitionierung.

Negativ ist bei der Installation mit der Free-DVD aufgefallen, dass

keine Liste von Spiegelservern bereitstand bzw. abgerufen werden

konnte. Es wurde lediglich die Fehlermeldung angezeigt.

Anschließend hatte man die Möglichkeit,

eine Serveradresse

anzugeben. Dabei bestand zu dem Zeitpunkt bereits eine Verbindung

zum Internet. Das war jedoch nicht weiter schlimm, da sich nach

der Installation die Quellen problemlos einrichten ließen. Bei der

Installation des Bootloaders (GRUB 0.97 mit ext4-Unterstützung)

wurde sowohl Windows als auch das zweite Linux-System auf dem

Rechner erkannt.

Positiv ist zu erwähnen, dass nach der Installation der One-CD ein

Dialog erscheint, der anbietet, nicht benötigte Sprachpakete

und Treiber zu deinstallieren. Obwohl in diesem Fall keine

Probleme auftraten, sollte man bei diesem Schritt

stets vorsichtig sein

und sich die Liste der zu entfernenden Pakete gut ansehen.

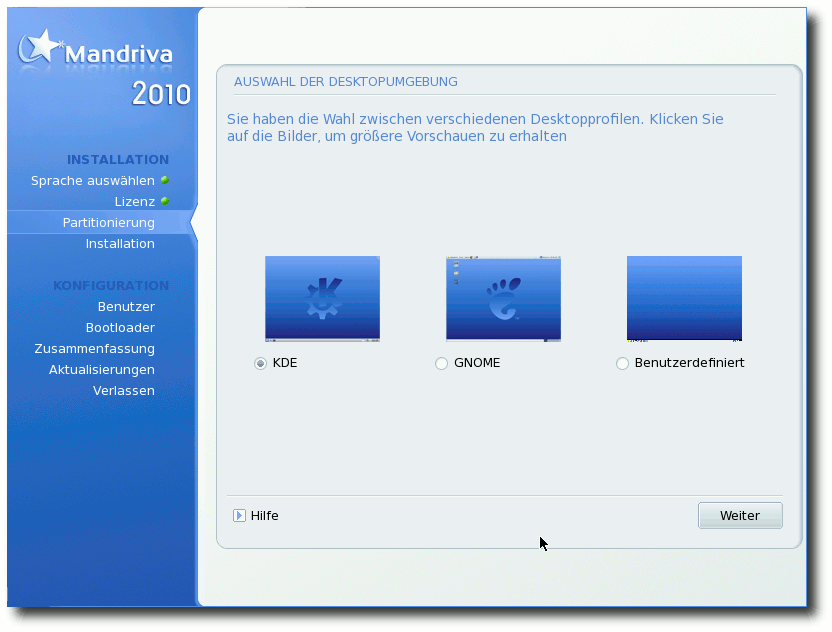

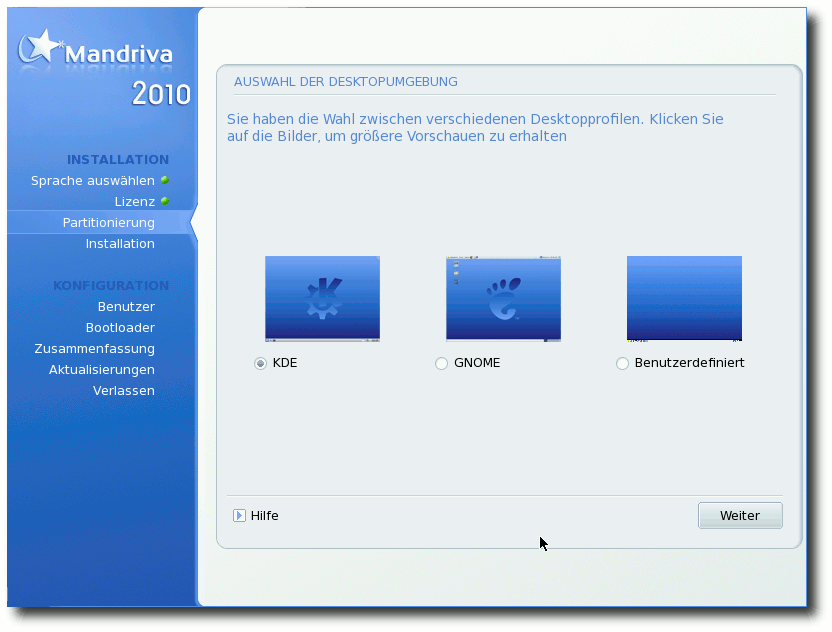

Auswahl der Desktopumgebung.

Beim ersten Neustart nach der Installation wird noch der Benutzer

eingerichtet und ein Root-Passwort festgelegt. Anschließend

erscheint ein Wizard, der ein paar Fragen stellt und

bittet, die Hardwareliste an Mandriva zu senden. Leider ist der

„Cancel“-Button etwas versteckt am unteren rechten Rand.

Wer die Umwelt schonen will oder kein optisches Laufwerk besitzt,

kann sich sowohl die Live-CD als auch die Free-DVD auf einen

USB-Stick schieben. Als Hilfsmittel dazu wird

Mandriva-Seed [6]

angeboten. Mandriva-Seed gibt es als Windows- und als Linux-Version

und macht das Aufspielen auf Sticks kinderleicht.

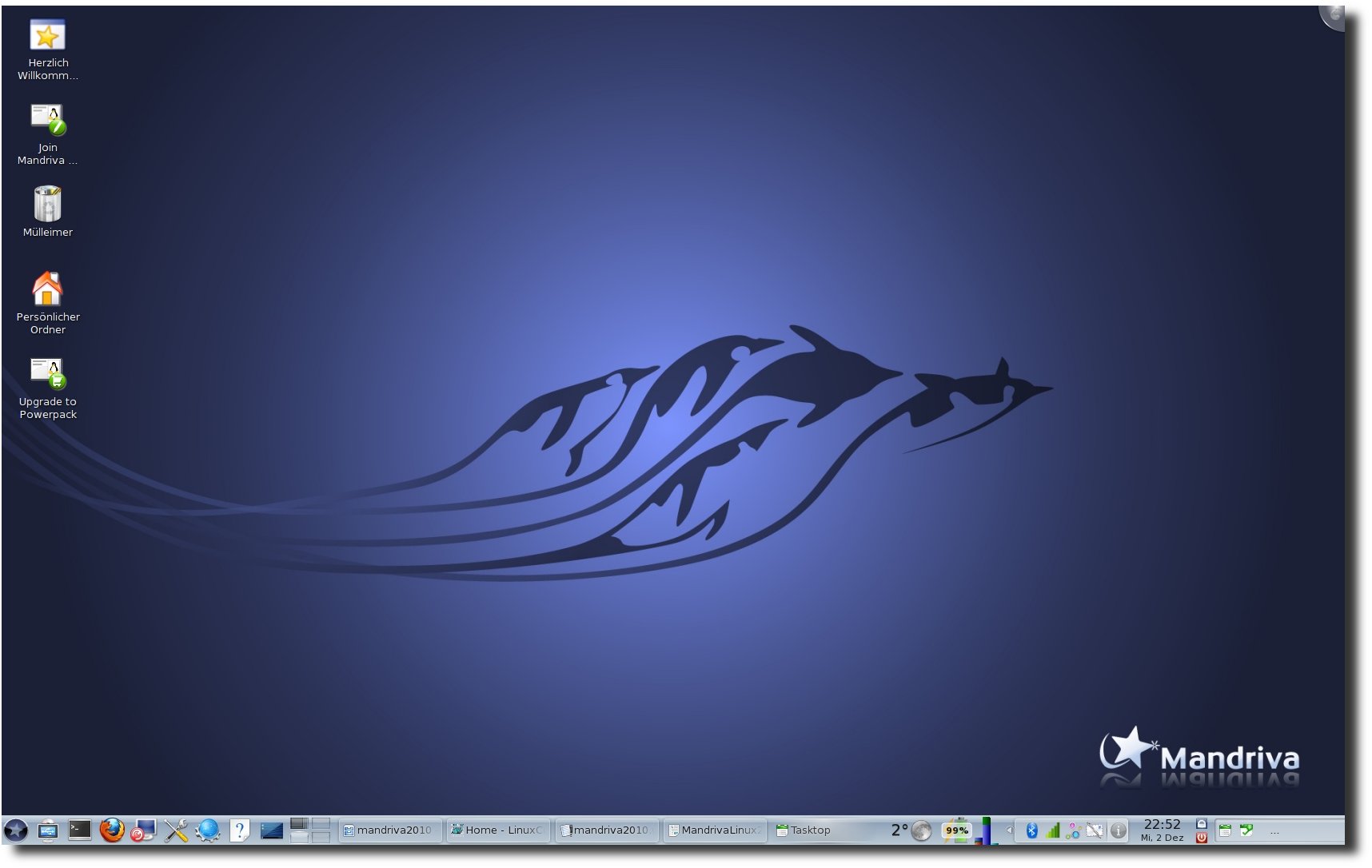

Erscheinungsbild und erster Eindruck

Nach der Installation startet Mandriva erfreulich zügig. Vor allem

fiel der schnelle Start von KDE auf. Dauerte das Starten von KDE in

früheren Versionen etwa eine halbe Minute, so braucht KDE jetzt nur

noch wenige Sekunden, bis es in voller Pracht erscheint. Als Erstes

fällt dabei auf, dass neben den angelegten Benutzern auch ein

Gast-Account vorhanden ist. Dieser erlaubt Gästen einen

passwortlosen Zugang, allerdings werden alle Daten nur temporär in

einem tmpfs-Dateisystem angelegt und nach dem Abmelden wieder

gelöscht. Wer sich an dem Gast-Zugang stört, kann ihn jedoch im

Mandriva Control Center deaktivieren.

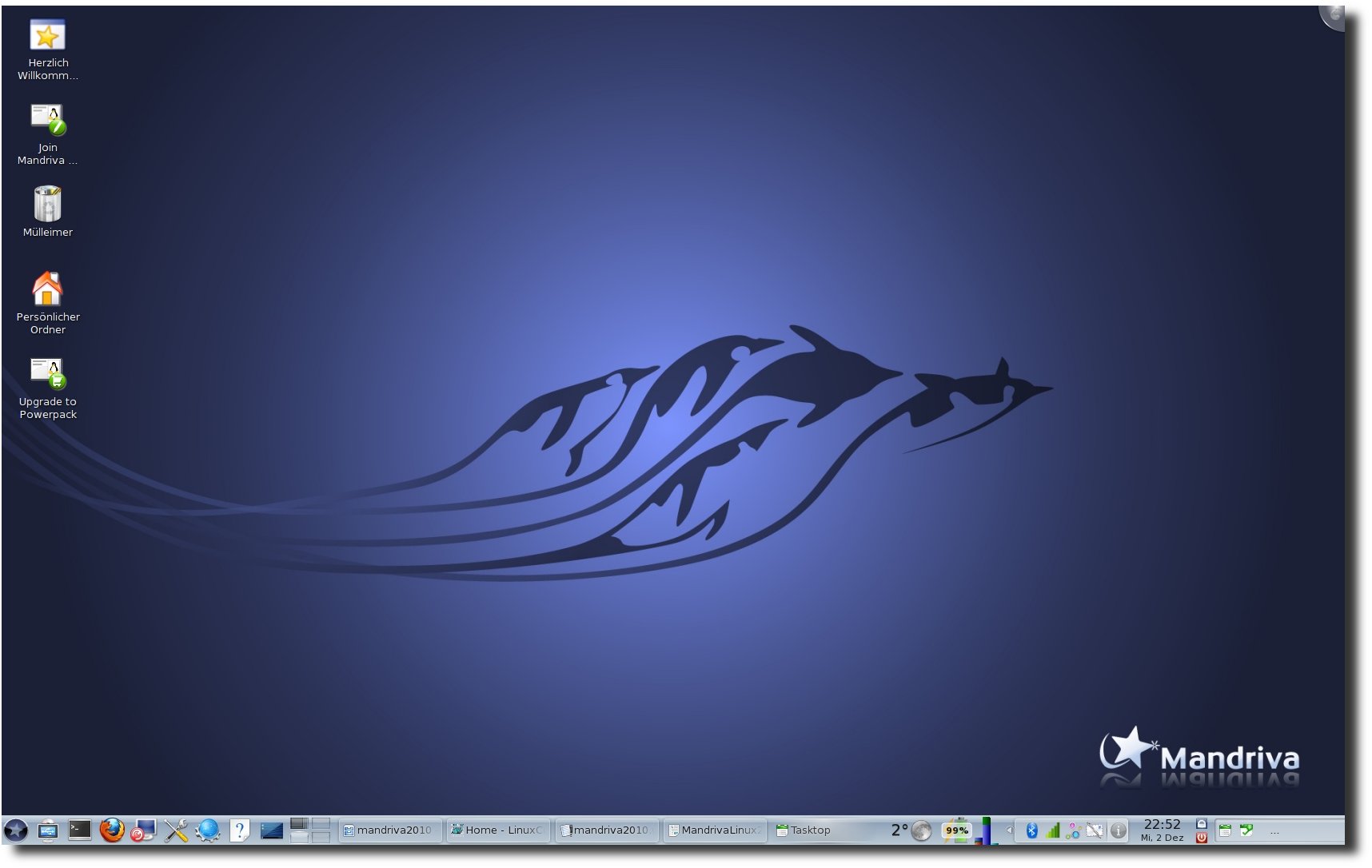

Mandriva Free mit KDE.

In der neuen Version präsentiert sich Mandriva aufgeräumt und klar.

Mandriva kommt je nach Edition in einem unterschiedlichen Theme.

One und Powerpack ähneln sich dabei sehr. Das Theme der Free-Version

präsentiert sich dagegen unterschiedlich. Innerhalb der Testdauer

wurde nichts am Standardaussehen verändert, was auch daran liegt,

dass an den Hauptkritikpunkten des Designs gearbeitet wurde. Unter

KDE wird jetzt ein eigenes Plasma-Theme verwendet. Außerdem wurde die

Fensterdekoration „Ia-Ora“ überarbeitet. Auch wenn „Ia-Ora“ immer

noch nicht überwältigend schön ist, so wirkt es zumindest nicht

mehr wie ein Fremdkörper. Das eigene Plymouth-Theme wirkt in allen

Versionen gefällig, ohne verspielt zu sein. So lässt sich

eigentlich das gesamte Erscheinungsbild von Mandriva zusammenfassen.

Mandriva One mit GNOME.

Die unterschiedlichen Desktopumgebungen wurden gleichermaßen

angepasst, sodass auch alle Programme, gleich mit welchem Toolkit,

sich in die unterschiedlichen Umgebungen gut einpassen.

OpenOffice.org nutzt zudem unter KDE das Oxygen-Icon-Theme, um eine

bessere Integration zu erreichen. Bei der One war das Abspielen von

MP3s und das Ansehen von YouTube-Videos sofort möglich. Die gesamte

Hardware der Testrechner wurde sofort erkannt und richtig

konfiguriert. LAN, WLAN, Grafik und selbst Bluetooth funktionierte

auf Anhieb. Der eingebaute Kartenleser arbeitet ebenfalls zur

vollsten Zufriedenheit.

Mandriva Powerpack mit KDE.

Das komplette System mit seinen Tools arbeitet zügig und schnell.

Auch die Softwareverwaltung hat an Geschwindigkeit zugelegt, und da

die wichtigsten Quellen bereits eingerichtet sind, kann direkt

losgelegt werden.

Das Einzige, was den positiven Gesamteindruck etwas trübte, war eine

falsche Upgrade-Meldung, die anbot, ein Upgrade auf Mandriva Linux

2009.1 durchzuführen. Ein Update behob dieses Problem jedoch.

Mandriva verwalten

Ein großes Plus von Mandriva Linux war und ist seit jeher das

Mandriva Control Center. Alle administrativen Aufgaben lassen sich

dort erledigen, wobei in der Standardkonfiguration vor allem

Werkzeuge für Endanwender vorhanden sind. Installiert man

entsprechende Pakete nach, stehen aber umfangreiche Werkzeuge zum

Einrichten unterschiedlicher Server bereit.

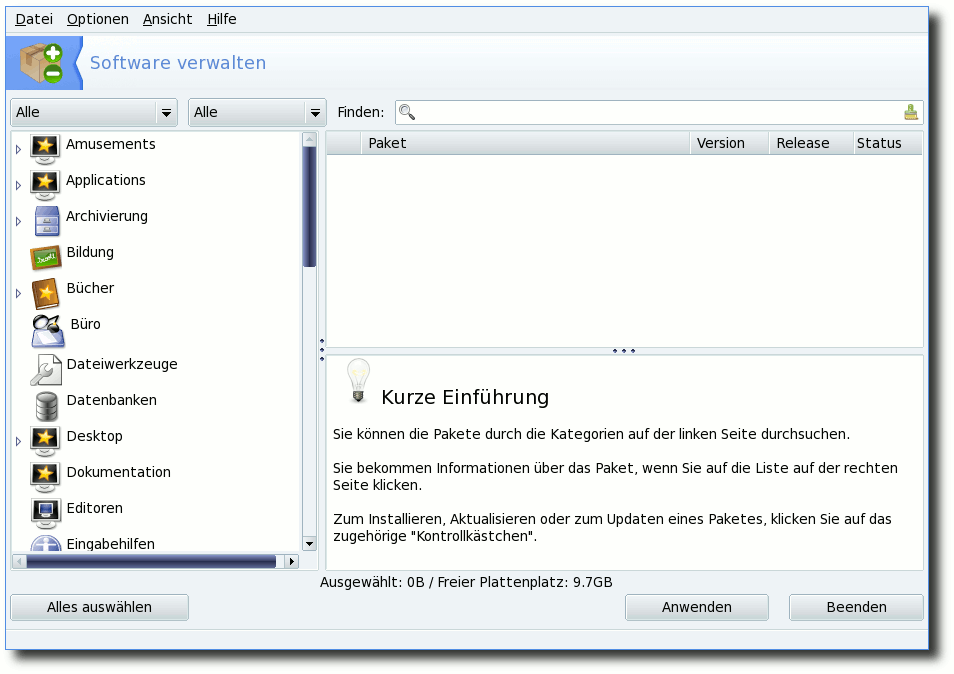

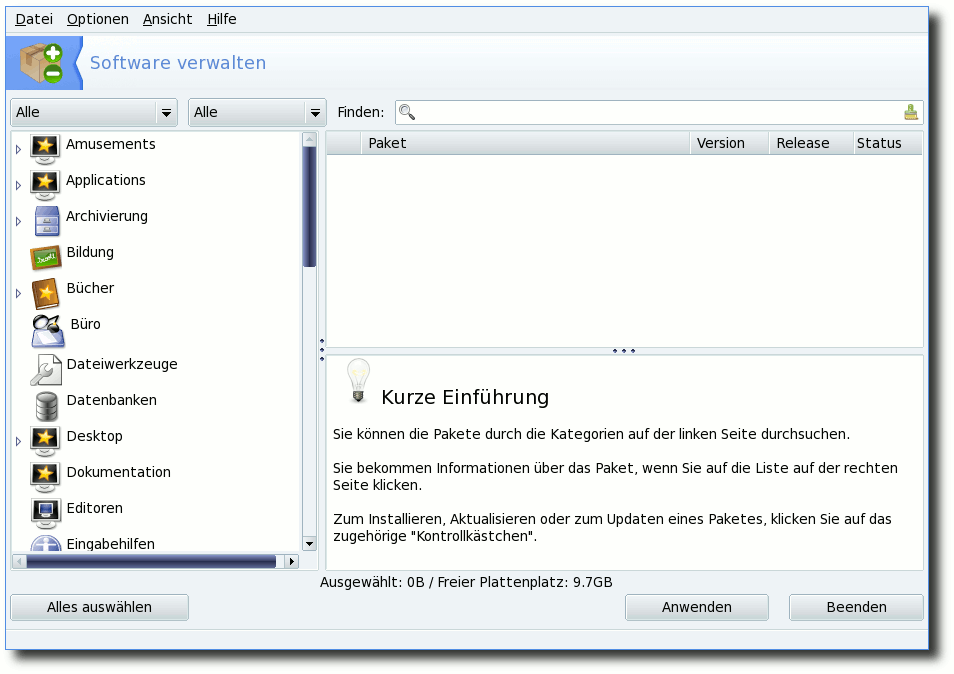

Softwareverwaltung

Die Softwareverwaltung ist zweifellos eine der wichtigsten Werkzeuge

im Leben eines Linuxsystems. Im Falle von Mandriva ist es URPMI

bzw. die grafische Oberfläche Rpmdrake. Alles Wichtige dazu findet

sich im Mandriva Control Center in der Rubrik „Software verwalten“.

Hier müssen zuerst in der Quellenverwaltung die benötigten

Softwarequellen eingerichtet werden. Wählt man rechts „Hinzufügen“,

hat man die Möglichkeit, einen vollständigen Quellen-Satz

oder nur Update-Quellen hinzuzufügen. Wählt man ersteres, werden

alle offiziellen Quellen (Main, Contrib, Non-Free, Backports,

Testing mit ihren

jeweiligen Update-Quellen) eingerichtet, wobei

nur die ersten drei mit den Update-Quellen aktiviert werden. Dabei

wird jedoch kein spezieller Server gewählt, sondern die MIRRORLIST

verwendet. Mit der MIRRORLIST wird vor jeder Aktion von URPMI ein

Server ausgesucht, der aktuell ist und eine gute Verbindung

erlaubt. Möchte man jedoch einen speziellen Server verwenden, kann

man über das Menü „Datei Pfeil rechts Add a specific media mirror“ einen aus

einer Liste wählen. Alternativ kann man auch den Service

SmartUrpmi [7] der deutschen

Mandriva-Community nutzen. Dieser bietet zudem eine erweiterte

Quellen-Auswahl. In den PLF-Quellen finden sich einige

Extras wie

libdvdcss, einige Codecs, lame und vieles mehr.

Rpmdrake als grafische Oberfläche bieten zudem einige Extras, die

hier kurz erwähnt werden sollen. Über die Drop-Down Menüs in der

linken oberen Ecke kann das Suchergebnis beeinflusst werden. Hier

kann eingestellt werden, ob nur nach Paketen mit grafischer

Oberfläche gesucht oder ob nur Metapakete angezeigt werden sollen.

Drückt man auf das Lupen-Symbol in der Suchleiste, kann man wählen,

wo gesucht werden soll, also ob beispielsweise nur in den

Paketnamen gesucht werden soll oder in den gesamten Dateilisten der

einzelnen Pakete.

Über das „Ansicht“-Menü kann man die Kategorie

wählen, die im linken Teil des Fensters angezeigt wird.

Mandrivas Softwareverwaltung Rpmdrake.

Neu seit der Version 2010 ist die Möglichkeit, die regelmäßige

Überprüfung nach Updates zu konfigurieren. Hier lässt sich die

Frequenz wählen und wann der erste Check nach dem Systemstart

stattfinden soll.

Über die Konsole hat man die Möglichkeit, verwaiste Pakete zu

entfernen. Dazu muss man den Befehl

ausführen. Hier gilt jedoch besondere Vorsicht: Entfernt man zum

Beispiel das Metapaket task-kde, wird die gesamte KDE als

verwaist dargestellt. Möchte man einzelne Pakete als nicht-verwaist

markieren, so muss man sie lediglich mit urpmi aufrufen. Das

Paket wird dann nicht erneut installiert, sondern nur als manuell

installiert markiert und ist somit nicht mehr verwaist.

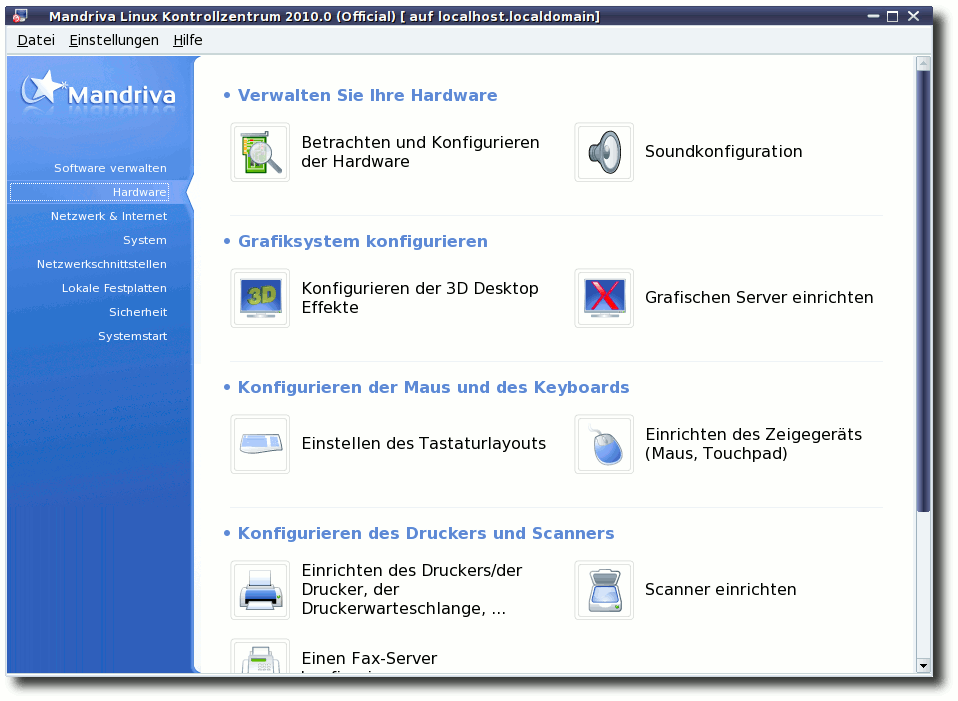

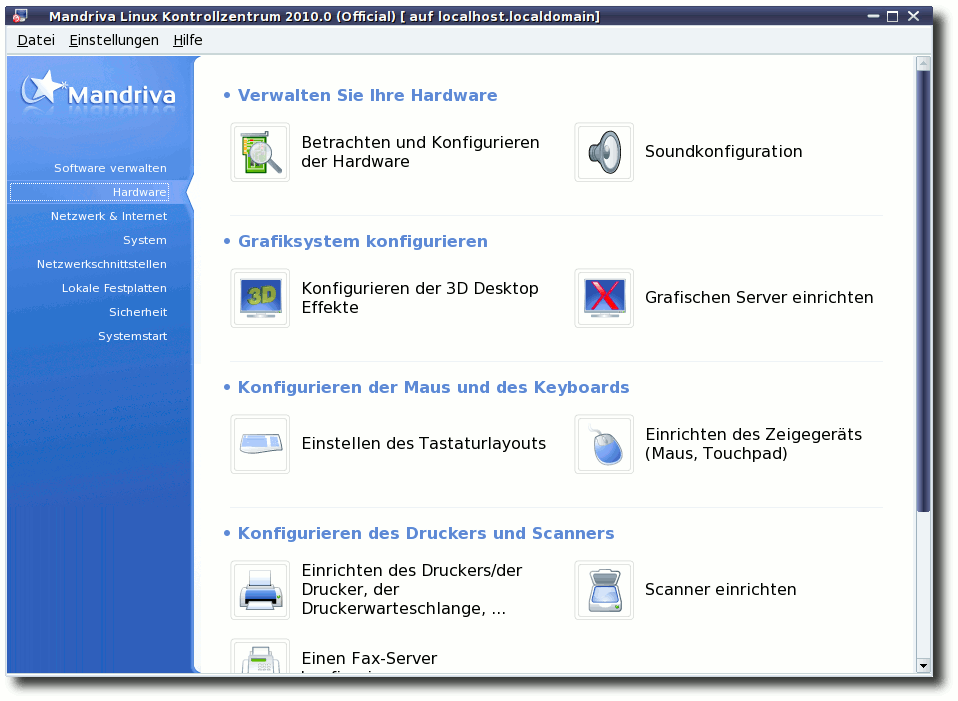

Hardwareeinrichtung

Auch bei der Einrichtung der Hardware unterstützt einen das Mandriva

Control Center. Wer die Free-Version zur Installation nutzt, will

vielleicht den proprietären Treiber für die Grafikkarte

nachinstallieren und verwenden. Dazu wählt man in der Rubrik

„Hardware“ den Punkt „Grafischen Server einrichten“. An dieser

Stelle muss man nur die Einrichtung der Grafikkarte erneut

durchgehen (die Vorauswahl bestätigen) und wird am Ende gefragt, ob

man den proprietären Treiber nutzen möchte. Bejaht man diese

Frage, wird der entsprechende Treiber heruntergeladen und eingerichtet.

Das Ganze funktioniert aber auch andersherum. Will man lieber den

freien Treiber verwenden, verneint man die Frage.

Die Hardwarerubrik im MCC.

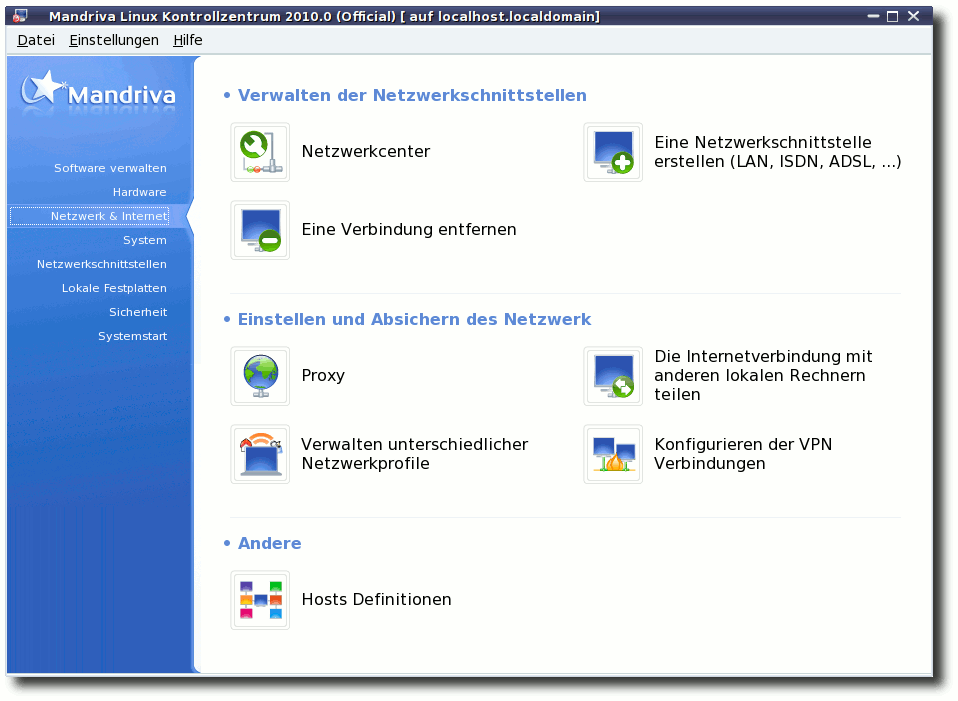

Ähnlich komfortabel läuft die Einrichtung von kabellosen Netzwerken.

Unter „Netzwerk & Internet“ kann man neue Schnittstellen hinzufügen.

Werden Treiber für das Gerät benötigt, werden diese heruntergeladen und

installiert. Bei der One-Edition sollten jedoch schon alle Treiber vorhanden sein.

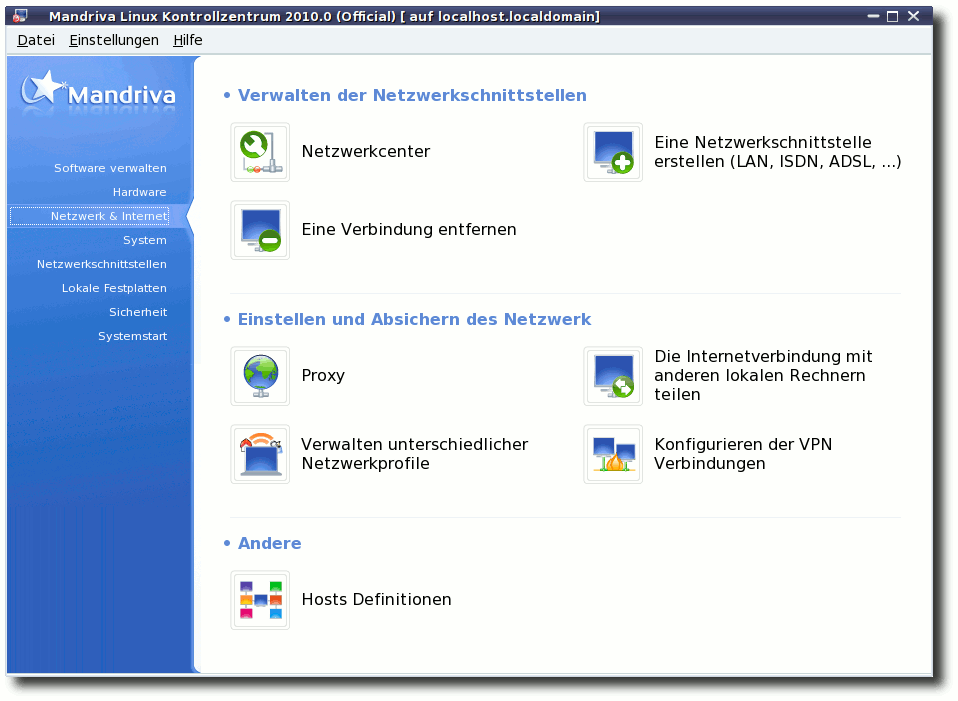

Die Netzwerkrubrik im MCC.

In der Rubrik „Hardware“ gibt es zudem den Punkt „Betrachten und

Konfigurieren der Hardware“. Hier kann die gesamte verbaute

Hardware angezeigt werden. Wählt man aus der Liste ein bestimmtes

Element an, kann auch ein jeweiliger Einrichtungsassistent

gestartet werden.

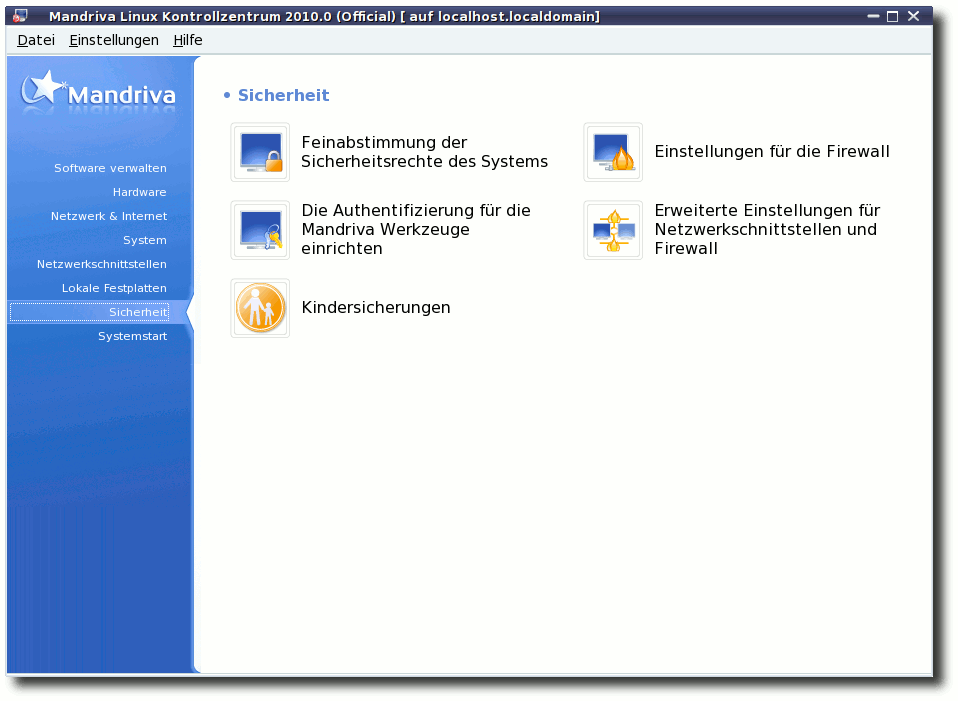

Weiterhin gibt es ein Sicherheitscenter, in dem sich regelmäßige Checks

einstellen lassen. Eine interaktive Firewall sowie eine

Kindersicherung sind auch dabei. Letztere bietet jetzt auch die

Möglichkeit, Benutzern den Zugang zum Internet nur in einer

bestimmten Zeitspanne zu erlauben.

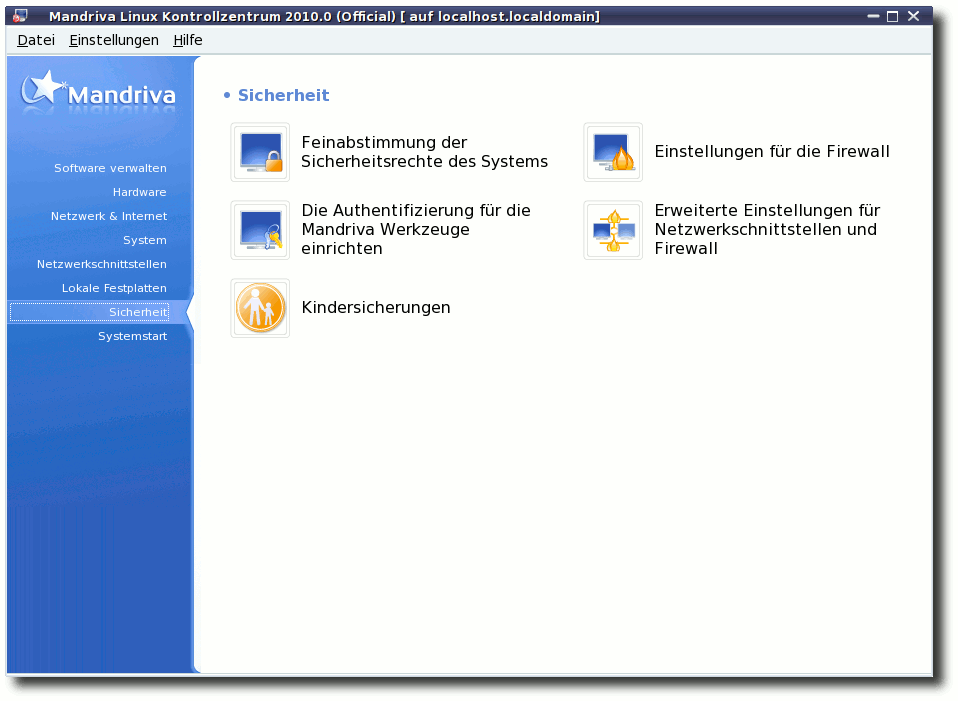

Die Sicherheitsrubrik im MCC.

Der smarte Desktop

Ja, wer hat nicht schon immer auf den smarten Desktop gewartet?

Jetzt soll er da sein. Allerdings bleibt er vorerst nur KDE-Nutzern

zugänglich. Hinter dem smarten Desktop verbirgt sich die

Integration des semantischen

Desktops [8]

mit Nepomuk. Da Mandriva mit Sebastian Trueg einen Hauptentwickler von

Nepomuk bezahlt, wundert es wenig, dass Mandriva damit wirbt, die

erste Distribution mit der Integration zu sein. Dabei gehen die

Möglichkeiten weit über das Taggen und Kommentieren von Dateien

hinaus. In einem kleinen

Video [9]

zeigt Mandriva auch, wie das funktionieren soll.

Zuerst musste aber das Paket nepomuk-scribo installiert und

Nepomuk in den KDE-System-Settings aktiviert werden. Anschließend

kann man sich das „Task Management Widget“ auf den Desktop legen

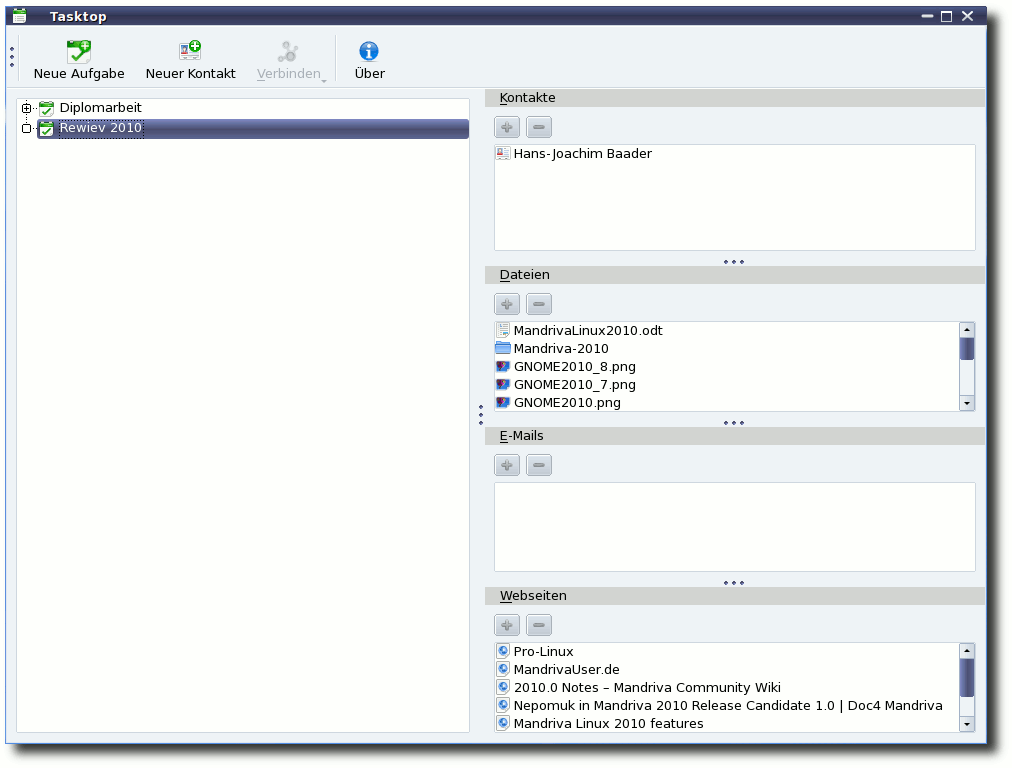

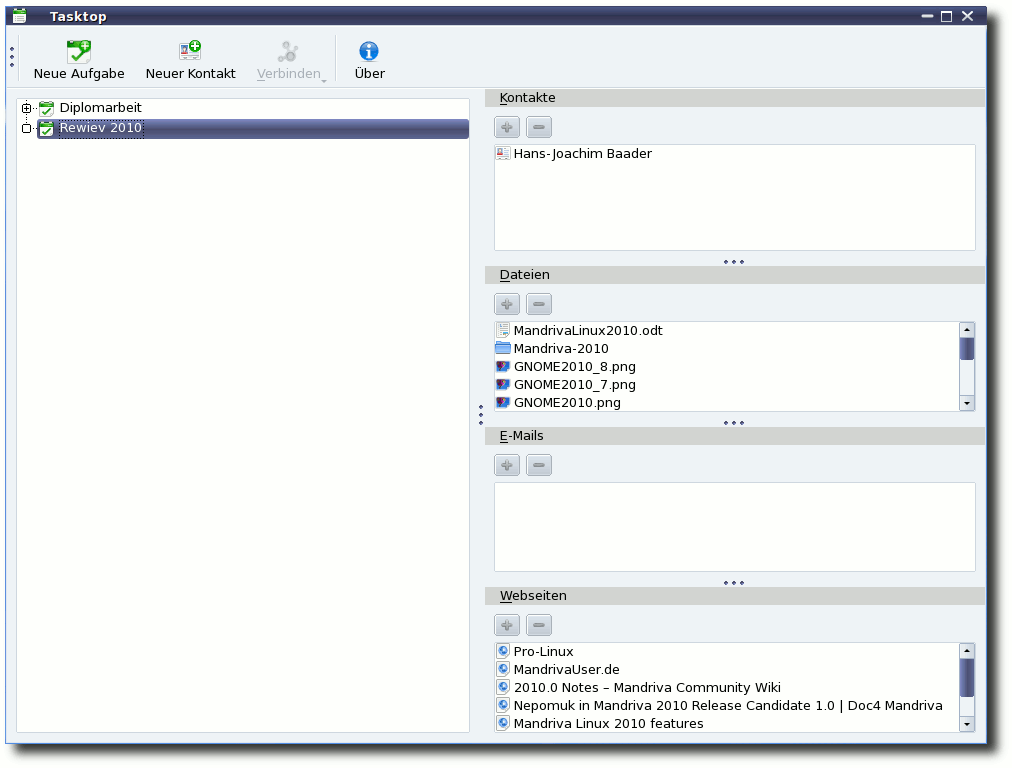

oder das Programm Tasktop starten. Mit Tasktop lassen sich Aufgaben

(mit Unteraufgaben) definieren und den Aufgaben Ressourcen

zuordnen. Als Ressourcen sind

bisher Kontakte, E-Mails,

Dateien/Ordner und Webseiten möglich. Webseiten können dabei mit

zwei Klicks aus dem Konqueror heraus mit einer Aufgabe verbunden

werden. Für Dateien und Ordner gilt das Gleiche mit Dolphin.

Wer

E-Mails mit Aufgaben verknüpfen will, braucht das Paket

kmail-nepomuk, das eine veränderte Version von KMail darstellt.

Nach der Installation wird man jedoch darauf hingewiesen, dass es

sich dabei um eine Technologie-Vorschau handelt und man diese

Version auf keinen Fall für wichtige E-Mails nutzen soll. Schade

eigentlich, denn so konnten die Funktionen nur

angetestet werden.

Kontakte müssen in Tasktop komplett neu angelegt werden. Eine

Funktion zum Importieren der Kontakte aus dem KAdressbook war nicht

aufzufinden. Hat man mehrere Kontakte mit einer Aufgabe verknüpft,

kann man so eine E-Mail an alle Kontakte dieser Aufgabe schicken.

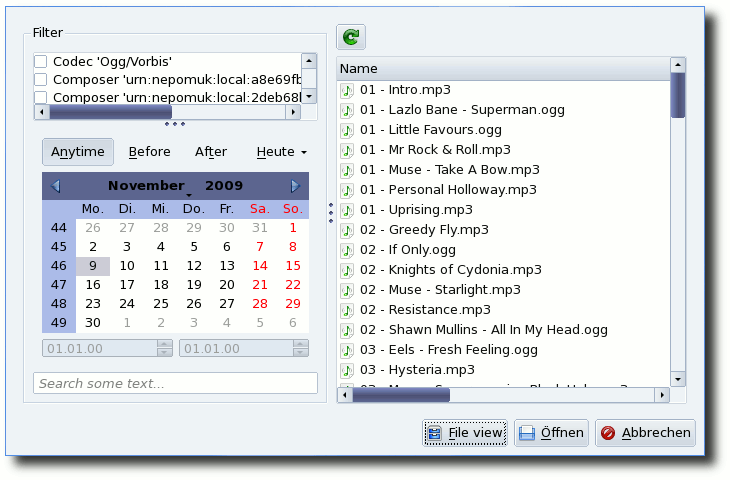

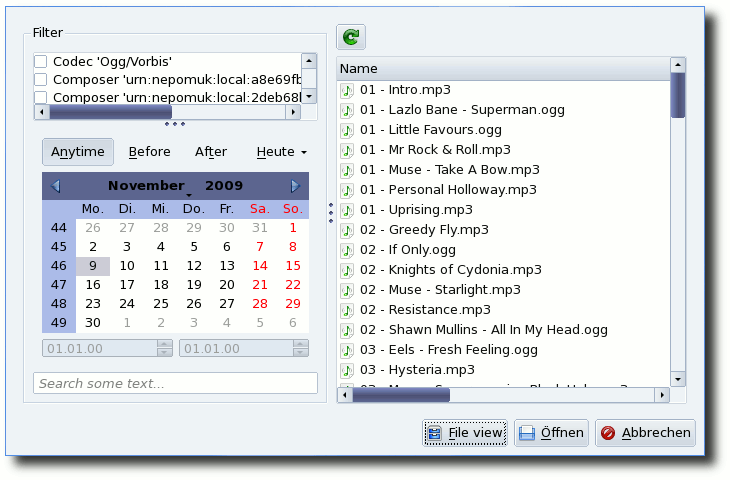

Der semantische Dateidialog.

In allen KDE-Anwendungen steht zum Öffnen und Speichern neben den

normalen Dialogen auch eine semantische Ansicht zur Verfügung.

Diese erlaubt das Suchen von Dateien anhand eines Filters und

Kalenders. Beispielsweise können damit alle Dateien anzeigt werden,

die heute bearbeitet wurden. Die Filterfunktion erwies sich dagegen

als wenig hilfreich. Es erschienen hunderte Einträge zu Nepomuk,

deren Sinn nicht ersichtlich war.

Alles in allem lässt sich mit semantischen Desktops erstmals

vernünftig arbeiten. Bei der Erstellung dieses Berichtes

haben sie sich als durchaus nützlich erwiesen. Interessante Webseiten wurden

aus dem Konqueror heraus per Mausklick mit der Aufgabe „Review

2010“ verknüpft. Bilder, Ordner und andere Dateien, die im

Zusammenhang wichtig erschienen, ebenso aus Dolphin. An einigen

Stellen hakte es jedoch noch, sodass man sich auf kommende

Versionen freuen kann.

Tasktop zum Verwalten von Aufgaben.

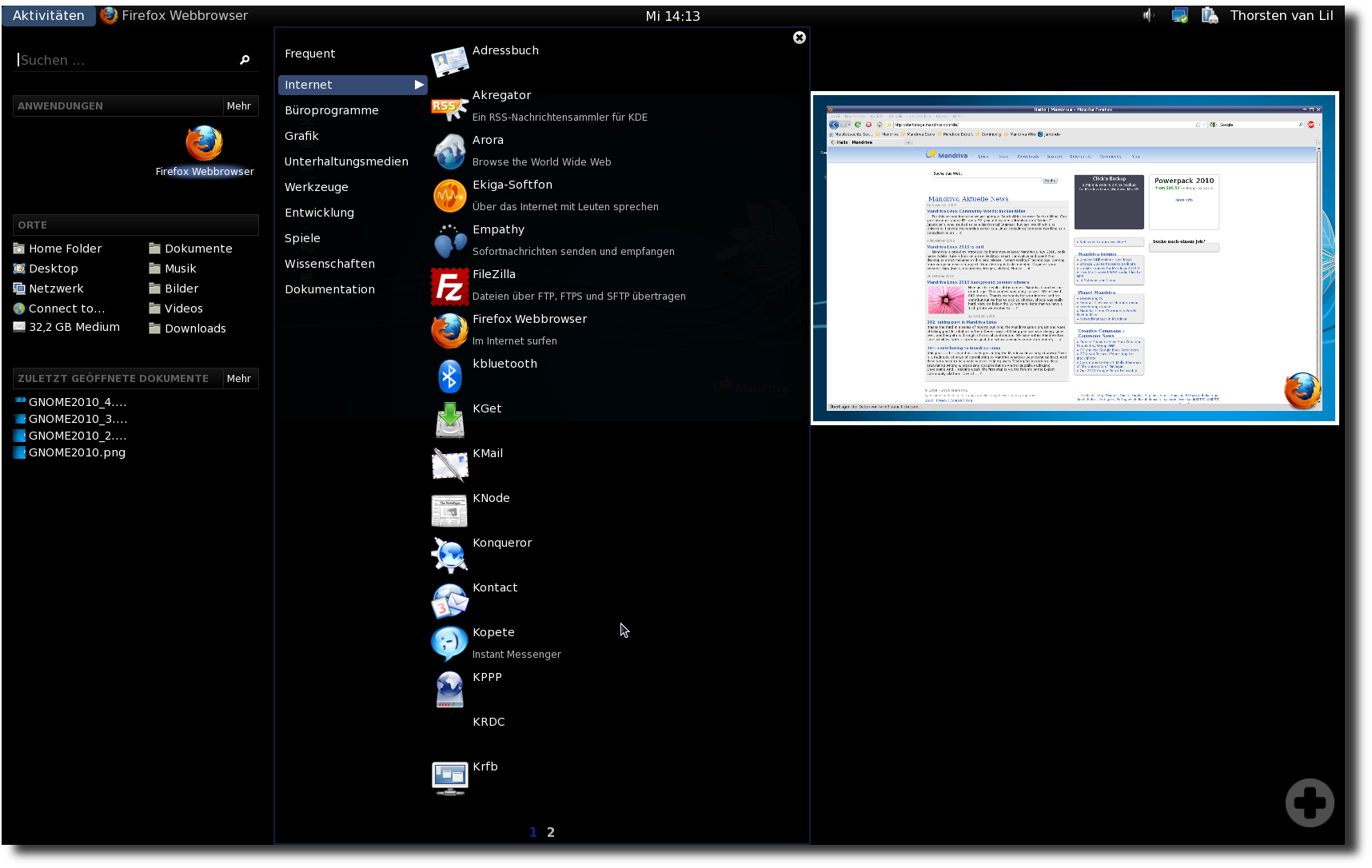

Ausblick auf GNOME3

GNOME kommt in der aktuellen Version 2.28. Auch wenn in diesem

Artikel der Fokus auf KDE liegt, soll GNOME nicht vergessen werden.

Mandriva wird oftmals als KDE-Distribution bezeichnet. Das liegt

zum einen an der sehr guten Integration von KDE und zum anderen an

den Nutzern. Laut Umfrage im offiziellen Mandriva-Forum nutzen ca. 75 %

aller Nutzer Mandriva mit KDE. Dennoch gibt sich Mandriva

jedes Mal viel Mühe, GNOME mit Erfolg auf einen gleichwertigen Level

zu bringen. Fensterdekoration und Hintergrund sind die gleichen wie

in KDE. Die Menüs sind aufgeräumt und gut sortiert. Lediglich das

verwendete Icon-Theme ist wenig gefällig.

In GNOME 2.28 ist mit Zeitgeist [10] und

GNOME Shell [11] ein Ausblick auf GNOME3

dabei. Durch den Aufruf des Befehls

wird die GNOME-Shell gestartet. Über das Konzept hinter der

GNOME-Shell mit den Aktivitäten wurde in letzter Zeit genug

geschrieben. Im Test hat es gut funktioniert, war leicht zu

verstehen und die Effekte liefen flüssig. Lediglich beim

ersten

Öffnen des Programm-Menüs gab es ein paar Sekunden Verzögerung.

Insgesamt war der Eindruck sehr positiv und man darf auf die weitere

Entwicklung gespannt sein, schließlich vergeht bis GNOME3 noch

fast ein Jahr.

GNOME Shell.

Weitere Oberflächen

Neben GNOME und KDE kommt Mandriva mit vielen weiteren Oberflächen.

Xfce und LXDE

gehören ja schon zum guten Ton. Daneben gibt es noch

für alle Netbook-Besitzer Sugar und Moblin. Mit dem jeweiligen

Metapaket (task-sugar bzw. task-moblin) sind die Umgebungen

schnell installiert. Dabei beißen sich allerdings die Pakete von

mutter und moblin-mutter, sodass man die GNOME Shell nicht

parallel zu Moblin installiert haben kann.

Moblin selbst bietet eine ansprechende und leicht verständliche

Oberfläche. Auch das Netzwerk-Center funktionierte im Test

problemlos, sodass mit wenigen Klicks eine WLAN-Verbindung

erstellt werden konnte. Allerdings stellt einen das Verlassen der

Oberfläche vor eine Herausforderung: Es gab keine Möglichkeit, sich

abzumelden, auch die Tastenkombination zum Neustarten des X-Servers

brachte keinen Erfolg. Der Wechsel auf die Konsole per

Tastenkombination klappte jedoch.

Mandriva hat angekündigt, dass nach dem Erscheinen von Moblin 2.1

auch wieder eine Mandriva-Moblin-Live-CD erscheinen wird, doch bis

jetzt ist das nicht geschehen.

Der Härtetest

Wie bereits angekündigt, wurde für den Test Mandriva Linux 2010 mit

der KDE-Live-CD auf einem Desktop-PC mit 512 MB Arbeitsspeicher

installiert. Die Installation selbst war, wie zu erwarten, sehr

zähflüssig. Der Bootvorgang dauerte bereits mehrere Minuten und

endete auf der Konsole. Die verbaute GeForce-4-Grafikkarte wurde

zwar korrekt erkannt und mit dem proprietären Treiber eingerichtet,

doch dieser scheint hier Probleme zu verursachen. Nach dem Wechseln

zum freien Treiber über das Tool XFdrake startete KDE problemlos,

wenngleich auch das weitere Minuten brauchte. Nach dem Start wurden

nicht benötigte Hintergrundprogramme wie draksnapshot beendet, um

den Platz im Arbeitsspeicher frei zu machen.

Anschließend ließ sich die Installation starten und verlief

reibungslos. Nach der Installation ließ sich mit dem Rechner

überraschend gut arbeiten. Der Startvorgang in KDE4 mit allen

Hintergrundprogrammen dauerte ziemlich genau 60 Sekunden. Nach dem

Start waren dabei etwa 30 % des Arbeitsspeichers belegt, also etwa

180 MB. Nach dem Start von Amarok, Firefox und OpenOffice.org waren

jedoch auch schon über 45 % des Arbeitsspeichers belegt. Das

Navigieren mit Dolphin auch in Ordnern mit vielen Dateien verlief

zügig. Programme wie OpenOffice.org und Firefox brauchten für den

Erststart wenige Sekunden.

Zusammenfassend lässt sich also sagen, dass 512 MB Arbeitsspeicher

genug ist für eine volle Installation mit KDE4. Als Installationsweg

empfiehlt sich jedoch eher die Free-DVD und weniger die Live-CD.

Die Community

Die Gemeinschaft der Mandriva-Nutzer [12]

ist im deutschsprachigen Raum eher etwas kleiner, aber dafür an

einer Stelle zentriert. Dort findet sich neben einem aktiven

Forum [13], ein Wiki [14],

Newsportal [15], Spiegel-Server

und ein eigenes Paket-Repository. Zu dem Angebot haben sich

vor wenigen Wochen auch eine

Netbook-Edition [16] und eine

LXDE-Edition [17] gesellt.

Fazit

Mandriva Linux 2010 hat sich innerhalb der letzten Wochen als gut

durchdachtes und leicht zu bedienendes System erwiesen. Das System

arbeitet schnell und wirkt trotz KDE4 leicht und spritzig. Es hat

große Freude bereitet, das System zu nutzen und negative Punkte

müssen wirklich gesucht werden, aber es gibt sie. Dazu zählen die

falsche Upgrade-Meldung (was aber mit einem Update behoben wurde)

und die eine oder andere fehlende Übersetzung. Alles in allem ist

Mandriva Linux 2010 aber eine rundum gelungene Version, die ich

jedem nur empfehlen kann. Die Berichte über Mandriva 2010, die

bisher veröffentlicht wurden, sind ähnlich positiv, sodass jeder,

der gerade auf der Suche nach einer neuen Distribution ist, sich

Mandriva ansehen sollte.

Seit Mandriva Linux 2009.0 hat sich somit Mandriva mit jeder Version

deutlich gesteigert. Man darf also gespannt sein, wo die Reise noch

hingeht.

Links

- http://wiki.mandriva.com/de/2010.0_Notes

- http://www.pro-linux.de/NB3/artikel/2/360/mandriva-linux-2010.html

- http://www.gnu.org/copyleft/fdl.html

- http://www2.mandriva.com/linux/which/

- http://go-oo.org/

- ftp://ftp.mandrivauser.de/mandriva_isos/2010.0

- http://www.mandrivauser.de/smarturpmi

- http://doc4.mandriva.org/bin/view/labs/Nepomuk-mdv2010-RC

- http://www.dailymotion.com/video/xbc6a2_nepomuk-semantic-desktop-under-mand_tech

- http://live.gnome.org/Zeitgeist

- http://live.gnome.org/GnomeShell

- http://www.mandrivauser.de/

- http://www.mandrivauser.de/forum

- http://www.mandrivauser.de/doku/doku.php

- http://www.mandrivauser.de/wordpress/

- http://www.mandrivauser.de/wordpress/?p=443

- http://www.mandrivauser.de/wordpress/?p=454

| Autoreninformation |

| Thorsten van Lil

nutzt Mandriva privat seit 2007. Er ist verantwortlich

für das offizielle deutsche Mandriva-Wiki und ist darüber hinaus

Administrator des MandrivaUser-Newsportals.

|

| |

Diesen Artikel kommentieren

Zum Index

von Mathias Menzer

Basis aller Distributionen ist der Linux-Kernel, der

fortwährend weiterentwickelt wird. Welche Geräte in einem halben

Jahr unterstützt werden und welche Funktionen neu hinzukommen,

erfährt man, wenn man den aktuellen Entwickler-Kernel im Auge

behält.

Linux 2.6.33

In unter drei Monaten und nach nur acht Vorabversionen veröffentlichte Torvalds Ende Februar noch den Kernel 2.6.33 [1]. Der trotz Weihnachtszeit und des Jahreswechsels vergleichsweise schnell fertiggestellte Neuling der Linux-Kernel-Reihe kann dennoch mit bedeutenden Neuerungen aufwarten. So befindet sich der freie Treiber „Nouveau“ für NVIDIA-Grafik-Chipsätze nun im Kernel. Er wurde mittels Reverse Engineering ohne Hilfe von NVIDIA entwickelt, bietet jedoch bereits gute 2-D-Unterstützung und eine eingeschränkte 3-D-Beschleunigung. Die Arbeiten daran laufen weiter, unter anderem mit dem Ziel, die Abhängigkeit von der Firmware ctx_voodoo zu entfernen. Die Nouveau-Entwickler erhoffen sich eine bessere und längerfristige Unterstützung von Grafikhardware, da Anwender unterstützter Karten nun nicht mehr allein auf das Wohlwollen des Herstellers angewiesen sind.

Ebenfalls populär war die Aufnahme des Kernel-Moduls von DRBD (Distributed Replicated Block Device). Diese Software ermöglicht die Replikation eines Blockspeichergerätes über das Netzwerk auf andere Systeme. Damit lassen sich zum Beispiel Partitionen erstellen, die auf mehreren Servern synchron gehalten werden und somit beim Ausfall eines Systems noch zur Verfügung stehen - sei es durch einen Festplattendefekt, eine Störung des Netzwerks oder sonstige Ausfälle bedingt.

Etwas Schutz vor bösen Absichten sollen „TCP Cookie Transactions“ (TCPCT) bieten - eine Erweiterung des TCP-Protokolls, die die Wirksamkeit von Denial-of-Service-Attacken vermindert. Dabei wird beim Verbindungsaufbau ein Cookie mitgesendet, mit dessen Hilfe auf der Gegenseite eben jener Verbindungsaufbau ohne die Nutzung weiterer Ressourcen durchgeführt werden kann. Ebenso werden direkt nach Beendigung der Verbindung Ressourcen auf dem Server wieder freigegeben.

Auch von ReiserFS gibt es wieder etwas zu hören. Allerdings von der etwas älteren Version 3, die bislang immer noch Gebrauch vom Big Kernel Lock (BKL) machte. Diese mittlerweile veraltete Variante zur Verhinderung gleichzeitiger Zugriffe auf den Kernelspace sperrt den gesamten Kernel, im Gegensatz zur aktuellen Methode, nur einzelne Zweige zu sperren. ReiserFS machte hiervon exzessiv Gebrauch und erleichterte es den Entwicklern dadurch nicht gerade, ihm den BKL auszutreiben. Sie bedienten sich daher rekursiver Locks (mehrfacher Sperren durch einen einzigen Thread). Dies wird auch nicht als saubere Lösung gesehen, allerdings hätte eine Implementierung aktueller Sperrmechanismen ein Umschreiben großer Teile von ReiserFS erfordert.

Auch diesmal ist die Anzahl der Änderungen wieder zu groß, um sie alle beschreiben zu können. Spieler und Bastler können sich über die Unterstützung für Sonys Wii und Nintendos Gamecube freuen, Entwickler über weitere Werkzeuge zur Leistungsmessung des Kernels. Der Radeon-Treiber wurde verbessert und arbeitet nun auch mit R6xx- und R7xx-Modellen, neue Treiber kamen in allen Bereichen hinzu. Eine umfassende, englischsprachige Auflistung bietet Kernelnewbies [2].

Android fliegt raus

Seit 2.6.33 sind die Android-spezifischen Anpassungen nicht länger im Linux-Kernel enthalten. Einmal mehr betonte der Verwalter des staging-Zweiges, Greg Kroah-Hartman, „staging ist kein Abladeplatz für ungepflegten Code“ und warf die entsprechenden Treiber kurzerhand raus [3]. Android nutzt ein anderes Verfahren zum Sperren genutzter Bereiche im Kernelspace und verfügt auch über ein abweichendes Sicherheitsmodell, wodurch zusätzliche Anpassungen benötigt werden, damit Android-Treiber in den Linux-Kernel aufgenommen werden könnten. Leider machte Google bislang keine Anstalten, um diese notwendigen Änderungen vorzunehmen. Nachdem Jan Wildeboer nun einen Fork des Kernels [4] befürchtete, kam wieder Leben in das Thema. In einem Interview mit Linux-Magazin ließ Kroah-Hartman durchsickern, dass Google die Zusammenarbeit mit den Entwicklern des Mainstream-Kernels aufnehmen möchte und auch das Sicherheitsmodell von Android überarbeiten wolle [5].

Optimierungen für den Desktop

Auch Con Kolvias, der ein ausgeprägtes Faible für Scheduler hat, meldet sich zurück - mit einem umfassenden Satz an Patches für den Kernel 2.6.33, der sich auf die Leistung des Kernels auf einem Desktop-System positiv auswirken soll [6]. So findet sich darin unter anderem der von ihm erdachte Brain Fuck Scheduler (BFS), mit dem er sich im September vergangenen Jahres nach zweijähriger Pause wieder bei der Kernel-Entwicklergemeinde zurückmeldete (siehe „Der September im Kernel-Rückblick“, freiesMagazin 10/2009 [7]). BFS nutzt die Ressourcen auf Systemen mit vier oder weniger Prozessoren besser als der derzeit verwendete Completely Fair Scheduler (CFS). Weitere enthaltene Patches verringern Latenzzeiten oder optimieren das Swap-Verhalten.

Ksplice

Eine Methode, um Kernelaktualisierungen ohne Neustart des Systems zu installieren, stellt Ksplice dar (siehe „Kernel-Rückblick“, freiesMagazin 05/2008 [8]). Das am MIT (Massachusetts Institute of Technology) [9] entwickelte Verfahren wird nun durch das Unternehmen Ksplice [10] als Dienstleistung namens „Ksplice Uptrack“ vertrieben. Dabei stellt Ksplice angepasste Aktualisierungen bereit, die per Abonnement durch ein auf dem System installierten Programm heruntergeladen und als Modul zur Laufzeit in den Kernel eingehängt werden. Während das Abonnement für Red Hat Enterprise Linux, CentOS, Debian und Ubuntu 8.04 LTS kostenpflichtig ist, steht es Anwendern von Ubuntu 9.04 und 9.10 kostenfrei zur Verfügung [11].

Was kostet Linux?

Linux ist Freie Software. Dass damit nicht frei im Sinne von Freibier gemeint ist, darauf wies schon Richard M. Stallman hin. Eine Forschungsgruppe an der Universität von Oviedo (Spanien) hat diese Aussage nun mit harten Zahlen untermauert [12]. Die Forscher ermittelten nach dem Constructive Cost Model (COCOMO) [13] den Wert des Kernels 2.6.30 mit über einer Milliarde Euro. Bei einer Entwicklungszeit von 14 Jahren würden von Anfang an 985 Personen an der Kernel-Entwicklung mitarbeiten müssen. Die Forscher weisen darauf hin, dass die verwendeten Kostenmodelle der Komplexität der Open-Source-Software-Entwicklung nicht ganz gerecht werden, da hier Code beständig einfließt, aber auch wieder entfernt wird. Dies würde ein Überdenken dieser Modelle erfordern, um zum Beispiel auch die Wiederverwendung und Weiterentwicklung des Codes zu berücksichtigen [14].

Links

- http://lkml.org/lkml/2010/2/24/301

- http://kernelnewbies.org/Linux_2_6_33

- http://www.pro-linux.de/NB3/news/1/15260/android-und-der-linux-kernel.html

- http://jan.wildeboer.net/2010/02/is-google-forking-the-linux-kernel/

- http://www.linux-magazin.de/NEWS/Video-Android-und-der-Linux-Kernel

- http://www.linux-community.de/Internal/Nachrichten/Con-Kolivas-meldet-sich-mit-Patchset-fuer-2.6.33-zurueck

- http://www.freiesmagazin.de/freiesMagazin-2009-10

- http://www.freiesmagazin.de/freiesMagazin-2008-05

- http://mit.edu/

- http://www.ksplice.com/

- http://www.pro-linux.de/NB3/news/1/15293/ksplice-uptrack-ermoeglicht-kernel-updates-ohne-neustart.html

- http://www.pro-linux.de/NB3/news/1/15350/was-kostet-die-entwicklung-des-kernels-2630.html

- http://de.wikipedia.org/wiki/COCOMO

- http://iri.jrc.ec.europa.eu/concord-2010/posters/Garcia-Garcia.ppt

| Autoreninformation |

| Mathias Menzer

wirft gerne einen Blick auf die Kernel-Entwicklung, um mehr über die

Funktion von Linux zu erfahren. |

| |

Diesen Artikel kommentieren

Zum Index

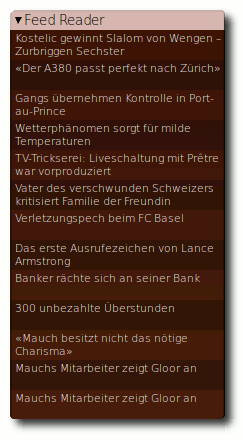

von Ralf Hersel

Die Arbeitsoberfläche der Linux Desktops ist von Haus aus eine Wüste,

die zu 5 % aus Panels, Menüs und Startern besteht und zu 95 % ein

Hintergrundbild ohne weitere Information oder Funktion zeigt. Viele

Anwender sind mit diesem Zustand zufrieden, andere wünschen sich mehr

Inhalt auf der Oberfläche. In diesem Artikel werden Maßnahmen beschrieben, um

den Informationsgehalt des Desktops zu erhöhen und ihn optisch

ansprechender zu gestalten.

Status quo

Die grafische Benutzeroberfläche wurde ab 1973 von der Firma Xerox mit

dem Xerox Alto erfunden. Zu einem kommerziellen Erfolg wurde jedoch

erst der Xerox Star [1] im Jahr 1981. Die Oberfläche des Xerox Star

zeigt die wesentlichen Elemente des Konzepts: grafische Darstellung,

Anwendungen in eigenständigen Fenstern, Icons als Links auf

Anwendungen, Verzeichnisse oder Dateien. Der Xerox Star verdeutlicht

die Schreibtisch-Metapher: Es liegen geöffnete Briefe herum, es gibt

Posteingangs- und -ausgangskorb, einen Papierkorb, Taschenrechner und

Drucker sowie Ordner für die verschiedenen Dokumententypen.

In den vergangenen 30 Jahren hat sich an diesem Grundkonzept nicht

viel verändert. Seien es die Apple-, Windows- oder Linux-Desktops, im

Grunde genommen sieht es immer noch aus wie damals. Auf einem modernen

Desktop, wie z. B. GNOME, ist von der Schreibtisch-Metapher nicht mehr

viel übrig geblieben. Der Schreibtisch ist so gut wie leer; lediglich

der Papierkorb ist noch vorhanden, versteckt sich aber rechts unten im

Panel. Der Grund für das Verschwinden der ursprünglichen

Desktopelemente liegt auf der Hand - ein geöffnetes Dokument oder

Programm

verdeckt in der Regel große Teile des Schreibtischs und damit

auch die nützlichen Helferlein. Im Panel sind diese Elemente jedoch auch bei

maximierten Programmfenstern jederzeit erreichbar.

Folgt man den Forendiskussionen zu diesem Thema [2], so

besteht hier kein Handlungsbedarf. Die meisten Anwender sind mit dem

Desktop zufrieden. Die Minimalisten unter ihnen bevorzugen einen

aufgeräumten Schreibtisch, auf dem fast nichts herumliegt. Bei der

anderen Fraktion ähnelt der Desktop einem Schachbrett voller Starter

und Dokumentenicons.

Wer jedoch mehr Informationen auf seiner grafischen Oberfläche haben

möchte, für den

bieten die aktuellen Linux-Desktops kleine

Applikationen, sogenannte Applets. Bei KDE heißen sie Plasmoide;

bei GNOME gibt es die GDesklets und die Screenlets [3]. Mit ihnen lässt sich der

Informationsgehalt des Desktop erweitern.

Mehr Infos

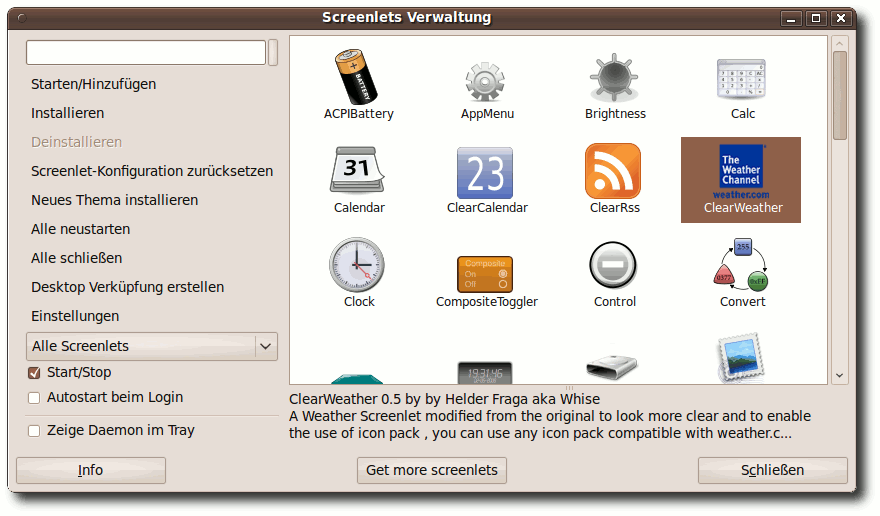

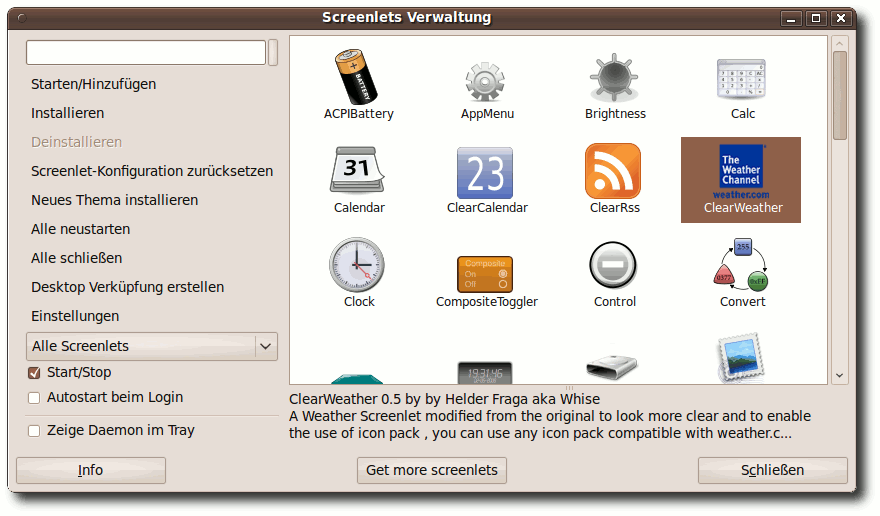

Als Beispiele für informative Applets unter Ubuntu mit GNOME-Oberfläche

dienen das Clear-Weather-Screenlet und das Feed-Reader-Screenlet. Bevor diese

eingerichtet werden können, muss man das Paket screenlets

wie gewohnt über das Software-Center installieren.

Nach der Installation kann die Screenlet-Verwaltung

aus dem Menü „Zubehör“ gestartet werden.

Diese Verwaltung gibt einen Überblick über die verfügbaren Screenlets,

erlaubt das Starten und Stoppen sowie das Konfigurieren der

ausgewählten Screenlets. Außerdem kann über das Internet [4] die Sammlung erweitert werden. Wer

möchte, kann die Screenlets seiner Wahl einmalig starten oder per

Eintrag in die Startprogramme bei jedem Sitzungsstart automatisch auf

den Desktop bringen.

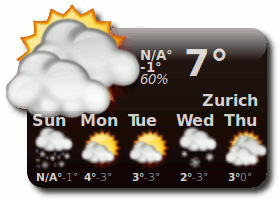

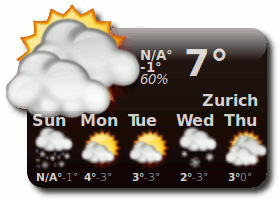

Die Wettervorhersage (Clear-Weather-Screenlet) geht über den

Standard-Wetterbericht im GNOME-Panel hinaus, indem auch Informationen

zur Tag-/Nachttemperatur, der Luftfeuchtigkeit und dem

voraussichtlichen Wetter der nächsten Tage angezeigt werden. Der

wesentliche Aspekt ist jedoch die permanente Anzeige auf dem Desktop;

im Gegensatz dazu müssen die Wetterinformationen aus dem GNOME-Panel

immer aktiv geöffnet werden. Das ist als grundsätzlicher Vorteil der

Applets zu sehen - Informationen können im Vorübergehen konsumiert werden;

es muss kein Programm gestartet werden.

Bevor das Wetter für den eigenen Standort angezeigt wird, muss man in

den Einstellungen des Clear-Weather-Screenlets die lokale Position

angeben. Diesen sogenannten ZIP-Code findet man auf der Seite

von weather.com [5].

Dort kann nach dem Namen der Stadt gesucht

werden, worauf der gesuchte ZIP-Code als Teil der URL angezeigt wird.

Bei der Stadt Zürich sieht die URL von weather.com so aus:

http://www.weather.com/weather/today/Zurich+Switzerland+SZXX0033?from=enhsearch.

Der ZIP Code lautet SZXX0033 und wird im Feld „ZIP“ bei den

Einstellungen des Clear-Weather-Screenlets erwartet.

Screenlet-Verwaltung.

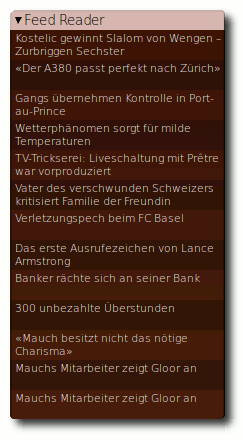

Ein weiteres Beispiel für die Erhöhung des Informationsgehalts des

Desktops ist das Feed-Reader-Screenlet. Mit ihm kann ein RSS-Feed

abonniert werden. Das Screenlet zeigt die Überschriften der Feeds an,

öffnet beim Darüberfahren mit der Maus den Kurztext der Nachricht und

beim Klicken die zugehörige Internetseite. Möchte man mehrere

Feeds im Auge behalten, so können weitere Instanzen des Feed-Reader-Screenlets

gestartet und auf dem Desktop angeordnet werden.

Clear-Weather-Screenlet.

Feed-Reader-Screenlet.

Die beiden vorgestellten Screenlets beziehen ihre Informationen aus

dem Internet, somit ist eine Internetverbindung erforderlich, um keine

leeren Screenlets auf dem Desktop zu haben. Was sich trivial und

selbstverständlich anhört, birgt eine kleine Tücke: Beim Starten

erwarten die Screenlets eine bestehende Internetverbindung, ansonsten

zeigen sie keinen Inhalt an. Wer nun zu Hause oder unterwegs seinen

Zugang zum Internet über WLAN herstellt, wird feststellen, dass es

einige Sekunden dauert, bis eine Verbindung aufgebaut wird. In dieser

Zeit sind alle Screenlets gestartet und haben natürlich keine

Verbindung zum Internet bekommen. Das ist nicht sehr schön, zumal die

Screenlets erst nach einigen Minuten ein Update des Inhalts holen;

solange bleiben sie leer.

Abhilfe schafft hier ein Skript, welches die Screenlets erst dann

startet, wenn eine Internetverbindung besteht. Hierzu gibt es eine

korrekte, aber komplizierte Lösung und eine Quick-and-Dirty-Lösung. Bei

der korrekten Lösung wartet ein Skript solange, bis tatsächlich eine

Internetverbindung besteht, bevor die Screenlets gestartet werden. Die

einfachere Lösung wartet ein paar Sekunden und startet die Screenlets

dann.

#!/bin/bash

# wait until internet is up

# before screenlets are started

sleep 12

python -u /usr/share/screenlets/ClearWeather/ClearWeatherScreenlet.py &

python -u /usr/share/screenlets/FeedReader/FeedReaderScreenlet.py

|

Listing: start-screenlets.sh

Zuerst wird zwölf Sekunden lang gewartet - das ist ein

Erfahrungswert, den jeder für seinen PC ermitteln muss. In den

nachfolgenden Zeilen werden die beiden Screenlets gestartet.

Wichtig ist, dass am Ende der Zeile das Zeichen & steht. Damit wird

der Befehl als Hintergrundprozess gestartet. Lässt man es aus, wird

der Feed-Reader erst gestartet, wenn das Clear-Weather-Screenlets beendet wird.

Das Skript interessiert sich nicht dafür, ob nach zwölf Sekunden die

Internetverbindung tatsächlich besteht. Wer es gerne etwas

komplizierter möchte, kann das zweite Skript verwenden:

#!/bin/bash

PING_URL=www.google.com

WAIT_FOR=30 # seconds

trap "exit 1" SIGTERM

sleep $WAIT_FOR && kill $$ &

while ! ping -c1 $PING_URL 2>/dev/null 1>&2; do sleep 1; done

kill %-

exit 0

|

Listing: test-inet.sh

Zuerst werden zwei Variablen definiert. Eine mit der Testadresse

und eine Weitere mit der maximalen Wartezeit für die Verbindung.

Die Zeile danach sorgt dafür, dass ein exit 1 gesendet wird,

falls das Skript mit kill beendet werden sollte.

Danach wird die Wartezeit gestartet, die nach Ablauf der Zeit

diesem Skript mit kill den Garaus macht - das ist sozusagen der

Selbstzerstörungsmechanismus für den Fall, dass überhaupt keine

Internetverbindung hergestellt werden kann. In der while-Schleife wird

die URL angepingt und eine Sekunde gewartet, bis der

ping erfolgreich war, also die Internetverbindung besteht. Nach der

Schleife könnten nun die Startkommandos für die Screenlets stehen,

denn die Schleife wird erst bei bestehender Internetverbindung

verlassen. Da nun alles bestens ist, wird die zuvor gestartete

Selbstzerstörung abgeschaltet, indem ein kill an den letzten

Hintergrundprozess geschickt wird. Zum Schluss wird das Skript

erfolgreich verlassen. Falls das Skript bei Zeitablauf durch den Hintergrundprozess

zwangsbeendet wird, geschieht dies mit exit 1, um einen nicht

erfolgreichen Skriptablauf zu signalisieren.

Wie man sieht, ist das zweite Skript nicht so einfach zu verstehen wie

das erste, obwohl dieses für den gewünschten Zweck völlig ausreichend

ist. Möchte man es verwenden, so müssen die Aufrufe für die

Screenlets aus den Startprogrammen entfernt werden. Lediglich der

Eintrag „Screenlets Daemon“ muss dort bestehen bleiben. Anschließend

fügt man den Aufruf des eigenen Skripts zu den Startprogrammen hinzu.

Desktop verschönern

Nachdem der Desktop nun durch die Screenlets um einiges informativer

geworden ist, kann man sich über die Verschönerung Gedanken machen.

Hierfür gibt es vielfältige Möglichkeiten, die von eigenen

Hintergrundbildern bis zu anderen Desktop-Themen reichen. Die

Hintergrundbilder

haben den Nachteil, dass sie in der Regel statisch

sind, so dass man jeden Tag das gleiche sieht.

Seit Ubuntu 9.10 gibt

es zwar die wechselnden Bilder, die sich jedoch lediglich auf eine

Handvoll verschiedener Bilder beschränken.

Es ist interessanter, von einer dynamischen Quelle bei jedem Systemstart ein neues Bild zu

beziehen. Das funktioniert einfacher als man denkt.

Der Desktop: Zwei Feedreader, das Wetter und eine Notiz.

Der Trick besteht darin, eine Internetseite zu finden, auf der sich

eine Bilddatei eindeutig identifizieren lässt. Die meisten Leser

kennen wohl die Suchmaschine von Microsoft mit dem Namen „Bing“ [6]. Ob man diese Suchseite gut findet und

verwenden möchte, sei jedem selbst überlassen - was man Microsoft

jedoch zugestehen muss ist die gute Auswahl der Hintergrundbilder.

Über Geschmack lässt sich bekanntlich nicht streiten, aber diese

Bilder sind wirklich schön. Deshalb sind sie eine gute Quelle zur

Verschönerung des Desktops. Mit einem simplen Python-Skript lassen

sich die Bilder auf den Desktop zaubern.

Die Programmiersprache Python ist bei den populären

Linuxdistributionen bereits vorhanden und muss daher nicht erst

installiert werden. Das Skript ist sehr einfach und wird im Folgenden

erklärt.

#!/usr/bin/env python

# Get the background image from

# Bing and make it the wallpaper

import urllib

def main():

page = urllib.urlopen("http://www.bing.com").read()

start = page.find("/fd\/hpk2\/", 0)

end = page.find("jpg", start)

url = "http://www.bing.com" + page[start:end+3]

urllib.urlretrieve(url, "bing.jpg")

if __name__ == '__main__': main()

|

Listing: bingster.py

Hinweis: Grundlagen von Python werden im Folgenden nicht erklärt.

Zuerst wird mit import die Bibliothek urllib geladen, um auf

Internetseiten zugreifen zu können. Die Hauptfunktion liest zuerst die Seite

http://www.bing.com als String in die Variable page ein. Die nächste

Zeile sucht in der Seite nach der signifikanten Zeichenfolge

/fg/hpk2/, die das Verzeichnis darstellt, in dem Microsoft die Bing-Bilder

ablegt. Anschließend wird nach der Zeichenfolge jpg gesucht,

was das Ende der gesuchten Bildadresse markiert. Danach wird nun

die Adresse des Bildes konstruiert indem man http://www.bing.com mit

der gefundenen Bildadresse kombiniert. Zum Schluss wird das Bild unter

der Adresse in url bei Bing abgeholt und im aktuellen

Verzeichnis unter dem Namen bing.jpg abgespeichert.

Jetzt fehlen noch zwei Sachen: das Python-Skript muss in die von

der Internetverbindung abhängigen Startprogramme aufgenommen werden. Das erweiterte

Shellskript sieht dann wie in Listing 4 aus.

Man sollte nicht vergessen, den vorhergehenden Befehl mit einem &

abzuschließen, damit er als Hintergrundprozess gestartet wird.

Außerdem muss dem Desktop gesagt werden, wo das neue Hintergrundbild

zu finden ist. Dazu öffnet man den Dialog zur Einstellung des

Hintergrundbildes, verweist auf das Bing-Bild und stellt je nach Geschmack den Stil auf

„zentriert“ oder „Bildschirm füllen“. Nun wird bei

jedem Start das aktuelle Bild von Bing geholt und auf dem Desktop

gezeigt.

#!/bin/bash

# wait until internet is up before screenlets are started

sleep 12

python -u /usr/share/screenlets/ClearWeather/ClearWeatherScreenlet.py &

python -u /usr/share/screenlets/FeedReader/FeedReaderScreenlet.py &

python -u ~/bingster.py

|

Listing: inetwait.sh

In Zukunft

Über die Zukunft des Desktops gibt es diverse Meinungen. Die einen

glauben an eine Verstärkung der Schreibtisch-Metapher wie im

Bumptop-Video [7] schön zu sehen ist.

Andere sehen alles in die Wolke wandern und stellen sich den Desktop

im Browser vor und nennen ihn Webtop. Bei Ubuntu und dem GNOME-Desktop

zeigen sich drei Entwicklungen [8]:

- stärkere Integration von sozialen Elementen wie beim „Me Menu“ [9]

- Ausrichtung auf Aktivitäten und multiple Desktops in der neuen GNOME Shell

- die Zeit als Organisationskriterium für Dokumente in GNOME Zeitgeist.

Betrachtet man den Eingangsbildschirm von aktuellen Smartphones, so

steht hier die Anzeige von wichtigen Informationen im Vordergrund.

Praktisch alle Smartphone-Desktops zeigen PIM-Informationen (Personal Information

Management) an. Dazu gehören: nächste Aktivitäten

(Kalender und Aufgaben), häufige Kontakte (Personen), Nachrichten

(E-Mail, SMS, Messenger, Telefonate), Geo-Infos (Landkarten), häufige

Anwendungen und Dokumente (Programme, Dokumente inklusive Multimedia-Inhalte).

Die Hintergrundbilder von früheren Smartphone-Desktops sind

mittlerweile vollständig von den oben genannten Info-Inhalten

verdrängt worden. Diese Entwicklung ist auf PC-Desktops bisher nicht

zu beobachten.

Fazit

Eine Renovierung der 30 Jahre alten Desktop-Metapher ist überfällig.

Die grafische Benutzeroberfläche als reines Abbild des realen

Schreibtisches wird den heutigen Bedürfnissen nach Information,

Kommunikation und optischer Gestaltung nicht mehr gerecht. Moderne

Desktops bieten vielfältige Möglichkeiten zur Anreicherung nach den

persönlichen Anforderungen. Dennoch, der Desktop an und für sich wirkt

verstaubt. Die ständige Weiterentwicklung der wichtigsten

Linux-Desktops, KDE und GNOME, wird noch in diesem Jahr für frischen

Wind und neue Konzepte sorgen. Das ist gut so, denn die Wüste lebt.

Links

- http://www.aresluna.org/attached/usability/articles/biurkonaekranie/pics/xerox

- http://forum.ubuntuusers.de/topic/den-desktop-aktiv-nutzen/

- http://wiki.ubuntuusers.de/Desklets

- http://screenlets.org/index.php/Download

- http://www.weather.com

- http://www.bing.com

- http://www.youtube.com/watch?v=M0ODskdEPnQ

- https://wiki.ubuntu.com/MeMenu

- http://live.gnome.org/ThreePointZero/Plan

| Autoreninformation |

| Ralf Hersel

schreibt in erster Linie für Ein- und Umsteiger auf Linux.

Sein Fokus liegt auf relevanten Informationen, die die tägliche Arbeit

mit Linux erleichtern und anreichern. Er ist überzeugt davon, dass

Linux das beste Betriebssystem für Computerneulinge ist.

|

| |

Diesen Artikel kommentieren

Zum Index

von Hauke Goos-Habermann

Dieser Artikel zeigt eine weitere Methode, Pakete mit Abhängigkeiten

herunterzuladen. Anders als in dem Artikel „Raus aus der

Ubuntu-Paketabhängigkeitshölle“, freiesMagazin 01/2010 [1],

funktioniert diese Variante ohne Root-Rechte und unabhängig von der

verwendeten Distribution, solange diese die APT-Programme

wie apt-get

bereitstellt.

Da APT bereits alle nötigen Funktionen enthält, um Pakete inklusive

aller Abhängigkeiten herunterzuladen, besteht der eigentliche

„Trick“ darin, APT so zu konfigurieren, dass eine Paketquelle

unabhängig von der des übrigen Systems angelegt und verwaltet

werden kann. In jedem beliebigen Verzeichnis kann eine Datei- und

Verzeichnisstruktur angelegt werden, die von APT akzeptiert wird.

Vorbereitungen

Verzeichnisstruktur anlegen

Die folgenden Schritte werden in einer Shell als normaler Benutzer

ausgeführt. Zuerst legt man ein neues Verzeichnis an und wechselt

hinein. In diesem Verzeichnis werden dann alle weiteren Schritte

ausgeführt.

$ mkdir /tmp/testquelle

$ cd /tmp/testquelle

|

APT benötigt einen Satz von Dateien und Verzeichnissen, um die

Pakete und zusätzliche Informationen ablegen zu können. Unter

lists und lists/partial werden die Paketindizes gespeichert.

Diese enthalten die Liste aller herunterladbaren Dateien abhängig

von der sources.list (mehr dazu später).

$ mkdir -p ./lists/partial

$ mkdir -p ./archives/partial

$ mkdir -p ./cache

$ touch ./lists/lock ./status

|

APT speichert die

komplett heruntergeladenen Pakete unter archives und noch nicht

vollständige Pakete unter archives/partial. Für die Paketsuche

wird das Verzeichnis cache von APT erwartet. Damit während der

Aktualisierung der Paketindizes kein weiterer APT-Aufruf gestartet

werden kann, benötigt APT noch die leere Datei lists/lock.

Die

Datei status würde in einem normalen System schließlich

Informationen über deinstallierte und installierte Pakete enthalten. Zum

Herunterladen von Paketen wird sie zwar nicht direkt gebraucht,

aber APT beginnt nicht mit der Arbeit, wenn sie fehlt.

Paketquellendatei erstellen

Debian und alle von Debian abgeleiteten Distributionen (z. B.

Ubuntu/Kubuntu) verwenden eine Datei, in der die Paketquellen

(normalerweise Server im Internet) eingetragen sind, von der die

Softwarepakete heruntergeladen werden. Diese Datei heißt

sources.list und befindet sich im Normalfall im Verzeichnis

/etc/apt.

Möchte man Pakete für die gerade verwendete Distribution aus dem

Internet laden, so genügt ein simples Kopieren von

/etc/apt/sources.list in das aktuelle Verzeichnis:

$ cp /etc/apt/sources.list .

|

Dann hat man aber nur die Pakete, die sich auch so herunterladen

und installieren lassen.

Interessant wird die Sache allerdings, wenn man eine neue

sources.list anlegt bzw. die kopierte verändert und in dieser die

Paketquelle(n) einer fremden Distribution angibt. Hierdurch kann

man gänzlich andere Pakete als die der eingesetzten Distribution

herunterladen. Beispielsweise könnte man folgende Zeile eintragen,

wenn man Pakete aus Debian unstable haben möchte,

selbst wenn man Ubuntu einsetzt:

deb http://ftp2.de.debian.org/debian/ unstable main non-free contrib

|

Pakete suchen und herunterladen

Paketindex heruntergeladen

Damit APT weiß, welche Pakete es überhaupt gibt, lädt es hierfür

Indexdateien herunter. Hierbei ist der apt-get update-Aufruf so

zu erweitern, dass alles auf dem aktuellen Verzeichnis arbeitet:

$ apt-get update -o=Dir::Cache=./cache -o=Dir::Cache::archives=./archives -o=Dir::State::status=./status -o=Dir::State=. -o=Dir::Etc::sourcelist=./sources.list

|

Pakete suchen

Beim Suchen im lokalen Verzeichnis werden die gleichen Anpassungen

vorgenommen:

$ apt-cache search -o=Dir::Cache::archives=./archives -o=Dir::State::status=./status -o=Dir::State=. -o=Dir::Etc::sourcelist=./sources.list <Suchbegriff>

|

Pakete herunterladen

Das Herunterladen von Paketen geschieht ebenfalls mit den

Anpassungen und dem üblichen APT-Befehl. Wichtig hierbei ist, dass

zusätzlich der Parameter -d angegeben wird, damit APT die Pakete

nur herunterlädt und nicht versucht, diese zu installieren. Nach

Abschluss des Downloads befinden sich die Pakete inklusive der

benötigten Abhängigkeiten im Unterverzeichnis archives.

$ apt-get install -d -o=Dir::Cache=./cache -o=Dir::Cache::archives=./archives -o=Dir::State::status=./status -o=Dir::State=. -o=Dir::Etc::sourcelist=./sources.list <Pakete>

|

Quellpakete herunterladen

Das Herunterladen von Quellpaketen geschieht analog. Dabei ist der

Parameter install durch source zu ersetzen und darauf zu

achten, dass in der sources.list die zugehörige Quelle für

Quellpakete eingetragen ist. Zum Beispiel

gehört zu dem oben angegebenen Repository das folgende Quellrepository:

deb-src http://ftp2.de.debian.org/debian/ unstable main non-free contrib

|

local-apt

Um die Anwendung einfacher zu gestalten, gibt es die Skriptsammlung

local-apt [2] als fertiges

Paket, das die vorgestellten Schritte in einfachen Kommandos

zusammenfasst und nach Anlegen einer sources.list in jedem

beliebigen Verzeichnis verwendet werden kann:

- local-apt-update aktualisiert den Paketindex

- local-apt-search <Suchbegriff> sucht ein Paket im Paketindex

- local-apt-download <Paket(e)> lädt ein Paket herunter

- local-apt-source <Paket(e)> lädt den Quellcode eines Paketes herunter

- local-apt-mkpackages erzeugt die Paketindexdateien,

die benötigt werden, um die Pakete zu installieren

(muss im Verzeichnis archives ausgeführt werden).

local-apt installieren

Möchte man local-apt häufiger benutzen, so bietet sich an, das Paket

fest im System zu installieren. Hierzu lädt man das local-apt-Paket

von der Dodger-Tools-Seite [3]

herunter und installiert es z. B. mit folgendem Aufruf:

$ cd /tmp

$ wget http://dodger-tools.sourceforge.net/debs/local-apt_1.0-38_all.deb

# dpkg -i local-apt_1.0-38_all.deb

|

Links

- http://www.freiesmagazin.de/freiesMagazin-2010-01

- http://dodger-tools.sourceforge.net/

- http://dodger-tools.sourceforge.net/debs/#end

| Autoreninformation |

| Hauke Goos-Habermann

arbeitet freiberuflich als Entwickler und

Trainer für Linux und Open-Source-Software. Er ist zudem

Hauptentwickler des Softwareverteilungssystems m23 und weiterer Open-Source-Software

sowie Mitorganisator der Kieler Linux- und Open-Source-Tage.

|

| |

Diesen Artikel kommentieren

Zum Index

von Marcel Jakobs

Die Standardshell auf den meisten Linux-Systemen ist die

Bash [1]. Sie ist

sehr mächtig und erlaubt es, viele Aufgaben zu automatisieren.

Dieser Artikel soll sich einer sehr interessanten, noch

mächtigeren Shell widmen, der Z-Shell - kurz zsh [2].

Installation und Start

Die zsh lässt sich auf den meisten Linux-Systemen aus der

Paketverwaltung über das Paket zsh installieren. Danach kann man

sie mit dem Aufruf von

ausführen. Um sie zur Standardshell zu machen, genügt der Befehl

$ chsh -s /usr/bin/zsh BENUTZERNAME

|

wobei BENUTZERNAME durch den entsprechenden eigenen Benutzernamen

ersetzt werden und der Pfad zu zsh stimmen muss. Wo zsh liegt,

kann man mit dem folgenden Befehl herausfinden:

Auf manchen Systemen liegt zsh beispielsweise in /bin.

Die zsh bedient sich Elementen der Bash, der Korn-Shell (ksh) und

der TENEX-C-Shell (tcsh - eine erweiterte C-Shell). Sie ist sehr

gut konfigurierbar und fast jedes Verhalten der Bash kann

nachgeahmt werden, sodass der Umstieg sehr leicht fällt. Bestehende

Bash-Scripte können natürlich weiterhin genutzt werden, wenn der

Shebang entsprechend gesetzt ist (siehe „Shebang -

All der Kram“, freiesMagazin 11/2009 [3]):

Beispiele

Im Folgenden sollen einige interessante Vorteile der zsh kurz durch

Beispiele beschrieben werden. Da die zsh sehr viele

Möglichkeiten bietet, ist es aber nicht möglich, alles im Detail zu

erläutern.

Hinweis: Optionen werden mit dem Befehl setopt gesetzt,

gelten aber nur für die aktuelle Sitzung. Um sie dauerhaft zu aktivieren,

muss man diese in die Konfigurationsdatei ~/.zshrc

schreiben.

Autokorrektur

Die zsh beherrscht einen Mechanismus, der kleine Tippfehler

automatisch korrigiert. Hat man in einem Ordner eine Datei

testfile.txt und möchte diese nach file2.txt kopieren, so führt man

in der Regel folgenden Befehl aus:

$ cp testfile.txt file2.txt

|

Wie von der Bash gewohnt, nutzt man dafür die Autovervollständigung

mittels „Tab“. Bei einem Verschreiber wird dieser in der zsh

automatisch korrigiert.

Beispiel:

wird automatisch korrigiert und zu

vervollständigt.

Die Autokorrektur aktiviert man mit der Option correct.

Globale Aliase

Neben den normalen Aliasen für Kommandos, wie man sie aus der Bash

kennt, gibt es in der zsh noch globale Aliase, die überall im

Befehl genutzt werden können, nicht nur am Anfang.

Zwei Beispiele verdeutlichen dies:

$ alias -g G='| grep'

$ alias -g L='| less'

|

Dies erzeugt die globalen Aliase G und L, die man hinter alle

möglichen Befehle schreiben kann, um die Ausgabe des entsprechenden

Befehls in grep oder less umzuleiten:

entspricht dem Befehl

oder

entspricht

Natürlich ist dann auch Folgendes möglich:

was folgendem Befehl entspricht:

Suffix-Aliase

Mit Suffix-Aliasen kann man Programme festlegen, mit denen bestimmte

Dateitypen (anhand ihrer Endung) geöffnet werden sollen. Man

braucht dann nur noch den Namen der Datei eingeben und sie wird mit

dem entsprechenden Programm geöffnet.

Beispiel:

legt einen Alias für PDF-Dateien an, die mit Evince geöffnet werden

sollen. Danach reicht die Eingabe von

und die Datei dokument.pdf wird mit Evince geöffnet.

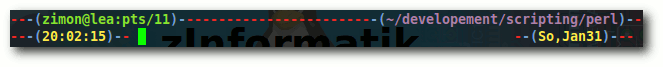

Aliase für Verzeichnisse: Hashes

Mit sogenannten Hashes lassen sich Aliase für beliebige

Verzeichnisse anlegen. Auf diese kann dann sehr einfach zugegriffen

werden. Mit dem Befehl

$ hash -d perl=~/development/scripting/perl

|

legt man einen Hash namens perl für das Verzeichnis

~/development/scripting/perl an. Auf dieses Verzeichnis kann man

jetzt mit ~perl zugreifen - auch innerhalb eines Befehls, wie

folgendes Beispiel zeigt:

Dieser Befehl kopiert die Datei testscript.pl

in das Verzeichnis ~/development/scripting/perl.

Auto-CD

Mit der Option autocd kann man zum Wechseln in ein Verzeichnis

einfach den Namen eines Verzeichnisses eingeben und das Kommando cd

davor weglassen. Wenn es keinen Befehl gibt, der so heißt

wie das Verzeichnis, wird in das Verzeichnis gewechselt - falls

es existiert.

Kurze for-Schleifen

Statt einem

$ for i in *.eps; do epstopdf $i; done

|

um alle EPS-Dateien in einem Verzeichnis in PDF-Dateien umzuwandeln,

genügt unter zsh die kürzere Form

$ for i (*.eps) epstopdf $i

|

Globale History

Die History, die man mit der „Pfeil hoch“-Taste durchgehen

kann, kann man in der zsh so einstellen, dass sie in jeder

zsh-Instanz gleich ist. Das heißt, man hat nicht mehr für jedes

Fenster eine eigene History, sondern kann mit der Taste „Pfeil hoch“

auch Befehle auswählen, die in anderen Fenstern eingegeben wurden.

Die History wird jedoch nur nach jedem Befehl aktualisiert. Das

heißt, man muss gegebenfalls einmal „Return“ drücken, damit die

Befehle aus einem anderen Fenster verfügbar sind.

Dieses Verhalten kann mit der Option share_history aktiviert werden.

Directory Stack

Wie die Bash hat die zsh auch einen Directory Stack. Mit dem Befehl

pushd kann man das aktuelle Verzeichnis auf den Stack legen und

mit popd das jeweils letzte Verzeichnis vom Stack nehmen und

dorthin springen.

Mit der Option auto_pushd legt die zsh automatisch jedes

Verzeichnis auf den Directory Stack, aus welchem man in ein anderes

Verzeichnis wechselt. So hat man immer eine History der

Verzeichnisse, in denen man war und kann mit popd sehr einfach

wieder in Verzeichnisse wechseln, die man vorher besucht hatte.

Globbing

Die Nutzung von Wildcards - unter zsh „Globbing“ genannt - ist bei

der Z-Shell etwas mächtiger als in der Bash.

Zunächst gibt es rekursives Globbing. So kann man mit dem Befehl

alle HTML-Dateien im aktuellen Verzeichnis und allen

Unterverzeichnissen auflisten lassen.

Es gibt jedoch auch noch Qualifier, um Dateien mit bestimmten

Eigenschaften auszuwählen. Diese schreibt man in runde Klammern. So

kann man mit . normale Dateien, mit / Verzeichnisse und mit @

symbolische Verweise prüfen. Praktisch ist das beispielsweise, wenn man allen

Verzeichnissen ab einem bestimmten Verzeichnis die Rechte 755 und

allen Dateien 644 vergeben möchte. Dies kann man mit den folgenden

zwei Befehlen bewerkstelligen, anstatt mit find und exec zu arbeiten:

$ chmod 755 **/*(/)

$ chmod 644 **/*(.)

|

Zusätzlich gibt es auch Qualifier für verschiedene Dateirechte.

Folgender Befehl listet alle Dateien auf, die von allen beschrieben

werden können:

Auch nach der Dateigröße lässt sich suchen:

listet alle leeren Dateien auf.

Auch die Sortierung lässt sich beliebig anpassen. Mit dem Befehl

listet man alle Dateien der Größe nach von klein nach groß auf. Mit

großem O wird die Sortierung umgekehrt.

Somit lässt sich mittels Globbing in der zsh das Kommando find fast

komplett ersetzen.

Die hier gezeigten Beispiele sehen auf den ersten Blick recht

kompliziert und kryptisch aus. Wenn man das Prinzip erst einmal

verstanden hat und die wichtigsten Qualifier kennt, ist es aber ganz

einfach und sehr praktisch.

Es gibt noch jede Menge weiterer Qualifier und Möglichkeiten für das

Globbing (z. B. nur das erste oder eine bestimmte Anzahl von

Elementen auszuwählen).

Im zsh-Manual [4]

gibt es eine Liste der Glob-Qualifier.

Um alle Möglichkeiten nutzen zu können, sollte die Option

extended_glob gesetzt werden.

Vervollständigung

Die zsh hat wie die Bash einen Vervollständigungsmechanismus, sodass man

mit „Tab“ Kommandos, Dateinamen und vieles mehr

vervollständigen kann. In der zsh ist dieser Mechanismus jedoch

extrem gut konfigurier- und programmierbar. So kann man beispielsweise beim

scp-Befehl, der Dateien über SSH kopiert, die Verzeichnisse auf dem

entfernten Rechner vervollständigen [5]

und genau definieren, welche Programme mit welchen Dateitypen

zusammenarbeiten können. Für sehr viele Programme ist dies schon

vorgefertigt, sodass ein

automatisch zu

vervollständigt wird.

Sehr praktisch ist auch die Menüfunktion. So wird beim ersten Druck

auf die „Tab“-Taste wie in der Bash so weit vervollständigt, bis nicht

mehr eindeutig entschieden werden kann, welche Datei (bzw. welcher Befehl)

gemeint ist. Ein weiterer Druck auf die „Tab“-Taste listet alle

weiteren Möglichkeiten auf und jeder weitere Druck geht diese

Möglichkeiten durch.

Wenn man also Dateien test.txt, testfile1.txt und testfile2.txt

hat und Folgendes eingibt

so wird zuerst auf test vervollständigt. Ein weiterer Druck gibt

alle Möglichkeiten aus:

testfile1.txt testfile2.txt

test.txt

|

und ein dritter Druck auf die „Tab“-Taste vervollständigt den Befehl zu

Das ist viel schneller als erst ein f einzugeben, um erneut „Tab“

zu drücken, und dann die 1 einzugeben, um wiederum „Tab“ zu

drücken, bis der Dateiname endgültig vervollständigt wird.

Ein weiterer Druck auf „Tab“ nimmt dann die nächste Möglichkeit. In

diesem Beispiel also

und so weiter.

Expansion

Mit der „Tab“-Taste kann man in der zsh nicht nur Kommandos,

Dateinamen etc. vervollständigen, sondern auch Variablen

expandieren. Viele kennen die spezielle Variable !!, die den

zuletzt ausgeführten Befehl enthält. Wenn man

eingibt und „Tab“ drückt, wird dies automatisch zum zuletzt

ausgeführten Befehl expandiert. Genauso kann man auch jede andere

Variable expandieren:

und „Tab“ wird beispielsweise zu /home/zimon/development, wenn man

sich gerade in diesem Verzeichnis befindet.

History-Kontrolle

Wie bei der Bash auch, kann man in der zsh die History durchsuchen.

Die zsh geht jedoch so weit, dass man auch nach bestimmten

Parametern suchen kann.

Ein Beispiel:

$ cp ../perl/foo.pl ~/development/projektordner

|

Danach kommen ein paar andere Kommandos. Möchte man nun eine andere

Datei in den gleichen Projektordner kopieren, reicht folgende Eingabe:

$ cp ../perl/bar.pl !?proj?:3

|

Mit !? wird nach einem vorherigen Befehl gesucht. Das proj ist

eine Zeichenkette, die in diesem Befehl vorkam. Mit dem ?:3 wird

das dritte Argument genutzt. Durch Expansion (siehe oben) kann man

durch einen Druck auf „Tab“ diesen Ausdruck auch noch expandieren,

um sicherzugehen, dass das richtige Argument ausgewählt wurde.

Man kann zwar mit „Alt“ + „+“, wie in der Bash, die jeweils letzten

Argumente durchgehen. Auf diese Weise kann man aber auch das zweite

von drei Argumenten suchen.

Es gibt noch wesentlich mehr Möglichkeiten die History zu durchsuchen und zu verwenden.

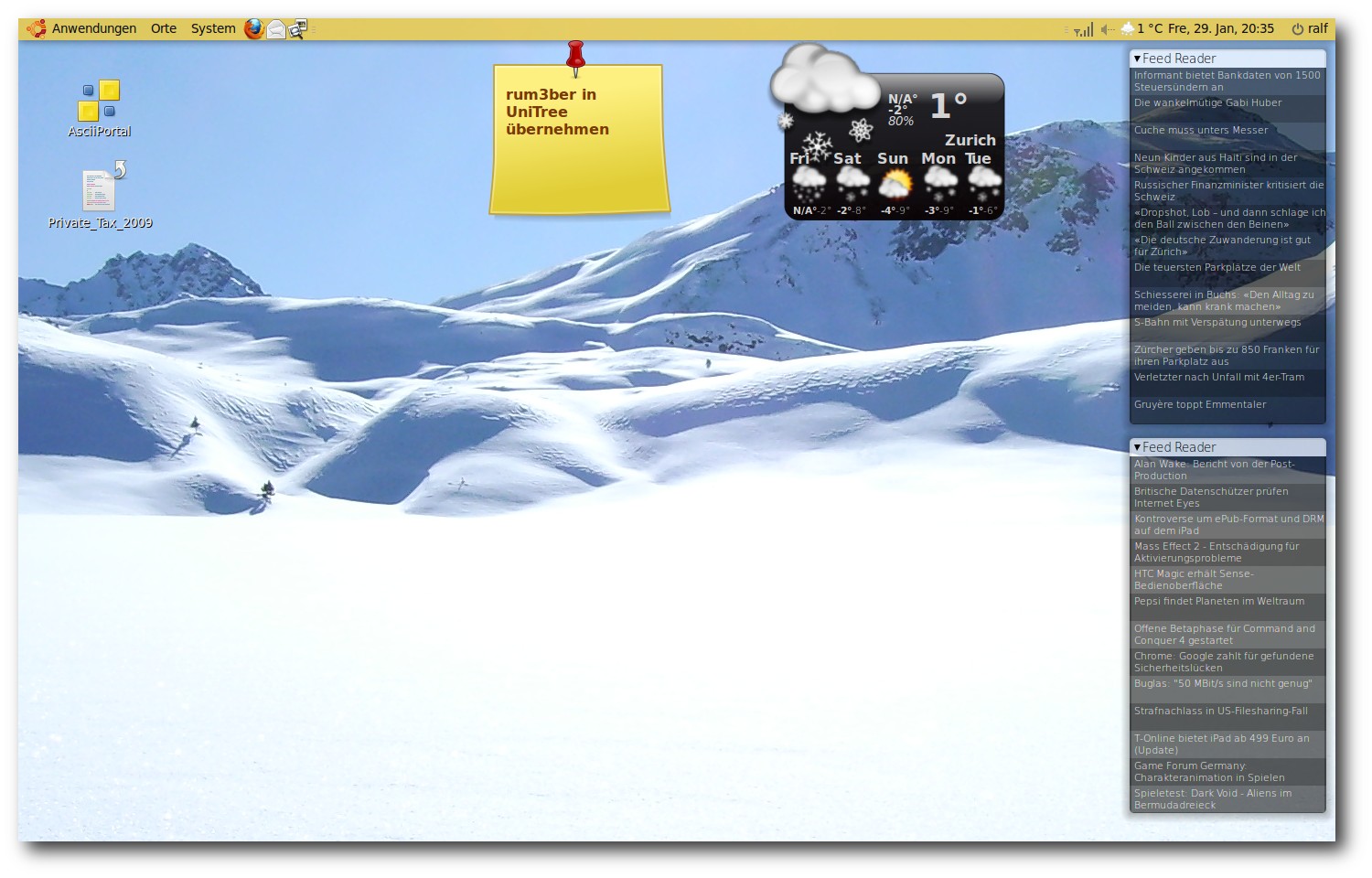

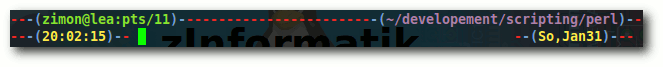

Hochkonfigurierbarer Prompt

In der Z-Shell kann man nicht nur die linke Seite des Prompts,

sondern auch die rechte Seite konfigurieren. Der Prompt in der

Abbildung ist eine abgeänderte Version von

Phil!s ZSH Prompt [6]).

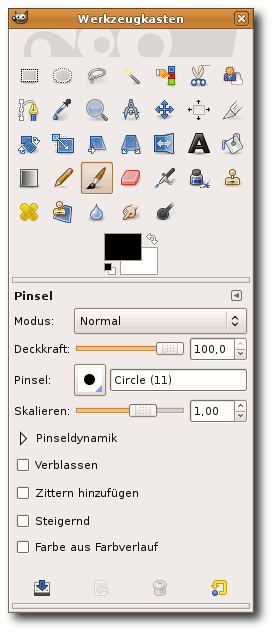

Ein Beispiel-Prompt der zsh.

Die Anzeige der Uhrzeit inklusive Sekunden ist recht praktisch, da

man daran sieht, wie lange ein Befehl gedauert hat oder wann man ihn

ausgeführt hat. Es gibt jedoch auch die Möglichkeit, automatisch die

Ausgabe von time bei der Beendigung eines Befehls ausgeben zu

lassen, der länger als eine vorher definierte Zeit benötigt hat.

ZLE-Widgets